Tensoroperatoren sind das Herzstück moderner Künstlicher Intelligenz (KI) und speziell bei großen Sprachmodellen (Large Language Models, LLMs) sowie tiefen neuronalen Netzwerken unverzichtbar. Über 90 Prozent aller Rechenoperationen in diesen komplexen Modellen werden durch Tensor-Operationen ausgeführt. Die Effizienz und Leistungsfähigkeit dieser Operatoren sind somit entscheidend für die Gesamtsystemleistung. In einer Ära, in der Rechenressourcen teuer und oft begrenzt sind, ist die Fähigkeit, Tensoroperatoren optimal an die jeweiligen Hardwareplattformen anzupassen, von enormer Bedeutung. Traditionell erfolgt die Entwicklung dieser hochoptimierten Operatoren durch manuelle Anpassungen, die mehrere Monate dauern können und Expertenwissen voraussetzen.

Mit dem Aufkommen leistungsfähiger Maschinenlernmodelle und der Fokussierung auf Hardware-nahe Programmierung eröffnet sich jedoch ein neues Zeitalter automatisierter Codegenerierung für Tensoroperatoren. Ein Durchbruch in diesem Bereich ist das Framework QiMeng-TensorOp, das auf der Kombination von großen Sprachmodellen (Large Language Models, LLMs) und einem tiefgreifenden Verständnis von Hardwareprimitiven basiert. Ziel ist es, Tensoroperatoren automatisch aus einer einzigen Zeile Benutzeranweisung zu generieren, die direkt an die Besonderheiten unterschiedlicher Hardwarearchitekturen angepasst sind. Dies beinhaltet beispielsweise RISC-V Prozessoren, ARM-basierte Systeme und leistungsstarke Grafikprozessoren (GPUs). QiMeng-TensorOp geht somit weit über die Fähigkeiten herkömmlicher Textgenerierungsmodelle hinaus, indem es Hardwareeigenschaften tief integriert und parametriert, um optimale Performance bei der Tensorberechnung zu erzielen.

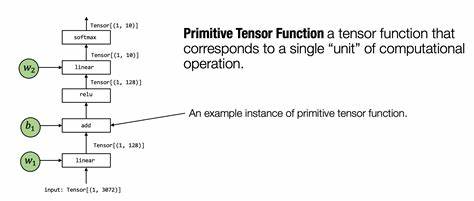

Die Herausforderung bei dieser Automatisierung liegt nicht nur in der reinen Codegenerierung, sondern auch darin, wie gut das Modell die Besonderheiten der zugrundeliegenden Hardware erkennt und effektiv nutzt. Hardwareprimitiven — niedrigstufige, optimierte Befehle und Operationen, die direkt von der Architektur unterstützt werden — spielen hierbei eine Schlüsselrolle. Indem QiMeng-TensorOp diese Primitiven programmatisch einsetzt, kann es Tensoroperatoren erzeugen, die sowohl in Effizienz als auch in Geschwindigkeit über von Menschen entwickelte Lösungen hinausgehen. Experimentelle Ergebnisse zeigen, dass QiMeng-TensorOp auf verschiedensten Hardwareplattformen sowie bei unterschiedlichen State-of-the-Art LLMs und typischen Tensoroperationen erhebliche Leistungssteigerungen erzielt. Während Standard-LLMs ohne hardwarefokussierte Optimierung oft nur begrenzt enge Performance erreichen, liefert QiMeng-TensorOp teilweise eine bis zu 1291-fache Verbesserung.

Solche gewaltigen Sprünge bedeuten eine drastische Verringerung von Rechenzeit und Energieverbrauch. Besonders beeindruckend sind die Vergleiche mit von Experten manuell optimierten Implementierungen. Auf Basis von OpenBLAS, einer der führenden Bibliotheken für lineare Algebra auf CPUs, konnte QiMeng-TensorOp auf RISC-V Prozessoren eine 2,5-fache Performanceüberlegenheit erzielen. Ebenso übertraf es auf NVIDIA GPUs die hochentwickelte cuBLAS-Bibliothek um 24 Prozent. Weitere Vorteile resultieren aus der signifikanten Reduzierung der Entwicklungszeit.

Während manuelle Optimierungen oft Monate in Anspruch nehmen, verringert sich dieser Aufwand durch den Einsatz von QiMeng-TensorOp um das 200-fache, was nicht nur Zeit, sondern auch erhebliche Kosten spart. Die Fähigkeit, hochleistungsfähige Tensoroperatoren automatisch und hardwareoptimal zu generieren, ermöglicht es Unternehmen und Forschern, flexibler auf neue Hardwaregenerationen zu reagieren. Anstatt bei jedem Technologiewechsel von Grund auf optimierten Code manuell zu schreiben, können sie sich auf die automatisierte Anpassung verlassen. Besonders mit der rasanten Entwicklung neuer Chiparchitekturen und spezialisierter Beschleuniger ist dieser Vorteil von strategischer Bedeutung. Auch für die Weiterentwicklung von KI-Anwendungen eröffnen sich neue Möglichkeiten.

Die hohe Performance bei Tensorberechnungen führt nicht nur zu schnelleren Trainings- und Inferenzzeiten großer Modelle, sondern ermöglicht auch, komplexere und genauere Modelle in Echtzeit einzusetzen. Dies betrifft zahlreiche Anwendungsgebiete, vom autonomen Fahren über medizinische Bildanalyse bis hin zu Sprachassistenten und Simulationen. Interessanterweise hebt QiMeng-TensorOp hervor, wie wichtig ein tiefes Verständnis der zugrunde liegenden IT-Hardware für die Softwareentwicklung im KI-Bereich ist. Die Verbindung von maschinellem Lernen, Hardwarewissen und Programmiertechniken setzt neue Maßstäbe für die Entwicklung agiler und skalierbarer Lösungen. Dabei steht das automatische Tunen von Parametern der Tensoroperatoren im Vordergrund, da nur eine feingesteuerte Anpassung an die Architektur maximale Leistung garantiert.

Zudem belegt die Forschung, wie leistungsstark der Einsatz von Hardwareprimitiven sein kann. Solche Primitiven erlauben unmittelbaren Zugriff auf die internen Ressourcen von Prozessoren und können durch spezialisierte Befehle parallele Berechnungen, Speicherausnutzung und Datenübertragungen effizient koordinieren. Dies führt zu enormen Geschwindigkeitsgewinnen, die über reine Compileroptimierungen hinausgehen. QiMeng-TensorOp bildet damit ein technologisches Fundament für die Automatisierung der nächsten Generation von KI-Softwareentwicklung. Die Ergebnisse und Methoden zeigen auf, dass die Verschmelzung von KI-generierten Codes, Hardwarekenntnissen und systematischer Parameteroptimierung nicht nur möglich, sondern essenziell für die Zukunft moderner Anwendungen ist.