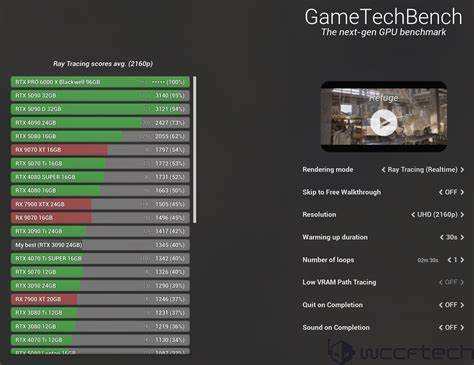

Die Nvidia RTX PRO 6000 Workstation Edition mit 96GB VRAM ist ein Meilenstein im Bereich der Grafikprozessoren für professionelle Anwendungen und Künstliche Intelligenz. Mit ihrem enormen Videospeicher, der neuen Blackwell-Architektur und einer beeindruckenden Leistungsdichte richtet sich diese Grafikkarte explizit an Entwickler, Forscher und Profis, die große Sprachmodelle lokal trainieren, feinjustieren oder ausführen möchten. Der Trend zu immer größeren KI-Modellen erfordert GPUs, die nicht nur leistungsstark, sondern auch effizient und zuverlässig im Dauerbetrieb sind. Die RTX PRO 6000 stellt in dieser Hinsicht eine interessante Alternative zu Multi-GPU-Setups dar, die traditionell wegen ihrer Komplexität, Skalierungsprobleme und PCIe-Bandbreitenengpässen herausfordernd sein können. Aufbau und Technik der RTX PRO 6000 beeindrucken auf mehreren Ebenen.

Der 96GB fassende GDDR7-Videospeicher mit einer Bandbreite von rund 1792 GB/s ermöglicht es, Modelle mit Parametergrößen jenseits der 200 Milliarden lokal zu laden – etwas, was mit kaum einer anderen einzelnen Karte ebenbürtig möglich ist. Die Blackwell-Architektur basiert auf modernster CUDA-Technologie mit über 24.000 CUDA-Kernen und bietet mit einem TDP von bis zu 600 Watt viel Spielraum für Performance. Für den Anschluss an den Prozessor steht PCIe 5.0 x16 zur Verfügung, was in Kombination mit der hohen Speichergröße die Datenübertragung spürbar beschleunigt und Engpässe vermeidet.

In der Praxis zeigt sich die RTX PRO 6000 als eine sehr dichte und robuste Lösung. Das Gewicht und die Größe erinnern an einen schweren Baustein – ein physisches Indiz für die enorme Leistungskomplexität unter der Haube. Anders als bei Consumer-Karten wird die GPU in minimalistischer, dafür aber sicherer Verpackung geliefert. Die Stromversorgung erfolgt über klassische 12V-2x6-Pin-Stecker und erfordert eine sorgfältige Installation, um Überhitzungsrisiken zu vermeiden – ein Aspekt, der angesichts von teils problematischen Erfahrungen bei verwandten Modellen wie der RTX 5090 FE ernst genommen werden sollte. Ein wichtiger technischer Hinweis betrifft die Treiberunterstützung unter Linux.

Da die RTX PRO 6000 auf der neuen Blackwell-Architektur basiert, funktionieren nicht alle bisherigen Nvidia-Treiber. Die Installation des aktuellen Nvidia-Treibers in Version 575 oder höher ist notwendig, um die volle Unterstützung sicherzustellen. Vor allem Entwickler, die auf eine stabile und nahtlose Softwareunterstützung angewiesen sind, werden sich hier auf einige Anfangsschwierigkeiten einstellen müssen. Das Treiberupdate auf Version 575.51.

03 unter Ubuntu 22.04 brachte die benötigte Kompatibilität und erlaubt die problemlose Nutzung im CUDA-12.9-Umfeld. Palettenfähige Softwarebibliotheken müssen jedoch noch nachziehen, denn viele Machine-Learning- und Large-Language-Model-Tools unterstützen Blackwell noch nicht vollständig. Ein Kernaspekt der Untersuchung ist die Auswirkung der Leistungsaufnahme auf die Effizienz und Performance.

Während viele Sachen nach maximaler Leistung streben, zeigt sich bei der RTX PRO 6000 ein spannender Trend: Die GPU skaliert erstaunlich gut mit reduzierten Power-Limits. Tests mit ResNet-50 Trainingsdurchsatz verdeutlichen, dass bei 450 Watt, also 75 Prozent der maximalen Leistungsaufnahme, noch rund 95 Prozent der Performance erreicht werden. Noch spannender ist der Peak der Effizienz, der bei rund 300 Watt erreicht wird, wo sich ein Performance-Watt-Verhältnis von über 3 ergibt. Dieser Wert ist für die Dauerbelastung von Trainings- und Inferenzanwendungen äußerst relevant, da eine geringere Leistungsaufnahme gleichzeitig die Wärmeentwicklung und damit die Kühlanforderungen abfedert. In der Praxis empfiehlt sich für die meisten Workloads ein Betrieb bei 450 Watt als bester Kompromiss zwischen Leistung, Effizienz und Kühlsystembelastung.

Im Bereich Large Language Models (LLMs) zeigt die RTX PRO 6000 ihr wahres Potenzial. Während kleine Modelle mit weniger als 10 Milliarden Parametern meist schon bei geringer Leistungsaufnahme maximal ausgelastet sind, punktet der 96GB-VRAM besonders bei Modellen ab 35 Milliarden Parametern. So sind LLMs wie Qwen3-235B oder Llama-4-Scout-17B-16E aufgrund des großen Speichers lokal mit großem Kontextfenster ausführbar, was sonst häufig eine Verteilung auf mehrere GPUs oder die Nutzung von Layer-Offloading erfordert hätte. Die Benchmarks zeigen zudem, dass die Performance bei 450 Watt zwischen 85 und 95 Prozent des Maximums verbleibt, während gleichzeitig der Energieverbrauch um ein Viertel sinkt. Dies macht die Arbeit mit großen Modellen effizient und praktikabel im eigenen Workstation-Umfeld ohne externe Cloud-Ressourcen.

Zudem zeigt das geringe Idle-Power-Level bei etwa 17 bis 20 Watt eine angenehm niedrige Grundlast, die bei Dauerbetrieb erhebliche Energieeinsparungen im Vergleich zu anderen High-End-GPUs bedeutet. Für Anwender, die neben LLMs auch mit Bild- und Videogenerierung arbeiten, eignet sich die RTX PRO 6000 ebenfalls sehr gut. Obwohl der Fokus auf KI-Modellen liegt, lassen sich durch die hohe Speichergröße und Rechenleistungen auch komplexe bildverarbeitende Workloads beschleunigen. Mit Modellen wie Flux.1-dev oder Bagel-7B-MoT konnte bei 1024x1024 Pixeln eine flüssige Performanz erreicht werden, die neue Möglichkeiten für den stationären Kreativarbeitsplatz eröffnet.

Ein oft diskutiertes Thema ist der Vergleich zwischen einer einzelnen 96GB-Karte und Multi-GPU-Setups mit z.B. mehreren 40er oder 30er Serienkarten. Die RTX PRO 6000 bietet hier gleich mehrere Vorteile: Komplexität und Fehlerquellen bei Multi-GPU-Szenarien fallen nahezu komplett weg, da das Handling von Model-Parallelismus oder Gradient-Synchronisation äußerst kompliziert sein kann und oft zu Problemen mit PCIe-Bandbreite sowie Gesprächsverzögerungen führt. Zudem spart ein einzelnes Board Platz im Rechnergehäuse, reduziert Kühlungsaufwand und senkt Kosten für passende Motherboards und Netzteile.

Der Autor des Benchmarks machte die Erfahrung, dass eine Kombination aus einer RTX PRO 6000 mit 4x A4000 GPUs in der Praxis sinnvoll sein kann, je nach Anwendungsfall. Wer allerdings reine Kostenoptimierung möchte und bereit ist, mit den Nachteilen von mehreren Karten zu leben, kann mit einem guten 3090er-Setup oder sogar einer 5090 günstig und performant arbeiten – vorausgesetzt die Limits beim Speicherplatz und der Systemkomplexität sind absehbar. Geeignet ist die RTX PRO 6000 vor allem für Unternehmen, Teams und Entwickler, die große KI-Modelle mit über 70 Milliarden Parametern lokal hosten wollen und nicht von externen Cloud-Diensten oder API-Limitierungen abhängig sein möchten. Die Möglichkeit, mehrere mittelgroße Modelle gleichzeitig laufen zu lassen, ohne Performance-Einbußen durch Verteilungseffekte zu erleiden, ist ein wesentlicher Vorteil. Darüber hinaus profitieren Anwender von extensiver VRAM-Größe bei Training, Feintuning oder dem Betrieb von Hybridmodellen mit sparsamen Expertennetzwerken (MoE).

Für Gelegenheitsnutzer oder solche, die hauptsächlich kleine bis mittelgroße KI-Modelle einsetzen, ist die Anschaffung bislang kaum rentabel. Hier bieten sich deutlich erschwinglichere Optionen an, während die RTX PRO 6000 den Anspruch hat, eine hochspezialisierte Lösung für den professionellen Bereich zu sein. Auch das Thema Lautstärke und thermisches Verhalten sollte Beachtung finden: Unter Volllast erreicht die GPU zwar knapp 66 Grad Celsius bei aktivem Kühlerlauf, erzeugt dabei aber eine Lautstärke von bis zu 66 Dezibel aus geringer Distanz, was in geschlossenen Gehäusen spürbar sein kann. Für den stationären Arbeitsplatz ist das möglicherweise kritisch – in größeren Setups oder Rechenzentren eher untergeordnet. Interessantes Fazit ist, dass Nvidia mit der RTX PRO 6000 ein bisher kaum bedientes Marktsegment perfekt bedient hat.

Die Kombination aus riesigem VRAM, moderner Architektur und guter Effizienz bei reduzierter Leistungsaufnahme macht das System zukunftssicher, gerade für die rasante Entwicklung bei KI-Modellen. Anderseits ist die Karte nicht preiswert und die Softwareunterstützung für Linux-basierte Workflows noch nicht vollständig ausgereift. Damit bleibt die RTX PRO 6000 eine Speziallösung für Anwender mit klaren Anforderungen und dem Willen, auch betreiberseitige Herausforderungen mitgedacht zu lösen. In der Gesamtbetrachtung hebt die RTX PRO 6000 die lokale Arbeit mit enormen KI-Modellen auf ein neues Niveau, eliminiert viele der Stolpersteine konventioneller Multi-GPU Setups und bietet Entwicklern ein Werkzeug, das die Grenzen zwischen Forschung und Produktivumgebung immer weiter verwischt. Besonders die hervorragende Performance-Watt-Kurve bei 450 Watt macht sie in der Praxis ideal einsetzbar für den Dauerbetrieb.

Somit ist die Nvidia RTX PRO 6000 nicht einfach nur eine weitere GPU, sondern eine strategische Investition für professionelle Nutzer, die auf lokale KI-Infrastruktur setzen und dabei höchste Ansprüche an Leistung, Stabilität und Speicher haben. Bis die Konkurrenz von AMD oder Intel mit vergleichbaren Lösungen im Multi-Terabyte VRAM Segment marktreif ist, setzt Nvidia mit diesem Modell Maßstäbe, wie eine einzelne GPU zur Rechenmaschine für die nächste KI-Generation werden kann.