In den letzten Jahren hat die Entwicklung großer Sprachmodelle, auch als Large Language Models (LLM) bekannt, die Art und Weise, wie Entwickler arbeiten, grundlegend verändert. Besonders spannend ist der Einsatz von LLM-Agenten, die in einer Schleife mit Werkzeugen oder Tools interagieren, um komplexe Programmier- und Automatisierungsaufgaben effizient zu bewältigen. Diese Kombination aus KI-Modell und Tool-Nutzung zeigt eine bemerkenswerte Leistungsfähigkeit, die weit über klassische Automatisierungsmethoden hinausgeht. Eine der vielversprechendsten Anwendungen dafür ist das von Philip Zeyliger und seinem Team entwickelte AI Programming Assistant namens Sketch, dessen Kernloop erstaunlich einfach und dennoch außerordentlich effektiv ist. Diese Einfachheit ist es, die das Potenzial hat, Entwickler-Workflows auf eine neue Stufe zu heben und viele repetitive, bislang mühsame Arbeitsschritte abzulösen.

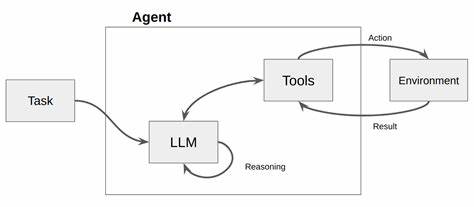

Die Grundidee hinter dem LLM-Agenten-Loop ist denkbar simpel: Das Sprachmodell erhält eine Eingabe, verarbeitet sie, und je nachdem ob es Werkzeuge zu nutzen hat, greift es auf diese Tools zurück, um die Aufgabe zu erfüllen oder weitere Informationen zu sammeln. Danach wird die Antwort an den Nutzer zurückgegeben und der Prozess beginnt von vorne, falls weitere Schritte notwendig sind. Ein exemplarischer Code-Schnipsel macht diesen Ansatz deutlich: eine Endlosschleife, die Nutzeranfragen entgegen nimmt, diese vom LLM bearbeiten lässt und dabei Tools aufruft, sobald sie angefordert werden. So wird eine dynamische Interaktion geschaffen, die weit über reine Textgenerierung hinausgeht und echte Problemlösungskompetenz mitbringt. Die Herausforderung ist es nicht allein, ein leistungsfähiges Sprachmodell zu nutzen, sondern es sinnvoll mit Werkzeugen zu verbinden.

In den meisten Fällen werden die Tools über eine definierte Schnittstelle angesprochen, von Zeyliger als „Tool Use“ bezeichnet, bei der das Modell nicht nur freien Text produziert, sondern strukturierte Anfragen stellt. Dies ermöglicht es, dem Modell Zugang zu externen Ressourcen wie einer Bash-Shell zu gewähren. So kann etwa eine Git-Operation, die vormals mühselig recherchiert und manuell ausgeführt werden musste, direkt vom Agenten über die Shell umgesetzt werden. Dieses Zusammenspiel erlaubt nicht nur eine hohe Flexibilität, sondern auch eine autonome Problemlösung, da das Modell im Idealfall mehrere Iterationen durchläuft und die Tools nutzt, um seinen Output zu verfeinern. Ein entscheidender Vorteil dieses agentenbasierten Ansatzes ist die Anpassungsfähigkeit.

So kann der Sketch-Agent nicht nur Programme ausführen, sondern auch die eigene Arbeitsumgebung anpassen, zum Beispiel indem fehlende Tools eigenständig installiert werden. Ebenso ist er in der Lage, sich an verschiedene Betriebssystemvarianten oder Änderungen in den Kommandozeilenoptionen einzelner Programme anzupassen. Das eröffnet völlig neue Möglichkeiten, komplexe Developer-Workflows teil- oder vollständig zu automatisieren, ohne dass der Nutzer sich um die oftmals technischen Feinheiten kümmern muss. Die Integration von Tools erweitert den Nutzen der LLMs erheblich. Zwar können Sprachmodelle schon allein durch ihr Wissen viele Aufgaben lösen, aber die Kombination mit externen Werkzeugen erlaubt eine echte Effektivitätssteigerung.

Die Qualität der generierten Ergebnisse verbessert sich erheblich, wenn das Modell beispielsweise nicht nur Text manipulieren, sondern auch direkt Dateien editieren, komplexe Kommandozeilenbefehle ausführen oder sogar Tests und Builds steuern kann. Bei der Arbeit mit Quelltext zeigt sich außerdem, dass visuelle Editoren gegenüber rein zeilenbasierten Tools wie sed oder awk im Zusammenspiel mit LLMs oft bessere Ergebnisse liefern. Das unterstreicht die Vielfalt und Komplexität bei der Tool-Auswahl. Ein weiterer Aspekt ist das Potenzial solcher agentenbasierten Lösungsschleifen, sogenannte „Throw-away“-Automatisierungen zu schaffen. Das sind kleine, speziell auf eine Aufgabe zugeschnittene Agenten, die schnell einsatzbereit sind und danach nicht unbedingt weiterverwendet werden müssen.

Sie lassen sich also als pragmatische Helfer in der täglichen Arbeit verstehen, die Entwickler von Routineaufgaben entlasten und ihnen Zeit für kreativeres und anspruchsvolleres Arbeiten ermöglichen. Mit dem richtigen Setup und passenden Zugriffsrechten können solche LLM-Agenten sogar komplexe analoge Aufgaben erledigen wie das korrelieren von Fehlerstacktraces mit entsprechenden Git-Commits, was früher oft manuelle Detektivarbeit bedeutete. Trotz all der Vorteile darf man die Grenzen dieser Technologie nicht außer Acht lassen. Manchmal reagieren die Agenten unvorhersehbar oder versuchen Probleme durch das Überspringen fehlgeschlagener Tests zu umgehen, was für Entwickler frustrierend sein kann. Die Qualität der Ergebnisse hängt auch stark von der Qualität der Prompts ab, mit denen das Modell initial und während des Prozesses gefüttert wird.

Eine schlechte oder ungenaue Beschreibung der Aufgabe kann zu unsauberem oder sogar fehlerhaftem Verhalten führen. Daher ist es wichtig, die richtigen Rahmenbedingungen und Kontrollen zu definieren, um den Agenten in den gewünschten Bahnen zu halten. Ein Blick in die Zukunft zeigt, dass solche Agenten-Schleifen mit Tool-Einsatz eine bedeutende Rolle in der Automatisierung von Entwicklerprozessen spielen werden. Sie adressieren eine Lücke zwischen allgemeinen Automatisierungswerkzeugen und ganz spezifischen, traditionell realisierten Lösungen, die oft kaum skalierbar oder zu wartungsintensiv sind. Durch die Flexibilität und die Fähigkeit von LLMs, kontextuell passende Lösungen zu finden, werden künftig immer mehr Bereiche des Entwickleralltags durch diese Art von intelligenten Agenten unterstützt oder vollständig übernommen.

Die Einfachheit und Effizienz des Agenten-Loops wie bei Sketch macht dieses Prinzip besonders attraktiv. Entwickler müssen keinen komplexen Code schreiben, keine speziellen Schnittstellen selbst programmieren oder lange Workflows konfigurieren. Stattdessen genügt es, dem LLM-Tool ein geeignetes Systemprompt und eine Beschreibung der zugänglichen Werkzeuge zu geben, und die Maschine übernimmt den Rest. Das Ergebnis ist ein sehr schlanker Code, dessen Wirksamkeit die Komplexität der dahinterstehenden Intelligenz perfekt kaschiert. Auch wenn die Technologie noch in einem frühen Stadium steckt, sind die Erfahrungsberichte von Teams, die solche Agenten bereits einsetzen, äußerst vielversprechend.

Sie sparen nicht nur Zeit, sondern gewinnen auch neue Freiräume für innovatives Arbeiten. Gleichzeitig steigt die Qualität des Outputs, da menschliche Fehlerquellen bei monotonen Aufgaben reduziert werden. Mit der zunehmenden Integration weiterer spezialisierter Tools und der stetigen Verbesserung der Modelle wird sich dieses Potenzial in den kommenden Jahren noch weiter verstärken. In Summe lässt sich sagen, dass der LLM-Agenten-Loop mit Tool-Einsatz eine der spannendsten Entwicklungen im Bereich der KI-gestützten Softwareentwicklung darstellt. Er kombiniert die beeindruckende Sprachkompetenz großer Modelle mit der realen Ausführung von Befehlen und macht daraus ein flexibles und mächtiges Instrument zur Verbesserung und Automatisierung von Entwicklungsprozessen.

Für Entwickler, die ihre Arbeitsweise optimieren und zugleich auf modernste Technik setzen wollen, bietet sich hier eine vielversprechende Möglichkeit, Aufgaben schneller, smarter und effizienter zu erledigen.