Die rasante Entwicklung im Bereich der künstlichen Intelligenz stellt immer höhere Anforderungen an Softwaretools, die sowohl Leistung als auch Flexibilität bieten. In diesem Kontext positioniert sich Nabla als moderne Bibliothek, die differenzierbare Programmierung mit einer tiefen Integration von Python und dem aufstrebenden Mojo-Programmiersystem verbindet. Dieser Ansatz schafft eine ideale Grundlage für die Entwicklung komplexer Machine-Learning-Modelle und dynamischer neuronaler Netzwerke, die auf neuesten Hardwarearchitekturen wie GPUs hochperformant laufen. Nabla ist weit mehr als nur eine weitere ML-Bibliothek. Es vereint das bewährte Konzept von multidimensionalen Arrays, ähnlich wie es NumPy bietet, mit einer starken GPU-Beschleunigung, die den Rechenaufwand komplexer Matrizenoperationen erheblich reduziert.

Die Besonderheit liegt in der nahtlosen Unterstützung differenzierbarer Programmierung durch leistungsstarke Funktionstransformationen wie Gradientenberechnung (grad), automatische Vektorisierung (vmap) und Just-in-Time-Kompilierung (jit). Diese Konstrukte erlauben es Programmierern, komplizierte mathematische Ableitungen und hochdynamische Modellstrukturen effizient umzusetzen, ohne lange Entwicklungszyklen oder externe Werkzeuge zu benötigen. Ein signifikanter Vorteil von Nabla ist die Integration mit Mojo, einer modernen Programmiersprache und Compiler-Technologie, die speziell für performantes maschinelles Lernen entwickelt wurde. Mojo verbindet die einfache, dynamische Syntax von Python mit der Geschwindigkeit und Systemnähe von Sprachen wie C++. In Nabla wird eine experimentelle API bereitgestellt, die es ermöglicht, native Mojo-Kernels direkt einzubinden und damit den Zugriff auf die volle Power moderner Hardware wesentlich zu vereinfachen.

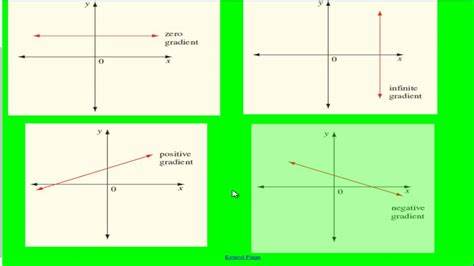

Anwender profitieren so von einer flexibel skalierbaren Umgebung, die sowohl für Forschung als auch Produktion geeignet ist. Das Konzept differenzierbarer Programmierung ermöglicht es, Algorithmen nicht nur zu definieren, sondern auch automatisch deren Ableitungen und Gradienten zu berechnen. Dies ist essentiell für Training und Optimierung von neuronalen Netzwerken und anderen ML-Modellen. Nabla bietet hierzu eine intuitive API, mit der Funktionen mit minimalem Aufwand vektorisiert, differenziert und JIT-kompiliert werden können. So kann beispielsweise eine Summe über das Quadrat eines Eingabearrays berechnet und gleichzeitig deren Gradient effizient bestimmt werden – alles innerhalb weniger Zeilen Code.

Diese Einfachheit öffnet die Tür für innovative Experimente und komplexe Modellarchitekturen. Die Architektur von Nabla ist modular und klar strukturiert. Der Kern der Bibliothek beinhaltet die Array-Datenstruktur und ihre Integration mit einem sogenannten MAX-Compiler zur Optimierung der Berechnungspfade. Hierauf aufbauend existieren verschiedene Module für neuronale Netze, mathematische Operationen sowie Transformationen von Funktionen. Diese Trennung erleichtert die Wartung, Erweiterung und Einbindung von neuen Features.

Gleichzeitig wird durch die Integration eines umfangreichen Testsystems und Tutorials ein solides Fundament für Entwickler gelegt, die Nabla für eigene Projekte anpassen möchten. Ein Meilenstein in Nablas Entwicklung ist die experimentelle Unterstützung für fortgeschrittenes Indexieren und die Verbindung mit Jupyter-Notebooks, was interaktive Entwicklung und Visualisierung stark vereinfacht. Diese Features sprechen vor allem Forscher an, die mit tiefgehender Kontrolle über ihre Modelle arbeiten möchten. Darüber hinaus sind umfangreiche Beispiele und Tutorials verfügbar, die den Einstieg erleichtern und bewährte Best Practices vermitteln. Der Zugriff auf die GPU-Beschleunigung erfolgt durch eine optimierte Schnittstelle, die hardware-spezifische Features ausnutzt, ohne die Abstraktionsebene zu verlieren.

Dies sorgt für eine erhebliche Steigerung der Rechengeschwindigkeit in datenintensiven Anwendungen. Insbesondere bei großen Datensätzen und tiefen Netzwerken zeigt Nabla hier deutliche Vorteile gegenüber klassischer CPU-basierter Verarbeitung. Für erfahrene Entwickler und Beitragswillige bietet Nabla eine offene Plattform mit klaren Richtlinien. Der Quellcode ist auf GitHub veröffentlicht, unterliegt der Apache-2.0-Lizenz und wird aktiv gepflegt.

Durch die modulare Struktur und ein rigoroses Testverfahren können Erweiterungen und Verbesserungen zügig integriert werden. Auch die Integration neuer Hardwareunterstützungen und experimenteller Features steht im Fokus der Community. Ein weiterer Pluspunkt von Nabla ist die flexible Entwicklungsumgebung. Neben der einfachen Installation über den Python-Paketmanager PyPI kann Nabla auch direkt aus dem Quellcode im Entwicklungsmodus installiert werden. Dies ermöglicht es, neue Funktionalitäten schnell zu testen und maßgeschneiderte Anpassungen vorzunehmen.

Die Kombination aus Python und Mojo garantiert dabei eine optimale Balance zwischen Produktivität und Performanz. Aus SEO-Sicht profitiert Nabla durch die klare Adressierung von Schlüsselthemen wie automatische Differenzierung, GPU-beschleunigtes Rechnen, Neuronale Netze, Python und Mojo-Integration sowie moderne kompilergestützte Laufzeitoptimierung. Besonders relevant sind Suchanfragen rund um leistungsfähige und flexible ML-Frameworks, deren moderne Architekturen und innovative Programmiermodelle. Durch aktuell gehaltene Dokumentation, offene Community und vermehrte Anwendungsszenarien positioniert sich Nabla als lohnenswerte Alternative zu etablierten Lösungen. Die Entwicklung differenzierbarer Programme gewinnt zunehmend an Bedeutung, da sie ein Kernstück moderner KI-Methoden darstellt.