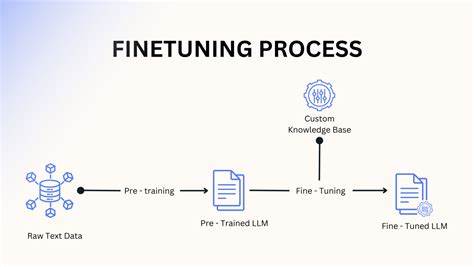

Im Jahr 2025 steht die Welt der Künstlichen Intelligenz (KI) und des Machine Learnings (ML) vor einer bedeutenden Weiterentwicklung. Die Fähigkeit, vortrainierte Modelle durch Fine-Tuning spezifisch auf individuelle Anforderungen anzupassen, hat sich als eine der wichtigsten Methoden etabliert, die ML-Ingenieuren einen entscheidenden Wettbewerbsvorteil verschafft. Fine-Tuning ist nicht länger nur ein technischer Prozess, sondern vielmehr die geheime Zutat, der es gelingt, komplexe KI-Systeme effektiver, flexibler und anwenderfreundlicher zu gestalten. Doch was genau macht Fine-Tuning zu diesem so wertvollen Werkzeug und wie verändert es die Arbeit von Machine Learning-Ingenieuren im Jahr 2025? Diese Fragen stehen im Mittelpunkt der aktuellen Diskussionen und dieser umfassenden Analyse. Fine-Tuning bezeichnet den Prozess, ein bereits vortrainiertes Machine Learning-Modell auf eine neue, meist spezifischere Aufgabe oder auf einen bestimmten Kontext anzupassen, ohne es von Grund auf neu zu trainieren.

Diese Methode erspart enorme Rechenressourcen, Zeit und Kosten im Vergleich zur vollständigen Modellentwicklung und ermöglicht gleichzeitig eine hohe Genauigkeit bei individuellen Anforderungen. Die Entwicklung vortrainierter Modelle durch Unternehmen wie OpenAI, Google oder Meta hat in den letzten Jahren eine Vielzahl leistungsfähiger Grundmodelle hervorgebracht, die durch Fine-Tuning gezielt auf bestimmte Aufgaben spezialisiert werden können. Für ML-Ingenieure bedeutet Fine-Tuning, mit leistungsstarken OK-Modellen zu arbeiten und diese optimal für ihre spezifischen Einsatzzwecke anzupassen. Auf diese Weise wird Fine-Tuning zum entscheidenden Hebel, um bestehende Technologie effizient zu nutzen und zugleich innovative Anwendungen zu entwickeln. Im Jahr 2025 hat sich die Landschaft der KI stark verändert.

Anstatt Modelle von Grund auf selbst zu entwickeln, setzen ML-Ingenieure zunehmend auf Transfer Learning und fein abgestimmte Modelle. Diese Herangehensweise ist nicht nur aus wirtschaftlichen Gründen attraktiv, sondern verhindert auch einen Ressourcenverbrauch, der überproportional zum Nutzen stünde. Dadurch können Unternehmen schneller auf Marktveränderungen reagieren und spezifische Anforderungen einzelner Branchen oder Kunden bedienen. Reinforcement Learning from Human Feedback (RLHF) hat sich dabei als eine Schlüsselkomponente moderner Fine-Tuning-Strategien etabliert. Durch die direkte Einbindung menschlicher Rückmeldungen in den Lernprozess werden Modelle auch außerhalb rein datengetriebener Optimierungen weiter verfeinert.

Diese Technologie ermöglicht es ML-Ingenieuren, Modelle zu gestalten, die besser auf menschliche Erwartungen und ethische Anforderungen abgestimmt sind. Die Kombination von Fine-Tuning und RLHF führt zu intelligenten Systemen, die nicht nur technisch leistungsfähig, sondern auch benutzerfreundlich und vertrauenswürdig sind. Ein weiterer wichtiger Fortschritt liegt in der Entwicklung von benutzerfreundlichen Bibliotheken und Frameworks, die Fine-Tuning deutlich zugänglicher machen. Hugging Face mit seiner TRL-Bibliothek ist dabei exemplarisch zu nennen. Sie ermöglicht es auch weniger erfahrenen ML-Ingenieuren, komplexe Fine-Tuning-Prozesse mit innovativen Methoden wie Proximal Policy Optimization (PPO) umzusetzen.

Diese Tools abstrahieren technische Details und schaffen eine Umgebung, in der Kreativität und Fokussierung auf konkrete Anwendungsfälle im Vordergrund stehen. Für ML-Ingenieure bedeutet das eine erhebliche Erleichterung im Alltag und eine neue Qualität der Zusammenarbeit zwischen Mensch und Maschine. Die Rolle des ML-Ingenieurs wandelt sich in diesem Kontext deutlich. Die rein technische Umsetzung wird zunehmend ergänzt durch ein tiefes Verständnis der zugrundeliegenden Modelle, der menschlichen Bedürfnisse und der ethischen Implikationen. Fine-Tuning fungiert daher als Brücke zwischen Technologie und Anwendungswelt und ermöglicht maßgeschneiderte Lösungen, die in verschiedensten Branchen eingesetzt werden können – von Finanzdienstleistungen über Gesundheitswesen bis hin zu Marketing und Softwareentwicklung.

Dabei gewinnt auch der gesellschaftliche Aspekt der KI-Entwicklung an Bedeutung. Durch Fine-Tuning können Modelle Verhalten und Vorlieben von Nutzerinnen und Nutzern besser berücksichtigen, was die Akzeptanz von KI-Systemen erhöht und deren Wirkung positiv beeinflusst. Gleichzeitig trägt diese Anpassung dazu bei, Fehlverhalten zu minimieren und Verzerrungen abzubauen. Im Jahr 2025 steht Fine-Tuning also nicht nur für technologische Exzellenz, sondern auch für verantwortungsvolle KI-Entwicklung. Blickt man auf die Zukunft, so wird Fine-Tuning weiterhin eine zentrale Rolle spielen.

Die rasante Entwicklung neuer Modellarchitekturen, die zunehmende Verfügbarkeit spezialisierter Datensätze und die stetige Verbesserung von Rechenressourcen schaffen ideale Voraussetzungen dafür. ML-Ingenieure werden verstärkt darauf setzen, Modelle kontinuierlich zu verfeinern und an immer neue Anforderungen anzupassen. Dadurch beschleunigt sich die Innovationsgeschwindigkeit und die Wettbewerbsfähigkeit von Unternehmen steigt. Abschließend lässt sich festhalten, dass Fine-Tuning im Jahr 2025 zu einem unverzichtbaren Werkzeug für Machine Learning-Ingenieure geworden ist. Es verbindet Effizienz, Präzision und Anpassungsfähigkeit und ermöglicht die Entwicklung von KI-Systemen, die nicht nur technisch hochentwickelt, sondern auch praxisnah und menschlich relevant sind.

ML-Ingenieure, die Fine-Tuning beherrschen, sichern sich einen entscheidenden Vorteil in einem dynamischen und anspruchsvollen Berufsfeld. Die Kombination aus modernsten Methoden, praxisorientierten Werkzeugen und einem Fokus auf ethische und soziale Aspekte macht Fine-Tuning zur geheimen Zutat, die die Zukunft des Machine Learnings prägt und maßgeblich vorantreibt.