Programmieren ist weit mehr als das reine Schreiben von Code. Es ist ein Prozess, der tiefes Verständnis sowohl für das Problem als auch für die Art und Weise erfordert, wie Computer Ressourcen nutzen. Erfolgreiches Codieren bedeutet, Eingaben effizient in Ausgaben zu verwandeln, während begrenzte menschliche und maschinelle Ressourcen bestmöglich eingesetzt werden. Dabei konzentriert sich die datenorientierte Denkweise auf die Klarheit im Umgang mit Daten, anstatt auf ästhetische oder rein elegante Codeformen. Obwohl Lesbarkeit wichtig ist, steht das echte Verständnis dessen, was der Code tatsächlich tut, klar im Vordergrund.

Dies umfasst auch, welche Daten wann und in welcher Reihenfolge gelesen oder verändert werden. In vielen traditionellen Programmieransätzen wird defensive Kapselung propagiert, bei der Daten hinter komplexen Schnittstellen verborgen werden. Doch dieser Ansatz erschwert oftmals das Verständnis des Programms. Fragen wie "Ist es sicher, diese Methode in genau diesem Kontext aufzurufen?" oder "Sind bestimmte Werte synchron mit den zugrundeliegenden Daten?" lassen sich so nur schwer beantworten. Außerdem führen solche Praktiken zu weniger effizienten Schnittstellen, die lediglich Objekte verarbeiten und viele unnötige Kopien erzeugen – Strukturen, die moderne Hardware nicht optimal nutzen können.

Die Grundfrage beim Programmieren sollte stets sein: Was will ich, dass der Computer genau macht? Erst wenn diese Frage klar beantwortet ist, werden Designentscheidungen zu Werkzeugen, die das gewünschte Verhalten klar und knapp ausdrücken. Es ist oft eine Falle, Code zu entwerfen, der eine vermeintliche Realität exakt widerspiegelt. Kategorien, die Menschen bilden, existieren nämlich nur im Kopf und sind nicht immer sinnvoll oder notwendig für das Programm. So ist die Unterscheidung etwa, ob ein Auftragnehmer ein Angestellter ist, irrelevant für die Programmstruktur. Entscheidend ist, ob das Programm diese beiden Gruppen gleich oder unterschiedlich behandelt und entsprechende Logik implementiert.

Eine übermäßige Orientierung an einer vermeintlich objektiven Wirklichkeit erschwert den Code nur unnötig. Eine weitere häufige Fehlannahme besteht darin, dass Programme strikt hierarchisch aufgebaut sein müssen. Die Realität von Problemstrukturen lässt sich oft nicht sauber in Baumstrukturen fassen, da sich relevante Kategorien überschneiden können. Es ist deshalb besser, flexibel mit der Organisation von Code umzugehen und ihn so zu strukturieren, dass er wiederkehrende Verhaltensmuster möglichst einfach abbildet. Auch die Organisation von Dateien und Ordnern folgt oftmals mehreren wechselwirkenden Kriterien, weshalb es selten sinnvoll ist, sehr lange über die perfekte Struktur zu grübeln.

Die Entwicklung eines Programms beginnt idealerweise mit der Betrachtung der zugrunde liegenden Daten in Form von atomaren Fakten. Atomar bedeutet hier, dass eine Information in ihrem Zusammenhang vollständig und unveränderlich vorliegt – beispielsweise das Datum einer Vertragsunterschrift, das immer wahr bleibt und nicht mehr geändert wird. Es hilft, Fakten distanziert zu betrachten und nur ausgehend von dem, was das Programm betreffen soll, festzulegen, was als „wahr“ gilt. Als nächstes entwickelt man ein Verständnis darüber, wie Eingaben in Ausgaben überführt werden können und welche Zwischenzustände sinnvoll sind. Diese Zwischenzustände ergeben oft einen Datenfluss, in dem Eingaben am Anfang stehen, Ausgaben am Ende und dazwischen abgeleitete Daten verarbeitet werden.

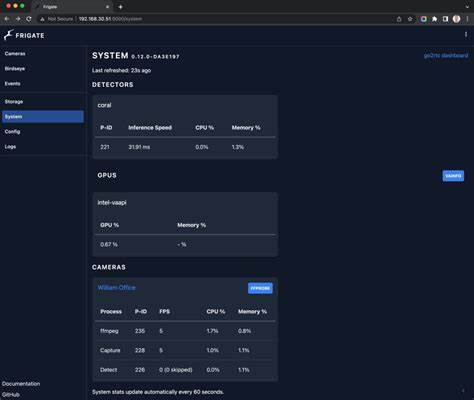

Ein gutes Verständnis der Datenmengen, der Verteilung und möglicher Korrelationen hilft dabei, Entscheidungen im Entwurf und der späteren Implementierung zu treffen. Die tatsächliche Umsetzung auf einer Maschine ist dabei eine Herausforderung, für die kaum klare Lehrbücher existieren. Es geht darum, abzuwägen, welche Daten gespeichert und wann sie neu berechnet werden, wie Daten im Speicher oder auf Datenträger verteilt werden und in welcher Reihenfolge Berechnungen ausgeführt werden. Die berühmte RUM-Hypothese (Read, Update, Memory) beschreibt die oft unvermeidlichen Konflikte zwischen Lesezeiten, Schreibzeiten und Speicherplatzbedarf. Clevere Lösungen setzen hier auf unterschiedliche Strategien für verschiedene Datensegmente oder verarbeiten Schreibvorgänge in Batches, um Lesegeschwindigkeit nachgelagert zu optimieren.

Synchronisierungsprobleme treten häufig auf, wenn verschiedene Datenrepräsentationen nebeneinander existieren und sich nicht immer genau gleich aktualisieren lassen. Die effizienteste Fehlervermeidung besteht darin, eine einzige Quelle der Wahrheit zu haben und abgeleitete Zustände stets komplett neu zu berechnen. Ist das nicht praktikabel, helfen kontrollierte Schnittstellen sowie Versions- oder Zeitstempelmechanismen, um die Konsistenz zu gewährleisten. Beim Schreiben des tatsächlichen Codes ist es wichtig, alle notwendigen Schritte klar und in der richtigen Reihenfolge abzubilden. Werte, die zusammen verkehren, sollten sinnvoll gebündelt werden, etwa in Strukturen oder Objekten.

Wiederholung im Code kann durch Funktionen reduziert werden, doch nur wenn dies die Lesbarkeit verbessert. Andernfalls ist es besser, sich Wiederholungen zu erlauben, was auch dem Prinzip der semantischen Kompression entspricht – komplexe Sachverhalte teilt man in gut verständliche Blöcke auf. Es ist falsch, Code für Probleme zu schreiben, die man nicht wirklich zu lösen versucht. Generalisierungen um der Generalisierung willen führen eher zu schlechteren Ergebnissen. Stattdessen liegt der Fokus darauf, dass ein späterer Leser den Code, die Abläufe und die Datenflüsse gut nachvollziehen kann.

Das umfasst auch die Runtime-Observabilität, also die Möglichkeiten, zur Laufzeit Fehler oder Zustände zu erkennen und zu analysieren. Bestimmte Programmierkonstrukte erschweren das Verständnis erheblich. Indirektionen, Callbacks, komplexe Makros und Ausnahmen können das Springen im Code unmöglich machen und somit die Nachvollziehbarkeit verringern. Später abgelegte, zeitlich versetzte Callbacks sind besonders problematisch, da unklar ist, wann und in welchem Zustand sie ausgeführt werden. Solche asynchronen Konstrukte verwandeln Programme in Listen undurchsichtiger Zustände, was Debugging und Profilierung stark erschwert.

Ein Programmierstil, der synchron auf Ereignisse reagiert und Zustände zentral verwaltet, ist hier oft vorteilhafter. Ein strukturierter Umgang mit Zustand ist essentiell. Idealerweise ist alle Zustandsinformation von einer einzigen Wurzel aus zugänglich und logisch in einem Baum organisiert. Dies erleichtert es jedem Entwickler, die Ressourcen zu überblicken, Fehler zu finden oder einzelne Teile zu testen. Zeiger oder Referenzen, die zwischen beliebigen Komponenten hin- und herzeigen, führen schnell zu einem undurchsichtigen „Dschungel“ von Zuständen, der schwer zu warten ist.

Gerade in Sprachen ohne automatische Speicherverwaltung können solche Strukturen zu schwer identifizierbaren Fehlern führen. Das Design sollte außerdem ein „Downstream-Access“ Prinzip verfolgen: Funktionen können nur auf Zustände zugreifen, die unterhalb ihrer Position im Baum liegen, nicht aber auf Geschwister oder Eltern. Dies minimiert Risiken, dass ungewollt Zustände verändert werden oder Invarianten verletzt werden, die möglicherweise temporär außer Kraft gesetzt sind. Funktionale Aufteilung im Code sollte so erfolgen, dass komplizierte Kontrollflüsse möglichst lokal zusammengefasst werden. Lange Funktionen sind oft besser lesbar als viele kleine, zwischen denen man ständig springen muss – vor allem wenn der Überblick über den Ablauf dadurch verloren geht.

Temporäre Variablen und Zwischenwerte lassen sich zudem in Blöcke kapseln, um den Lesefluss zu verbessern. Ein wichtiger Tipp für das Entwickeln von Hochleistungssoftware ist es, Architekturentscheidungen frühzeitig mit Kenntnis der zugrundeliegenden Hardware und Datenmengen zu treffen. Einfach erst alles programmieren und erst dann optimieren ist oft ineffizient. Stattdessen hilft es, sich Orientierung an theoretischen Maximalwerten zu geben und Profiling gezielt einzusetzen, um fundierte Verbesserungen zu erarbeiten. Auch sollte man sich bewusst sein, dass bessere Leistung nicht immer komplexeren Code bedeutet.

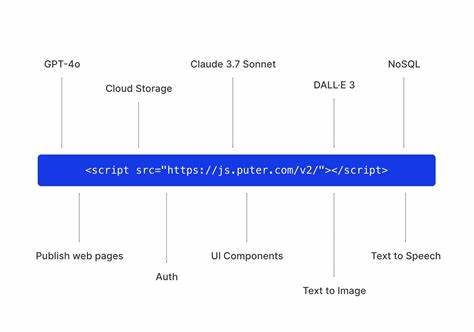

Vielmehr erlaubt ein durchdachtes Architekturdesign oft eine Vereinfachung des Systems als Ganzes. Beispiele zeigen, dass Programme, die extrem hohe Leistung liefern, selten einfach nur Hotspots optimieren, sondern ihre Gesamtsystemstruktur anpassen, um die Hardware effizient zu nutzen. Die Zentralisierung von Code, der Komponenten initialisiert und deren Zusammenspiel definiert, erleichtert das Verständnis erheblich. Das Risiko nichtdeterministischen Verhaltens lässt sich durch klare Steuerung und der Isolierung von unsicheren Elementen an den Systemrand verringern. So können etwa Netzwerkkommunikation oder Zufallselemente kontrolliert und reproduzierbar gemacht werden.

Fazit: Programmieren ist primär ein Prozess des Denkens über Verhalten, Daten und Ressourcen. Ein datenorientierter Ansatz, der Fakten präzise modelliert und klare, nachvollziehbare Abläufe definiert, führt zu sauberem und effizientem Code. Deklarative Eleganz ist schön, darf aber nicht auf Kosten von Klarheit und Kontrolle gehen. Nur durch den bewussten Umgang mit Daten, Zuständen und Rechenprozessen entsteht Software, die sowohl gut wartbar als auch leistungsfähig ist.