In der heutigen digitalen Welt gewinnen Large Language Models (LLMs) zunehmend an Bedeutung. Sie unterstützen Softwareentwickler, erstellen Texte und bieten Lösungen für komplexe Probleme. Doch je mehr diese KI-Systeme in den Arbeitsalltag integriert werden, desto wichtiger wird es, den Umgang mit ihnen verantwortungsvoll zu gestalten. Besonders im Softwareentwicklungsprozess besteht die Gefahr, dass die eigentliche Identität des Entwicklers verwischt oder sogar gestohlen wird, wenn KI-generierter Code nicht korrekt gekennzeichnet wird. Diese Problematik wirft wichtige Fragen zur Transparenz, Urheberschaft und Nachvollziehbarkeit der Arbeit auf, die in Zeiten moderner KI unverzichtbar sind.

Es ist entscheidend, Mechanismen zu etablieren, die sicherstellen, dass menschliche Entwickler nicht übergangen oder die Anerkennung ihrer Beiträge entzogen wird. Die Einbindung von LLMs als Hilfsmittel hat den Vorteil, komplexe Codefragmente schnell zu generieren und repetitive Aufgaben zu erleichtern. Trotzdem bleibt der menschliche Entwickler der zentrale Entscheider, der Verantwortung für die Korrektheit und Sicherheit des Codes übernimmt. Ein kritischer Aspekt dabei ist die Identifikation der Quelle einzelner Codeabschnitte. Wenn Programmierer den automatisch generierten Code nicht entsprechend kennzeichnen, besteht die Gefahr, dass ihre individuelle Arbeit durch die KI überschattet wird.

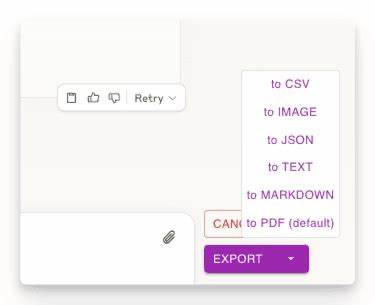

Man darf nicht außer Acht lassen, dass letztlich der Mensch die Verantwortung trägt – sei es bei Fehlern, Sicherheitslücken oder beim geistigen Eigentum. Um dieser Problematik zu begegnen, hat sich ein bewährter Prozess bei der Nutzung von LLMs etabliert. Die Empfehlung lautet, für jeden Einsatz einer KI stets einen separaten Git-Benutzeraccount zu verwenden. Dieser Benutzeraccount dient dazu, die Commits, welche direkt aus den generierten Vorschlägen der LLM stammen, transparent und sauber von den eigenen Beiträgen abzugrenzen. Nach dem automatischen Commit wird der Code gründlich geprüft, angepasst und überarbeitet.

Anschließend erfolgt ein separater Commit mit dem persönlichen Git-User, um klarzustellen, welchen Anteil der Entwickler selbst beigetragen und verbessert hat. Dieses Vorgehen sorgt für Nachvollziehbarkeit und wahrt die Integrität des Entwicklers. Ein oft unterschätzter Vorteil dieser Praxis liegt in der klaren Trennung der Verantwortlichkeiten. Wenn KI-generierter Code ohne eigene Korrektur übernommen wird, kann es später schwierig werden, Fehlerquellen oder Schwachstellen zuzuordnen. Entwickler, die ihre Änderungen separat committen, zeigen klar auf, welche Teile verifiziert und eigenständig optimiert wurden.

Diese Transparenz ermöglicht es auch Teamleitern und Auditoren, den Entwicklungsprozess besser zu verstehen und gegebenenfalls Haftungsfragen klarer zu beantworten. Zudem fördert diese Arbeitsweise ein bewussteres und reflektiertes Zusammenspiel zwischen Mensch und Maschine. Die Diskussion um Identitätsdiebstahl durch LLMs ist nicht nur ein technisches Thema sondern auch eine ethische Herausforderung. KI als Tool sollte den Entwickler unterstützen, keinesfalls seine Rolle verdrängen oder die Anerkennung seiner Leistung einschränken. Dabei spielt die Dokumentation eine zentrale Rolle.

Eine klare Kommentierung und sorgfältige Versionskontrolle schützen nicht nur vor Missverständnissen, sondern helfen auch, den eigenen Beitrag im gesamten Projektverlauf sichtbar und verständlich zu machen. Gerade in einem Umfeld, in dem mehrere Entwickler und automatisierte Systeme zusammenarbeiten, ist es unerlässlich, die Spur der einzelnen Beiträge eindeutig nachzuvollziehen. Für Unternehmen bedeutet dies, klare Richtlinien und Standards zur Verwendung von LLMs einzuführen. Nur so lässt sich gewährleisten, dass sowohl die Compliance-Anforderungen erfüllt werden als auch die Rechte der Entwickler geschützt bleiben. Die Integration von KI-Tools sollte stets begleitet werden von Schulungen, die Entwickler über korrekte Verfahren und ethische Fragestellungen informieren.

Auf diese Weise können Teams das Potenzial von LLMs optimal nutzen, ohne Sicherheits- oder Identitätsrisiken einzugehen. Die Technologie entwickelt sich rasant, daher ist es ebenso wichtig, sich kontinuierlich über neue Best Practices und Sicherheitsmechanismen auf dem Laufenden zu halten. Die Verantwortung liegt nicht nur bei den einzelnen Entwicklern, sondern auch bei Plattformanbietern, Open-Source-Gemeinschaften und Führungskräften in der Softwareentwicklung. Ein gemeinschaftlicher Ansatz zur Problemvermeidung und Transparenz stärkt das Vertrauen in AI-gestützte Entwicklungsprozesse. Zusammenfassend lässt sich sagen, dass der Schutz der eigenen Identität bei der Nutzung von LLMs eine Kombination aus technischem Vorgehen, verantwortungsvollem Verhalten und organisatorischen Maßnahmen erfordert.

Indem Entwickler auf die Trennung der Git-User achten, ihre Arbeit dokumentieren und den generierten Code kritisch prüfen, verhindern sie, dass die KI mehr als nur ein Werkzeug bleibt. Stattdessen wird sie zum wirkungsvollen Partner, der das kreative und technische Potenzial des Menschen ergänzt, ohne dessen Rechte und Anerkennung zu beeinträchtigen. In einer Zeit, in der künstliche Intelligenz zunehmend unseren Arbeitsalltag durchdringt, ist diese Balance essenziell, um Innovation und Integrität zu vereinen.

![Testing noise cancellation voice+vision AI [video]](/images/6DDF526C-B41C-41A3-84B3-D8E23D86DCA3)