In der heutigen digitalen Welt ist die Wahl der richtigen Datenbanktechnologie von entscheidender Bedeutung für den Erfolg von Softwareanwendungen. Immer mehr Unternehmen stehen vor der Herausforderung, bestehende Datenbanksysteme zu überdenken und gegebenenfalls zu migrieren, um Kosten zu senken, Leistung zu steigern und zukünftige Skalierbarkeit sicherzustellen. Ein häufig gewählter Kandidat für solche Migrationen ist Postgres, eine leistungsstarke Open-Source-Datenbank, die sich durch Stabilität, Flexibilität und eine lebendige Entwickler-Community auszeichnet. Doch warum entscheiden sich Unternehmen für den Wechsel zu Postgres, und wie kann eine solche Migration effektiv umgesetzt werden? Im Folgenden werden diese Fragen auf Basis realer Praxiserfahrungen eingehend erläutert. Viele junge Unternehmen setzen zunächst auf verteilte SQL-Datenbanken wie CockroachDB, die insbesondere aufgrund ihrer automatischen horizontalen Skalierung und der einfachen Einrichtung von Mehrregionen-Setups punkten.

Diese Technologien versprechen hohe Verfügbarkeit und eine nahtlose Skalierung über verschiedene geografische Regionen hinweg, was besonders unter Datenschutzgesichtspunkten wie der DSGVO wichtig ist. So auch bei Motion, einem innovativen Softwareunternehmen, das bis Anfang 2022 CockroachDB nutzte. Ihre Entscheidung beruhte vor allem auf der Passwortfreundlichkeit der Multi-Region-Unterstützung und dem SQL-kompatiblen Interface. Mit zunehmendem Wachstum und steigendem Nutzungsaufkommen zeigten sich jedoch gravierende Nachteile. Die Betriebskosten explodierten auf ein Vielfaches und erreichten bis 2024 den mittleren sechsstelligen Bereich.

Dabei verliefen alle Operationen bislang in einer einzigen Region mit vergleichsweise einfachen transaktionalen Datenbankabfragen. Dieser Kosten-Nutzen-Konflikt rückte die Frage in den Fokus, ob ein robustes und gut unterhaltenes Postgres-System nicht wirtschaftlich und technisch sinnvoller wäre, auch wenn es nicht von Haus aus eine Multi-Region-Strategie abbildet. Die Migration zu einem neuen Datenbanksystem ist jedoch alles andere als trivial. Insbesondere bei umfangreichen und komplexen Datenstrukturen, wie sie in großen Anwendungen üblich sind, stellen Datenmigration und Schemaänderungen eine erhebliche Herausforderung dar. Ein zentrales Problem waren bei Motion vor allem Migrationsvorgänge, bei denen die bisher eingesetzte Object-Relational-Mapper-Lösung Prisma häufig aufgrund von Zeitüberschreitungen versagte.

CockroachDB konnte große Migrationen oft nicht in akzeptabler Zeit durchführen, was zu mehrfachen manuellen Eingriffen und erheblichen Verzögerungen im Deployment führte. Im direkten Vergleich konnte Postgres bei denselben Migrationen eindrucksvoll zeigen, wie schnell und effizient solche Änderungen ablaufen. Beispielsweise dauerte die Hinzufügung einer neuen Spalte in einer stark frequentierten Tabelle unter Postgres nur wenige Sekunden, während CockroachDB in diesem Szenario mehrfach scheiterte und den Prozess blockierte. Diese Leistungsunterschiede führten zu einer unangenehmen Situation, in der selbst erfahrene Entwickler Arbeitsprozesse außerhalb der Datenbank durchführen mussten, um System-Lockups zu vermeiden. Änderungsprozesse wurden somit erheblich erschwert und verzögerten notwendige Updates des CockroachDB-Systems, was wiederum den technischen Support erschwerte.

Neben den Migrationen zeigten sich auch bei ETL-Prozessen erhebliche Probleme. Die Schnittstellen von Drittlösungen wie Airbyte waren entweder unzureichend oder befanden sich in einem frühen Entwicklungsstadium, was durch Probleme wie Speicherlecks noch verschärft wurde. Ein funktionierendes und zuverlässiges Daten-Extraktions- und Ladeverfahren ist jedoch essentiell für stabile Datenpipelines und eine zeitnahe Konsolidierung. Durch die eingeschränkten Möglichkeiten bei CockroachDB verloren Unternehmen wertvolle Zeit und mussten mit erheblichen Leistungseinbußen leben. Die Leistungsfähigkeit von Postgres im Vergleich zu CockroachDB zeigte sich auch bei der Ausführung von Datenbankabfragen.

Während CockroachDB bei bestimmten Abfragen dank seines Optimierers Vorteile bot, war die Mehrheit der realweltlichen Anwendungsabfragen stark auf komplexe Join- und Aggregationsabfragen angewiesen. Diese führten dort jedoch zu deutlich höheren Latenzen. Postgres konnte in vielen Fällen durch eine effizientere Abfrageplanung und ausgefeilte Indexstrategie erheblich schnellere Ergebnisse liefern und so den Alltag der Entwickler und Anwender deutlich verbessern. Darüber hinaus belasteten bestimmte Eigenheiten bei CockroachDB die Nutzererfahrung nachhaltig. Beispielsweise war das Management von Indizes schwierig, da die Anzeige für nicht verwendete Indizes häufig irreführend war.

Ebenso gestattete der disributierte Charakter von CockroachDB keine einfache Abbruchmöglichkeit laufender, rechenintensiver Abfragen via SQL-Clients, was im Fehlerfall zu langwierigen Problemen führte. Der Support war zudem nur schwer erreichbar und der administrative Umgang teilweise sehr umständlich gestaltet. Technische Hürden betrafen darüber hinaus die Netzwerkinfrastruktur. Zeitweise auftretende Verbindungsprobleme über Tailscale beeinträchtigten die Erreichbarkeit der Datenbankcluster und erschwerten den zuverlässigen Betrieb. Solche Herausforderungen blieben bei Postgres aus, was zu einer stabileren Entwicklungsumgebung führte.

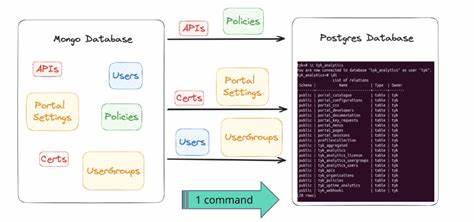

Die finale Migration selbst war ein Kraftakt, der viel eigenes Engineering erforderte, denn fertige Tools im CockroachDB-Umfeld waren rar. Ein maßgeschneiderter ETL-Prozess kam hierbei zum Einsatz, der auf moderner Software wie Bun basierte. Dieser Prozess extrahierte zunächst das komplette Datenbankschema und die zugehörigen Daten in Dateien und führte anschließend eine Streaming-gestützte Einspeisung in das neue Postgres-System durch. Für die Umwandlung von speziellen Datentypen wie JSON- und Array-Kodierungen mussten eigens entwickelte Parsing- und Transformationsroutinen implementiert werden, um eine hundertprozentige Kompatibilität sicherzustellen. Trotz der Komplexität löste sich der gesamte Prozess nach einigen Tests in Luft auf.

Auf einem leistungsstarken virtuellen Server dauerte die Migration des etwa 100 Millionen Zeilen umfassenden Systems lediglich rund 15 Minuten im produktiven Einsatz. Das Unternehmen entschied sich, eine vorsichtige Betriebsruhe von rund einer Stunde einzulegen, um etwaige Risiken auszuschließen und nach der Migration den Traffic schrittweise hochzufahren. Die Vorteile zeigten sich unmittelbar nach dem Wechsel. Die aggregierten Antwortzeiten der Anwendungen verbesserten sich um ein Drittel. Bereits wenige Stunden später konnten durch das Postgres-Ökosystem und Tools wie PGAnalyze mehrere bislang ungeschliffene Abfragen identifiziert und optimiert werden.

Das führte nicht nur zu besseren Laufzeiten, sondern gewährleistete auch eine langfristige Stabilität und Wartungsfreundlichkeit der Datenbank. Ein weiterer, nicht zu unterschätzender Faktor war die signifikante Kosteneinsparung. Allein durch den Wechsel konnte das Unternehmen die jährlichen Datenbankkosten um über 110.000 US-Dollar reduzieren. Dieses Einsparpotenzial wächst mit steigendem Datenverkehr und der fortschreitenden Skalierung der Architektur weiter.

Der Wechsel zu Postgres ist deshalb keine rein technische Entscheidung, sondern gleichzeitig ein wirtschaftlicher und strategischer Meilenstein. Die Open-Source-Natur von Postgres bietet zusätzlich die Freiheit, ohne teure Lizenzgebühren zu skalieren und von einer großen Community sowie einem vielfältigen Ökosystem zu profitieren. Zusammenfassend lässt sich sagen, dass die Migration zu Postgres nicht nur Vorteile bezüglich der Performance und Kostenbereinigung mit sich bringt, sondern auch die Entwicklungseffizienz und Betriebssicherheit entscheidend steigert. Unternehmen sollten allerdings ausreichend Planung, Tests und fachliche Expertise investieren, um den Wechsel reibungslos zu gestalten. Ein systematisches Vorgehen bei der Extraktion, Transformation und Migration der Daten ist essenziell, ebenso wie das frühzeitige Benchmarken und Vergleichen von Abfragen und Migrationsprozessen im Zielsystem.

Die Fallstudie von Motion zeigt eindrucksvoll, dass ein einzelner, technisch versierter Entwickler in der Lage war, eine solch komplexe Migration erfolgreich durchzuführen und dadurch den Grundstein für zukünftiges Wachstum zu legen. Wer sich heute mit Datenbanktechnologie beschäftigt, sollte Postgres auf dem Schirm haben und die stetig wachsende Innovationskraft und Stabilität dieser Plattform nutzen, um nachhaltige und zukunftsfähige Lösungen zu implementieren. Die Entscheidung für Postgres bedeutet nicht nur eine technologische Neuausrichtung, sondern auch eine Investition in Flexibilität, Skalierbarkeit und wirtschaftliche Effizienz. Gerade Unternehmen mit starkem Wachstumspotential und steigenden Datenvolumina profitieren von der hohen Performance und dem umfangreichen Funktionsumfang dieser Datenbank, was letztendlich den Erfolg der gesamten Anwendung und die Zufriedenheit der Anwender maßgeblich steigert.

![How a Mechanical Watch Works (2020) [video]](/images/A2096DBE-5117-4C9D-B430-B0105DC44435)