Die rasante Entwicklung der Künstlichen Intelligenz hat in den letzten Jahren nicht nur technologische, sondern auch gesellschaftliche Debatten entfacht. Im Kern dieser Gespräche steht die Frage, wie schnell Algorithmen die Fähigkeiten von KI-Systemen verbessern können und welche Faktoren diese Geschwindigkeit maßgeblich beeinflussen. Insbesondere im Kontext der voranschreitenden Superintelligenz-Szenarien wird vielfach diskutiert, ob eine schnelle Selbstverbesserung von Algorithmen zu einem sprunghaften Fortschritt führen kann – oft beschrieben als eine sogenannte „Software-Intelligenzexplosion“. Um diese Frage zu beantworten, lohnt es sich, die Rolle der Rechenkapazität, die Art der algorithmischen Innovationen sowie die Grenzen der Skalierbarkeit eingehender zu beleuchten. Ein zentraler Aspekt dabei ist, inwiefern entscheidende algorithmische Fortschritte unabhängig von der genutzten Rechenleistung funktionieren oder ob sie erst durch sehr leistungsfähige Hardware überhaupt signifikante Vorteile entfalten können.

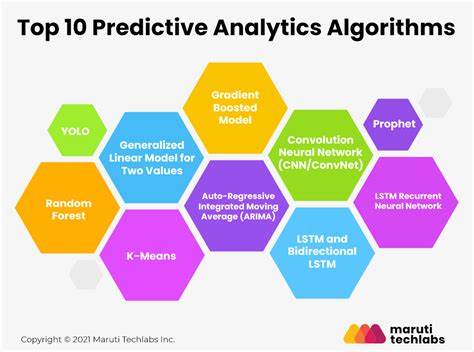

Die Unterscheidung zwischen compute-unabhängigen und compute-abhängigen Verbesserungen ist dabei essenziell. Compute-unabhängige Fortschritte zeigen bereits in kleineren Modellen deutliche Leistungssteigerungen, die sich mit zunehmender Modellgröße meist weiter verstärken. Ein Beispiel hierfür ist die Layer-Normalisierung, die in frühen neuronalen Netzwerken eingeführt wurde und bis heute eine grundlegende Methode zur Stabilisierung und Beschleunigung des Trainings darstellt. Diese Art von Verbesserungen ermöglicht es, auch bei begrenzten Hardware-Ressourcen sichtbare Fortschritte zu erzielen. Im Gegensatz dazu existieren compute-abhängige algorithmische Innovationen, die erst bei erheblichen Rechenressourcen ihre Wirkung voll entfalten und sich auf kleineren Modellen kaum oder sogar negativ auswirken können.

Die Entwicklung des Transformer-Architekturschemas ist ein Paradebeispiel dafür. Ursprünglich revolutionierte dieser Ansatz Sprachmodelle mit enormem Skalierungspotenzial, das jedoch erst bei sehr großen Datenmengen und massiver Rechenleistung richtig zur Geltung kommt. Ähnlich verhält es sich mit Konzepten wie der Multi-Query-Attention, die zunächst auf kleineren Modellen kaum Vorteile bieten, aber bei größeren Systemen die Speicher- und Effizienzeigenschaften deutlich verbessern. Nicht zuletzt zeigt ein Blick auf konkrete Fallbeispiele, wie sich dieser Unterschied in der Praxis äußert. So konnte das chinesische KI-Projekt DeepSeek trotz deutlicher Hardware-Restriktionen durch aufwändige algorithmische Verbesserungen bemerkenswerte Ergebnisse erzielen.

Dabei kamen technische Innovationen wie Multi-Headed Latent Attention und Mixture-of-Experts zum Einsatz, die typischerweise eine sehr hohe Rechenleistung voraussetzen, um ihr volles Potenzial auszuschöpfen. Das Beispiel unterstreicht, dass auch bei limitierten Ressourcen durch clevere algorithmische Anpassungen Fortschritte möglich sind, gleichzeitig aber die größten Performance-Sprünge typischerweise von solchen Innovationen getragen werden, welche rechenintensive Umgebungen benötigen. Die Forschung zeigt, dass die größten historischen Fortschritte im Bereich der KI häufig durch compute-abhängige Innovationen erzielt wurden, die oft erst bei gigantischen Modellen mit entsprechendem Training auf leistungsstarker Hardware sichtbar wurden. Diese Innovationen können die Effizienz und Leistungsfähigkeit von Modellen um Faktoren zwischen zehn und fünfzig oder sogar mehr steigern. Sie stellen somit den Hauptmotor hinter großen Entwicklungssprüngen dar und sind bisher für etwa 99 Prozent des kumulierten Rechenäquivalentgewinns verantwortlich.

Daraus folgt, dass Rechenkapazität und Algorithmen eng miteinander verzahnt sind: Fortschritte in der Hardware ermöglichen neue algorithmische Paradigmen, während diese Paradigmen wiederum die geeignete Nutzung der Hardware vorantreiben. Gleichzeitig bieten compute-unabhängige Fortschritte eine wichtige Grundlage, die es auch Forschungsteams mit eingeschränkten Ressourcen ermöglicht, substanzielle Leistungssteigerungen zu erzielen und Erkenntnisse zu gewinnen. So konnten Experimente auf kleineren Modellen etwa mit Methoden wie Layer Normalization, Positionally Encoded Embedding (RoPE) und FlashAttention deutlich messbare Verbesserungen erzielen. Obwohl diese Effekte im Vergleich zu compute-abhängigen Innovationen geringer ausfallen, machen sie doch einen wesentlichen Beitrag zu nachhaltigem Fortschritt aus und senken die Einstiegshürde für neue Entwicklungen. In der Praxis bedeutet das, dass die Geschwindigkeit der algorithmischen Weiterentwicklung stark davon abhängt, wie leicht es Forschern gelingt, compute-abhängige Innovationen zu entdecken und zu verifizieren.

Diese Innovationen sind oft schwer zu finden, erfordern komplexe Experimente auf sehr großen Modellen und sind nur bei entsprechendem Compute-Pool zugänglich. Labs mit großen Rechnerressourcen besitzen daher einen signifikanten Wettbewerbsvorteil, da sie schneller neue, leistungsfähige Ansätze validieren und implementieren können. Diese Dynamik hat Auswirkungen auf die Governance und Regulierung der KI-Entwicklung, da schwer zugängliche Ressourcen den Fortschritt verlangsamen könnten, während compute-unabhängige Fortschritte weiterhin in der Breite erforscht werden. Dass weniger rasant wachsende Hardware-Ressourcen nicht automatisch einen Stillstand der algorithmischen Innovation bedeuten, zeigen Beobachtungen, wonach einige Entwickler erfolgreich sogenannte Mid-Scale-Experimente durchführen. Dabei werden zwar deutlich geringere Rechenkapazitäten als bei den größten Trainingsläufen eingesetzt, jedoch ausreichend, um compute-abhängige Effekte zumindest anzudeuten.

Somit können auch unter leicht eingeschränkten Bedingungen wichtige Entdeckungen gemacht werden, vorausgesetzt, die Teams verfügen über das nötige Know-how und die Methodik. Dennoch bleiben die bedeutungsvollsten Durchbrüche traditionell an Labore mit Zugang zu High-End-Compute gebunden. Neben reiner Hardware und Algorithmen spielen weitere Faktoren wie die Qualität und Zusammensetzung von Trainingsdaten eine wesentliche Rolle bei Fortschritten im KI-Bereich. Verbesserungen in der Datenbereitstellung können algorithmische Entwicklungen ergänzen oder beschleunigen, ebenso wie innovative Trainingsmethoden und Incorporation von Feedback-Techniken nach dem Pre-Training wie etwa Reinforcement Learning oder Fine-Tuning. Diese Aspekte wurden in aktuellen Untersuchungen meist nicht primär berücksichtigt, bieten jedoch weitere Hebel für die Entwicklung leistungsfähigerer KI-Systeme.

Im Fazit lässt sich festhalten, dass die Geschwindigkeit und das Ausmaß, mit denen Algorithmen KI-Fähigkeiten verbessern können, eng mit der Verfügbarkeit und dem effektiven Einsatz von Rechenressourcen verknüpft sind. Während kleinere und weniger rechenintensive Innovationen wichtige Beiträge leisten und Barrieren verringern, sind die markanten Sprünge in der Leistungsfähigkeit bislang fast immer an große Rechenkapazitäten gekoppelt. Dies prägt auch die Forschungslandschaft, indem gut ausgestattete Einrichtungen einen Vorsprung bei der Erforschung und Validierung bahnbrechender, compute-abhängiger Algorithmus-Generationen haben. Daraus folgt, dass das zukünftige Tempo der KI-Entwicklung stark davon abhängen wird, wie rasch und effizient solche algorithmischen Innovationen entdeckt und anwendbar gemacht werden können – was wiederum durch die Hardware-Infrastruktur, Experimentiermethoden und organisatorische Rahmenbedingungen beeinflusst wird. Die Herausforderung für Wissenschaft und Wirtschaft besteht darin, einen Ausgleich zu schaffen: Einerseits müssen Investitionen in High-End-Computing-Skalierung erfolgen, um die vielversprechendsten compute-abhängigen Fortschritte zu ermöglichen, andererseits sollten compute-unabhängige Innovationen systematisch gefördert werden, um eine breitere Zugänglichkeit von KI-Technologien zu gewährleisten.

Nur so wird ein nachhaltiger Fortschritt garantiert, der sowohl schnell als auch inklusiv ist. Experten appellieren deshalb an eine differenzierte Strategie bei der KI-Governance, die sowohl Hardware-Beschränkungen als auch algorithmische Potenziale berücksichtigt und so eine fundierte Prognose sowie Steuerung des zukünftigen Entwicklungstempos ermöglicht. Zusammenfassend steht fest, dass Algorithmen die Fähigkeiten von KI-Systemen weiterhin schnell verbessern können – allerdings ist dieser Fortschritt nicht unabhängig von den zugrunde liegenden Rechenressourcen zu sehen. Die spannendste Frage wird sein, wie Forscher zukünftig die Balance finden zwischen der Entdeckung bahnbrechender, rechenintensiver Algorithmen und der Optimierung vorhandener, weniger rechenabhängiger Ansätze, um so die Entwicklung der KI nachhaltig voranzutreiben.