In einer Welt, die zunehmend von Technologien durchdrungen ist, spielt die Kommunikation zwischen Mensch und Maschine eine immer bedeutendere Rolle. Künstliche Intelligenz (KI) übernimmt mittlerweile zahlreiche Aufgaben, von Sprachassistenten über automatisierte Kundenbetreuung bis hin zu Echtzeit-Übersetzungen. Trotz der enormen Fortschritte in diesen Bereichen bleibt eine Herausforderung besonders relevant und bislang oft vernachlässigt: die korrekte Aussprache von Namen. Diese scheinbar einfache Fähigkeit ist jedoch ein wesentlicher Bestandteil menschlicher Identität und kultureller Anerkennung. Projekt Sapiens widmet sich genau dieser Herausforderung, indem es die „Aussprache-Schicht“ für KI aufbaut – eine Innovation, die präzise Namensaussprachen auf der Ebene einzelner Laute ermöglicht und so die menschliche Kommunikation mit Maschinen revolutioniert.

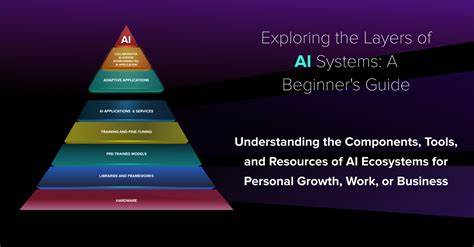

Der Begriff „Aussprache-Schicht“ beschreibt eine neue fundamentale Ebene in der Architektur moderner KI-Systeme. Während bisherige KI-Modelle vorwiegend auf der Verarbeitung von Texteingaben, Bildern und normalen Audioinhalten basieren, fehlt oftmals ein spezialisiertes Modul, das sich auf die verlässliche und kulturell korrekte Wiedergabe von Namen konzentriert. Diese Schicht agiert als Bindeglied zwischen dem Sprachverständnis und der gesprochenen Interaktion und sorgt dafür, dass KI-Systeme nicht nur Worte erkennen, sondern sie auch aussprechen wie ein Mensch, der mit den jeweiligen kulturellen und sprachlichen Nuancen vertraut ist. Eine der großen Herausforderungen bei der präzisen Namensausprache liegt in der Vielfalt der Sprachen, Dialekte und regionalen Besonderheiten weltweit. Namen sind nicht nur Worte, sie tragen historische, kulturelle und persönliche Bedeutung.

Die korrekte Aussprache ist daher auch ein Ausdruck von Respekt und Identitätswahrung. Werden Namen falsch ausgesprochen, kann dies zu Frustration bei Nutzern führen und das Vertrauen in KI-basierte Systeme beeinträchtigen. Projekt Sapiens hat es sich zur Aufgabe gemacht, diese Barriere zu überwinden, indem es ein umfassendes und verifiziertes Datenbank- und API-System entwickelt, das phonemische Informationen zu Namen aus Hunderten von Kulturen und Regionen liefert. Phoneme sind dabei das zentrale Element. Sie sind die kleinsten klanglichen Einheiten einer Sprache, vergleichbar mit den Bausteinen, aus denen Wörter zusammengesetzt werden.

Während die Schreibweise eines Namens eine visuelle Information ist, gibt das phonemische Transkript Auskunft über seine tatsächliche Aussprache. Diese Trennung ist entscheidend, denn oft lassen sich aus der Schreibweise die korrekten Laute nicht eindeutig ableiten. Das international anerkannten IPA (International Phonetic Alphabet) wird hierfür verwendet, um die Klangstruktur systematisch zu beschreiben und damit Maschinen zu ermöglichen, Namen präzise auszusprechen. Ein Beispiel verdeutlicht diese Komplexität sehr gut: Der Name „Aisling“ aus dem Irischen besteht aus mehreren spezifischen Lauten, die mit IPA-Symbolen wie /æ/, /ʃ/, /l/, /ɪŋ/ dargestellt werden. Für ein KI-System bedeutet das, diese Laute zu erkennen, korrekt zu synthetisieren und in der richtigen Reihenfolge auszusprechen.

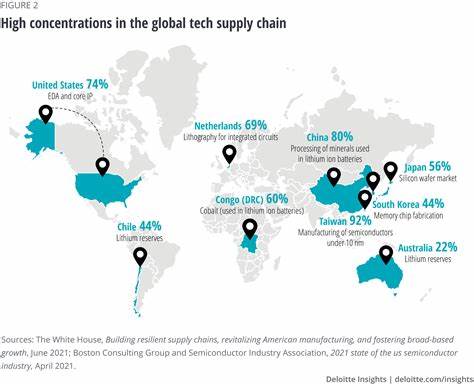

Ohne diese phonemische Feinjustierung könnte die Aussprache stark von der tatsächlichen Erwartungen der Sprecher abweichen – was den Gebrauch von Sprachassistenten oder automatisierten Systemen stark einschränken würde. Der Wert präziser phonemischer Daten beschränkt sich allerdings nicht nur auf die einzelne Namensausprache. Für die Entwicklung großer Sprachmodelle (LLMs) wie jene von Unternehmen wie Meta, Google, OpenAI oder Anthropic ist die Einbindung phonemischer Daten ein entscheidender Fortschritt. Solche Modelle, die zunehmend Echtzeit-Sprachverarbeitung ermöglichen, profitieren enorm von genauen, mehrfach validierten Lautinformationen. Dies verbessert nicht nur die Spracherkennung und -synthese, sondern auch die Kontextsensitivität der KI, sodass Interaktionen natürlicher, respektvoller und kulturell sensibler ablaufen.

Darüber hinaus unterstützt die sprachübergreifende Abdeckung der Datenbank von Projekt Sapiens auch die Multilingualität in der KI-Forschung. Viele KI-Systeme stehen vor der Herausforderung, gewisse Sprachen oder Dialekte nur unzureichend zu verstehen oder zu sprechen. Die umfassenden und validierten phonemischen Datensätze liefern das nötige Fundament, um Trainingsdatensätze zu erweitern und die Qualität von TTS- (Text-to-Speech) und ASR- (Automatic Speech Recognition) Systemen signifikant zu verbessern. So können Sprachassistenten eine Vielzahl von Namen aus der ganzen Welt korrekt aussprechen, was ein inklusiveres Nutzererlebnis schafft und Barrieren im Sprachgebrauch abbaut. Die Integration dieser Aussprache-Schicht in KI-Architekturen erfolgt oft über APIs, die für Entwickler zugänglich sind und eine nahtlose Einbindung erlauben.

Diese Schnittstellen bieten sowohl Zugriff auf geprüfte Datensätze als auch auf Echtzeit-Funktionalitäten, um in unterschiedlichsten Anwendungen von Chatbots über Navigation bis hin zu Medienproduktion die korrekte Aussprache sicherzustellen. Dies ermöglicht es Unternehmen, ihre Produkte sprachlich zu verfeinern und den Erwartungen ihrer Nutzer gerecht zu werden. Ein weiterer Aspekt der Bedeutung von Projekt Sapiens liegt in der sozialen und ethischen Dimension. Namensaussprachen sind eng mit Identität verbunden. Wenn Sprachsysteme Namen falsch aussprechen, sendet das eine Botschaft der Verkennung und des Mangels an Akzeptanz.

Durch den Aufbau einer robusten, menschzentrierten Datenbasis, die von Muttersprachlern verifizierte Audioaufnahmen und umfangreiche linguistische Prüfungen einschließt, schafft Projekt Sapiens einen Beitrag zu kulturellem Respekt und Diversität in der digitalen Welt. Die bewusste Integration dieser Werte in KI-Systeme stellt sicher, dass Technologie nicht entmenschlicht, sondern Bereicherung für die gesellschaftliche Kommunikation wird. In der nahen Zukunft ist zu erwarten, dass die Aussprache-Schicht von KI-Systemen immer weiter an Bedeutung gewinnen wird. Sprachassistenten werden zunehmend in Alltagsgegenständen integriert sein, von Autos über Smartphones bis hin zu Smart-Home-Systemen. Die korrekte und respektvolle Aussprache von Namen wird dabei nicht nur als technische Fähigkeit verstanden, sondern auch als Voraussetzung für vertrauensvolle Interfaces und personalisierte Nutzererlebnisse.

Somit bedeutet die Entwicklung dieser Aussprache-Schicht auch eine Fortschreibung der menschlichen Kommunikation im digitalen Zeitalter. Nicht zuletzt spielt die Aussprache-Schicht eine zentrale Rolle im Bereich der Barrierefreiheit. Menschen mit unterschiedlichen sprachlichen Hintergründen, Hör- oder Sprachbehinderungen profitieren von KI-Systemen, die nicht nur Sprache erkennen, sondern auch individuell und präzise auf Namen und Begriffe reagieren können. Dies fördert die Inklusion und ermöglicht einen breiteren Zugang zu digitalen Dienstleistungen. Zusammenfassend lässt sich sagen, dass der Aufbau der Aussprache-Schicht für künstliche Intelligenz ein Meilenstein für die Weiterentwicklung sprachbasierter Technologien darstellt.

Mit Projekt Sapiens steht eine innovative Lösung bereit, die phonemische Präzision auf globaler Ebene bereitstellt, um KI-Systeme menschlicher, kulturell sensibler und funktional leistungsfähiger zu machen. Durch das Verstehen und richtige Aussprechen von Namen wird KI in die Lage versetzt, Identitäten zu achten und echte menschliche Kommunikation zu ermöglichen – eine Grundlage für die Zukunft der Interaktion zwischen Mensch und Maschine.