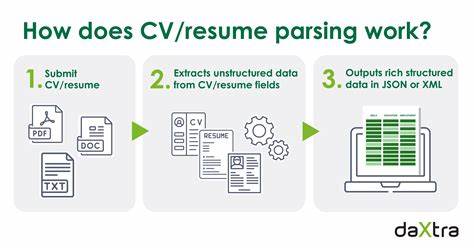

In der heutigen globalisierten Arbeitswelt werden Lebensläufe immer vielfältiger und komplexer gestaltet. Unterschiedliche Layouts, mehrspaltige Designs und variierende Formatierungen stellen klassische Techniken der Texterkennung vor große Herausforderungen. Vor diesem Hintergrund entwickelt Noxx eine innovative Lösung, die künstliche Intelligenz mit gezielter Validierung verbindet, um auch anspruchsvoll formatierte Bewerbungsunterlagen in strukturierte Daten umzuwandeln. Dieses Vorgehen ermöglicht Unternehmen, ihre Recruitment-Prozesse effizienter zu gestalten und internationale Talente mit exakten Informationen schneller zu identifizieren. Die klassische optische Zeichenerkennung (OCR) stößt bei modernen Lebensläufen oft an ihre Grenzen.

Standard-OCR-Methoden verarbeiten Texte sequenziell, meist zeilenweise von oben nach unten und von links nach rechts. Komplexe Dokumente mit nebeneinander angeordneten Informationen, etwa Fähigkeiten auf einer Seite und Berufserfahrung auf der anderen, führen dabei häufig zu fehlerhaften Zuordnungen. Jobtitel können mit falschen Firmen verbunden werden oder wichtige Details gehen in der Textflussaufbereitung verloren. Die Folge ist ein fragmentiertes Bild, das eine automatisierte Weiterverarbeitung erschwert. Noxx begegnet diesen Herausforderungen mit einer neuartigen Herangehensweise, indem nicht nur der reine Text, sondern auch die räumliche Position jedes Textelements erfasst wird.

Durch das Erfassen von sogenannten Bounding Boxes, also rechteckigen Koordinaten, die den genauen Ort eines Textabschnitts auf der Seite beschreiben, bleibt die räumliche Kontextinformation erhalten. Diese zusätzliche Information erlaubt es den eingesetzten großen Sprachmodellen (LLMs), die dokumentübergreifende Struktur nachzuvollziehen und relevante Zusammenhänge besser zu verstehen. Ein Beispiel verdeutlicht dies: Statt nur die Worte „Senior Software Engineer“ zu erfassen, speichert das System zusätzlich die Position zur besser geläufigen Orientierung und Verbindung mit anderen Elementen. Im Rahmen der effizienten Verarbeitung großer Mengen digitaler Lebensläufe spielt neben der Genauigkeit auch die ökonomische Nutzung von Rechenressourcen eine große Rolle. Noxx analysierte verschiedene Datenformate zur Darstellung der räumlichen Informationen und stellte fest, dass manche Formate bei wachsendem Textvolumen effizienter sind und gleichzeitig die Kontexttreue wahren.

Während einfache CSV-Darstellungen zwar die wenigsten Token für die KI bereitstellten, sanken die Genauigkeit und die Zuordnungssicherheit bei komplexeren Dokumenten. Der bewährte Mittelweg wurde in Form des sogenannten „ltwh“-Formats gefunden, das die Position mit den Parametern left (links), top (oben), width (Breite) und height (Höhe) beschreibt. Dieses Format bietet eine ausgewogene Balance zwischen Token-Einsparung und kontextueller Verständlichkeit für das Modell. Zur objektiven Bewertung der unterschiedlichen OCR-Methoden hat das Entwicklungsteam von Noxx ein umfassendes Evaluationssystem mit einer Befehlszeilenschnittstelle (CLI) geschaffen. Darin werden diverse OCR-Pipelines gegeneinander antreten gelassen und anhand eines eigens definierten Ground-Truth-Schemas geprüft.

Dieses Schema fokussiert sich auf zentrale Informationen aus der Berufserfahrung, wie Titel, Unternehmen, Beschreibung und Zeiträume, und validiert die Extraktion mit quantitativen Metriken wie dem Jaccard-Ähnlichkeitsmaß. So lässt sich genau bestimmen, wie präzise und zuverlässig die einzelnen Methoden Daten herausfiltern. Die Vergleichsstudien zeigten, dass OCR-Verfahren, die räumliche Kontexte etwa durch Bounding Boxes mitliefern, deutlich besser abschneiden als reine Textextraktionslösungen. Insbesondere die Integration von AWS Textract mit Bounding Box-Daten bietet ein hervorragendes Verhältnis von Genauigkeit zu Verarbeitungsgeschwindigkeit. Obwohl diese Methode etwas länger pro Dokument benötigt als reine Texterkennungsprozesse, erhöht sich die Treffergenauigkeit auf etwa 97,5 Prozent.

Das ist ein deutlicher Fortschritt, der gerade in produktiven Anwendungen einen entscheidenden Unterschied macht. Neben der reinen technische Leistungsfähigkeit spielen auch Implementierungskosten und Betriebsaspekte eine wichtige Rolle. Die Serverless-Architektur, die Noxx nutzt, profitiert besonders von der nahtlosen Einbindung von AWS Lambda und Textract, da sich hierdurch Wartungsaufwand und Entwicklungszeiten erheblich reduzieren lassen. Eigene OCR-Pipelines zu bauen und zu betreiben, wäre nicht nur komplexer, sondern auch teurer. Somit ist die gewählte Lösung nicht nur aus Sicht der Leistung, sondern auch wirtschaftlich sinnvoll.

Ein weiterer spannender Befund aus den Tests war, dass leicht rauschbehaftete Textergebnisse – wie sie beispielsweise von Tesseract OCR erzeugt werden – bei der anschließenden Verarbeitung durch große Sprachmodelle oft sogar bessere Resultate liefern als völlig bereinigte Daten. Die KI zeigt sich erstaunlich robust gegenüber gewissen Unsauberkeiten und kann die Information aufgrund ihrer kontextuellen Fähigkeiten dennoch sehr gut interpretieren und strukturieren. Dies öffnet die Tür für einen pragmatischen Umgang mit Rohdaten, der den Aufwand für aufwendige Säuberungen und Nachbearbeitungen minimiert. Der Einsatz dieser modernen Validierungsstrategie hebt Noxx deutlich von traditionellen Bewerbermanagementsystemen ab. Während viele Systeme vor allem Stichworte suchen und einfache Filtermechanismen bieten, gelingt es Noxx dank der Kombination aus OCR, Bounding Box-Informationen und leistungsstarken Sprachmodellen, die Bedeutung ganzer Abschnitte eines Lebenslaufs zu erfassen.

Das Ergebnis ist eine präzise, strukturierte Datenbank, die eine intelligente und semantisch fundierte Empfehlung von Kandidaten ermöglicht und gleichzeitig administrative Hürden abbaut. Der gesamte Workflow von der Dokumentenerfassung bis zur finalen Kandidatenauswahl profitiert von der Validierung. Durch das kontinuierliche Messen und Vergleichen der Modell- und OCR-Ergebnisse kann Noxx stetig seine Algorithmen verbessern und an neue Dokumenttypen anpassen. Diese iterative Herangehensweise garantiert, dass die Lösung am Puls der Zeit bleibt und sich flexibel an wechselnde Anforderungen anpassen lässt. Insgesamt lässt sich sagen, dass die Kombination von räumlich informierender Texterkennung und großen Sprachmodellen einen Paradigmenwechsel in der automatisierten Datenextraktion aus komplexformatigen Dokumenten markiert.

Noxx demonstriert damit, wie durch datengestützte Validierung und sorgfältige Evaluierung leistungsfähige KI-basierte Systeme entstehen, die weit über einfache Keyword-Suche hinausgehen. Diese Technologien ebnen den Weg für eine schnellere, kosteneffizientere und objektivere Personalgewinnung auch im internationalen Kontext. Unternehmen, die ihre Auswahlprozesse optimieren und zugleich die Vielfalt und Komplexität heutiger Bewerbungsunterlagen beherrschen wollen, finden in diesen Ansätzen wertvolle Impulse. Die Erfahrungen aus der Validierung bei Noxx zeigen auch, wie wichtig es ist, von vornherein messbare Kriterien festzulegen und mit empirischen Daten fundierte Entscheidungen zu treffen. Gerade im Umgang mit KI-Anwendungen wird der Strukturierung des Entwicklungs- und Testprozesses eine Schlüsselrolle zukommen – vergleichbar mit etablierten Praktiken in der klassischen Softwareentwicklung.

Abschließend empfiehlt sich für Entwicklerteams und HR-Technologieanbieter, die erfolgreiche Kombination aus räumlicher Texterkennung und KI-gestützter Kontextverarbeitung zu prüfen und in eigene Lösungen zu integrieren. Die Ergebnisse von Noxx verdeutlichen, dass hier durch Innovationskraft und konsequente Evaluation deutliche Wettbewerbsvorteile erzielt werden können. Die Zukunft der Bewerberanalyse liegt damit sowohl in der technologischen Finesse als auch in der soliden Validierung, die Qualität und Skalierbarkeit gleichermaßen ermöglicht.