Die Auswahl der richtigen Datenbanklösung ist eine der entscheidenden Anforderungen für moderne Softwareunternehmen. Insbesondere wenn es um Anwendungen mit großen Datenmengen, hohen Verfügbarkeitsanforderungen und komplexen Abfragen geht, stehen Entwickler vor der Herausforderung, eine Datenbank zu finden, die sowohl skalierbar als auch wirtschaftlich ist. CockroachDB hat sich als verteilte Datenbanklösung mit Fokus auf horizontale Skalierbarkeit und Multi-Region-Unterstützung etabliert. Doch nicht immer ist eine solche Lösung die optimale Wahl – gerade dann nicht, wenn sich Anforderungen verändern oder Kosten plötzlich ansteigen. Immer mehr Unternehmen überlegen deshalb, zu einer bewährten und etablierten relationalen Datenbanklösung wie PostgreSQL zu migrieren.

Der Wechsel von CockroachDB zu PostgreSQL bietet zahlreiche Vorteile, bringt jedoch auch Herausforderungen mit sich, die es sorgfältig zu bewältigen gilt. CockroachDB wurde ursprünglich als eine moderne, verteilte SQL-Datenbank konzipiert, die sich durch eine einfache Skalierbarkeit und hohen Grad an Fehlertoleranz auszeichnet. Gerade für Use Cases mit global verteilten Nutzern und gesetzlich vorgeschriebenen Datenlokalisierungen, wie sie beispielsweise durch die Datenschutz-Grundverordnung (DSGVO) notwendig sind, kann CockroachDB ihre Vorteile ausspielen. Allerdings kommen mit diesen Features auch nicht unerhebliche Kosten einher, die insbesondere bei einem anhaltenden Wachstum der Datenbank und der Systemnutzung stark ansteigen können. Die Kosten für CockroachDB sind nicht nur monetärer Natur, sondern auch im Bereich der operativen Komplexität spürbar.

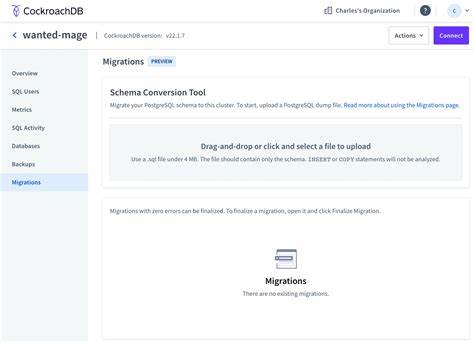

Unternehmen berichten von immer häufiger auftretenden Problemen bei der Migration von Datenbankschemata, beispielsweise wenn ORM-Tools wie Prisma zum Einsatz kommen. In solchen Szenarien können automatische Migrationen von neuen Spalten oder Änderungen am Schema regelmäßig Timeout-Fehler verursachen. Die Folge sind Verzögerungen im Deployment-Prozess und ein hoher manueller Aufwand, um Migrationen zu vollziehen – oft durch manuelles Ausführen von Befehlen direkt am Datenbankcluster. Im Vergleich dazu bietet PostgreSQL durch jahrelange Optimierungen eine robustere, zuverlässigere und vor allem schnellere Verarbeitung von Schemaänderungen. Während CockroachDB in Tests Migrationen mit mehreren Millionen Datensätzen wegen Timeouts oft nicht ohne manuelle Eingriffe bewältigen kann, absolviert PostgreSQL ähnliche Aufgaben in Sekundenbruchteilen.

Diese Performanceverbesserung minimiert das Risiko von Betriebsunterbrechungen, sorgt für einen reibungsloseren Entwicklungsprozess und schont die personellen Ressourcen. Auch im Bereich der ETL-Prozesse und Datenübertragung offenbaren sich bei CockroachDB technische Einschränkungen. Die Unterstützung etablierter ETL-Tools ist nach wie vor gering. Ein Beispiel ist der Airbyte-Connector für CockroachDB, der sich über Jahre hinweg im Alpha-Status befand, somit instabil und mit Speicherlecks behaftet war. Das erschwert die kontinuierliche Datenintegration und behindert die schnelle Verarbeitung großer Datenmengen.

Unternehmen entdecken daher häufig, dass eigene ETL-Skripte notwendig sind, um umfassende Datenmigrationen oder regelmäßige Datensynchronisationen durchzuführen. Diese Eigenentwicklung bindet wertvolle Entwicklerkapazitäten und erhöht das Fehlerrisiko im Betrieb. Die Performance von Abfragen zwischen CockroachDB und PostgreSQL unterscheidet sich stark – was zunächst nicht intuitiv erscheint. Zwar gibt es Einzelfälle, in denen CockroachDB dank seines optimierten Query-Planners schneller ist, beispielsweise bei sehr spezifischen Aggregationsabfragen. Doch im betrieblichen Alltag dominieren deutlich komplexere und vielfach verschachtelte SQL-Anfragen, die von ORM-Generierungswerkzeugen wie Prisma erzeugt werden.

Diese tendieren zu sehr komplexen, schwer optimierbaren SQL-Statements mit zahlreichen Joins, Subqueries und teilweise redundanten Bedingungen. In solchen Fällen zeigt sich, dass PostgreSQL oft die Nase vorn hat. Der relationale Optimizer von PostgreSQL verarbeitet diese Anfragen effizienter, vermeidet aufwändige Full-Table-Scans und kann zudem durch gezieltes Indexmanagement die Antwortzeiten drastisch verkürzen. Zahlreiche reale Beispiele belegen, dass Abfragen auf PostgreSQL um ein Vielfaches schneller sind und somit unmittelbare positive Auswirkungen auf die Nutzererfahrung der Applikationen haben. Kürzere Antwortzeiten beugen Frustrationen vor und erhöhen die Produktivität, was gerade bei SaaS- oder internen Tools von hoher Bedeutung ist.

Neben Performance und Kosten gibt es auch Aspekte, die den Alltag von Entwicklern und Administratoren prägen. So ist das Management von laufenden Queries bei CockroachDB deutlich komplexer als bei PostgreSQL. Während letzteres dank seiner Monolith-Architektur einfach über SQL-Clients oder GUI-Tools wie TablePlus laufende Abfragen abgebrochen werden können, erfordert die Abbruchprozedur bei CockroachDB das Handeln über diverse Nodes und die Benutzung der Cockroach-Konsole. In Produktionsumgebungen kann dies zu zeitintensiven Herausforderungen führen und sogar kritische Ausfälle provozieren. Auch die Unterstützung seitens des Herstellers ist ein nicht zu unterschätzender Faktor.

CockroachDB-Anwender berichten von umständlichen Supportportalen, getrennten Authentifizierungen und langen Antwortzeiten, was in kritischen Situationen den Arbeitsfluss erheblich stören kann. PostgreSQL profitiert von einer großen Community, einer Vielzahl von professionellen Support-Anbietern und einem reichen Ökosystem aus Tools und Erweiterungen, die schnelle Lösungen für Probleme ermöglichen. Technische Hürden beim Datenbankwechsel gibt es natürlich auch beim eigentlichen Migrationsprozess. Insbesondere die Unterschiede in der Serialisierung von Datentypen wie JSON oder Arrays zwischen CockroachDB und PostgreSQL können ungeahnte Fehler hervorrufen. Hier ist eine genaue Analyse und Anpassung der Export- und Importprozesse notwendig, um Datenintegrität und Funktionskompatibilität sicherzustellen.

Individuell entwickelte ETL-Skripte unter Einsatz moderner Programmiersprachen wie Bun oder Node.js helfen dabei, Daten zuverlässig zu transformieren und zu übertragen. Der Betrieb solcher Migrationen erfordert eine gut durchdachte Planung, um Ausfallzeiten so gering wie möglich zu halten. Die Einplanung von Wartungsfenstern, das Staging der Migration in Testumgebungen und das schrittweise Hochfahren der Anwendungen nach erfolgreichem Datenimport sind Bestandteile eines risikominimierenden Prozesses. Praktische Erfahrungen zeigen, dass mit ausreichender Vorbereitung Datenbanken mit Größenordnungen im hohen Millionenbereich innerhalb von weniger als einer Stunde migriert werden können, ohne Datenverlust oder Inkonsistenzen.

Post-Migration eröffnen sich dann neue Möglichkeiten der Optimierung. Die reichhaltigen Werkzeuge von PostgreSQL wie PGAnalyze erlauben es, schwach performante Abfragen schnell zu identifizieren und mittels Indexanpassungen, Query-Rewrites oder Materialized Views zu beschleunigen. Das Resultat sind geringere Latenzzeiten, eine bessere Skalierbarkeit bei steigendem Datenaufkommen und eine spürbare Entlastung der Infrastruktur. Nicht zuletzt führt der Wechsel zu PostgreSQL oft zu erheblichen Kostensenkungen. Die eingesparten Betriebs- und Lizenzkosten können leicht fünfstellig im Jahr betragen und ermöglichen es Unternehmen, diese Ressourcen besser in Produktentwicklung oder Wachstum zu investieren.

Zudem profitieren Entwicklerteams von einfacheren Wartungsprozessen und einer besseren Planbarkeit von Releases, was wiederum eine höhere Produktqualität zur Folge hat. Zusammenfassend lässt sich festhalten, dass der Umstieg von CockroachDB auf PostgreSQL für viele Unternehmen eine sehr sinnvolle Entscheidung ist, wenn sich die Originalanforderungen der Datenbank verändern, sich das Systemwachstum deutlich erhöht und die Kosten die Vorteile übersteigen. PostgreSQL bietet eine reife, stabile und wirtschaftliche Alternative mit exzellentem Performanceprofil, breiter Toolunterstützung und einem starken Community- und Support-Ökosystem. Durch gründliche Planung, angepasstes ETL-Handling und gezielte Optimierungen nach der Migration kann das volle Potenzial der neuen Datenbankumgebung ausgeschöpft werden – mit spürbaren Vorteilen für Entwickler, Betrieb und Anwender gleichermaßen.