In der heutigen schnelllebigen Welt der Informatik ist die Verlässlichkeit wissenschaftlicher Ergebnisse ein zentrales Thema. Immer wieder zieht die Forschung Kritik auf sich, weil Ergebnisse nicht nachvollziehbar sind oder vorgestellte Technologien und Algorithmen sich im Praxistest als unbrauchbar erweisen. Das führt zu einer fundamentalen Frage: Wie wichtig sind Wiederholung, Reproduktion und Replikation von Forschungsergebnissen für den Fortschritt in der Informatik? Die drei Begriffe, obwohl ähnlich klingend, besitzen unterschiedliche Bedeutungen und spielen jeweils eine entscheidende Rolle bei der Absicherung wissenschaftlicher Erkenntnisse. Dieses Spannungsfeld wird häufig durch systemische Herausforderungen wie den starken Publikationsdruck in der akademischen Welt verschärft. Zudem wirken sich technische Veränderungen und wirtschaftliche Aspekte auf den Nachvollziehbarkeitsprozess aus.

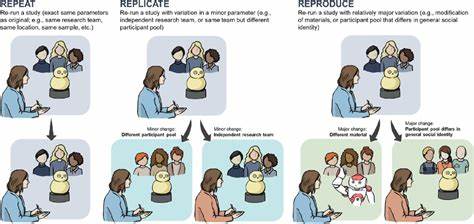

Ein genauerer Blick auf diese Dynamik offenbart Ursachen, Probleme und potenzielle Lösungsansätze für eine robuste, vertrauenswürdige Informatikforschung. Wiederholen bedeutet in der Wissenschaft, ein Experiment wie ursprünglich durchgeführt exakt zu wiederholen. Dabei wird die gleiche Methodik, die gleichen Daten und die identische Hardwareumgebung genutzt, um die Ergebnisse zu überprüfen. In der Informatik zeigt sich dieses Konzept als besonders anspruchsvoll, da Softwaresysteme und Hardwarekomponenten sich rasant weiterentwickeln und oft nicht exakt rekonstruierbar sind. Egal ob ein Algorithmus zur Netzwerksicherheit oder ein Betriebssystemteil getestet wird, die exakte Wiederholung erfordert verlässlichen Zugang zu Originalquellcode, Konfigurationsdetails und Testumgebungen.

Leider ist das in der Praxis oft nicht der Fall, da viele Veröffentlichungen diese vollständigen Informationen nicht liefern. Zugleich müssten Wissenschaftler ihre experimentellen Artefakte bereitstellen. Zwar hat beispielsweise die Association for Computing Machinery (ACM) Badges eingeführt, die Software und Datensätze als Teil der Veröffentlichung kennzeichnen, doch ist die Einreichung solcher Daten nicht verpflichtend. Das hält viele Forscher davon ab, vollständige Umsetzungsmaterialien zu teilen oder langfristig zu pflegen. Die Geschwindigkeit der technologischen Entwicklung in der Informatik ist ein weiterer Grund, warum exaktes Wiederholen zur Herausforderung wird.

Veraltete Hardware ist schwer erhältlich und die Softwareumgebungen ändern sich oft so schnell, dass ehemals funktionierende Systeme nicht mehr lauffähig sind. Diese Dynamik fördert eine Art „Abandonware“-Phänomen, bei dem veröffentlichte Programmcodes nicht mehr gepflegt werden und nach einiger Zeit unbrauchbar sind. Ein verwandtes, aber doch unterschiedliches Konzept ist das der Reproduktion. Hierbei wird das Experiment mit unterschiedlichen Mitteln oder leicht abgewandelten Methoden noch einmal durchgeführt, um zu prüfen, ob das ursprüngliche Ergebnis sich unabhängig vom Medium bestätigt. In der Informatik bedeutet dies etwa, dass ein Forscherteam eine andere Implementierung eines Algorithmus schreibt, aber versucht, das gleiche Ergebnis zu erzielen.

Das Ziel ist zu zeigen, dass die Resultate nicht nur Zufälle oder Einzelfälle sind, sondern eine valide wissenschaftliche Grundlage besitzen. Auch dieser Schritt ist jedoch nicht unumstritten. Aufgrund der schwierigen Nachvollziehbarkeit von Softwareartefakten und fehlender Dokumentation haben viele Reproduktionsversuche beispielsweise bei Betriebssystem- oder Netzwerkthemen große Hürden. Zudem fehlt oft der Anreiz, solche Arbeit zu leisten, wenn ein Forschungserfolg selbst publiziert werden muss, doch das Nachprüfen fremder Arbeiten selten Anerkennung innerhalb der akademischen Entwicklung bringt. Die akademische Struktur der Informatik fördert eher neuartige Beiträge als solide Validierung bestehender Arbeit, auch wenn Letzteres für die Wissenschaft unerlässlich ist.

Diese Problematik ist nicht nur ein theoretisches Problem, sondern zeigt direkte Auswirkungen auf die Vertrauenswürdigkeit von Forschungsergebnissen und deshalb auch auf deren Einfluss auf Industrie und Gesellschaft. Der Begriff der Replikation geht noch einen Schritt über die Reproduktion hinaus. Replikation beschreibt die unabhängige Durchführung eines Forschungsprojekts an einer anderen Institution oder mit anderen Ressourcen, um die Allgemeingültigkeit eines Befundes zu prüfen. In den Naturwissenschaften ist diese Praxis seit Jahrhunderten etabliert und gilt als Grundpfeiler der Wissenschaft. Doch in der Computerwissenschaft wird Replikation häufig unterschätzt.

Das Risiko, dass eine bahnbrechende neue Technik nur auf einer einmaligen Testreihe beruht, ist real. Das Beispiel von Fehlinterpretationen in der Wissenschaft, etwa die berüchtigte Geschichte um die vermeintliche Entdeckung der „kalten Fusion“, zeigt, wie gefährlich es ist, wenn Forschungsergebnisse ungeprüft als Wahrheit akzeptiert werden. In der Informatik könnten fehlerhafte Algorithmen gravierende Folgen haben, etwa wenn sie in sicherheitskritischen Anwendungen wie Fahrzeugsteuerungen oder medizinischen Geräten eingesetzt werden. Dennoch ist der Weg zur Replikation mit einigen zusätzlichen Hürden verbunden. Einerseits sind Expertise und Ressourcen notwendig, um bestehende Forschungsprojekte technisch nachzubauen und gründlich zu prüfen.

Andererseits verhindert der Publikationsdruck eine Kultur der Sorgfalt. Wissenschaftlicher Erfolg wird primär an der Anzahl erster Veröffentlichungen gemessen, nicht daran, ob vorherige Ergebnisse reproduziert oder widerlegt wurden. Dieses System animiert Forscher zur Quantität statt Qualität. Folglich entsteht ein „publish or perish“-Dilemma, das manche auf Abwege führt, zum Beispiel durch oberflächliche Studien, Datenmanipulation oder gar die Verwendung von Paper Mills, also Fabriken, die wissenschaftliche Publikationen produzieren, ohne dass die Resultate stimmen. Dabei sind die Kosten für das Replizieren von Informatikforschung heute niedriger denn je.

Rechenleistung ist erschwinglicher, Hardware vielfältig und Entwicklergemeinden sind global vernetzt. Außerdem sorgt Open-Source-Software dafür, dass Quellcode leichter zugänglich ist als früher. Trotz alledem erfordert es den Willen der Gemeinschaft und gezielte Anreize, damit mehr Replikationsarbeit geleistet wird. Eine mögliche Idee ist, Nachwuchswissenschaftler frühzeitig in die Replikation einzubeziehen, indem sie zu Beginn ihres Studiums versuchen, renommierte Ergebnisse kritisch zu überprüfen. So werden sowohl die Qualität der Forschung gestärkt als auch jungen Forschern Erfahrung vermittelt.

Die Informatik steht damit an einem entscheidenden Scheideweg. Will sie als echte Wissenschaft gelten, braucht es strengere Vorgaben für die Veröffentlichung von Forschungsergebnissen. Hierzu gehört die verpflichtende Bereitstellung von Quellcode, Daten und detaillierten Versuchsbeschreibungen. Nur so können Ergebnisse objektiv überprüft und validiert werden. Verpflichtende Gutachten sollten auch die technische Nachprüfbarkeit in den Peer-Review-Prozess einbeziehen.

Außerdem sollten Institutionen und Förderer den Wert von Replikationsstudien anerkennen und gezielt fördern. Ein kultureller Wandel, der Qualität vor Quantität stellt, ist unerlässlich, um der Informatik den Ruf zu sichern, den sie als Grundlage moderner Gesellschaften braucht. Verglichen mit anderen Naturwissenschaften wäre Informatik theoretisch in einer hervorragenden Position, da Hardware und Software grundsätzlich digital reproduzierbar sind. Anders als bei großen, komplexen Experimenten in der Physik müssen keine überdimensionalen Anlagen gebaut werden, um Ergebnisse zu validieren. Dennoch steht die Gemeinschaft vor der Herausforderung, geistige und materielle Ressourcen für Nachvollziehbarkeit bereitzustellen.

Die technische Komplexität von Rechenumgebungen verlangt zudem spezialisierte Dokumentationen und Prüfprotokolle, die noch zu selten Standard sind. Insgesamt zeigt sich, dass Wiederholung, Reproduktion und Replikation keine lästigen Zusatzaufgaben sind, sondern Kernbegriffe der wissenschaftlichen Glaubwürdigkeit. Alle Beteiligten – Forscher, Institutionen, Verlage und Industrie – sollten gemeinsam an einer Verbesserung arbeiten. Nur so lassen sich innovative Ideen nicht nur präsentieren, sondern tatsächlich in die Praxis umsetzen und auf ihre Tragfähigkeit prüfen. Abschließend muss betont werden, dass es bereits Fortschritte gibt.