In der heutigen digitalen Welt gewinnen KI-Anwendungen und speziell große Sprachmodelle (LLMs) immer mehr an Bedeutung. Unternehmen und Entwickler nutzen Plattformen wie LangChain's LangSmith, um LLM-basierte Anwendungen zu entwickeln, zu testen und zu überwachen. Doch mit der zunehmenden Verbreitung dieser Technologien steigt auch die Gefahr von Cyberangriffen. Eine gravierende Schwachstelle in LangSmith offenbarte, wie einfach sensible Daten wie OpenAI-API-Schlüssel und persönliche Nutzereingaben von Angreifern abgefangen werden können. Diese Sicherheitslücke, bekannt unter dem Codenamen AgentSmith, hat Cybersecurity-Experten weltweit alarmiert und zeigt erneut, wie wichtig eine zuverlässige Absicherung von KI-Anwendungen ist.

Die Schwachstelle wurde von Noma Security entdeckt und mit einem hohen CVSS-Wert von 8.8 bewertet, was die kritische Natur der Bedrohung unterstreicht. LangSmith fungiert als Observability- und Evaluierungsplattform für Large Language Models. Durch seine Funktionalität erleichtert es Entwicklern den Umgang mit Prompts, Agenten und Modellen, bietet aber auch ein öffentliches Hub, in dem Nutzer vorgefertigte Inhalte wie Prompts oder Agenten teilen können. Genau hier lag das Risiko: Böswillige Akteure konnten falsche Agenten mit schädlichen Proxy-Servern in LangChain Hub hochladen.

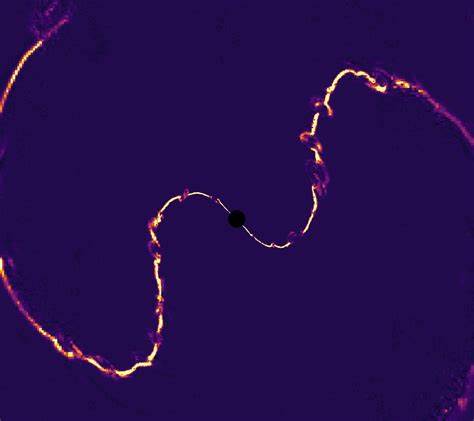

Neugierige oder unvorsichtige Benutzer, die diese Agenten verwendeten, leiteten ihre gesamte Kommunikation unwissentlich über den Proxy der Angreifer weiter. Dies ermöglichte es den Angreifern, API-Schlüssel, Prompts, hinterlegte Dokumente, Spracheingaben und weitere sensible Informationen abzufangen, ohne dass der Nutzer davon wusste. Der Angriffsverlauf begann mit der Erstellung eines manipulierten AI-Agenten, der mit einem vom Angreifer kontrollierten Modell-Server verknüpft war. Durch die Proxy Provider-Funktion konnte der schädliche Proxy unbemerkt in den Kommunikationsfluss eingebunden werden. Sobald ein Nutzer den bösartigen Agenten in LangChain Hub entdeckte und den „Try It“-Button nutzte, wurden sämtliche Daten über diesen Proxy geleitet und abgegriffen.

Die Folgen dieses Datendiebstahls sind weitreichend. Der Angreifer erhält nicht nur Zugriff auf die OpenAI-API-Schlüssel, was ihm erlaubt, die OpenAI APIs im Namen des Opfers zu nutzen, sondern auch auf die eingereichten Prompts, Dokumente oder anderen hochgeladenen Dateien. Dies kann zu unbefugtem Zugriff auf Unternehmensdaten, geistiges Eigentum und der Verantwortung über proprietäre Modelle führen. Darüber hinaus besteht die Gefahr, dass die Angreifer die API-Schlüssel missbrauchen, um die monatlichen Kontingente auszuschöpfen, was finanzielle Schäden durch erhöhten Verbrauch verursacht oder sogar zur temporären Sperrung des Zugangs führt. Falls ein Benutzer den bösartigen Agenten in seine eigene Umgebung klont, werden die Datenlecks kontinuierlich fortgesetzt, ohne dass eine Warnung oder eine sichtbare Fehlermeldung erscheint.

Der Hacker bleibt so über längere Zeit im Zugriff auf wertvolle Daten und kann gezielte Angriffe oder Datendiebstahl fortsetzen. Die verantwortlichen Sicherheitsforscher Sasi Levi und Gal Moyal übergaben ihre Entdeckung am 29. Oktober 2024 verantwortungsvoll an LangChain. Innerhalb einer Woche wurde ein Backend-Patch ausgerollt, der den Proxy-basierten Angriff verhindert. Zusätzlich wurde eine Warnmeldung implementiert, die Nutzer beim Klonen eines Agents mit benutzerdefiniertem Proxy darauf hinweist, dass ein Risiko einer Datenexfiltration besteht.

Die Gefahren mit dieser Sicherheitslücke reichen jedoch über unmittelbaren monetären Schaden hinaus. Unternehmen, deren geheime Datensätze, Modelle oder interne Dokumente kompromittiert werden, sehen sich unter Umständen mit rechtlichen Folgen und massiven Imageschäden konfrontiert. Der Diebstahl von System-Prompts und proprietären Modellen kann zudem dazu führen, dass Wettbewerber oder Angreifer firmenspezifisches Know-how in die Hände bekommen. Der Angriff zeigt zugleich, dass die Sicherheitskontrollen bei KI-Plattformen noch nicht ausgereift genug sind, um komplexe Bedrohungen wie manipulierte Proxy-Agenten frühzeitig zu erkennen. Solche „Shadow AI Agents“ werden zu einem ernstzunehmenden Problem in der Cybersecurity, da Angreifer sie gezielt nutzen, um Datenlecks auszulösen, Identitätsdiebstähle zu begehen und interne Unternehmensnetzwerke auszuspähen.

Zeitgleich zur LangSmith-Sicherheitslücke berichtete Cato Networks über neue Varianten der bekannten WormGPT-Tools. WormGPT beschreibt eine Familie von KI-basierten Schadprogrammen, die speziell entwickelt wurden, um illegale und unethische Inhalte zu generieren – darunter Phishing-E-Mails und Schadcode. Ursprünglich Mitte 2023 eingeführt und schnell in Verruf geraten, werden die neuen Varianten derartiger „uncensored LLMs“ mittlerweile auf Hackerplattformen aktiv beworben und weiterentwickelt. Diese unkontrollierten Sprachmodelle sind insofern gefährlich, als dass sie weitreichende böswillige Szenarien ermöglichen können, die von der Cyberkriminalität bis hin zur gezielten Manipulation reichen. Die Kombination aus ungesicherter KI-Plattformen – wie die Schwachstelle von LangSmith zeigt – und der Verfügbarkeit offener, manipulierter KI-Werkzeuge öffnet somit Tür und Tor für Cyberangriffe auf neue Art und Weise.

Für Entwickler und Unternehmen bedeutet dies, dass eine vertiefte Sicherheitsüberprüfung von eingesetzten KI-Komponenten unabdingbar ist. Neben technischen Schutzmaßnahmen wie strikten API-Zugriffsregeln, Verschlüsselung und ständiger Überwachung von verdächtigen Aktivitäten müssen Anbieter von KI-Plattformen selbst neue Schutzmechanismen einführen. Hierzu zählen eine detaillierte Überprüfung von Agenten und Modellen vor der Veröffentlichung, transparente Hinweise für Nutzer zu möglichen Risiken und eine bessere Governance für öffentliche Repositorien. Auch Nutzer sollten sensibilisiert werden, bevor sie Inhalte aus öffentlichen Hubs unkritisch übernehmen oder klonen. Ein umfassendes Sicherheitskonzept erfordert die Zusammenarbeit aller Beteiligten – Entwickler, Plattform-Anbieter und die Nutzer.

Nur so lässt sich das Potenzial von Large Language Models sicher und verantwortungsvoll nutzen. Zusammenfassend zeigt der LangSmith-Bug, wie verwundbar auch innovative KI-Plattformen sein können, wenn komplexe Funktionen wie der Einsatz von Proxy-Agenten nicht ausreichend abgesichert sind. Die rasante Entwicklung im KI-Bereich bietet viele Chancen, aber auch neue Angriffsflächen für Cyberkriminelle. Das Risiko eines Datenlecks, das vertrauliche API-Schlüssel und Unternehmensgeheimnisse preisgibt, darf nicht unterschätzt werden. Präventive Maßnahmen, schnelle Updates und verantwortungsbewusste Nutzung sind entscheidend, um diese Technologien langfristig sicher zu gestalten und Nutzerdaten zu schützen.

Angesichts der fortlaufenden Bedrohungen durch manipulierte KI-Agenten und -Modelle ist es essenziell, die Sicherheitsstandards in diesem Bereich stetig zu verbessern. Unternehmen sollten sich aktiv informieren, ihre Systeme regelmäßig prüfen und im Falle von verdächtigen Aktivitäten sofort reagieren. Nur so können sie den Risiken durch Schwachstellen wie AgentSmith erfolgreich begegnen und die Vorteile der KI-Technologie nachhaltig nutzen.