In unserer zunehmend digitalisierten Welt sind Smartphones aus dem Alltag von Kindern kaum noch wegzudenken. Schulen, Familien und Gesellschaften stehen vor der Herausforderung, den Umgang junger Menschen mit diesen Geräten zu regulieren. Oftmals wird die Debatte um Kinder und Smartphones auf die Frage reduziert, wie viel Bildschirmzeit altersgerecht ist. Doch gerade dieser Fokus verfehlt den Kern des Problems. Längst zeigt sich, dass die wirkliche Bedrohung nicht von der reinen Nutzung der Geräte ausgeht, sondern von den Algorithmen, die hinter den beliebten Apps und sozialen Netzwerken stehen.

Kinder sind heute nicht nur passive Konsumenten digitaler Inhalte. Sie bewegen sich in komplexen, algorithmisch gestalteten Welten, in denen die Angebote und Inhalte individuell auf ihre vermeintlichen Interessen zugeschnitten werden. Dieses personalisierte Erlebnis mag auf den ersten Blick harmlos oder sogar vorteilhaft erscheinen, da es etwa den Zugang zu Informationen erleichtert oder Lernerfahrungen bereichert. Allerdings birgt die algorithmische Aufbereitung auch Risiken, die weit tiefer gehen, als es reine Bildschirmzeiten vermuten lassen. Die Revolution der sozialen Medien hat mit der Verbreitung von Smartphones eine nie dagewesene Reichweite und Einflusskraft erlangt.

Plattformen wie TikTok, Instagram, Snapchat und andere sind nicht einfach Kommunikationskanäle. Sie sind durchdrungen von komplexen künstlichen Intelligenzen, die das Nutzungsverhalten analysieren, Inhalte in Echtzeit anpassen und so eine Art digitaler Sogwirkung erzeugen. Gerade für Kinder und Jugendliche, deren Gehirn und Sozialverhalten sich noch in der Entwicklung befinden, können diese algorithmisch verstärkten Erfahrungen schwerwiegende Folgen haben. Psychische Belastungen wie Angstzustände, Depressionen und ein vermindertes Selbstwertgefühl werden immer häufiger mit der Nutzung sozialer Medien bei jungen Menschen in Verbindung gebracht. Zahlreiche Studien, darunter die bekannten Forschungen von Jonathan Haidt, weisen darauf hin, dass Mädchen im Alter von zwölf bis achtzehn Jahren besonders gefährdet sind.

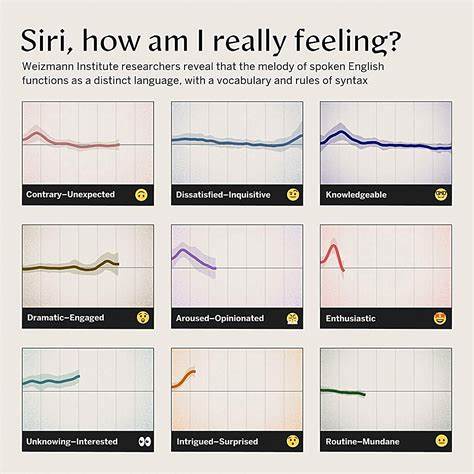

Die kontinuierliche Konfrontation mit idealisierten Darstellungen von Schönheit, Erfolg und gesellschaftlicher Anerkennung fördert Vergleichs- und Konkurrenzdenken, das in digitalen Umgebungen oft verstärkt wird. Was viele in der öffentlichen Diskussion nicht ausreichend beachten, ist die Tatsache, dass diese effizient gestalteten Algorithmen darauf ausgelegt sind, Engagement zu maximieren – und häufig auf Kosten der Nutzerinnen und Nutzer. Je länger Kinder in den Apps verweilen, desto mehr Werbeeinnahmen generieren die Betreiber. Die Algorithmen filtern Inhalte nicht unbedingt so, dass sie das Wohlbefinden der Nutzer fördern, sondern so, dass sie die Aufmerksamkeit festhalten. Problematische Inhalte, die Wut, Angst oder sensationelle Emotionen hervorrufen, sind oft jene, die am stärksten verbreitet werden.

Die Verantwortung liegt dabei nicht nur bei den Nutzern, sondern vor allem bei den Softwareunternehmen und deren Geschäftsmodellen. Es ist irreführend, wenn diese Firmen behaupten, sie könnten Probleme mit toxischen Inhalten oder Mobbing nicht technisch lösen. Tatsächlich verfügen viele dieser Konzerne über die fortschrittlichsten KI-Systeme der Welt, mit denen sich sowohl Inhalte filtern als auch Nutzeridentitäten besser schützen ließen. Der grundsätzliche Widerstand gegen schärfere Schutzmechanismen erfolgt vor allem aus finanziellen Interessen. Ein zentraler Lösungsansatz, der wiederholt vorgeschlagen wird, besteht in der Einführung eines verpflichtenden Identitätsnachweises für soziale Medien.

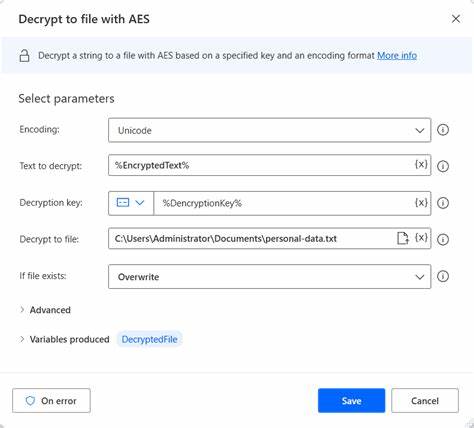

Analog zu den Verfahren im Bankensektor könnte so sichergestellt werden, dass Nutzerinnen und Nutzer altersgerecht eingestuft und toxisches Verhalten konsequent verfolgt werden könnte. Derartige Maßnahmen müssten so gestaltet werden, dass persönliche Daten geschützt bleiben und nicht für andere Zwecke missbraucht werden. Eine mögliche Umsetzung wäre die Nutzung unabhängiger Identitätsprüfer oder kryptografischer Techniken, die den Schutz der Privatsphäre gewährleisten. Durch eine echte Verknüpfung der digitalen Identität mit einer überprüfbaren Person könnten zahlreiche Probleme auf einmal adressiert werden. Zum einen ließe sich der Zugang für Kinder zu ungeeigneten Plattformen besser regeln.

Zum anderen könnten Täterinnen und Täter von Mobbing, Hassrede oder illegalem Verhalten identifiziert und zur Verantwortung gezogen werden. Zudem wäre der Missbrauch von Bots und automatisierten Accounts erheblich erschwert – ein Aspekt, der nicht nur Jugendschutz betrifft, sondern auch die Demokratie und öffentliche Diskurse. Gegen diese Lösungsansätze wird häufig das Argument vorgebracht, dass eine umfassende Altersverifikation die Nutzerzahlen und damit die Werbeeinnahmen schmälern würde. In Wahrheit zeigt sich hier ein Zielkonflikt zwischen wirtschaftlichen Interessen und dem Schutz des Kindeswohls. Die Gesellschaft muss sich die Frage stellen, welchen Stellenwert der Schutz der nächsten Generation in der digitalen Sphäre hat und ob wirtschaftliche Profite über deren psychische und soziale Gesundheit gestellt werden dürfen.

Darüber hinaus darf Regulierung nicht die Innovationsfähigkeit kleinerer Plattformen und Start-ups ersticken. Daher wäre es sinnvoll, Anforderungen wie die Altersverifikation und Nutzungsbeschränkungen an eine Größe der Plattform zu knüpfen. Nur große, wirkmächtige soziale Netzwerke sollten diese verpflichtende Regelung erfüllen müssen, um den Markt offen und vielfältig zu halten. Ein weiterer wichtiger Aspekt ist die Rechtssicherheit und Durchsetzbarkeit von Regelungen im digitalen Raum. Illegale Aktivitäten im Internet sollten genauso verfolgt und sanktioniert werden können wie im echten Leben.

Digitale Pseudonyme dürfen keine rechtliche Deckung bieten für strafbare Handlungen wie Mobbing oder Verbreitung unerlaubter Inhalte. Nur so kann eine Atmosphäre geschaffen werden, in der Kinder soziale Medien positiv und gesund nutzen können. Neben gesetzlichen Maßnahmen müssen Eltern, Schulen und Gesellschaften gleichermaßen sensibel und kompetent auf die Herausforderungen der digitalen Medien prepared sein. Die Förderung von Medienkompetenz und ein offener, ehrlicher Dialog mit Kindern und Jugendlichen sind essenziell, damit sie nicht nur technisch, sondern auch emotional und sozial stark in der digitalen Welt navigieren können. Abschließend lässt sich festhalten: Der Kampf um den Schutz von Kindern im digitalen Zeitalter darf nicht bei der reinen Regulierung der Bildschirmzeit stehen bleiben.

Die eigentliche Herausforderung besteht darin, die Macht hinter den Algorithmen zu verstehen und zu kontrollieren. Nur wenn der Fokus auf den zugrunde liegenden Softwaremechanismen und Geschäftsmodellen liegt, können wir nachhaltige, wirksame Lösungen finden. Die Technologie, um Kinder und Jugendliche vor den negativen Seiten sozialer Medien zu schützen, ist längst vorhanden. Was fehlt, ist die gesellschaftliche und politische Entschlossenheit, sie auch einzusetzen. Eine reflektierte Diskussion, verantwortungsvolle Regulierung und gemeinsames Handeln sind unerlässlich, um eine gesunde digitale Zukunft für die jüngste Generation zu schaffen.

Die entscheidende Botschaft lautet: Es geht nicht nur darum, wie lange Kinder Bildschirme nutzen, sondern welche Inhalte und Strukturen ihnen hinter diesen Bildschirmen begegnen. Algorithmen sind die neuen Hüter dieser Welten – und es ist an der Zeit, ihre Macht zum Wohle der Kinder zu gestalten.