Die Landwirtschaft steht vor der Herausforderung, Nahrungsmittelproduktion effizienter, nachhaltiger und präziser zu gestalten. Besonders die Reiskultivierung, die einen wesentlichen Beitrag zur Ernährung von mehr als der Hälfte der Weltbevölkerung leistet, ist dabei von großer Bedeutung. Reiskrankheiten wie Brown Spot, Rice Blast oder Bacterial Blight führen regelmäßig zu erheblichen Ertragseinbußen und stellen Landwirte weltweit vor große Probleme. Traditionelle Methoden der Krankheitserkennung basieren oft auf manueller Inspektion, die zeitaufwendig, teuer und anfällig für Fehler ist. Hier setzt die moderne Computer-Vision-Technologie ein, um präzise, schnelle und kostengünstige Lösungen anzubieten.

Der jüngste Fortschritt in diesem Bereich ist die Einführung eines optimierten, leichtgewichtigen Algorithmus namens YOLOv11-RD, eine speziell für die Reis-Krankheitserkennung angepasste Version des erfolgreichen YOLOv11-Modells. Die Bedeutung einer schnellen und genauen Erkennung von Reis-Krankheiten kann nicht hoch genug eingeschätzt werden. Früherkennung ermöglicht es Landwirten, gezielte Gegenmaßnahmen zu ergreifen, die Ausbreitung der Krankheiten zu stoppen und den Verlust wertvoller Ressourcen zu minimieren. Unsere natürliche Umwelt und ihre Herausforderungen – von wechselnden Wetterbedingungen bis hin zu dichten Anpflanzungen und wechselnden Wachstumsstadien – erschweren die Detektion mit herkömmlichen Verfahren. Deshalb ist eine automatisierte Methode erforderlich, die robust, effizient und für den Einsatz in ressourcenbegrenzten Feldgeräten geeignet ist.

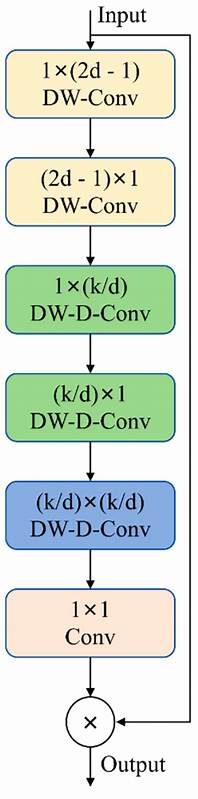

Der neu entwickelte Algorithmus YOLOv11-RD basiert auf der bewährten YOLOv11-Architektur, wurde jedoch durch mehrere innovative Module erheblich verbessert. Mit der Integration der erweiterten SPPFLKC-Aufmerksamkeitsmechanismen gelingt eine deutlich präzisere Extraktion von Mehrskalenmerkmalen. Diese Verbesserung ermöglicht, dass auch kleine, schwer erkennbare Krankheitsstellen zuverlässig detektiert werden können. Zudem wurde das Modell durch den Einsatz der C3k2-CFCGLU-Struktur optimiert, die die Fähigkeit verbessert, lokale Details zu erfassen und gleichzeitig die Berechnungen auf ein Minimum reduziert. Diese Kombination schafft ein ideales Gleichgewicht zwischen Modellgröße, Rechenaufwand und Genauigkeit.

Ein weiterer Meilenstein des Modells ist die Verwendung des C3k2-CSCBAM-Moduls im sogenannten „Neck“-Bereich des Netzwerks. Dieser Bereich ist für die Verknüpfung und das Zusammenführen der extrahierten Merkmale verantwortlich. Durch eine speziell entwickelte Kanals- und Raum-Aufmerksamkeit werden irrelevante Hintergrundinformationen hochwirksam unterdrückt, wodurch das Netzwerk besonders gut darin wird, relevante Zielmerkmale selbst in komplexen Umgebungen zu identifizieren. Dies ist entscheidend für die zuverlässige Erkennung von Krankheiten in dichten Pflanzenbeständen, bei Schattenwurf oder wechselnden Lichtverhältnissen. Besonders beeindruckend ist die Einführung eines spezialisierten Erkennungsmoduls mit einer Eingangsauflösung von 320 × 320 Pixel, das speziell auf die Detektion kleiner Objekte ausgelegt ist.

Gerade kleinste Disease-Patches, die normalerweise leicht übersehen werden, können so mit hoher Genauigkeit identifiziert werden. Dieses sogenannte LSDECD-Detektionsteil nutzt detailverstärkende Konvolutionen und profitiert von den zuvor genannten Aufmerksamkeitsmechanismen, was die Erkennungsqualität signifikant erhöht, ohne dass die Modellkomplexität unverhältnismäßig anwächst. Die Leistung des verbesserten YOLOv11-RD-Algorithmus wurde mithilfe eines umfangreichen Datensatzes getestet. Dieser Datensatz wurde sorgfältig aus über 5000 Originalaufnahmen zusammengestellt und umfasste verschiedene Reis-Krankheiten unter vielfältigen Umweltbedingungen. Höchste Qualität bei Auflösung und Annotation sowie Datenaugmentationstechniken wie zufälliges Spiegeln, Kontrastanpassung und Gaußsche Unschärfe wurden angewandt, um das Modell besonders robust gegenüber variierenden Szenarien zu machen.

Die Aufteilung in Trainings-, Validierungs- und Testsets gewährleistete eine objektive und detaillierte Evaluierung der Modellleistung. In den experimentellen Ergebnissen zeigte sich, dass YOLOv11-RD gegenüber dem Basismodell YOLOv11n eine Steigerung der durchschnittlichen Präzision (mAP) insbesondere bei kleinen Objekten um bis zu 11,5 % erreicht. Gleichzeitig sank die Anzahl der Modellparameter deutlich, wodurch das Modell auch für die Verwendung in eingebetteten Systemen mit beschränkten Ressourcen gut geeignet ist. Die Verringerung des Rechenaufwands um etwa 1,1 GFLOP ist hierbei von besonderer Bedeutung für den Einsatz auf mobilen Geräten, wie zum Beispiel Drohnen oder tragbaren Erkennungsgeräten. Die praktischen Tests auf Embedded Hardware wie dem NVIDIA Jetson Nano oder dem Raspberry Pi 4B bestätigen die ausgezeichnete Performance unter realen Bedingungen.

Die verbesserte Modellversion erzielte deutlich höhere Bildverarbeitungsraten (Frames per Second) bei gleichzeitig niedrigerem Stromverbrauch und geringerem Speicherbedarf. Auf Drohnenplattformen konnten Reisfelder in Echtzeit überwacht und Krankheitsherde zuverlässig detektiert werden, was enorme Fortschritte im Bereich der Präzisionslandwirtschaft bedeutet. Das neue Modell erfüllt damit eine zentrale Forderung der Landwirtschaft: die Kombination von hoher Genauigkeit, Echtzeitfähigkeit und geringer Hardwareanforderung. Dies schafft neue Chancen für kleine und mittlere Betriebe, die bislang von teuren oder schwer zu bedienenden Diagnoseverfahren ausgeschlossen waren. Die Automatisierung der Krankheitsüberwachung hilft, frühzeitige Interventionen durchzuführen, den Einsatz von Pestiziden zu vermindern und damit Umweltschäden zu reduzieren.

Die zukunftsweisende Integration intelligenter Algorithmen wie YOLOv11-RD in landwirtschaftliche Systeme markiert einen wesentlichen Schritt in Richtung nachhaltigeres Food-Supply-Chain-Management. Durch die frühzeitige und präzise Erkennung von Krankheitssignalen lassen sich Produktionsausfälle vermeiden und die Ernährungssicherheit gestärkt. Die Möglichkeit, den Algorithmus auf leistungsschwachen Geräten zu betreiben, fördert den breiten Einsatz auch in entlegenen Regionen. Darüber hinaus zeigt die Forschungsarbeit das Potenzial, weitere Sensordaten wie spektrale, meteorologische oder Bodenparameter in die Detektion zu integrieren, um eine noch ganzheitlichere und zuverlässigere Beurteilung des Pflanzenzustands zu ermöglichen. Multimodale Ansätze eröffnen neue Wege, die Genauigkeit und Robustheit der Erkennung weiter zu steigern und damit auch die Anpassungsfähigkeit an neue Krankheiten oder veränderte Umweltbedingungen zu gewährleisten.

Die Kombination aus neuartigen Aufmerksamkeitstechniken, effizienten Tiefenlernarchitekturen und praxisnaher Anwendung stellt eine wegweisende Entwicklung im Bereich der agrartechnischen Bildverarbeitung dar. Der Erfolg des verbesserten YOLOv11-RD demonstriert, wie zielgerichtete Optimierungen den Alltag von Landwirten nachhaltig erleichtern und den Weg zu einer intelligenten, ressourcenschonenden Landwirtschaft ebnen können. Zusammenfassend ist festzuhalten, dass das verbesserte YOLOv11-Algorithmus eine bedeutende Rolle bei der automatisierten Detektion von Reis-Krankheiten übernimmt. Seine Fähigkeit zur effizienten Erkennung kleiner und komplexer Krankheitssymptome, kombiniert mit der ressourcenarmen, schnellen Verarbeitung, macht es zu einem unverzichtbaren Werkzeug moderner intelligenter Landwirtschaftssysteme. Durch die weitere Forschung und Entwicklung in diese Richtung kann die Technologie noch besser an die vielfältigen Anforderungen realer landwirtschaftlicher Umgebungen angepasst werden.

Dies verspricht nicht nur eine höhere Erntequalität, sondern trägt auch dazu bei, die globale Ernährungssicherheit nachhaltig zu sichern und ökologisch verantwortungsbewusstes Wirtschaften zu fördern.