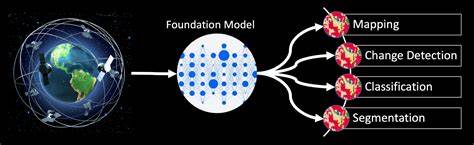

Die Geospatial Foundation Models (GFM) galten lange als vielversprechender Weg, um die Analyse von Erdbeobachtungsdaten, Landbedeckungsklassifikation und zeitlichen Veränderungen in großem Maßstab zu revolutionieren. Die jüngsten Entwicklungen und Erfolge im Bereich der Sprachmodelle, die auf kontinuierliche Skalierung von Modellgröße und Datenmengen setzen, erzeugten eine hohe Erwartungshaltung auch für GFMs. Doch die Realität zeigt sich ernüchternd: Trotz massiver Rechenressourcen und umfangreicher Datensätze bleiben die Leistungsgewinne marginal und oft hinter einfacheren, traditionellen Modellen wie U-Nets zurück. Die Rezession der Performance trotz exponentiellen Aufwands wirft grundlegende Fragen zur Skalierbarkeit und zu den zugrundeliegenden Modellarchitekturen und Trainingsstrategien auf. Die größten Hoffnungen auf Durchbruch setzte man in Modelle wie IBMs TerraMind, das mit einem enormen Trainingsaufwand von etwa 10^21 FLOPs und der Verarbeitung hunderter Milliarden von Bildpatches die Benchmark PANGAEA für geospatiale Anwendungen anführen sollte.

In der Praxis übertrifft TerraMind dennoch einen gut trainierten, klassischen U-Net nur marginal um etwa zwei Punkt mIoU (mean Intersection over Union), verliert auf mehreren Teilaufgaben sogar. Diese Beobachtung zeigt, dass einfaches Hochskalieren von Trainingsdaten und Modellgrößen nicht automatisch zu besseren Ergebnissen führt, wie man es aus dem NLP- oder Computer-Vision-Bereich erwarten könnte. Dieses Phänomen lässt sich unter anderem mit den sogenannten Scaling Laws aus der Sprachmodellierung kontrastieren. Während bei großen Sprachtransformern ein klares Leistungswachstum in Abhängigkeit von Modellkomplexität und Trainingsdatenmenge nachweisbar ist, folgen GFMs keinem so sauberen Muster. Modelle aus dem geospatialen Bereich scheinen häufig entweder untertrainiert oder übertrainiert, jedoch ohne eine eindeutige Optimalkurve nach dem Prinzip von 20 Tokens pro Modellparameter, wie es bei Sprachmodellen gilt.

Die hohe intrinsische Entropie in multimodalen Fernerkundungsdaten, die kontinuierliche (statt diskrete) Werte und multimodale Bänder enthalten, sowie die räumlich-temporale Redundanz erschweren diese Skalierbarkeit zudem erheblich. Ein weiterer Knackpunkt liegt in den Trainingszielen. Bisherige GFMs basieren oft auf pixelbasierten Rekonstruktions- oder Bildpatch-Kontrastiv-Verlustfunktionen. Diese ermutigen das Modell zwar dazu, feinste radiometrische Unterschiede zu lernen, vermitteln aber kaum Informationen über relevante Begrenzungen oder Klassen, die für Anwendungen in der Landbedeckung oder Umweltüberwachung entscheidend sind. Das Ergebnis ist eine Lernkurve mit abnehmendem Ertrag, bei der zusätzlicher Rechenaufwand und Datenwachstum nur unzureichende Verbesserungen bringen.

Die Redundanz durch tägliche Aufnahmen ähnlicher Gebiete verstärkt diese Herausforderung, da viele neue Daten weniger neue Information enthalten und so eher Kosten als Nutzen erzeugen. Aus Sicht von Anwendern und Branchenexpert:innen ergibt sich hier eine wesentliche Problematik bei der Adoption dieser Modelle. Die feinen Leistungsunterschiede von wenigen Prozentpunkten gegenüber bewährten und gut optimierten Modellen wie U-Nets rechtfertigen meist nicht den zusätzlichen Aufwand für Integration, Anpassung und Anforderungen an Hardware, wie größere Grafikkarten oder längere Trainingszeiten. Das bestehende Ökosystem von Datenpipelines, Bildkachelung und Ergebnissen zusammensetzen muss häufig mit erheblichen Anpassungen erweitert werden, was zusätzliche Kosten und Komplexität bedeutet. Praktiker:innen wünschen sich oft robustere, gezieltere Lösungen für spezifische Aufgaben anstelle von universellen Foundation Models mit marginalen Verbesserungen.

Um diese Herausforderungen zu bewältigen, müssen zukünftige Entwicklungen in der Geospatial KI neue Wege in der Modellierung und Datenaufbereitung einschlagen. Ein vielversprechender Ansatz ist die Entwicklung von aufgabenspezifischeren und informationsreicheren Vortrainingszielen. Beispiele sind maskiertes Segmentieren, bei dem das Modell lernt, wichtige räumliche und zeitliche Strukturen besser zu erkennen, oder das Vorhersagen von Sensordaten über multimodale Datensätze hinweg, das eine tiefere Integration verschiedener Messgrößen ermöglicht. Ebenso entscheidend ist es, hochredundante und inhaltsgleiche Bildpatches frühzeitig aus dem Trainingsdatensatz zu entfernen, um die Wirksamkeit der Rechenressourcen zu erhöhen und einen Informationszuwachs mit dem zusätzlichen Rechenaufwand besser zu korrelieren. Darüber hinaus sind Investitionen in die Erforschung geeigneter Metriken und Evaluationen notwendig, um die Leistung und Skalierungseigenschaften von GFMs realistisch abzubilden.

Es fehlt bislang an systematischen Loss-vs-Compute-Sweeps, ähnlich denen, die das Verständnis von Sprachmodellen unterstützt haben. Nur so können Forscher:innen belastbare Aussagen über optimale Trainingsgrößen, Datenmengen und Architekturdesigns treffen, die über einfache Heuristiken hinausgehen. Auch die Datenbeschaffung und -aufbereitung müssen im Fokus stehen. Vielversprechender sind Ansätze, die Zeitreihen besser auswerten, da sie potenziell eine höhere Informationsdichte als räumliche Einzelszenen liefern. Eine verbesserte Auswahl repräsentativer Zeitfenster, weniger Überlappung und gezielte Sensorfusion könnten ebenso zu nennenswerten Leistungssteigerungen führen.

In der Praxis werden GFMs deshalb nur dann einen nachhaltigen Einfluss gewinnen, wenn nicht nur die algorithmische Leistung verbessert wird, sondern auch Anwenderfreundlichkeit und der Wertbeitrag im Produktivbetrieb steigen. Das bedeutet hardwareeffiziente Modelle, einfache Integrationsmöglichkeiten in bestehende Geo-Workflow-Systeme und Tools zur effektiven Diagnose, Visualisierung und Nachbearbeitung sind essentiell. Zudem sind reale Anwendungsfälle mit nachvollziehbaren Kosten-Nutzen-Analysen gefragt, damit Investitionen in GFMs über den Proof-of-Concept hinausgehen. Zusammenfassend lässt sich sagen, dass die Entwicklung geospatialer Foundation Models an einer grundlegenden Zielfrage scheitert: Es geht nicht allein darum, immer größere Modelle mit unendlichen Datenmengen zu trainieren. Vielmehr erfordert der Fortschritt im Bereich der Erdbeobachtung eine stärkere Ausrichtung der Trainingsziele an den konkreten Aufgaben, die Optimierung der Informationsdichte der verwendeten Daten und eine pragmatische Betrachtung der Nutzbarkeit im operativen Umfeld.

Es bleibt spannend, wie die Forschung diese Probleme in den nächsten Jahren adressiert, aber der aktuelle Status zeigt klar, dass wir uns von reinem Skalieren als Allheilmittel verabschieden müssen. Der Weg zu wirklich leistungsfähigen und weit verbreiteten geospatialen Foundation Models führt über interdisziplinäre Zusammenarbeit, bei der Expert:innen aus Fernerkundung, KI, Hardwareentwicklung und Anwenderbranchen gemeinsam zielgerichtete Lösungen schaffen. Nur so können die ambitionierten Erwartungen Realität werden und die vielversprechenden Potenziale von Big Data und Machine Learning für Erdbeobachtung voll ausgeschöpft werden.