Die rasante Entwicklung künstlicher Intelligenz (KI) hat in den letzten Jahren viele beeindruckende Fortschritte hervorgebracht. Sprachmodelle wie ChatGPT, bildgenerierende Systeme und andere maschinelle Lernverfahren beeinflussen bereits zahlreiche Bereiche unseres Alltags und der Industrie. Doch gerade in dieser dynamischen Phase rückt ein bislang wenig beachtetes, aber tiefgreifendes Problem zunehmend ins Blickfeld der Forschung: der sogenannte "Model Collapse". Wissenschaftler warnen davor, dass KI-Modelle Gefahr laufen, sich quasi selbst zu „fressen“ und dabei ihre Leistungsfähigkeit einzubüßen – ein Prozess, der vergleichbar mit einer Schlange ist, die sich in ihren eigenen Schwanz beißt und somit ihre Lebensgrundlage zerstört. Model Collapse beschreibt den Zustand, in dem KI-Systeme, vor allem Machine-Learning-Modelle, ihre Trainingsdaten zunehmend aus Inhalten zusammensetzen, die selbst von anderen KI-Systemen generiert wurden.

Auf den ersten Blick erscheint es logisch, neue Modelle mit neuen, automatisch erstellten Daten zu versorgen, um den stetig wachsenden Bedarf an Trainingsmaterial zu decken. Doch wenn Modelle hauptsächlich Daten anderer Modelle benutzen, entfernen sie sich langsam von der ursprünglichen, echten Datenverteilung. Vereinfacht gesagt: Die Modelle „verlernen“ echte Wissensgrundlagen und adaptieren zunehmend künstliche Verzerrungen und Fehler, die sich über die Generationen verstärken. Die Ursache für das Phänomen liegt tief in der Natur heutiger KI-Systeme begründet. KI-Modelle sind im Kern Mustererkenner.

Sie analysieren riesige Datenmengen und versuchen bei Eingaben die wahrscheinlichste Antwort basierend auf bereits gelernten Mustern zu liefern. Je häufiger ein Muster in den Daten auftritt, desto wahrscheinlicher ist es, dass das Modell das entsprechende Ergebnis bevorzugt liefert. Das herrscht Gleichgewicht, solange das zugrunde liegende Datenset vielfältig und echt bleibt. Doch wenn eine Datenquelle überflutet wird von KI-generierten Inhalten, etwa durch automatisch erstellte Blogbeiträge, Bilder, Texte oder Musik, verschwimmen die Grenzen. Die echten Daten werden durch die maschinellen Nachahmungen ständig überdeckt.

Ein anschauliches Beispiel liefert die Forschung von Ilia Shumailov und seinem Team an der Universität Oxford. Sie zeigen, wie Bildmodelle, die auf Hunderte von Bildern trainiert werden, zunehmend populäre Varianten bevorzugen. Bei der Generierung von Hundebildern entstehen immer häufiger gängige Rassen wie Golden Retriever oder Labrador, die in großen Datenmengen dominieren. Seltene Rassen oder speziellere Variationen werden verschwinden. Wenn dann neue Modelle auf diese Daten zugreifen, hält sich das Klischee von „90% aller Hunde sind Golden Retriever“, wobei tatsächlich die Vielfalt und Komplexität der realen Welt verloren geht.

Die Auswirkungen sind nicht nur theoretischer Natur. Wenn künftige KI-Modelle ihr Wissen hauptsächlich aus Inhalten ziehen, die von anderen KI-Modellen stammen, wird sich die Qualität des Outputs kontinuierlich verschlechtern. Modelle könnten zunehmend stereotype, oberflächliche und weniger nützliche Ergebnisse liefern. Die sogenannte „Degeneration“ der intellektuellen Kapazität der Systeme bedeutet letztlich eine Einschränkung ihrer Einsatzmöglichkeiten, da verlässliche und tiefgreifende Antworten immer seltener werden. Darüber hinaus stellt der Model Collapse eine fundamentale Herausforderung für die Weiterentwicklung zu echten Superintelligenzen dar.

Die Annahme, dass Maschinen durch immer größere, auch selbst generierte Datensätze stetig besser werden, ist nur dann gültig, wenn die Datenqualität erhalten bleibt. Wenn jedoch das Fundament aus echten Beobachtungen, menschlichen Interaktionen und authentischem Kontext schwindet, gerät das gesamte Trainingskonzept ins Wanken. Experten warnen deshalb, dass das grundsätzliche Paradigma der großen Sprach- und Bildmodelle überdacht werden muss, wenn die KI langfristig sinnvoll und robust bleiben soll. Eine weitere Dimension des Problems ist die öffentliche Verfügbarkeit von Trainingsdaten. Viele KI-Firmen sammeln enorme Mengen an Webinhalten, die zunehmend von KI selbst erstellt wurden.

Dieser Kreislauf bedeutet, dass neue Modelle oft nicht mehr frühere Versionen mit echten Daten, sondern „Data Wrapping“ mit synthetischen Inhalten nutzen. Der Verlust an Diversität in den Trainingsquellen beschleunigt die Entwicklung eines in sich geschlossenen, aber abgeschotteten Systems. Doch wie lässt sich dieser Tendenz entgegenwirken? Forscher empfehlen mehrere Ansätze, um Model Collapse zumindest zu verlangsamen oder zu begrenzen. Ein Schlüssel ist die klare Kennzeichnung (Watermarking) von KI-generierten Inhalten, sodass Folgegenerationen diese als künstlich erkannt und mit entsprechender Vorsicht behandelt werden können. Theoretisch würde dies helfen, die Modelle darauf zu trainieren, echte Daten von synthetischen zu unterscheiden.

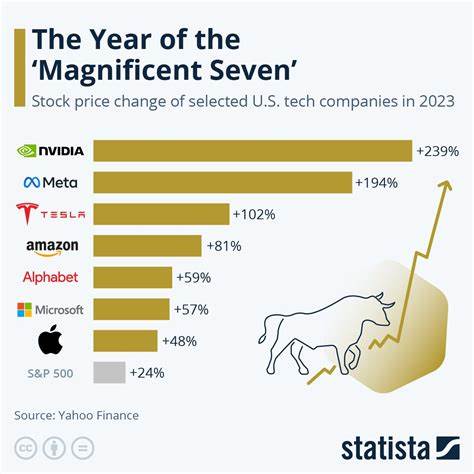

In der Praxis ist dieses Verfahren bei Bilddaten bislang noch schwierig umzusetzen, bei Texten sind erste Ansätze vorhanden. Darüber hinaus bleibt der Erhalt der Vielfalt und Originalität in den Trainingsdaten essenziell. Unternehmen und Forschungseinrichtungen müssen den Zugang zu authentischen, menschlich erzeugten Quellen priorisieren und möglicherweise exklusive Datenquellen bewahren. Der sogenannte „first mover advantage“ könnte dabei eine zweischneidige Rolle spielen: Große Konzerne halten wertvolle Daten zurück, während die Gefahr besteht, dass kleinere oder neue Marktteilnehmer sich auf bereits generierte, künstliche Daten stützen müssen. Zudem spielt die Entwicklung neuer Evaluationsmethoden eine zentrale Rolle.

Qualitative und quantitative Metriken für die Herkunft und Vielfalt der Trainingsdaten könnten ein Standardinstrument werden, um die Gesundheit eines Modells zu bewerten. Dies würde die Transparenz erhöhen und somit bessere Kontrollmechanismen schaffen. Model Collapse ist keine ferne Hypothese, sondern ein wachsendes praktisches Problem mit tiefgreifenden Konsequenzen für die KI-Industrie und -Wissenschaft. Die ethische und ökonomische Bedeutung liegt darin, dass eine Verschlechterung der Modellqualität auch die Nutzererfahrung massiv beeinträchtigen kann. In Bereichen wie der medizinischen Diagnostik, autonomem Fahren oder rechtlichen Beratung wären Fehlinterpretationen fatal.

Zusammenfassend lässt sich sagen, dass der Kreislauf von KI-generierten Inhalten als Trainingsmaterial eine ernsthafte Gefahr für die Zukunft der KI-Modelle darstellt. Wissenschaftler fordern mehr Bewusstsein für das Problem, gezielte technische Lösungen zur Kennzeichnung von künstlichen Daten und eine dauerhafte Sicherstellung von vielseitigen, menschenzentrierten Trainingsquellen. Nur so kann die Entwicklung von KI-Systemen nachhaltig und robust gehalten werden, um die zahlreichen Versprechen der künstlichen Intelligenz nicht durch einen Selbstzerstörungsprozess zunichtezumachen. Die Herausforderung besteht darin, den Fortschritt mit Bedacht zu gestalten und ein Übermaß an KI-Content als Trainingsmaterial kritisch zu hinterfragen, um die Balance zwischen Effektivität und Qualität zu wahren.