Die Primzahlen faszinieren Mathematiker seit Jahrtausenden, und trotz intensiver Forschung bleiben viele ihrer Geheimnisse ungelöst. Eines der zentralen Themen in der Zahlentheorie ist der Satz von der Primzahldichte, der eine asymptotische Beschreibung der Verteilung der Primzahlen liefert. Während der klassische Satz von der Primzahldichte sich auf große Intervalle bezieht, rückt die Untersuchung kurzer Intervalle zunehmend in den Fokus – insbesondere die Frage, wie oft und in welchen Bereichen das Verhalten der Primzahlen vom erwarteten Muster abweicht. Diese sogenannten außergewöhnlichen Intervalle bieten spannende neue Erkenntnisse und stellen hohe Anforderungen an die angewandten Methoden der analytischen Zahlentheorie. In den letzten Jahren haben bedeutende Fortschritte auf dem Gebiet der Nullstellen-Dichtesätze die Tür zu einer besseren Kontrolle über diese außergewöhnlichen Intervalle geöffnet.

Nullstellen-Dichtesätze befassen sich mit der Verteilung der Nullstellen der Riemannschen Zetafunktion, einem analytischen Objekt, dessen Hypothesen und Eigenschaften tief mit der Verteilung der Primzahlen verknüpft sind. Je bessere Schranken für die Anzahl der Nullstellen in bestimmten Regionen der komplexen Ebene gefunden werden, desto genauer lässt sich das Verhalten der Primzahlen erfassen, auch in äußerst kurzen Intervallen. Die Riemannsche Zetafunktion ist von zentraler Bedeutung für den Satz von der Primzahldichte. Bekanntlich hängt die Verteilung der Nullstellen eng mit der Verteilung der Primzahlen zusammen. So hat die berühmte Riemannsche Vermutung als einer der wichtigsten offenen mathematischen Vermutungen das Ziel, eine vollständige Charakterisierung aller nicht-trivialen Nullstellen zu liefern.

Bisher ist diese Vermutung weder bewiesen noch widerlegt, doch Zwischenresultate, wie die sogenannten Nullstellen-Dichtesätze, bieten praktische Werkzeuge zur Abschätzung von Fehlertermen bei der Primzahldichte. Die klassische Version des Satzes von der Primzahldichte beschreibt das Verhalten der Funktion π(x), die die Anzahl der Primzahlen bis x angibt. Für sehr große x konvergiert das Verhältnis π(x) zum Logarithmus von x, was aussagt, dass Primzahlen im Durchschnitt seltener werden, jedoch äußerst regelmäßig verteilt sind, wenn man lange Intervalle betrachtet. Anders sieht es in kurzen Intervallen aus: Dort treten sogenannte Ausnahmen oder außergewöhnliche Intervalle auf, in denen die Verteilung der Primzahlen nicht dem „normalen“ Muster folgt. Die Herausforderung besteht darin, die Anzahl und Dimension dieser Ausnahmen zu quantifizieren und möglichst präzise abzuschätzen.

Die Erforschung der außergewöhnlichen Intervalle setzte bedeutende Entwicklungen voraus – so zeigten Untersuchungen von Forschern wie Selberg, Heath-Brown und jüngst Bazzanella und Perelli, dass die Anzahl der Intervalle, in denen die Primzahldichte regelmäßig „stört“, durch verschiedene analytische Techniken eingeschränkt werden kann. Dennoch war es lange Zeit schwierig, diese Abschätzungen flexibel auf neue Erkenntnisse bei Nullstellen-Dichtesätzen anzupassen. Ein entscheidender Durchbruch gelang mit der Zusammenarbeit von Ayla Gafni und Terence Tao, die in ihrem Paper explizite Verbindungen zwischen Nullstellen-Dichteexponenten und der Dimension der Ausnahmeintervalle formulierten. Durch die Abstraktion vorhandener Argumente konnten sie eine Formel entwickeln, die es ermöglicht, die Beziehung zwischen der Anzahl der Nullstellen und der Menge der Ausnahmen unabhängig von spezifischen Nullstellen-Dichtesätzen zu berechnen. Dies stellt einen bedeutenden Fortschritt dar, da so neue Nullstellen-Dichteschranken – etwa die von Guth und Maynard erreichten – unmittelbar in verbesserte Schranken für die exceptional intervals überführt werden können.

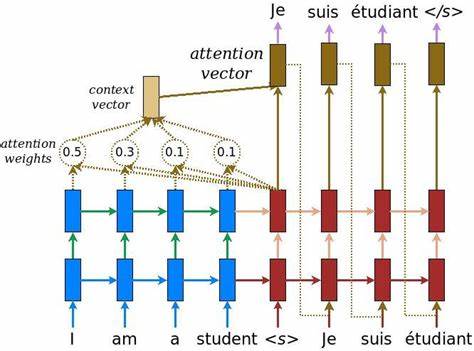

Die Methode von Gafni und Tao basiert auf der Ausnutzung des sogenannten expliziten Primformel-Zusammenhangs, der die Verteilung der Primzahlen mit den Nullstellen der Zetafunktion in Beziehung setzt. Dabei werden Momente von Prime-Gaps, also Abstände zwischen aufeinanderfolgenden Primzahlen, durch Verfahren der analytischen Zahlentheorie untersucht, um die Menge der außergewöhnlichen Intervalle zu beschränken. Besonders innovativ ist der Einsatz höherer Momente – etwa der vierten Momente – und die Anwendung additive Energiebegriffe auf die Nullstellen selbst, was die Schranken weiter verbessert und verfeinert. Die additive Energie bezieht sich auf die Häufung von Linearkombinationen der Nullstellen und ist ein Konzept, das seit Heath-Browns Arbeiten in der Zahlentheorie eine wichtige Rolle spielt und jüngst von Guth und Maynard in der Optimierung von Nullstellen-Dichteabschätzungen verwendet wurde. Die Integration dieser Konzepte erlaubt eine präzisere Kontrolle und macht die Analyse weniger abhängig von einzelnen Extrempunkten, was insgesamt zu robusteren Ergebnissen führt.

Die Ergebnisse zeigen, dass unter der Annahme stärkerer Hypothesen, wie der allgemeinen Dichtehypothese oder sogar der Lindelöf- oder Riemannschen Vermutung, die Dimension der Ausnahmeintervalle drastisch reduziert werden kann. Dies bedeutet, dass die Verteilung der Primzahlen in kurzen Intervallen nahezu regulär ist, abgesehen von sehr wenigen Ausnahmen – was das Bild von Primzahlen als „fast zufällig“ und doch tief strukturiert weiter untermauert. Unabhängig von solchen Hypothesen wurde durch die jüngsten Fortschritte erreicht, dass sich konkrete quantitative Aussagen zur Verteilung von Primzahlen in kurzen Intervallen machen lassen, die vor einigen Jahren noch utopisch wirkten. Insbesondere konnte die exakte Beziehung zwischen dem Nullstellen-Dichteexponenten und der Messung der Ausnahmeintervalldimension erstmals klar und berechenbar formuliert und implementiert werden. Dies erleichtert es anderen Forschern, diese Ergebnisse auf verschiedene Fragestellungen in der analytischen Zahlentheorie anzuwenden, und ergänzt zudem die entstehende Datenbank zur Analyse von Exponenten analytischer Zahlentheorie (ANTEDB), die als Ressource für die Forschung geeignet ist.

Ein weiteres spannendes Anwendungsfeld liegt in der Untersuchung von Primzahllücken und Mustern, die über das bloße Vorkommen einzelner Primzahlen hinausgehen. Das Verständnis der Ausnahmeintervalle kann Hinweise liefern, wie sich Primzahlen in kleinen Fenstern zusammenfinden, was wiederum mit Problemen wie der Zwillingsprimzahl-Vermutung, Verteilungen von Primzahlzwillingen und anderen offenen Fragen zusammenhängt. Interessanterweise reflektieren diese Erkenntnisse auch tiefere Zusammenhänge zwischen den scheinbar chaotischen Verteilungen der Primzahlen und strukturierten analytischen Eigenschaften der Riemannschen Zetafunktion. Die Beziehung von Nullstellenverteilungen, additive Energiekonzepte und groß angelegte Verteilungsmuster eröffnet somit ein vielschichtiges Bild, das die Grenzen zwischen Zufall und Ordnung in der Zahlentheorie austariert. Die Arbeit von Gafni und Tao zeigt exemplarisch, wie moderne Zahlentheorie durch die Verknüpfung klassischer Methoden mit neuen analytischen und kombinatorischen Techniken weiter vorangetrieben wird.