In der heutigen digitalen Welt, in der schnelle Datenzugriffe und hohe Verfügbarkeit eine zentrale Rolle spielen, sind Redis und SQL-Datenbanken zu unverzichtbaren Komponenten moderner IT-Architekturen geworden. Redis, bekannt für seine Geschwindigkeit als In-Memory-Cache, und traditionelle relationale SQL-Datenbanken, die stabile ACID-Eigenschaften gewährleisten, bilden zusammen ein dynamisches Duo. Doch die Kombination dieser Systeme wirft eine komplexe Herausforderung auf: Wie lässt sich die Konsistenz der Daten zwischen dem flüchtigen Cache von Redis und der dauerhaften SQL-Datenbank sicherstellen? Dieser Balanceakt zwischen Performance und Datenintegrität ist für viele Unternehmen von großer Bedeutung und entscheidet über die Zuverlässigkeit ihrer Anwendungen. Der Grundgedanke bei der Verwendung eines Caches wie Redis liegt darin, sogenannte „heiße Daten“ im schnellen Hauptspeicher zwischenzuspeichern, um kostspielige Lesezugriffe auf die langsameren SQL-Datenbanken zu reduzieren. Diese Herangehensweise folgt häufig der sogenannten Pareto-Regel, wonach etwa 80 % der Lesezugriffe auf nur 20 % der Daten entfallen.

Jedoch bedeutet die Speicherung redundanter Daten in zwei unterschiedlichen Systemen auch, dass die Daten nicht mehr nur an einem einzigen Ort existieren – der klassische Single Source of Truth ist somit aufgelöst. Damit entsteht das Problem der Konsistenz zwischen Cache und Datenbank, welches nicht nur theoretische Bedeutung hat, sondern sich bei hoher Last und parallelen Zugriffen in der Praxis oft kritisch auswirkt. Die zentrale Schwierigkeit liegt darin, sicherzustellen, dass Nutzer und Anwendungen immer aktuelle und korrekte Daten erhalten, auch wenn viele Prozesse gleichzeitig lesen und schreiben. Wenn eine Anwendung beispielsweise eine Aktualisierung in der SQL-Datenbank vornimmt, muss der entsprechende Eintrag im Redis-Cache entweder aktualisiert oder gelöscht werden, damit keine veralteten Werte gelesen werden. Dabei gilt es zu vermeiden, dass Prozesse beim Lesen zwischen dem Update der Datenbank und dem Löschen oder Aktualisieren des Cache-Inhalts veraltete Daten erhalten – sogenannte Dirty Reads.

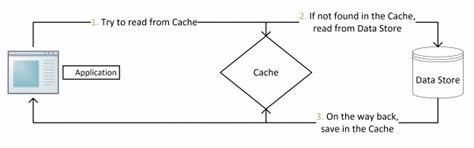

Ein oft angewandter und relativ einfacher Ansatz ist das sogenannte Cache-Expiry, also das automatische Ablaufen von Cache-Einträgen nach einer bestimmten Zeit. Zwar ist es grundsätzlich sinnvoll, Daten im Cache nicht unbegrenzt vorzuhalten, um Speicherressourcen zu managen, jedoch kann diese Methode alleine keine echte Konsistenz garantieren. Setzt man die Ablaufzeit zu lang an, besteht die Gefahr, dass Nutzer veraltete Informationen über einen längeren Zeitraum erhalten. Wird die Dauer sehr kurz gewählt, kann es zu vielen Cache-Misses kommen, was wiederum die Performance stark beeinträchtigt und den Nutzen des Caches negiert. Eine weitere und häufig genutzte Strategie ist das Cache-Aside-Muster, das auch als Lazy Loading bezeichnet wird.

Hierbei liest die Anwendung erst im Cache und bei einem Cache-Miss wird die SQL-Datenbank abgefragt, um die Daten anschließend in den Cache zu schreiben. Beim Ändern der Daten in der Datenbank löscht oder invalidiert die Anwendung den entsprechenden Cache-Eintrag, damit beim nächsten Lesezugriff die aktualisierten Daten geladen werden. Dieses Muster bietet in der Praxis eine gute Balance zwischen Konsistenz und Performance und wird von vielen großen Unternehmen genutzt. Dennoch existieren auch hier Schwachstellen. In Szenarien mit hoher Parallelität kann es dazu kommen, dass zwischen der Aktualisierung der Datenbank und dem Löschen des Cache-Eintrags andere Prozesse noch den alten Cache-Wert lesen, was zu Inkonsistenzen führt.

Noch problematischer ist der Fall, dass ein Prozess abstürzt, bevor er den Cache vollständig invalidieren kann – so bleibt der Cache veraltet, bis er manuell oder durch Ablaufzeit entfernt wird. Es gibt Varianten des Cache-Aside-Ansatzes, bei denen die Reihenfolge von Cache-Invalidierung und Datenbank-Update verändert wird, doch sie leiden oft unter noch schwerwiegenderen Inkonsistenzen. Beispielsweise kann eine frühzeitige Löschung des Cache-Eintrags vor der Datenbank-Aktualisierung dazu führen, dass andere Prozesse in der Zwischenzeit alte Daten aus der Datenbank lesen und neu in den Cache schreiben. Dieses Problem verstärkt sich bei der Variante, bei der Updates gleichzeitig im Cache und in der Datenbank geschrieben werden, da konkurrierende Schreibprozesse zu widersprüchlichen Datenständen führen können. Alternativ gibt es Read-Through- und Write-Through-Strategien, bei denen der Cache so konzipiert ist, dass er die SQL-Datenbank automatisch bei Cache-Misses liest beziehungsweise Updates zuerst im Cache durchführt und danach synchron in der Datenbank speichert.

Diese Ansätze haben jedoch große technische Herausforderungen. Redis unterstützt von Haus aus keine automatische Datenbankabfrage bei Cache-Misses und bietet keine native Möglichkeit, Schreibvorgänge atomar und synchron mit der Datenbank abzugleichen. Zudem ist Redis als In-Memory-Datenstruktur-Store nicht zum dauerhaften Speichern von Daten ausgelegt und kann bei Ausfällen Daten verlieren, was die Zuverlässigkeit untergräbt. Eine weitere interessante Methode ist der Write-Behind-Pattern, bei dem Updates zunächst im Cache erfolgen und dann asynchron in die Datenbank geschrieben werden. Dies kann durch Zwischenpuffern über Message Queues oder Redis Streams erfolgen, wodurch eine höhere Schreibperformance erreicht wird.

Allerdings handelt es sich dabei um eine eventual consistency Lösung, die nur dann funktioniert, wenn die Reihenfolge der Operationen gewahrt bleibt. Stellt man sich z.B. vor, dass Datenbankupdates außerhalb der Reihenfolge ausgeführt werden, entstehen leicht Inkonsistenzen. Ein gängiges Verfahren zur Verbesserung der Cache-Invalidierung ist das so genannte Double-Delete-Pattern.

Hierbei wird der Cache-Eintrag unmittelbar vor und einige Millisekunden nach dem Datenbank-Update gelöscht, um sicherzustellen, dass nach dem Update keine veralteten Werte mehr im Cache verweilen. Auch wenn dies die Wahrscheinlichkeit von Inkonsistenzen verringert, kann es in seltenen Fällen immer noch zu Dirty Reads kommen. Eine revolutionäre Idee stammt vom Alibaba-Projekt Canal, das den Prozess umkehrt. Anstatt vom Cache aus die Datenbank zu aktualisieren, überwacht Canal das MySQL-Binlog und repliziert Änderungen in Echtzeit zurück in den Redis-Cache. Dieses Prinzip nutzt die Bindegliedfunktion des Binlogs in relationalen Datenbanken, die als vertrauenswürdige und langlebige Quelle gilt.

So können Cache und Datenbank nahezu synchron gehalten werden, ohne direkte Operationen zwischen ihnen orchestrieren zu müssen. Dieses Verfahren bietet eine höhere Datensicherheit und Konsistenz, stellt jedoch auch neue Anforderungen an die Infrastruktur und Komplexität des Systems. Zusammenfassend lässt sich sagen, dass keine der bestehenden Strategien eine absolute starke Konsistenz zwischen Redis-Cache und SQL-Datenbank unter hoher Last und Parallelität garantieren kann, ohne dabei starke Leistungseinbußen in Kauf zu nehmen. Für viele Anwendungen reicht eine eventual consistency aus, bei der veraltete Daten nur für sehr kurze Zeiträume auftreten und das System insgesamt performant bleibt. Die Wahl der geeigneten Strategie hängt stark von den spezifischen Anforderungen ab: Wie kritisch sind Fehler bei veralteten Daten? Wie hoch ist die erwartete Last? Wie viel Performance kann geopfert werden, um Konsistenz zu gewährleisten? Die Entwicklung und Optimierung von Hybrid-Architekturen mit Redis und SQL-Datenbanken ist nach wie vor ein aktives Forschungs- und Praxisfeld.

Entwickler sollten stets das Zusammenspiel von Cache-Invalidierung, Speicher- und Netzwerk-Latenzen sowie Ausfallsicherheit bedenken. Letztlich ist ein bewusster Kompromiss zwischen Konsistenz und Performance unvermeidlich. Die kontinuierliche Überwachung der Systeme, das geeignete Setzen von Cache-Ablaufzeiten und das Implementieren von Mechanismen wie Double-Delete oder der Einsatz von Binlog-basierten Synchronisationslösungen wie Canal können dazu beitragen, mögliche Inkonsistenzen zu minimieren und dennoch die Vorteile eines schnellen Caches voll auszuschöpfen.