Japan gehört aufgrund seiner geographischen Lage, starken Niederschläge und häufigen Taifune zu den weltweit am stärksten von Überschwemmungen gefährdeten Ländern. Die Komplexität der natürlichen Bedingungen und die dicht besiedelten urbanen Gebiete machen eine präzise und vorausschauende Hochwasserrisikobewertung unverzichtbar. In diesem Kontext hat ein innovatives Projekt an der Schnittstelle zwischen Geoinformationssystemen (GIS) und maschinellem Lernen eine neuartige Karte zur Bewertung von Hochwassergefährdungen für Japan entwickelt. Diese Kombination modernster Technologien verspricht eine deutlich verbesserte Vorhersagegenauigkeit und bietet wertvolle Unterstützung für Katastrophenschutz und Stadtplanung. Der Ansatz basiert auf der Verarbeitung umfangreicher geographischer Daten und der Anwendung eines linearen Regressionsmodells, um die wichtigsten Einflussfaktoren auf Überflutungsrisiken zu identifizieren und zu gewichten.

So entsteht eine datengestützte Karte, die sowohl Forscher als auch Behörden in ihrer Risikobewertung unterstützt und konkrete Handlungsoptionen aufzeigt. Die Grundlage der Karte bilden zwei zentrale Datensätze. Zum einen ein hydrologisches Kartenwerk der Universität Tokio, das vielfältige topographische und hydrologische Merkmale wie die Fließrichtung von Wasser, Geländehöhe, Abflussflächen und Flussbreiten umfasst. Diese Parameter sind entscheidend, um zu verstehen, wie Wasser fließt, wo es sich staut und wo Überschwemmungen besonders wahrscheinlich sind. Zum anderen werden historische Flutdaten der japanischen Forschungseinrichtung zur Erd- und Katastrophenforschung genutzt, die detaillierte Angaben zu zeitlichen und örtlichen Hochwasserereignissen von 1961 bis 2008 enthalten.

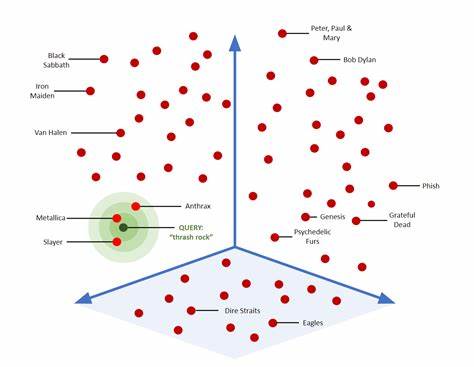

Die Kombination dieser Datensätze ermöglicht eine fundierte Analyse von Hochwasserereignissen im historischen Kontext und bildet die Basis für das Training des Machine-Learning-Modells. Die interdisziplinäre Vorgehensweise berücksichtigt sowohl natürliche Geländegegebenheiten als auch historische Überflutungsmuster und integriert diese zu einem umfassenden Bild. Die technische Umsetzung erfolgt durch das Einlesen und Verarbeiten von GeoTIFF-Dateien, die unterschiedliche Geländedaten räumlich kodieren. Besonderes Augenmerk liegt auf der präzisen Maskierung von Ozeanzonen, damit die Analyse ausschließlich auf relevante Landflächen fokussiert ist. Im Zentrum steht ein lineares Regressionsmodell, das automatisiert optimale Gewichtungen für die einzelnen Risikofaktoren bestimmt.

Diese Methode erlaubt es, anhand der historischen Daten zu quantifizieren, welcher Einfluss beispielsweise die Höhe des Geländes oder die Nähe zu Flusssystemen auf bedeutsame Überflutungen hat. Interessanterweise zeigte sich dabei, dass Geländehöhe und der sogenannte HAND-Wert (Height Above Nearest Drainage) die stärksten Einflussgrößen auf die Flutgefahr besitzen. HAND misst die relative Höhe eines Punktes über dem nächsten Fließgewässer und ist damit ein wichtiger Indikator für Überflutungsgefährdung, da niedrig gelegene Bereiche bei Hochwasser besonders anfällig sind. Die weiteren Faktoren wie die Größe der Einzugsgebiete (upstream drainage area), die Wasserfließrichtung sowie die Flussbreite trugen dagegen nur marginal zum Risiko bei. Insbesondere die Flussbreite zeigte in den Daten keinerlei signifikanten Einfluss.

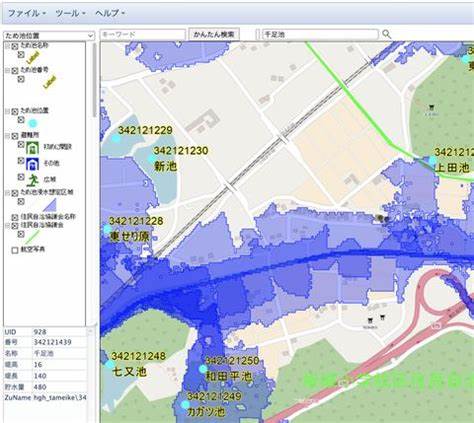

Dieses Ergebnis stimmt mit hydrologischem Wissen überein, da Wasser grundsätzlich der Schwerkraft folgend abfließt und niedrig gelegene Gebiete mit direktem Zugang zum Flusssystem besonders gefährdet sind. Die aus dem Modell gewonnenen Gewichte fließen in eine Risiko-Score-Funktion ein, welche für jede untersuchte Region einen normierten Wert von 0 bis 1 erzeugt. Wertet man diese Scores räumlich aus, entstehen hochauflösende Karten, die Hochrisikogebiete eindeutig hervorheben. Die Ergebnisse bestätigen bekannte Gefahrenzonen: so zählen die dicht besiedelten Metropolregionen um Tokio und die Kanto-Ebene, das urbane Ballungsgebiet Osaka-Kyoto-Kobe sowie die tiefer gelegenen Flusseinzugsgebiete in Hokkaido zu den bedeutendsten Gefahrenstellen. Die Validierung der Hochwasserrisikokarte erfolgt durch den Vergleich mit verifizierten historischen Überschwemmungen.

Dabei decken sich die modellierten Hochrisikozonen stark mit dokumentierten Ereignissen, was die Aussagekraft der Methode unterstreicht. Die Karte zeigt in lila markiert die Gebiete, in denen hohes Risiko besteht und wo tatsächlich Überschwemmungen aufgetreten sind. Neben den rein statistischen Modellen bietet die kartographische Darstellung vielfältige Nutzungsmöglichkeiten. So ermöglicht sie einerseits eine detaillierte Einschätzung der lokalen Überflutungsgefahr und kann andererseits als strategisches Instrument für Katastrophenschutz, Bauplanung und Infrastrukturentwicklung dienen. Insbesondere für städtische Planer eröffnen sich neue Chancen, problematische Gebiete frühzeitig zu identifizieren und Vorkehrungen zu treffen.

Die Kombination von GIS und maschinellem Lernen schafft dabei ein dynamisches Werkzeug, das angepasst und mit neuen Datensätzen weiter verfeinert werden kann. Trotz der vielversprechenden Ergebnisse gibt es zahlreiche Perspektiven, wie das Projekt weiterentwickelt werden kann. So liegen zukünftige Erweiterungen in der Integration tieferer Umweltparameter, etwa zur Bodenbeschaffenheit, Versiegelungsgraden oder städtischen Nutzungsmustern. Auch Klimaänderungen mit vermehrt extremen Niederschlägen erfordern eine dynamischere Modellierung, welche saisonale Schwankungen und langfristige Trends berücksichtigt. Die Entwicklung von zeitabhängigen Risikomodellen könnte zudem eine verbesserte Frühwarnung und adaptive Maßnahmenplanung ermöglichen.

Die Verfügbarkeit immer detaillierterer geographischer Daten, etwa durch Satelliten oder Drohnenbefliegungen, bietet zusätzliche Chancen, die Genauigkeit und Aktualität der Karten zu steigern. Die Verbindung von Big Data mit fortgeschrittenen Lernalgorithmen wird so zukünftig zu noch präziseren Hochwasserprognosen führen. In der praktischen Anwendung bietet das Projekt einen exemplarischen Nachweis, wie datengetriebene Methoden helfen können, Naturgefahren besser einzuschätzen und somit Menschenleben zu schützen. Durch den gezielten Einsatz von GIS-Technologien und Machine Learning wird das komplexe Zusammenspiel zahlreicher Umweltfaktoren erfassbar gemacht und in verständliche Risikoindikatoren überführt. Dies fördert nicht nur die öffentliche Aufmerksamkeit für Hochwassergefährdungen, sondern verbessert auch die Entscheidungsgrundlagen von Politik, Verwaltung und Bevölkerung.

Insgesamt zeigt das Vorhaben eindrucksvoll, dass innovative Technologien und interdisziplinäres Denken essenziell sind, um den Herausforderungen des Klimawandels und steigender Katastrophenrisiken zu begegnen. Die Kombination von räumlicher Datenanalyse und KI eröffnet neue Wege, um Hochwassergefahren frühzeitig zu erkennen und im Sinne einer nachhaltigen Risikovorsorge effizient zu steuern. Japan kann mit solchen Lösungen seine Vorreiterrolle im Katastrophenschutz weiter ausbauen und als Modell für internationale Anwendungen dienen. Die Verbindung von traditionellem Wissen mit modernen digitalen Werkzeugen wird so zu einem Schlüssel für die Sicherheit von Millionen Menschen – heute und in Zukunft.