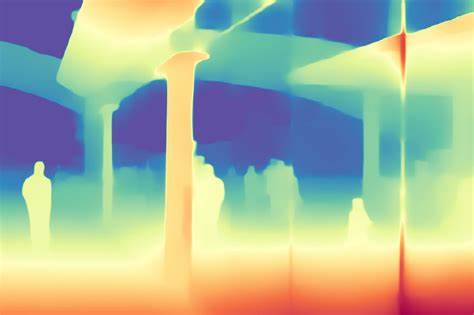

Die Fortschritte in der künstlichen Intelligenz haben in den letzten Jahren zahlreiche Bereiche revolutioniert, darunter auch die Bildverarbeitung und insbesondere die Tiefenschätzung aus Einzelbildern. Ein Durchbruch in diesem Bereich ist Depth Anything V2, ein Modell, das auf der Grundlage von umfangreichen synthetischen und realen Bilddaten entwickelt wurde und die monokulare Tiefenschätzung (MDE) auf ein neues Level hebt. Dieses Modell beeindruckt durch seine Fähigkeit, feinere Details zu erfassen, höhere Robustheit zu gewährleisten und gleichzeitig wesentlich effizienter zu arbeiten als vorherige Ansätze. Depth Anything V2 wurde von einem Team aus Forschern der University of Hong Kong und TikTok entwickelt und hat dabei bewährte Konzepte mit modernen Trainingsstrategien verbunden, um leistungsfähige und vielseitige Tiefenmodelle zu schaffen. Die Grundlage von Depth Anything V2 bildet ein großes Dataset, das sowohl synthetische als auch reale Bilder umfasst.

Über 595.000 synthetisch erzeugte Bilder dienen als Basis für das Training eines großen Lehrermodells. Diese synthetischen Daten ermöglichen eine präzise Kontrolle und eine hohe Qualität der Tiefenannotation, was bei realen Bildern wegen der Schwierigkeit der Tiefenerfassung oft ein Problem darstellt. Ergänzt wird dieses Training durch eine immense Menge von mehr als 62 Millionen unbezeichneten realen Bildern, für die das Lehrermodell hochqualitative Pseudo-Tiefenlabels erzeugt. Auf diese Weise gelingt es, realistische und generalisierbare Modelle zu trainieren, die in der Praxis herausragende Ergebnisse liefern.

Ein wesentlicher Fortschritt gegenüber dem Vorgängermodell Depth Anything V1 besteht darin, dass Depth Anything V2 keine beschrifteten realen Bilder mehr verwendet, sondern vollständig auf synthetische Daten als Trainingsgrundlage für das Lehrermodell setzt. Anschließend werden die realen Daten mit dem Lehrermodell pseudo-beschriftet, um die Studentmodelle zu trainieren. Diese Herangehensweise führt zu deutlich präziseren und robusteren Tiefenschätzungen, da das Modell gezielt von der klar definierten synthetischen Umgebung lernt und gleichzeitig mit realen Bildvariationen konfrontiert wird. Darüber hinaus erreicht Depth Anything V2 eine beeindruckende Effizienzsteigerung. Im Vergleich zu Modellen, die auf Stable Diffusion basieren, arbeitet es mehr als zehnmal schneller und weist eine erheblich geringere Modellgröße auf.

Dies macht das Modell nicht nur für die Forschung, sondern auch für den praktischen Einsatz attraktiv, insbesondere in Anwendungen mit begrenzten Ressourcen wie mobilen Geräten oder eingebetteten Systemen. Die Qualität der Tiefenschätzung zeigt sich besonders in der Fähigkeit, sehr feinkörnige Details herauszuarbeiten und eine hohe Genauigkeit bei der Darstellung von Tiefenvariationen innerhalb eines Bildes zu erzielen. Diese Eigenschaften sind essenziell, um eine realitätsnahe 3D-Rekonstruktion aus nur einem einzelnen Bild zu ermöglichen. Die Weiterentwicklung von Depth Anything V2 im Vergleich zur ersten Version macht es möglich, anspruchsvollere Szenen mit komplexer Beleuchtung, vielfältigen Texturen und unterschiedlichen Tiefenebenen zuverlässig zu erfassen. Neben der verbesserten Modellarchitektur und den Trainingsmethoden bietet Depth Anything V2 eine skalierbare Modellpalette mit sechs verschiedenen Modellen, die nach Größe und Komplexität abgestuft sind.

Drei dieser Modelle sind speziell für den Indoor-Bereich entwickelt, während drei weitere für Outdoor-Szenarien optimiert wurden. Diese Spezialisierung ermöglicht eine noch bessere Anpassung an die jeweiligen Einsatzumgebungen, da die Eigenschaften in Innen- und Außenräumen sehr unterschiedlich sind. Ein weiterer bemerkenswerter Aspekt von Depth Anything V2 ist die flexible Feinabstimmung (Fine-Tuning) mit metrischen Tiefendaten. Dieser Prozess nutzt die vorab trainierten Modelle und passt sie gezielt an reale Messdaten an, um die Tiefenmessungen quantitativ zu verbessern. So entstehen Modelle, die nicht nur qualitativ gute Tiefenkarten liefern, sondern auch präzise Entfernungswerte, was insbesondere in Bereichen wie autonomes Fahren, Robotik und Augmented Reality von hoher Bedeutung ist.

Die Entwicklung von Depth Anything V2 basiert auf einer klaren und effizienten Framework-Pipeline. Zunächst wird das größte Lehrermodell auf den umfangreichen synthetischen Daten trainiert. Danach erstellt dieses Aggregat hochwertige Pseudo-Tiefenlabels für die riesige Sammlung realer Bilder. Anschließend erfolgt das Training der Studentmodelle ausschließlich auf diesen pseudo-beschrifteten realen Daten. Auf diese Weise gelingt es, die Vorteile der synthetischen und realen Datenwelt ideal zu kombinieren, ohne auf teure und aufwändige manuelle Tiefenannotationen angewiesen zu sein.

Neben den technologischen Innovationen leistet Depth Anything V2 auch einen wertvollen Beitrag zur Forschung, indem es mit seinem neuen DA-2K-Benchmark eine vielseitige und robuste Evaluationsgrundlage bereitstellt. Diese Benchmark zeichnet sich durch spärliche, aber präzise Tiefenannotation aus, was die Vielfalt und Realitätsnähe der Testsets verbessert. Durch diesen Schritt wird die Bewertung von Tiefenschätzungsmethoden deutlich repräsentativer und praktikabler für reale Anwendungen. Die Relevanz von Modellen wie Depth Anything V2 erstreckt sich über zahlreiche Anwendungsbereiche. In der Automobilindustrie ermöglicht die monokulare Tiefenschätzung kostengünstige Entfernungserfassung und Szenenerkennung, die für Fahrerassistenzsysteme oder autonome Fahrzeuge unverzichtbar sind.

In der Architektur und Innenraumgestaltung liefern präzise Tiefenkarten wichtige Informationen für die Planung und Simulation. Ebenso profitieren Augmented- und Virtual-Reality-Systeme von genauen Tiefendaten, da sie die Verschmelzung von realer und digitaler Welt realistischer gestalten. Im Vergleich zu anderen zeitgenössischen Lösungen wie Marigold oder Geowizard hebt sich Depth Anything V2 durch seine Kombination aus hoher Genauigkeit, besserer Robustheit und enormer Geschwindigkeit deutlich ab. Während viele andere Modelle auf aufwendige Diffusionsverfahren setzen, bewahrt Depth Anything V2 eine effiziente und zugängliche Architektur, die sich leicht skalieren und anpassen lässt. Ein Blick auf die Zukunft offenbart, dass Depth Anything V2 ein bedeutendes Fundament für weiterführende Entwicklungen in der Tiefenschätzung bildet.

Durch die Verwendung synthetischer Daten in Kombination mit groß angelegten Pseudo-Labeling-Strategien zeigt das Modell eine nachhaltige Methodik, die auch auf andere Bereiche der KI angewendet werden kann, in denen hochwertige Labels knapp oder teuer sind. Darüber hinaus eröffnet die Bereitstellung von Modellen in verschiedenen Größen und für unterschiedliche Szenarientypen zahlreiche Optionen für Entwickler und Forscher, um maßgeschneiderte Lösungen für spezifische Herausforderungen zu finden. Ob auf leistungsfähigen Rechenzentren oder auf mobilen Endgeräten – die Flexibilität erlaubt vielfältige Einsatzmöglichkeiten. Depth Anything V2 macht deutlich, wie wichtig die Integration von synthetischen und realen Daten ist, um hochqualitative KI-Modelle zu trainieren, die praxistauglich sind. Dabei steht nicht nur die reine Leistungssteigerung im Vordergrund, sondern auch die Effizienz und Benutzerfreundlichkeit.