Das Internet ist eine gewaltige Ressource an Daten, die ständig wächst und sich verändert. Für Forscher, Entwickler und Unternehmen, die große Mengen an Webdaten analysieren möchten, stellt sich häufig die Frage, wie sie auf diese Daten zugreifen können, ohne selbst enorme Speicher- und Verarbeitungsressourcen investieren zu müssen. In diesem Kontext wird Common Crawl immer wieder als wertvolle Ressource genannt. Common Crawl ist ein open-source Web-Crawling-Projekt, das seit mehreren Jahren Milliarden von Webseiten sammelt und die gesammelten Daten der Öffentlichkeit kostenlos zur Verfügung stellt. Die Daten umfassen den vollständigen HTML-Content gefundener Webseiten, Metadaten, Linkstrukturen und mehr.

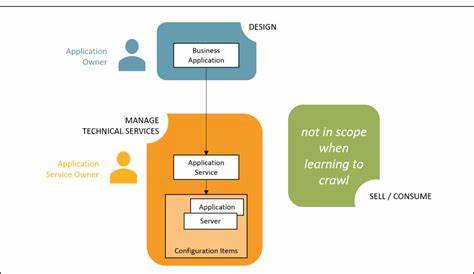

Trotz dieser Fülle an Informationen stellt sich eine zentrale Frage: Gibt es einen Dienst, der Common Crawl als einfache API zur Verfügung stellt, um nur auf relevante Daten zugreifen zu können, ohne den kompletten Datensatz herunterladen oder verwalten zu müssen? Common Crawl liefert eine enorm umfassende Datenbasis, die kontinuierlich wächst. Der vollständige Datensatz umfasst mehrere Terabyte an komprimierten Dateien und wird monatlich neu veröffentlicht. Für Unternehmen und Entwickler, die nicht die Infrastruktur oder Zeit haben, diese Daten vollständig herunterzuladen und selbst zu verarbeiten, sind entsprechende Dienste oder Tools interessant, die den Zugriff vereinfachen. Der Wunsch ist häufig, gezielt bestimmte Informationen zu extrahieren, wie zum Beispiel die Hostnamen oder URLs mit ihrem HTML-Content, ohne unnötige Daten zu laden. Während Common Crawl selbst keine dedizierte API anbietet, die diese maßgeschneiderten Datenpunkte einfach abfragt, gibt es Projekte und Tools in der Entwickler-Community, die diesen Bedarf adressieren.

Eine der bekanntesten Ressourcen ist die Index-API von Common Crawl selber, erreichbar unter index.commoncrawl.org. Diese API ermöglicht es, nach Domains oder URLs mit Wildcards zu suchen und liefert Metadaten zu den gefundenen Treffern. Das vereinfacht erstmals die Filterung der Daten erheblich und erlaubt, gezielt eine Untermenge der Daten zu identifizieren, die den eigenen Anforderungen entsprechen.

Für komplexere Anforderungen, etwa wenn komplette HTML-Seiten direkt abgefragt werden sollen, müssen Entwickler oft ergänzende Schritte unternehmen. Das liegt daran, dass Common Crawl die Rohdaten in sogenannten WARC-, WET- oder WAT-Dateien speichert, die wiederum auf Cloud-Speichern wie Amazon S3 liegen. Entwickler laden dann diese Dateien herunter oder streamen sie, um sie mit eigenen Programmen weiterzuverarbeiten. Das ist mit technischem Aufwand verbunden, insbesondere wenn nur Teilmengen der Daten benötigt werden. Einige Open-Source-Projekte versuchen, diesen Zugang zu erleichtern.

Zum Beispiel bietet das Projekt Wayurls auf GitHub einen Ansatz, um URLs aus Common Crawl kompakter und zugänglicher aufzulisten. Solche Tools helfen Anwendern, gezielt Webadressen zu extrahieren und diese für weitere Analysen zu nutzen. Sie ersetzen keine vollumfängliche API, optimieren aber den Einstieg in die Datenanalyse. Der Markt hat auch zusätzliche Anbieter hervorgebracht, die Dienstleistungen rund um Common Crawl anbieten. Diese spezialisierten Services bieten APIs an, die vorgefilterte oder angereicherte Datensätze bereitstellen.

Sie zielen darauf ab, den Prozess der Datenextraktion zu vereinfachen und skalierbar zu gestalten. Diese APIs sind oft kostenpflichtig, bieten aber entscheidende Vorteile für Unternehmen, die schnell auf nutzbare Informationen zugreifen möchten, ohne eigene gesamte Datenverarbeitungsketten aufzubauen. Für Entwickler oder Forscher, die das Thema Common Crawl API interessieren, ist es ratsam, sich zunächst mit der Index-API und den verfügbaren Open-Source-Tools vertraut zu machen. Das eröffnet einen ersten Zugang, mit dem sich Hostnamen, URLs oder Metadaten recherchieren lassen. Anschließend können eigene Parser oder Datenpipelines entwickelt werden, die dann gezielt einzelne Seiteninhalte aus den WARC-Dateien extrahieren.

Durch die Nutzung von Cloud-Diensten wie Amazon Web Services oder Google Cloud können diese Prozesse oft effizient gestaltet und skaliert werden. Die Nutzung von Common Crawl als Datenquelle ist besonders spannend für Bereiche wie SEO-Analyse, wissenschaftliche Webforschung, Marktanalysen oder maschinelles Lernen. Der Zugriff auf riesige Mengen Webcontent bietet einzigartige Chancen zur Entwicklung von Modellen, Identifikation von Trends oder zur Wettbewerbsbeobachtung. Der Einstieg in Common Crawl über eine API erleichtert die Arbeit insbesondere dann, wenn nur ausgewählte Datenpunkte aus großen Crawls benötigt werden. Trotz der vielen Vorteile gibt es auch herausfordernde Aspekte wie die Datenaktualität, da neue Crawl-Daten nur in Zyklen veröffentlicht werden und nicht in Echtzeit vorliegen.

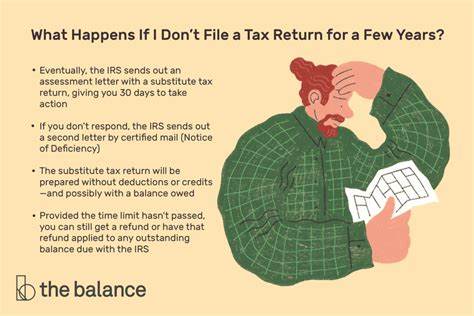

Außerdem erfordert die Verarbeitung großer Datenmengen ein gewisses technisches Know-how und Ressourcen, um die Daten sinnvoll zu filtern und zu nutzen. Unternehmen sollten diese Faktoren bei der Wahl der Zugangsform zu Common Crawl-Daten berücksichtigen. Abschließend lässt sich sagen, dass die direkte Bereitstellung von Common Crawl als API nicht im Standardumfang enthalten ist, jedoch durch externe Tools, die Index-API und spezialisierte Dienste zunehmend auch ohne eigene komplexe Infrastruktur machbar wird. Das steigende Interesse in der Entwicklergemeinschaft führt zu einer wachsenden Zahl hilfreicher Lösungen, um großen Webdatenbeständen effizient und flexibel zu begegnen. Für alle, die hostbezogene Webseite-Informationen und deren HTML-Inhalte für Datenanalysen brauchen, bieten sich heute schon praktikable Wege an, um auf Common Crawl zuzugreifen und die Rohdaten nutzbar zu machen.

Die Zukunft wird wahrscheinlich noch mehr vereinfachte Schnittstellen und APIs bringen, die den Umgang mit Web-Crawl-Daten weiter verbessern und die Hürden für den Einstieg deutlich senken.