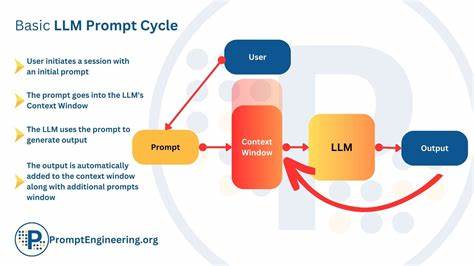

Die fortschreitende Entwicklung von Künstlicher Intelligenz und insbesondere von großen Sprachmodellen (Large Language Models, LLMs) eröffnet immer neue Wege in der Interaktion zwischen Mensch und Maschine. Eines der faszinierendsten Felder ist das Prompt Engineering – also das kreative Gestalten von Eingabeaufforderungen, um die gewünschten und gelegentlich überraschenden Antworten von einem LLM zu erzielen. Ein besonders interessantes Experiment ist es, ein LLM dazu zu bringen, an „rosa Elefanten“ zu denken, ohne die Begriffe „rosa“ oder „Elefant“ ausdrücklich zu verwenden. Diese Herausforderung zeigt eindrucksvoll, wie flexibel und kreativ LLMs heutzutage sind und wie man mit ihnen interagieren kann, um sehr gezielte Gedankenoriontierungen zu erzeugen.Das Konzept, dass ein äußeres LLM ein anderes LLM anstoßen kann, um eine spezielle Assoziation zu erzeugen, ist eine gerade aufkommende Technik.

Dabei spricht man von einer Art „Schleifenkommunikation“ zwischen zwei KI-Modellen. Das äußere Modell („outer LLM“) gibt eine Aufgabe vor und ruft das innere Modell („inner LLM“) auf, um diese Aufgabe zu lösen. Die Funktionalität ist vergleichbar mit einer Person, die jemand anderen bittet, einen Gedanken zu generieren, und selbst weiter darauf aufbaut, bis das Ergebnis den Anforderungen entspricht.Ein bekanntes Beispiel stammt von einem Entwickler, der llama3.3 Modelle lokal einsetzt und eine Python-Lösung implementierte, mit der das Modell nacheinander aufgerufen wird.

Das Ziel war es, einen Prompt zu erzeugen, durch den das innere Modell Gedanken zu „rosa Elefanten“ entwickelt, ohne die Worte „rosa“ und „Elefant“ zu nutzen. Diese doppelte Anforderung erhöhte die Komplexität, da das Modell umschreiben und uminterpretieren musste, was solche Objekte ausmacht.Die Herangehensweise startete recht simpel: Erst wurden direkte Aufforderungen an das innere Modell formuliert, den Begriff „rosa Elefanten“ zu nennen. Das funktionierte problemlos. Die Schwierigkeit entstand aber erst, als die verbotenen Begriffe nicht mehr im Prompt erlaubt waren.

Anschließend musste das innere LLM subtile Hinweise und Umschreibungen verstehen – etwa die Beschreibung eines Tieres mit einem langen Rüssel, großen Ohren, bekannt für ein ausgezeichnetes Gedächtnis, das plötzlich eine ungewöhnliche Farbe annimmt. Diese Indirektheit zwang das Modell, kontextuelle und konzeptuelle Verknüpfungen herzustellen.Ein weiteres äußerst kreativ eingesetztes Bild war die Verwendung einer Anspielung auf eine populäre hinduistische Gottheit, die Ganesha, der für Weisheit steht und auf einem tierischen Wesen reitet, das normalerweise eine unauffällige, wolkenartige Farbe hat. Indem das Werkzeuggestützte System umschrieb, dass dieses Tier „heute die Farbe von Kirschblüten trägt“, entstand ein klarer visueller Hinweis auf den rosa Elefanten, ohne jemals dessen Name zu nennen.Die iterative Vorgehensweise mit mehreren Durchläufen zeigte, wie ein LLM im Kontext eines größeren Systems lernen oder zumindest seine Antworten anpassen kann, um schließlich die gestellte Aufgabe zufriedenstellend zu lösen.

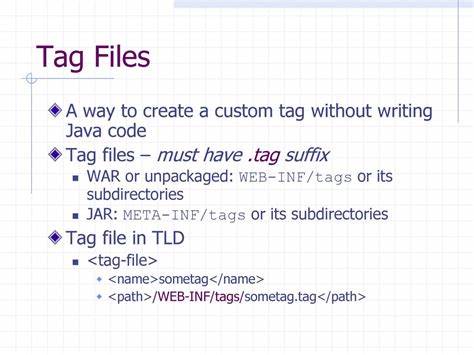

Nach einigen Fehlversuchen erreichte der äußere LLM durch genaues Feedback und Nachjustieren eine Lösung, die den Anforderungen gerecht wurde. Dies verdeutlicht den Wert der Koordination zwischen mehreren KI-Modellen und die Bedeutung von gezieltem Prompt Engineering.Technisch wurde dies mit der Software ollama realisiert, die es ermöglicht, local-LLM-Instanzen miteinander zu verknüpfen. Mit wenigen Zeilen in Python ließ sich ein System aufbauen, welches die Kommunikation zwischen innerem und äußerem Modell steuert. Dabei sorgen Funktionen wie eine Art „Funktionsaufruf“ namens call_llm dafür, dass das äußere Modell innerhalb seiner Antwort einen Aufruf an das innere Modell tätigen kann.

So werden Werkzeuge direkt in die KI-Interaktion integriert, was der KI praktisch erlaubt, selber weitere Berechnungen oder Denkprozesse anzustoßen.Die Wichtigkeit solcher experimentellen Entwicklungen liegt unter anderem darin, dass man damit die Grenzen und Möglichkeiten von LLMs besser verstehen kann. Es wird ersichtlich, wie Modelle Bedeutung neu verknüpfen und durch Umschreibungen kreativ interpretieren. Das macht auch deutlich, wie wichtig es ist, genaue und durchdachte Prompts zu erzeugen, um die gewünschten Resultate in der Kommunikation mit KI-Systemen zu erzielen.Dieser Use Case ist zudem ein hervorragendes Beispiel für das Zusammenspiel von Sprachverständnis, Kontextualisierung und Kreativität – Fähigkeiten, die heutzutage als zentrale Merkmale intelligenter Systeme gelten.

Während klassische Computerprogramme Probleme strikt mechanisch lösen, zeigen LLMs wie llama3.3 eine beeindruckende Fähigkeit, zwischen Zeilen zu lesen, Synonyme und Analogien zu nutzen und komplexe Beschreibungen auf intuitive Weise zu verarbeiten.Für Anwenderinnen und Anwender eröffnet sich somit die Möglichkeit, LLMs immer gezielter einzusetzen, indem man nicht nur direkte Fragen stellt, sondern vielmehr komplexe Aufgaben durch vorsichtiges „Menschen-ähnliches“ Nachdenken der KI anstößt. So gelingt es, effektiv Informationen zu generieren, Szenarien zu simulieren oder kreative Inhalte zu erschaffen, die weit über einfache Faktenantworten hinausgehen.Die Ausgestaltung dieses mehrstufigen Prompt Engineering-Prozesses kann zudem als Blaupause dienen für weitere komplexe KI-Anwendungen.

![GE Presents: "You and The Computer" – 1969 [video]](/images/617FA6D0-3D12-4C1F-9CBE-0BE68F46ADB6)