Die Textextraktion aus umfangreichen und komplexen Dokumenten gehört zu den zentralen Herausforderungen moderner Anwendungen im Bereich Künstliche Intelligenz. Insbesondere bei deutschen Ausschreibungen, die oft mit technischen, bürokratischen und rechtlichen Formulierungen auf Dutzenden bis Hunderten von Seiten glänzen, wird deutlich, wie schwierig es ist, relevante Informationen präzise und vollständig zu extrahieren. Forgent AI hat sich dieser Herausforderung mit dem Aufbau eines Minimum Viable Products (MVP) für LLM-basierte Extraktion angenommen und dabei wertvolle Erkenntnisse gewonnen, die weit über den bloßen Technologiehype hinausgehen. In diesem Beitrag blicken wir auf die relevanten Aspekte, erzielten Durchbrüche und Stolpersteine in der Praxis und erklären, warum eine gut durchdachte Herangehensweise der Schlüssel zum Erfolg ist. Die literarische und technische Tiefe der Dokumente macht die Aufgabe zur Königsdisziplin der Textextraktion.

Auswahl, Optimierung und Kombination verschiedenster Modelle sowie ein intelligentes Prompt-Design beeinflussen maßgeblich die Qualität der Ergebnisse. Als zentrale Herausforderung zeigte sich von Anfang an, dass Standardlösungen, die vielfach auf dem Markt beworben werden, erstaunlich häufig hinter den Erwartungen zurückbleiben. Die Annahme, dass Textextraktion eine „gelöste“ Disziplin sei, erweist sich somit als Trugschluss. Das Team von Forgent AI arbeitete intensiv an der Auswahl und Benchmarking unterschiedlichster Modelle, wobei sich moderne Gemini-Modelle von Google als besonders leistungsstark herausstellten und in ihrer neuesten Version bei der Volltextauslese eine beeindruckende Recall-Rate von über 95 % erzielten. Von großer Bedeutung war dabei das Verständnis der menschlichen Arbeitsprozesse.

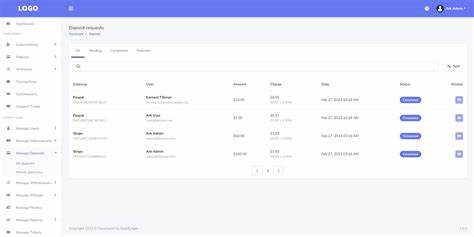

Es zeigte sich, dass selbst erfahrene Experten unterschiedliche Auffassungen darüber hatten, was genau eine Anforderung innerhalb der Ausschreibungsunterlagen darstellt. Dieses Phänomen der menschlichen Inkonsistenz – ausgelöst durch implizites Wissen und individuelle Interpretation – erschwerte das Erstellen eines belastbaren Ground-Truth-Datensatzes. Die Konsequenz daraus war die Notwendigkeit, das Problem zu modularisieren und unterschiedliche Aufgaben getrennt anzugehen. Anstatt zu versuchen, eine menschliche Arbeitsweise exakt abzubilden, setzte Forgent AI auf einen zweistufigen Ansatz: Zunächst eine möglichst umfassende Extraktion aller potentiellen Anforderungen und im Anschluss eine anpassbare Filterfunktion, mit der spezifische Nutzerpräferenzen abgebildet werden können. Ein weiterer Meilenstein des Projekts war die Entwicklung einer robusten Evaluationsinfrastruktur mit benutzerfreundlichen Interfaces.

Diese ermöglichte nicht nur technische Experten, sondern auch fachlichen Domain-Experten Zugriff auf die Testergebnisse und die aktive Anpassung der Promptgestaltung. Dies führte zu erheblich schnelleren Iterationszyklen und besseren Ergebnissen, da Muster sofort sichtbar wurden und Fehlerquellen leichter identifiziert werden konnten. Die Erkenntnis, dass kleine, hochwertige Evaluationsdatensätze wesentlich effektiver für die Optimierung sind als große, starr definierte Datensammlungen, unterstützt moderne Forschungsergebnisse zur Problemdefinition in der KI. Der iterative Prozess erlaubt eine flexible Anpassung der Bewertungskriterien und vermeidet das sogenannte „Criteria Drift“, bei dem die Evaluation unwiderstehlich mit der Modellanwendung verschmilzt. Im Mittelpunkt stand zudem ein sorgsamer Blick auf die Metriken: Neben klassischen Werten wie Präzision, Recall und F1-Score wurden wichtige Faktoren wie Kosten, Latenz und Skalierbarkeit berücksichtigt.

Immer wieder traten überraschende Effekte zutage, so führte beispielsweise eine psychologisch anmutende Änderung der Prompt-Sprache bei einem Anbieter zu einer messbaren Verbesserung bei der Vollständigkeit der Extraktion – allerdings zum Preis höherer Fehlalarme. Die Vergleichsstudien der verschiedenen Modelle offenbarten signifikante Unterschiede. Herausragende Ergebnisse erzielten Googles Gemini 2.5 Pro und Flash, die mit speziell abgestimmtem Prompting teilweise eine Recall-Rate von bis zu 98 % erreichten und so herkömmliche Wettbewerber wie Reducto, OpenAI oder Anthropic deutlich übertrafen. Gleichzeitig bewährte sich die Methode der Dokumentenchunkung, also der Aufteilung großer Dokumente in kleinere Abschnitte mit Überlappungen, um Kontextverlust und Halluzinationen entgegenzuwirken.

Das Clustern und die anschließende Deduplizierung der extrahierten Anforderungen waren entscheidende Schritte, um saubere und redundanzfreie Ergebnisse zu erzielen. Trotz aller technologischen Fortschritte zeigte sich, dass etablierte kommerzielle Produkte nicht immer die beste Kombination aus Leistung, Kosten und Zuverlässigkeit bieten. Offene Lösungen wie Docling, kombiniert mit leistungsfähigen LLMs, boten ebenfalls gute Leistungen, waren aber im Betrieb und der Wartung aufwendiger. Forgent AI entschied sich daher für eine pragmatische Strategie, bei der Frontend, Evaluationsinfrastruktur und Produktivcode eng verzahnt sind, um schnelle Verbesserungen und Skalierbarkeit sicherzustellen. Die wichtigste Lehre aus dem Projekt ist der kritische Umgang mit allgemeinen Benchmarks.

Viele public Benchmarks werden dem Anwendungsfall nicht gerecht und können den Eindruck erwecken, die Lösung sei schon in idealer Form verfügbar. Nur eine sorgfältige, eigene Evaluation mit realen, gut definierten Daten verrät tatsächlich den Stand der Technik für den jeweiligen Kontext. Die rasante Weiterentwicklung der Modelle erfordert außerdem einen Blick nach vorn. Wer heute mit Gemini 2.5 arbeitet, kann relativ sicher erwarten, dass in den kommenden sechs Monaten deutlich leistungsfähigere Optionen zur Verfügung stehen.

Ein stetes Nachjustieren und Experimentieren hilft dabei, den technologischen Vorsprung zu nutzen. Insgesamt belegt das Projekt, dass qualitativ hochwertige, hochverfügbare Textextraktion mit LLMs keineswegs trivial ist, sondern fundiertes Prozessverständnis, Methodik und technisches Know-how erfordert. Die Kombination von modularen Ansätzen, user-zentrierten Evaluationswerkzeugen und modernster Modelltechnik eröffnet aber das Potenzial, den bürokratischen Aufwand bei Ausschreibungen deutlich zu reduzieren und damit den Markt nachhaltig zu verändern. Forgent AI lädt alle Interessenten ein, diesen spannenden Weg weiter zu begleiten und gemeinsam mit ihnen neue Maßstäbe in der KI-gestützten Textanalyse zu setzen.

![World Robot Competition – Mecha fighting series [video]](/images/1F50920A-DBC3-4082-833B-873EB606ED6F)