Die rasante Evolution künstlicher Intelligenz hat die Art und Weise, wie Softwareentwicklung heute funktioniert, grundlegend verändert. Insbesondere die Kombination von großen Sprachmodellen (Large Language Models, LLM) mit lokalem Kontextwissen eröffnet neue Möglichkeiten, komplexe Codebasen besser zu verstehen und effizienter zu bearbeiten. In diesem Umfeld gewinnt RAGmate als lokaler RAG-Server für JetBrains IDEs deutlich an Bedeutung. Mit einem einzigartigen Fokus auf projektspezifischen Kontext schafft RAGmate eine innovative Schnittstelle zwischen etablierten KI-Technologien und den individuellen Anforderungen der Entwicklerteams. Die Idee hinter RAGmate ist denkbar einfach und doch höchst wirkungsvoll: Anstatt sich ausschließlich auf generische KI-Modelle zu verlassen, die Wissen aus einer unbestimmten Herkunft beziehen, indexiert RAGmate den kompletten Code eines Projekts lokal und ermöglicht so eine kontextuelle und präzise Informationsabfrage.

Das Resultat ist eine signifikant verbesserte Interaktion mit der JetBrains AI Assistant, die ohne RAGmate oft mit der Herausforderung konfrontiert ist, den komplexen Kontext großer oder historisch gewachsener Codebasen fehlerfrei nachzuvollziehen. Ein entscheidender Vorteil von RAGmate liegt in der vollständigen Datenhoheit. Branchenübergreifend steigt das Bedürfnis nach Datenschutz und der Vermeidung von Cloud-Diensten, in denen sensible Informationen unkontrolliert gespeichert werden könnten. RAGmate umgeht dieses Problem effektiv, indem es sämtliche Verarbeitungsschritte lokal ausführt. Somit verlassen vertrauliche Projektdaten niemals den Rechner der Entwickler und gewährleisten so maximale Sicherheit.

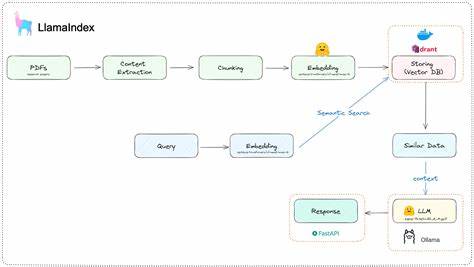

Die Technologie von RAGmate basiert auf einer Kombination von lokalen Einbettungen und semantischer Suche, die eine schnelle Indexierung und Wiederauffindung relevanter Codeabschnitte ermöglicht. Das Projekt unterstützt verschiedene LLM-Anbieter, darunter OpenAI, Ollama, LM Studio und andere Modelle mit API-Zugang. So können Benutzer flexibel ihr bevorzugtes KI-Modell einsetzen, ohne sich an eine bestimmte Plattform binden zu müssen. RAGmate integriert sich nahtlos in JetBrains IDEs durch eine leichtgewichtige HTTP-Brücke, die keine zusätzlichen Plugins oder komplexe Frameworks zum Betrieb benötigt. Diese elegante Architektur sorgt für einen minimalen Eingriff in bestehende Entwicklungsworkflows, was die Akzeptanz und den praktischen Nutzen der Lösung deutlich erhöht.

Die automatische Erkennung und Indexierung relevanter Dateien erfolgt intelligent, wobei gängige Entwicklungsdateien wie Python-, JavaScript-, TypeScript-, PHP-, Java-, Ruby-, Go-, C#- und Rust-Dateien berücksichtigt werden. Zusätzlich vermeidet RAGmate durch das Auslesen von .gitignore oder .aiignore-Listen bewusst Dateien, die nicht für die Indizierung geeignet oder notwendig sind, was dafür sorgt, dass der Prozess ressourcenschonend und effizient bleibt. Die Funktionsweise gestaltet sich denkbar einfach: Nach dem Aufbau eines lokalen Indexes als Wissensgrundlage wird der RAGmate-Server gestartet.

Die JetBrains AI Assistant verwendet anschließend den Server als Brücke zwischen dem LLM und dem eigenen Projektcode. So lassen sich Fragen formulieren, die wirklich direkt auf den individuellen Projektkontext abgestimmt sind. Ein Beispiel hierfür wäre die Anfrage, wo eine Funktion wie verify_token() im Quellcode verwendet wird oder eine Erklärung zum Login-Flow der Anwendung. Die Antworten basieren dabei auf den tatsächlich vorhandenen Daten statt auf allgemeinen Vermutungen oder Wissensdatenbanken. Gerade in großen oder komplexen Codeprojekten sowie bei legacy-Systemen führt dies zu einer enormen Beschleunigung von Entwicklungs- und Analyseprozessen.

Entwickler gewinnen nicht nur Sicherheit bei der Nutzung von KI-basierten Assistenzsystemen, sondern profitieren auch von einer verbesserten Qualität der generierten Vorschläge und Analysen. Für Entwickler, die JetBrains AI Assistant bereits nutzen, stellt RAGmate eine willkommene Erweiterung dar, die bestehende Funktionen sinnvoll ergänzt. Die Einrichtung erfolgt unkompliziert mittels Docker Compose, wodurch der RAGmate-Service in der Projektumgebung ohne großen Konfigurationsaufwand gestartet werden kann. Wichtig dabei ist die korrekte Angabe der Umgebungsvariablen, in denen LLM-Modell, Anbieter, API-Schlüssel und andere Parameter hinterlegt werden. Ein besonderes Highlight ist die Möglichkeit, Dateien in Echtzeit zu überwachen und die Indizes bei Änderungen automatisch zu aktualisieren.

Dies sorgt dafür, dass stets die aktuellsten Informationen zur Verfügung stehen, ohne dass manuelle Eingriffe nötig sind. Neben der technischen Funktionalität überzeugt RAGmate auch durch einfache Wartbarkeit und die Vermeidung unübersichtlicher Framework-Komplexität. Anders als manche Lösungen, die auf externe Abhängigkeiten wie LangChain oder LlamaIndex setzen, konzentriert sich RAGmate auf ein schlankes Setup, das die tägliche Arbeit erleichtert und Anpassungen schnell umsetzbar macht. Für Teams mit Fokus auf Datenschutz, die produktive Integration von KI in die Entwicklungsumgebung suchen, ohne Kompromisse bei der Kontrolle über den eigenen Code einzugehen, ist RAGmate eine äußerst attraktive Option. Der souveräne Umgang mit potentiell sensiblen Informationen verbindet sich mit einer produktiven Unterstützung, die auf praktischen Erfahrungen aus großen Codebasen basiert.

Zudem bietet RAGmate Raum für zukünftige Weiterentwicklungen und die Integration weiterer LLM-Modelle oder Embedding-Techniken, was die Plattform flexibel und zukunftssicher macht. In der Summe adressiert RAGmate ein bislang spürbares Defizit vieler KI-gestützter Entwicklerwerkzeuge: die fehlende Projektspezifik und Kontextsensitivität. Durch diese innovative lokale Retrieval-Augmented Generation Technologie gelingt es, die abstrakte Leistungsfähigkeit von LLMs auf konkrete, direkt im Code verankerte Informationen anzureichern. Dies erhöht nicht nur die Präzision der Antworten, sondern stärkt auch das Vertrauen der Entwickler in automatisierte Assistenzsysteme. In einer Zeit, in der KI zunehmend zum festen Bestandteil des Softwareentwicklungsprozesses wird, stellt RAGmate daher eine wegweisende Lösung dar, um künstliche Intelligenz wirklich zum Verbündeten und nicht zum Risiko im komplexen Entwicklungsalltag zu machen.

Wer JetBrains IDEs nutzt und den Wunsch nach einer datenschutzkonformen, projektbezogenen und dennoch flexiblen KI-Integration hat, findet mit RAGmate ein Werkzeug, das moderne KI-Potentiale effizient nutzbar macht und den Entwicklungsprozess nachhaltig verbessert. Die Kombination aus lokalen Indizes, semantischer Suche und offener Kompatibilität mit unterschiedlichen LLMs positioniert RAGmate zukunftssicher als eine unverzichtbare Ergänzung für Entwickler, die ihre Arbeit durch Künstliche Intelligenz zielgerichtet und verantwortungsvoll optimieren wollen.