Die Optimierung der Softwareleistung gehört zu den zentralen Aufgaben in der Softwareentwicklung. Gerade bei großen und komplexen Projekten ist das Profiling ein unerlässliches Werkzeug, um Engpässe zu erkennen und gezielt zu beheben. Doch trotz der breiten Verfügbarkeit von Profiling-Tools fühlen sich viele Entwickler überfordert von der schieren Menge an Informationen, die diese Werkzeuge liefern. Die Herausforderung besteht nicht darin, keine Daten zu haben, sondern die relevanten Informationen schnell und zuverlässig herauszufiltern. Dies ist insbesondere beim Erkennen von sogenannten Hotspots, also kritischen Codestellen, deren Laufzeitanteil die Performance maßgeblich beeinflusst, von großer Bedeutung.

Ein aktuelles Beispiel illustriert diese Problematik eindrucksvoll: Der Performance Profile Visualization Challenge, bei dem es darum geht, eine einzelne Zeile Code innerhalb eines komplexen Systems zu identifizieren, die für 90 Prozent der Laufzeit verantwortlich ist. Dieses Szenario ist extrem, aber zeigt zugleich, wie schwierig die schnelle Lokalisierung von Bottlenecks sein kann, selbst wenn sie offensichtlich sind. Eine Besonderheit dieses Falles ist, dass die Software in Zig geschrieben ist – eine Sprache, die vielen Entwicklern noch weniger vertraut ist. Dies bedeutet zusätzlich, dass konventionelle Profiling-Tools und -Methoden nicht ohne weiteres zu greifen scheinen. Gleichzeitig erschwert die ungewohnte Build- und Testumgebung die Verwendung bekannter Analysewerkzeuge.

Bei der Herausforderung helfen herkömmliche Profiler nur bedingt weiter, da sie meist eine Vielzahl von Detailinformationen generieren, ohne eine klare Priorisierung oder visuelle Hervorhebung der wichtigsten Problemstellen. Die Folge ist, dass Entwickler oft viel Zeit in die Analyse investieren müssen, um selbst zwischen Signal und Rauschen unterscheiden zu können. Die Frage, die sich daraus ergibt, lautet: Gibt es eine Methode oder ein Tool, das diesen Prozess radikal beschleunigt? Im vorgestellten Beispiel zeigte sich, dass der Ausschalt des problematischen Codes quasi sofort einen enormen Performance-Gewinn brachte, nämlich eine Reduktion der Laufzeit um das Zehnfache. Das bedeutet, dass der gesamte Engpass praktisch auf eine einzige Zeile zurückzuführen war. Ein ideales Profiling-Tool müsste also genau jene Zeile klar sichtbar machen und so eine schnelle Reaktion ermöglichen.

Die Realität sieht oft anders aus: Die Dauer bis zur Identifikation des Bottlenecks kann Stunden oder sogar Tage betragen, insbesondere wenn keine priortisierten oder visuell verdaulichen Reports vorliegen. Die Analyse im vorgestellten Setup beginnt mit dem Klonen eines Opensource-Repositories, dem Kompilieren des Codes mit Zig und dem Ausführen eines Testsystems namens Cluster. Ein Lauf dieses Tests dauert initial über zwei Minuten, was für Entwickler bei wiederholter Ausführung bereits spürbar zeitraubend ist. Die Identifikation eines einzigen, leicht veränderten Codeteils führte zu einer dramatischen Verbesserung – die Laufzeit sank auf nur noch wenige Sekunden. Dies wirft die Frage auf, ob die derzeitigen Profiling-Tools am Markt eigentlich dafür ausgelegt sind, solche Knackpunkte schnell zu erkennen, oder ob es an einer neuen Herangehensweise mangelt.

Ein wichtiger Aspekt bei der Lösung könnte die Verwendung von Performance Profile Visualizations sein, die es ermöglichen, Daten nicht nur in rohen Zahlen angezeigt zu bekommen, sondern in leicht verständlichen grafischen Formen. Solche Visualisierungen können beispielsweise in Form von Flame Graphs, Call Graphs oder Heat Maps erfolgen, die zeitlichen Aufwand und Hotspots in der Codebasis deutlich hervorheben. Bei der Nutzung solcher Visualisierungstools ist es wichtig, dass der Entwickler nicht überfordert wird. Die Menge der aufgezeichneten Daten muss sinnvoll gefiltert und geclustert werden, um ein 'Big Picture' zu bieten und schließlich auf eine oder wenige relevante Codezeilen einzugrenzen. Dabei sollten neben der quantitativen Analyse auch qualitative Faktoren berücksichtigt werden, etwa der Kontext des Codes oder typische Nutzungsmuster.

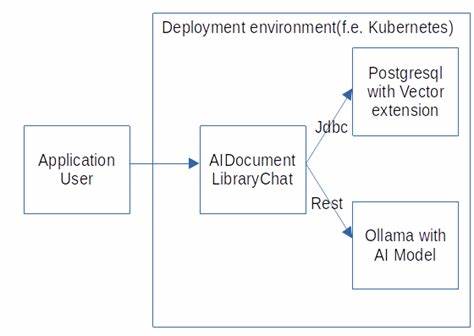

Ein weiterer Erfolgsfaktor bei der Profiling-Analyse ist die Automatisierung. Ein Tool, das mit aktuellen Run-Time-Daten arbeitet und ohne großen manuellen Eingriff präzise Engpässe aufzeigt, kann den Entwicklungsprozess deutlich effizienter machen. Besonders in kontinuierlichen Integrationsprozessen in der agilen Softwareentwicklung könnte eine solche Lösung den Weg zu performanteren Anwendungen ebnen. Zusätzlich erweist sich die Fähigkeit, auch in weniger bekannten Programmiersprachen wie Zig schnell und ohne aufwändige Anpassungen aussagekräftige Profildaten zu erzeugen, als wichtiger Faktor. Dies setzt flexible und anpassungsfähige Laufzeit-Inspection-Technologien voraus, die nicht zu tiefgreifende Modifizierungen der Testumgebung erfordern.

Neben den technischen Herausforderungen steht die Frage im Raum, wie Entwickler lernen, mit den umfangreichen Profildaten besser umzugehen. Ein geübter Blick für Muster, kombiniert mit modernen Visualisierungsansätzen, kann hier die Effizienz enorm steigern. Hilfreich ist es, wenn Tools Möglichkeiten bieten, die Daten interaktiv zu durchforsten, zwischen verschiedenen Aggregationsebenen zu wechseln und problematische Codeabschnitte direkt mit Quellcode-Editoren zu verknüpfen. Im Rückblick auf den Performance Profile Visualization Challenge zeigt sich, dass trotz modernster Werkzeuge der menschliche Faktor nach wie vor eine Rolle spielt. Das bewusste Fokussieren auf die richtigen Metriken, kombinatorisches Denken und die Bereitschaft, unbekannte Werkzeuge zu ergründen, sind Voraussetzung für schnelle Fortschritte.

Schließlich lässt sich festhalten, dass effizientes Profiling weit mehr erfordert als reine Datenerfassung. Es braucht smarte Visualisierungen und automatisierte Analysemechanismen, die dem Menschen helfen, den entscheidenden Engpass blitzschnell zu entdecken – selbst dann, wenn dieser nur aus einer einzigen Codezeile besteht. Damit gewinnen Entwickler Zeit, verbessern die Codequalität und schaffen Software, die nicht nur funktioniert, sondern auch performant und skalierbar ist. Die Zukunft der Softwareentwicklung wird dadurch maßgeblich mitbestimmt, wie gut diese Profiling-Herausforderungen gemeistert werden.