In den letzten Jahren haben große Sprachmodelle, sogenannte Large Language Models (LLMs), die Landschaft der Künstlichen Intelligenz und des Natural Language Processing fundamental verändert. Durch ihre Fähigkeit, umfangreiche Texte zu verstehen und zu generieren, unterstützen sie Anwendungen von maschineller Übersetzung über Textzusammenfassungen bis hin zu kreativen Schreibassistenzen. Dennoch bleiben Herausforderungen bestehen, insbesondere wenn es darum geht, diese Modelle auf Edge-Geräten mit begrenzten Ressourcen zu nutzen. Edge-Geräte, von Smartphones bis hin zu IoT-Systemen, verlangen immer öfter lokale Verarbeitung, um Latenzzeiten zu reduzieren und Datenschutz zu gewährleisten. Hier setzt das AccLLM-Projekt an, das durch ein ausgeklügeltes Zusammenspiel von Algorithmen und Hardware die Effizienz der LLM-Ausführung mit langen Kontexten revolutioniert.

Das Hauptproblem bei der Ausführung von LLMs auf Edge-Geräten liegt in der enormen Rechenleistung und dem hohen Speicherbedarf, vor allem wenn lange Eingabesequenzen verarbeitet werden sollen. Die klassische autoregressive Textgenerierung führt zu einem exponentiellen Anstieg des Rechen- und Speicheraufwands, was herkömmliche Geräte an ihre Grenzen bringt. AccLLM begegnet diesen Schwierigkeiten mit einem ganzheitlichen Ansatz, der sowohl algorithmische Optimierungen als auch maßgeschneiderte Hardwarelösungen integriert, um die Performance und Energieeffizienz signifikant zu steigern. Algorithmen sind die Seele von AccLLM. Zunächst sorgt eine intelligente Pruning-Technik dafür, dass nicht relevante oder redundante Teile des Modells abgeschnitten werden, ohne dass dabei die Genauigkeit bei der Textverarbeitung stark leidet.

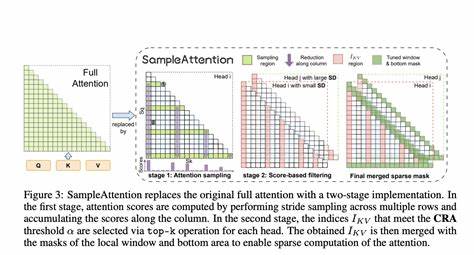

Diese gezielte Reduzierung des Modells minimiert den Rechenaufwand und den Speicherbedarf, was gerade für den Betrieb auf Edge-Geräten von entscheidender Bedeutung ist. Darüber hinaus integriert AccLLM das innovative Konzept der Λ-förmigen beziehungsweise Lambda-förmigen Aufmerksamkeit – eine Weiterentwicklung der klassischen Selbstaufmerksamkeit, die speziell darauf ausgelegt ist, bei langen Sequenzen die Komplexität der Berechnungen zu reduzieren, ohne wesentliche Informationen zu verlieren. Diese neue Art von Aufmerksamkeit ermöglicht eine effizientere Kontextverarbeitung, was besonders bei der Handhabung langer Texte hilft, die sonst durch enormen Kosten in Speicher und Laufzeit geprägt sind. Ein weiterer Meilenstein ist die Einführung eines neuartigen Quantisierungsschemas namens W2A8KV4, das heißt, die Gewichte werden mit 2-Bit, die Aktivierungen mit 8-Bit und der Key-Value-Cache mit 4-Bit dargestellt. Diese aggressive aber wohlüberlegte Quantisierung reduziert den Speicherverbrauch drastisch und ermöglicht schnellere Datenbewegungen zwischen Speicher und Recheneinheiten.

Auf diese Weise kann das Modell mit minimalen Genauigkeitsverlusten aufwändige Berechnungen mit geringerem Ressourcenverbrauch durchführen. Diese algorithmischen Innovationen finden ihre perfekte Ergänzung auf der Hardwareseite. AccLLM setzt auf einen speziell entwickelten FPGA-basierten Beschleuniger, der mit einer rekonfigurierbaren Recheneinheit ausgestattet ist, um flexibel auf die verschiedenen Anforderungen der Kompressionsverfahren und der Attention-Mechanismen zu reagieren. FPGA (Field Programmable Gate Array) bietet hier den Vorteil, dass Hardwarelogik dynamisch an unterschiedliche Algorithmen angepasst werden kann, was eine optimale Balance zwischen Performance, Energieeffizienz und Flexibilität erlaubt. Das FPGA-basierte Design erlaubt eine präzise Abstimmung auf das Quantisierungsschema und die Λ-förmige Aufmerksamkeit, wodurch alle algorithmischen Einsparungen direkt in gesteigerte Hardwareeffizienz umgesetzt werden.

Die Kombination aus hoher Parallelität und maßgeschneiderter Datenpfadgestaltung minimiert den Overhead und erlaubt eine deutliche Beschleunigung der LLM-Inferenz auf langen Kontexten. Die Ergebnisse sprechen für sich: In Vergleichstests mit dem aktuellen Stand der Technik, etwa gegenüber FlightLLM, zeigt AccLLM eine Steigerung der Energieeffizienz um mehr als das Vierfache bei einer nahezu verdreifachten Durchsatzrate. Diese Benchmarks wurden auf einem Xilinx Alveo U280 FPGA durchgeführt, der als Plattform die praktischen Vorteile der Co-Design-Philosophie eindrucksvoll unterstreicht. Die Kombination aus algorithmischer Kompression und flexibler, spezieller Hardware schafft damit die Grundlagen für den Einsatz von LLMs in Bereichen, die bisher wegen ihrer Ressourcenbeschränkungen als nicht praktikabel galten. Die Bedeutung von AccLLM für die Zukunft von KI-Anwendungen auf Edge-Geräten kann kaum überschätzt werden.

Durch die Ermöglichung langfristiger Kontextverarbeitung bei geringem Ressourcenverbrauch öffnet sich der Weg für eine Vielzahl neuer Anwendungen in Echtzeitkommunikation, personalisierten Assistenten, Augmented Reality und anderen Bereichen, in denen schnelle, lokale Verarbeitung von natürlicher Sprache entscheidend ist. Der Aspekt des Datenschutzes profitiert ebenfalls enorm, da lokal ausgeführte Modelle sensible Daten vor der Übertragung in die Cloud schützen und so Sicherheitsrisiken minimieren. Ein weiterer spannender Punkt ist das Potenzial der Technologie, sich auf andere Arten von neuronalen Netzwerken und Anwendungen zu übertragen. Die Prinzipien der quantitativen Reduktion, Strukturierung der Aufmerksamkeit und hardwareseitiger Flexibilität können auch in Bildverarbeitung, multimodalen Modellen und weiteren Bereichen Wirkung zeigen. AccLLM ist ein leuchtendes Beispiel dafür, wie das Zusammenspiel von Algorithmen und Hardwareentwicklung zu einer grundlegenden Beschleunigung und Verbesserung moderner KI-Systeme auf praktisch relevanten Plattformen führt.

Während die Herausforderungen bei der Umsetzung großer Sprachmodelle auf ressourcenarmen Geräten weiterhin bestehen, liefert der kooperative Ansatz von AccLLM dabei Lösungen, die nicht nur die Rechenleistung maximieren, sondern auch den Energieverbrauch minimieren – eine Voraussetzung für nachhaltige, skalierbare KI im Alltag. Die Zukunft der KI auf Edge-Geräten wird entscheidend von solchen innovativen Co-Design-Frameworks geprägt sein, die durch enge Verzahnung von Algorithmus-Optimierungen und spezialisierter Hardware neue Leistungsdimensionen erschließen und damit den Einsatzbereich komplexer Sprachmodelle erheblich erweitern. Zusammenfassend lässt sich sagen, dass AccLLM durch seine ganzheitliche Herangehensweise eine neue Ära in der Langkontext-LLM-Inferenz einläutet. Die Kombination von intelligentem Pruning, innovativer Lambda-Aufmerksamkeit und fortschrittlicher Quantisierung auf FPGA-Basis stellt eine bahnbrechende Lösung für das Dilemma zwischen Leistungsfähigkeit und Ressourcenverbrauch dar. Die zu erwartenden Auswirkungen auf unterschiedlichste Branchen zeigen, wie technologische Integration endgültig dazu beiträgt, das volle Potenzial von Large Language Models auch auf kleinen, aber allgegenwärtigen Geräten auszuschöpfen.

Damit wird die Vision einer dezentralisierten, effizienten und hochperformanten KI in greifbare Nähe gerückt – ein Meilenstein auf dem Weg zu einem intelligenten, vernetzten digitalen Zeitalter.