Das Model Context Protocol, bekannt als MCP, ist eine vielversprechende Open-Source-Initiative von Anthropic, die darauf abzielt, KI-Assistenten nahtlos mit verschiedenen Datenquellen und Werkzeugen zu verbinden. Die Idee hinter MCP ist, eine Art universelle Schnittstelle zu schaffen, die es erlaubt, große Sprachmodelle wie Claude oder Cursor flexibel mit APIs und anderen Anwendungen interagieren zu lassen. Bisher erinnert MCP an eine verbesserte Version des Plugin-Stores, den ChatGPT seit 2023 mit langer Warteliste anbietet. Die offene Natur von MCP macht es für Entwickler attraktiv, da ein einmal erstellter MCP-Server mit verschiedenen LLM-Anwendungen kompatibel ist und so ein breites Einsatzspektrum ermöglicht. Dennoch zeigt sich in der Praxis eine entscheidende Schwäche: MCP bietet keine integrierten UI-Komponenten, die für eine benutzerfreundliche Interaktion mit den verbundenen Tools essenziell wären.

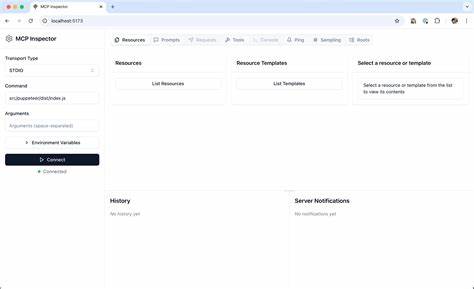

Zur Verdeutlichung dieser Problematik lohnt sich ein praktisches Beispiel eines MCP-Servers, der eine Anbindung an Jira realisiert – einem weit verbreiteten Werkzeug für Aufgabenmanagement und Kollaboration im Unternehmensumfeld. Der Entwickler dieses Servers ermöglichte es, aktuelle Tickets einzusehen und Kommentare zu bestehenden Tickets hinzuzufügen. Die technische Umsetzung war erstaunlich unkompliziert, da der MCP-Server im Wesentlichen nur einige Jira-API-Routen in das MCP-Protokoll eingebettet hat. Die Verbindung funktionierte reibungslos, und das große Potenzial des Protokolls wurde deutlich. Trotzdem offenbarten sich im Umgang mit dem System deutliche Schwächen bei der Nutzeroberfläche.

Die Darstellung war wenig intuitiv, wichtige Informationen wie der Kommentar mussten umständlich durch horizontales Scrollen in einem kleinen Fenster sichtbar gemacht werden. Textfelder, Buttons oder übersichtliche Kartenansichten wurden nicht unterstützt, sodass Benutzerfreundlichkeit und Effizienz leiden. Dies macht den Kern des Problems deutlich: Ohne UI-Komponenten innerhalb von MCP ist das Nutzererlebnis in vielen Szenarien unbefriedigend. Warum ist das Fehlen von UI-Komponenten im MCP-Protokoll so gravierend? Im Zeitalter moderner KI-Anwendungen, die sich meist in Form von Chatbots präsentieren, sind visuelle und interaktive Elemente unerlässlich, um komplexe Aufgaben übersichtlich zu gestalten. Nutzer möchten nicht nur reine Textinformationen konsumieren, sondern oft über Buttons Aktionen auslösen, über Textfelder Eingaben korrigieren oder über Kartenübersichten relevante Daten fokussiert betrachten.

Diese Komponenten ermöglichen es, die Interaktion so zu strukturieren, dass Nutzer schneller und präziser mit den zugrundeliegenden Daten und Funktionen arbeiten können. Ohne solche Elemente bleibt der Umgang mit integriertem Content oft umständlich und wenig produktiv. Betrachtet man die Entwicklerperspektive, so stellt MCP zwar eine große Vereinfachung dar, indem es standardisiert, wie KI-Modelle und verschiedene Tools kommunizieren. Das Protokoll definiert Strukturen, die etwa Informationen über Ressourcen und Werkzeuge getrennt halten. Allerdings liegt gerade hier eine weitere Herausforderung: Die Trennung von Tools und Ressourcen allein reicht nicht aus, um den Anforderungen moderner User Interfaces gerecht zu werden.

Während APIs vielfach reine Daten liefern, bedarf es einer Beschreibungs- und Rendering-Logik, die deutlich über die reine Datenkommunikation hinausgeht. MCP müsste daher um Spezifikationen erweitert werden, die eine deklarative Definition von UI-Komponenten erlauben – von einfachen Eingabefeldern bis zu komplexen interaktiven Karten oder Schaltflächen. Diese UI-Komponenten könnten optional implementiert werden, um Flexibilität zu garantieren. Für einfache Anwendungsfälle reichen vielleicht die bestehenden textbasierten Schnittstellen aus. Für komplexere Anwendungen, besonders im beruflichen Umfeld, sind ansprechende UI-Elemente jedoch ein entscheidender Vorteil.

Dabei könnten Entwickler oder MCP-Server-Hosts eigene UI-Frameworks oder Standards definieren, die von Clients wie Claude oder Cursor interpretiert und dargestellt werden. Dies würde nicht nur die Nutzerzufriedenheit steigern, sondern auch die Akzeptanz von MCP-basierten Tools erheblich erhöhen. Verglichen mit klassischen API-Integrationen, die sich über OpenAPI-Spezifikationen und HTTP-Anfragen realisieren lassen, liefert MCP ein interessantes Konzept, indem es LLM-Anwendungenlaufzeit Flexibilität bietet. Die KI kann dynamisch auf unterschiedliche Tools zugreifen, ohne dass die Entwickler von LLM-Apps ihre Produkte für feste APIs anpassen müssen. Dennoch bleibt eine wichtige Frage: Braucht es deswegen ein eigenes Protokoll? Kritiker argumentieren, dass das MCP-Protokoll zusätzlichen Aufwand mit sich bringt, weil für jedes Tool ein eigener Server aufgebaut werden muss.

Für spezielle Werkzeuge, wie etwa lokale Software (Blender als 3D-Modellierungssoftware oder Ableton für Musikproduktionen) macht dies Sinn, da dort APIs oft gänzlich fehlen. Für etablierte Systeme wie Task-Management-Plattformen oder Cloud-Services existieren hingegen oftmals gut dokumentierte APIs, die direkt nutzbar wären. Trotzdem darf man nicht unterschätzen, dass einige große Player wie OpenAI und Google Konzepte des MCP inzwischen adaptieren. Das deutet darauf hin, dass MCP oder Protokolle mit ähnlichem Ansatz eine Zukunft haben könnten. Die Frage des fehlenden UI-Elements bleibt dennoch offen und ist für das Nutzererlebnis und die Marktdurchdringung von entscheidender Bedeutung.

Während die technische Anbindung an Datenquellen funktioniert, entscheidet heute fast immer das UI über die Benutzerfreundlichkeit von Produkten – vor allem, wenn unterschiedliche KI-Modelle auf ähnliche Daten zugreifen können. Gute UI-Komponenten heben ein Produkt von der Konkurrenz ab, vereinfachen komplexe Informationen und ermöglichen eine effizientere Zusammenarbeit zwischen Mensch und Maschine. Von einer technischen Perspektive aus gesehen, könnten Frameworks wie Vercels AI SDK erste Vorstöße in Richtung UI-Unterstützung bieten – jedoch fehlen auch hier noch umfassende Standards innerhalb des MCP-Ökosystems. Die Entwicklergemeinschaft tut gut daran, über diese Lücke nachzudenken und Ideen für modular einsetzbare, flexible UI-Komponenten zu fördern. Gerade die Kombination aus Open-Source-Protokoll und der steigenden Qualität von Sprachmodellen eröffnet viele Möglichkeiten, das Nutzererlebnis durch visuelle und interaktive Elemente auf das nächste Level zu heben.