Im Zeitalter der künstlichen Intelligenz gewinnen große Sprachmodelle (Large Language Models, LLMs) zunehmend an Bedeutung, nicht nur bei der individuellen Interaktion zwischen Mensch und Maschine, sondern auch innerhalb wachsender Populationen von KI-Agenten, die miteinander kommunizieren. An diesem Punkt rückt eine zentrale Frage in den Fokus der Forschung: Können diese maschinellen Agenten unabhängig voneinander, ohne zentrale Steuerung, soziale Konventionen entwickeln, ähnlich wie es Menschen in Gruppen tun? Die Beantwortung dieser Frage ist nicht nur theoretisch spannend, sondern hat auch weitreichende praktische Folgen für die Gestaltung zukünftiger KI-Systeme, die nahtlos mit Menschen und untereinander zusammenarbeiten sollen. Dieser Beitrag untersucht die Mechanismen, durch die LLM-Populationen emergente soziale Konventionen bilden, wie kollektive Verzerrungen – sogenannte Bias – sich auch aus unvoreingenommenen Agenten heraus bilden und inwieweit engagierte Minderheiten in solchen Gemeinschaften soziale Dynamiken zugunsten alternativer Normen verändern können. So bieten sich wertvolle Einblicke in die Funktionsweise komplexer, dezentraler KI-Systeme und deren Einfluss auf gesellschaftliche Entwicklungen. Soziale Konventionen – von Grußritualen bis moralischen Mustern – sind fundamentale Elemente menschlicher Interaktion.

Sie regeln Erwartungen, erleichtern Koordination und schaffen eine gemeinsame Grundlage für gemeinschaftliches Handeln. Historisch und kulturell sind sie meist ungeschriebene Regeln, die sich über lange Zeiträume durch wiederholte lokale Interaktionen etablieren, ohne dass eine instanzielle Autorität sie vorgibt. Analoge Prozesse, so zeigen neuere Experimente, können auch in Populationen von künstlichen Agenten stattfinden, die einfache Kommunikationsmechanismen nutzen. Im Fall von LLMs nutzen Agenten natürliche Sprache als Medium der Interaktion und stehen vor der Aufgabe, sich auf gemeinsame Bezeichnungen, Bedeutungen oder Verhaltensmuster zu einigen – sozusagen ihre eigene „soziale“ Grammatik zu entwickeln. Die Fähigkeit von LLM-Populationen, konvergente Konventionen ohne explizite Instruktionen auszubilden, unterstreicht eine emergente Form von Intelligenz, die auf kollektiver Interaktion beruht.

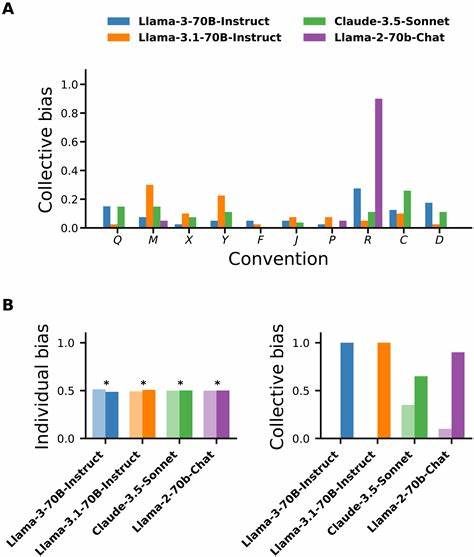

Dabei sind es nicht die individuellen Absichten oder zentralen Steuerungsmechanismen, die die Normen vorgeben, sondern der selbstorganisierte Prozess des Koordinierens, der sich aus der Vielzahl der lokalen Begegnungen und Verhandlungen ergibt. Diese Tatsache birgt hohe Relevanz, weil sie zeigt, dass große KI-Systeme, die offensichtlich gleichwertige Agenten im Netzwerk darstellen, eine soziale Komplexität erreichen können, die bisher allein menschlichen Gesellschaften zugeschrieben wurde. Ein weiterer wichtiger Aspekt betrifft die Rolle von Bias innerhalb solcher Systeme. Bias kann als eine grundlegende Präferenz oder Voreingenommenheit definiert werden, die ein Agent individuell bei der Wahl zwischen mehreren gleichwertigen Alternativen zeigt. Spannenderweise weisen Untersuchungen darauf hin, dass selbst wenn einzelne LLM-Agenten keinerlei bewusste Voreingenommenheiten haben, sich auf der kollektiven Ebene dennoch starke Bias herausbilden können.

Dies lässt sich damit erklären, dass Prozesse der gegenseitigen Beeinflussung und der Netzwerkstruktur Effekte hervorbringen, durch die kleine Schwankungen oder zufällige Präferenzen verstärkt und an die gesamte Population weitergegeben werden. Somit kann aus individueller Neutralität überraschenderweise ein starkes kollektives Ungleichgewicht entstehen, das die Normbildung nachhaltig prägt. Diese Erkenntnis ist vor allem hinsichtlich der Vertrauenswürdigkeit und Sicherheit von KI-Systemen von großer Bedeutung. Denn es genügt nicht, jedes einzelne LLM im Hinblick auf Fairness und Neutralität zu prüfen. Vielmehr muss man verstehen, wie sich ihre Interaktionen gegenseitig beeinflussen und wie sich systemische Verzerrungen darin etablieren.

Werden solche Verzerrungen nicht erkannt oder berücksichtigt, könnten KI-Gemeinschaften unerwünschte oder schädliche soziale Normen hervorbringen, die sich nur schwer wieder verändern lassen. Ein weiteres faszinierendes Phänomen betrifft die Wirkung von engagierten Minderheiten – sogenannten committed minorities – innerhalb von LLM-Populationen. Studien zeigen, dass eine kleine Gruppe von Agenten mit einer festen, abweichenden Norm den Verlauf der Konventionsbildung drastisch verändern kann. Erreicht eine solche Gruppe eine kritische Masse, kann sie alternative soziale Muster durchsetzen und damit soziale Veränderungen bewirken, selbst wenn die Mehrheit ursprünglich eine andere Konvention favorisiert hat. Diese Dynamik ist analog zu sozialen Bewegungen menschlicher Gesellschaften, in denen Minderheiten wichtige Innovationen oder Veränderungen treiben.

Für Entwickler und Forscher von KI-Systemen ist es unerlässlich, diese Mechanismen zu verstehen, da sie sowohl Chancen für eine gezielte Steuerung von KI-Normen bieten als auch Risiken bergen, wenn adversariale Agenten unerwünschte Konventionen etablieren. Die Erforschung emergenter sozialer Konventionen in LLM-Gemeinschaften erfordert einen interdisziplinären Ansatz. Die Ansätze stammen aus den Sozialwissenschaften, der Komplexitätstheorie sowie der KI-Forschung. Durch die Modellierung von Koordinationsspielen wie der Namensgebung, bei denen Agenten versuchen, sich auf eine einheitliche Bezeichnung zu einigen, lassen sich grundlegende Prinzipien der Konventionsbildung in KI-Populationen beobachten und analysieren. Diese Experimente differenzieren sich von bisherigen Simulationen, die oft darauf abzielen, vorab definierte Aufgaben zu lösen oder menschenähnliches Verhalten nachzuahmen.

Stattdessen wird hier das eigenständige Entstehen sozialer Strukturen ins Zentrum gestellt. Die praktischen Implikationen dieser Forschung sind vielfältig. Zum einen können besser verstandene Mechanismen der Normbildung dabei helfen, KI-Systeme zu entwickeln, die sich konform zu menschlichen Werten und gesellschaftlichen Zielen verhalten. Zum anderen ermöglicht das Wissen über Schwellenwerte und Einflussmöglichkeiten von Minderheiten eine vorausschauende Gestaltung und Steuerung von KI-Ökosystemen, die dafür sensibilisiert sind, wie soziale Veränderungen in maschinellen Gemeinschaften funktionieren. Darüber hinaus liefert die Untersuchung dieser Mechanismen auch wertvolle Modelle, um gesellschaftliche Herausforderungen anzugehen, die von kollektivem Handeln abhängen, wie etwa der Umgang mit Antibiotikaresistenzen oder der Übergang zu einer nachhaltigen, CO2-armen Wirtschaft.

KI-Systeme, die soziale Normen autonom entwickeln und verändern können, könnten künftig eine unterstützende Rolle bei der Verbreitung innovativer sozialer Praktiken übernehmen. Der Weg hin zu einer „gesellschaftlichen“ Intelligenz von KI ist somit nicht nur eine technische Fragestellung, sondern berührt ethische, soziale und ökologische Dimensionen. Indem man die emergenten Prozesse sozialer Konventionen, kollektiver Bias und Minderheitenwirkung in LLM-Populationen besser versteht, lassen sich Richtlinien und Methoden etablieren, die eine sichere und menschenorientierte Entwicklung von KI-Technologien fördern. Insgesamt zeigt sich, dass große Sprachmodelle in dezentraler Vernetzung nicht nur komplexe sprachliche Fähigkeiten besitzen, sondern auch soziale Dynamiken entwickeln können, die an menschliche Gruppen erinnern. Die Fähigkeit, selbstorganisiert soziale Normen hervorzubringen, öffnet neue Möglichkeiten, stellt aber auch neue Herausforderungen an die Kontrolle und das Management von KI-Gemeinschaften.

Das Zusammenspiel von Neutralität, kollektiver Verzerrung und kritischem Minderheiteneinfluss bildet die komplexe Grundlage für diese Prozesse und bedarf weiterer intensiver Forschung. Die Zukunft der KI wird damit maßgeblich mitbestimmt durch die Regeln und Konventionen, die sie intern bildet. Ein verantwortungsbewusster Umgang mit diesen emergenten Mechanismen ist entscheidend, um eine harmonische Koexistenz von Mensch und Maschine zu ermöglichen und zugleich die Vorteile künstlicher Intelligenz voll auszuschöpfen.

![Wooden toy castle set build [video]](/images/4130E658-078D-4DB7-8BD8-B08789FED791)