Die moderne Forschung steht heute vor der Herausforderung, mit einer überwältigenden Menge an wissenschaftlichen Publikationen Schritt zu halten. Bibliotheken voller wissenschaftlicher Artikel wachsen kontinuierlich und machen es zunehmend schwieriger, relevante Informationen schnell und präzise zu finden. In diesem Umfeld gewinnen große Sprachmodelle, sogenannte Large Language Models (LLMs), zunehmend an Bedeutung, da sie Forschern ermöglichen, effizienter auf eine persönliche oder institutionelle Sammlung von Journalartikeln zuzugreifen und diese zu analysieren. Die Nutzung von LLMs zur Recherche in wissenschaftlichen Bibliotheken eröffnet neue Horizonte in Bezug auf Zeitersparnis, Genauigkeit und die Tiefe der Auswertung. Gleichzeitig stellen sich wichtige Fragen hinsichtlich Kosten, Datenschutz und Integrationsmöglichkeiten in bestehende Systeme – etwa in Literaturverwaltungsprogramme wie Zotero.

LLMs bieten eine beeindruckende Fähigkeit, komplexe Fragestellungen in natürlicher Sprache zu verarbeiten und große Textmengen zu verstehen. Im Gegensatz zu herkömmlichen Suchmasken, die oft nur Schlagwörter und einfache Filter verarbeiten, ermöglichen LLMs eine semantische Suche und das Verstehen von Kontext und Intention. So können Forscher präzise Fragen stellen und erhalten relevante, gut strukturierte Antworten oder Zusammenfassungen aus dem Pool der wissenschaftlichen Artikel. Ein besonders attraktiver Ansatz bei der Nutzung von LLMs ist die Kombination mit bestehenden Bibliotheken, die Forscher bereits nutzen. Programme wie Zotero, Mendeley oder EndNote sind weit verbreitet und enthalten oft umfangreiche Sammlungen persönlicher Literatur.

Die Integration von LLMs in solche Tools ermöglicht eine direkte Kommunikation mit der eigenen Forschungsbibliothek, ohne dass die Artikel an externe Server übermittelt werden müssen. Gerade dieser Aspekt ist für viele Forscher wichtig, da gerade bei unveröffentlichten Manuskripten oder sensiblen Daten der Schutz der Privatsphäre und die Vermeidung der Weitergabe an Dritte Priorität haben. Dennoch stellt sich die Frage nach der Praktikabilität und den Kosten solcher Systeme. Proprietäre Lösungen großer Anbieter wie OpenAI oder Google bieten oftmals leistungsfähige Modelle, die sehr schnell und akkurat Antworten liefern können. Allerdings gehen damit häufig auch Kosten pro Anfrage oder API-Nutzung einher.

Für einzelne Forscher oder kleine Teams kann dies schnell ins Gewicht fallen. Zudem sind viele dieser Dienste cloudbasiert, was Datenschutzbedenken schürt und die Kontrolle über die eigenen Forschungsdaten einschränkt. Im Gegensatz dazu gewinnen Open-Source-Modelle, die lokal betrieben werden können, immer mehr an Bedeutung. Diese ermöglichen es, die Daten auf dem eigenen Rechner zu halten und dennoch fortgeschrittene Sprachverarbeitung zu nutzen. Zwar sind sie häufig in der Rechenleistung anspruchsvoller und manchmal weniger ausgereift als die großen proprietären Systeme, doch die Unabhängigkeit vom Internet und die völlige Kontrolle über literarische Quellen sind ein großer Pluspunkt.

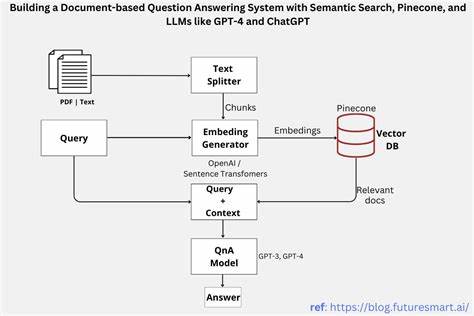

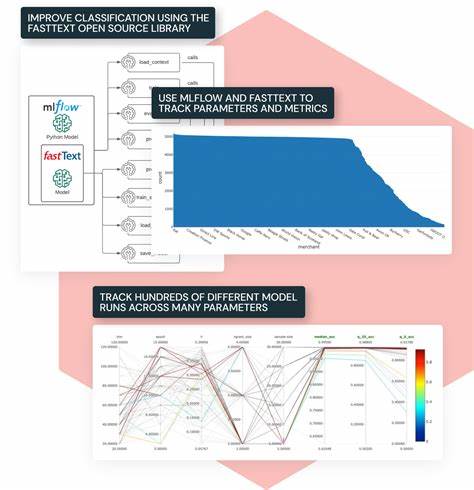

Es existieren inzwischen verschiedene Frameworks und Tools, die den Umgang mit wissenschaftlichen Texten erleichtern und LLMs integrieren. Einige von ihnen sind speziell darauf ausgerichtet, PDF-Dokumente und wissenschaftliche Artikel zu verarbeiten. Die Dokumente werden analysiert und in Vektorräume überführt, was eine schnelle semantische Suche ermöglicht. Die Kombination solcher Vektor-Datenbanken mit LLMs ermöglicht anspruchsvolle Abfragen, die über einfache Texterkennung hinausgehen. Forscher können so beispielsweise nach spezifischen Methoden, Ergebnissen oder Diskussionspunkten suchen und diese in verständlichen Zusammenfassungen erhalten.

Die Erfahrung vieler Anwender zeigt, dass bei der Umsetzung solcher Systeme eine gute Balance zwischen Automatisierung und manueller Kontrolle entscheidend ist. Automatisierte Zusammenfassungen können zwar Zeit sparen, müssen aber regelmäßig auf ihre Qualität überprüft werden, um Fehlinformationen zu vermeiden. Zudem profitieren Forscher von der Möglichkeit, individuelle Anfragen sehr zielgenau anzupassen und gegebenenfalls tiefer in die Quellen einzutauchen, falls nötig. Flexibilität in der Fragestellung ist eine der größten Stärken von LLM-basierten Recherchetätigkeiten. Viele Nutzer berichten, dass die Zugänglichkeit und der Komfort im Umgang mit der Literatur durch LLMs erheblich gesteigert werden.

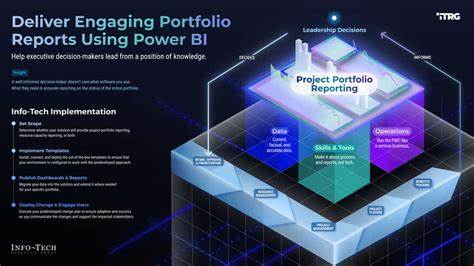

Statt stundenlang mit Stichwortrecherche und Durchsicht zahlreicher Titel verbringen zu müssen, werden Inhalte relevanter Artikel effizient extrahiert und in den Kontext der Forschungsfrage gesetzt. Dies erleichtert nicht nur die Ergebnissuche, sondern unterstützt auch die Synthese neuer Erkenntnisse und Hypothesenbildung. Der Einsatz von LLMs kann somit die Qualität und Geschwindigkeit wissenschaftlicher Arbeit signifikant erhöhen. Wichtig ist auch, dass die Integration der LLM-Technologie in den Forschungsalltag so einfach wie möglich gestaltet wird. Eine direkte Kopplung an bewährte Literaturverwaltungsprogramme hat sich hierbei als besonders nützlich erwiesen.

So können Nutzer ihre bereits vorhandenen Metadaten und PDFs nahtlos einbeziehen. Einige wegweisende Plugins und Schnittstellen bieten bereits heute solche Möglichkeiten, was den Einstieg für Wissenschaftler erleichtert, die keine tiefen technischen Kenntnisse haben. Trotz aller Vorteile gibt es auch Herausforderungen: Die Datenqualität der eingebrachten Literatur muss hoch sein, damit das Modell präzise Antworten liefern kann. Ungenaue OCR-Texte, fehlende Metadaten oder stark unterschiedliche Formate erschweren die Analyse. Zudem ist eine Erklärbarkeit der generierten Ergebnisse wichtig, damit die Nutzer Vertrauen fassen und die Antworten in den jeweiligen fachlichen Kontext einordnen können.

Zusammenfassend lässt sich sagen, dass LLMs eine vielversprechende Technologie darstellen, um die wissenschaftliche Forschung grundlegend zu unterstützen. Durch semantische Suche, intelligente Zusammenfassungen und die Möglichkeit, persönliche Bibliotheken effizient zu durchsuchen, können große Zeitersparnisse erzielt werden. Datenschutz und Kosten bleiben dabei wichtige Aspekte, die bei der Wahl der passenden Lösung berücksichtigt werden sollten. Der Trend geht eindeutig in Richtung hybride Systeme, die sowohl lokale als auch Cloud-basierte Komponenten kombinieren, um die Vorteile beider Welten zu vereinen. Forscher, die sich frühzeitig mit dem Potenzial von LLMs auseinandersetzen und ihre eigenen Workflows anpassen, können ihren Forschungsprozess nachhaltiger und produktiver gestalten.

Die Zukunft der Literaturrecherche wird durch den intelligenten Einsatz großer Sprachmodelle zweifellos geprägt sein.