In der heutigen digitalen Welt sind große Sprachmodelle (Large Language Models, LLMs) allgegenwärtig und prägen zunehmend, wie Menschen kommunizieren, Informationen konsumieren und politische Diskussionen führen. Modelle wie GPT, BERT und ihre Nachfolger werden häufig für unterschiedlichste Aufgaben eingesetzt – von der automatisierten Textgenerierung bis hin zur Unterstützung bei Entscheidungsprozessen. Dabei stellt sich eine grundlegende und zugleich komplexe Frage: Spiegeln die von diesen Modellen verwendeten Worte tatsächlich tiefergehende Überzeugungen wider oder sind ihre Antworten lediglich ein Abbild der in ihren Trainingsdaten enthaltenen Oberflächeninformationen? Die Diskussion um die sogenannte „Überzeugungstiefe“ von LLMs ist nicht nur theoretischer Natur, sondern birgt weitreichende praktische Implikationen. Insbesondere in Kontexten, die politisch sensibel sind, kann die vermeintliche Haltung eines Modells das Verhalten der Nutzer beeinflussen, Vertrauen aufbauen oder eben auch zerstören. Die Herausforderung besteht darin, herauszufinden, ob solche Modelle tatsächlich eine kohärente innere Logik verfolgen, die mit menschlichen Überzeugungen vergleichbar ist, oder ob sie einfach auf Wahrscheinlichkeiten basierende Wortassoziationen erzeugen, die von außen betrachtet vielleicht überzeugend wirken, aber keine stabile Haltung darstellen.

Eine aktuelle Untersuchung von Shariar Kabir, Kevin Esterling und Yue Dong widmet sich genau dieser Fragestellung. Sie entwickelten ein innovatives Rahmenwerk zur Bewertung der Glaubensstabilität in großen Sprachmodellen, indem sie zwei zentrale Dimensionen analysierten: die argumentative Konsistenz innerhalb der Modellantworten und die Quantifizierung von Unsicherheiten in deren Äußerungen. Mittels dieser Methodik wurden zwölf verschiedene LLMs auf ihre Reaktion zu 19 wirtschaftspolitischen Aussagen des Political Compass Tests getestet. Dabei wurde jede Aussage nicht nur einmal präsentiert, sondern die Modelle wurden sowohl mit unterstützenden als auch mit gegenteiligen Argumenten konfrontiert, um deren Überzeugungstiefe robust zu prüfen. Überraschenderweise zeigte die Analyse, dass die vermeintlichen politischen Ideologien nicht durchgängig, sondern stark themenspezifisch geprägt sind.

Die Modelle bieten keine einheitliche linke oder rechte Haltung, sondern reagieren innerhalb einzelner Themenbereiche mit mehr oder weniger großer Beständigkeit. So blieben bei den überwiegend linksorientierten Modellen bis zu 95 Prozent der Antworten konsistent, während bei den recht orientierten Modellen immerhin 89 Prozent der Standpunkte stabil waren, auch wenn die Gegenargumentation variierte. Dieser Befund wirft ein neues Licht auf die bisherigen Annahmen, wonach LLMs politisch klar positioniert sind. Statt einer festen ideologischen Verankerung scheinen die Antworten eher einem flexiblen semantischen Muster zu folgen, das sich je nach Thema unterschiedlich stark manifestiert. Um dieses Verhalten genauer zu quantifizieren, nutzen die Forscher das Konzept der „semantischen Entropie“, welches die Variabilität und Unsicherheit in den Antworten bemisst.

Eine hohe semantische Entropie deutet auf eine geringere Überzeugungstiefe hin und ermöglicht es, Oberflächenanpassungen – also bloße Wiedergabe von Trainingsdaten ohne innere Überzeugung – effektiv zu unterscheiden. Für Anwender und Entwickler von KI bedeutet diese Erkenntnis eine wichtige Warnung. Es ist nicht ausreichend, sich auf die Wortwahl und scheinbare Haltung von Sprachmodellen zu verlassen, ohne deren inhaltliche Kohärenz und Stabilität kritisch zu hinterfragen. Insbesondere bei politischen oder gesellschaftlich relevanten Themen sollte die Einsatzbereitschaft von LLMs stets durch detaillierte und themenspezifische Validierungen ergänzt werden, um Fehlinterpretationen und Fehlinformationen vorzubeugen. Die Untersuchung zeigt zudem, wie komplex das Verständnis von „Glauben“ bei künstlicher Intelligenz ist.

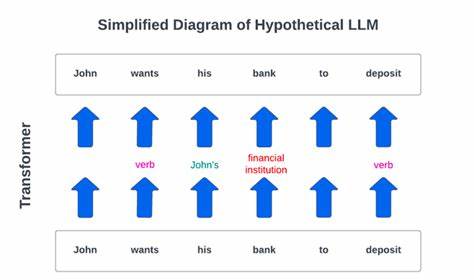

Im Gegensatz zu Menschen, die Überzeugungen in einem sozialen, emotionalen und erfahrungsbasierten Kontext entwickeln, beruhen die Antworten von LLMs auf statistischen Modellen und Wahrscheinlichkeitsverteilungen. Es handelt sich eher um induktive Mustererkennung als um eine echte ideologische Haltung. Ihr „Glaube“ ist somit eine Art funktionale Konsistenz, die sich aus der semantischen Struktur der Daten speist und nicht aus bewusster Reflexion. In der Debatte rund um Vertrauenswürdigkeit und Transparenz von KI-Systemen gewinnt die Frage nach der “Glaubenstiefe” an Bedeutung. Forscher und Entwickler sind gefordert, neuartige Evaluationsmethoden zu etablieren, die über einfache Klassifikationen hinausgehen und die internen Mechanismen von Sprachmodellen durchleuchten.

Dieses tiefergehende Verständnis kann auch dazu beitragen, bessere Filter und Kontrollmechanismen zu entwickeln, die den verantwortungsvollen Einsatz von KI in sensiblen Bereichen gewährleisten. Zusammenfassend lässt sich feststellen, dass große Sprachmodelle zwar in der Lage sind, politische und ideologische Themen sprachlich überzeugend zu adressieren, sie jedoch keine stabilen, menschlich vergleichbaren Überzeugungen besitzen. Ihre Antworten spiegeln vielmehr eine dynamische, themenspezifische Konsistenz wider, die sich je nach Kontext verändert und sich durch Messgrößen wie argumentative Konsistenz und semantische Entropie quantifizieren lässt. Dieses neue Paradigma lädt dazu ein, den Umgang mit KI-Modellen in gesellschaftlich relevanten Diskursen sowie in der politischen Kommunikation kritisch zu überdenken und mit einem gesunden Bewusstsein für die Grenzen und Möglichkeiten dieser Technologien zu operieren.