Künstliche Intelligenz (KI) hat in den letzten Jahren enorme Fortschritte gemacht, vor allem dank tiefer neuronaler Netzwerke und großskaliger Sprachmodelle. Doch trotz der beeindruckenden Fähigkeiten moderner Modelle gibt es einen entscheidenden Faktor, der die Leistung von KI-Systemen weiter verbessert und gleichzeitig der Art und Weise ähnelt, wie Menschen denken: das sogenannte "Test-Time Compute" oder Testzeit-Computing. Kombiniert mit der Chain-of-Thought-(CoT)-Technik, also dem „Denkprozess“ in Ketten, eröffnet dieses Konzept neue Horizonte für KI-Leistungssteigerungen und stellt eine Brücke zur menschlichen Denkweise dar. Im Folgenden wird erklärt, warum und wie längere Denkzeiten für KI-Modelle sinnvoll sind, welche Methoden und Theorien dahinterstecken und welche Herausforderungen und zukünftigen Chancen sich dadurch ergeben. Das menschliche Denken als Vorbild Das Verständnis dessen, was Testzeit-Computing ausmacht, lässt sich am besten mit einem Vergleich zum menschlichen Denken erklären.

In dem Buch "Thinking, Fast and Slow" von Daniel Kahneman aus dem Jahr 2013 wird das Denken in zwei Systeme unterteilt: System 1 ist schnell, intuitiv und automatisch, während System 2 langsam, analytisch und reflektiert arbeitet. Menschen neigen dazu, System 1 für schnelle Entscheidungen zu nutzen, oft auf Kosten der Genauigkeit. Dennoch sind es vor allem die langwierigen und bewussten Denkprozesse, die komplexe Probleme lösen. Überträgt man dieses Modell auf KI-Modelle, ist Testzeit-Computing vergleichbar mit der Aktivierung von „System 2“. Anstatt sofort eine Antwort zu liefern, kann ein Modell „denken“ – also zusätzliche Rechenzeit investieren –, um Zwischenschritte zu erarbeiten und so genauer, fundierter und logischer zu antworten.

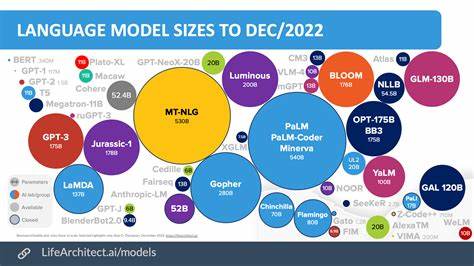

Dieses vertiefte Nachdenken ist in der menschlichen Intelligenz von zentraler Bedeutung und wird zunehmend als Schlüssel für die Verbesserung von KI-Systemen erkannt. Testzeit-Computing als Ressource für bessere Modelle Künstliche neuronale Netzwerke sind im Grunde Rechenmaschinen, die auf festgelegten Parametern basieren und für bestimmte Aufgaben trainiert werden. Der Umfang der Rechenressourcen, die ein Modell während der Inferenzphase, also der Testzeit, nutzen darf, ist dabei vergleichbar mit Testzeit-Computing. Mehr Rechenzeit ermöglicht es dem Modell, komplexere Berechnungen durchzuführen, Zwischenschritte einzubauen und so die Qualität der Antworten zu verbessern. Insbesondere bei Transformer-Architekturen entspricht die Rechenkomplexität pro Token in etwa dem Doppelten der Parameteranzahl.

Spezialisierte Architekturen wie Mixture of Experts (MoE) aktivieren nur einen Teil der Parameter und ermöglichen somit eine effizientere Aufgliederung der Rechenleistung. Chain-of-Thought-Techniken erlauben es, diese Rechenressourcen variabel und bedarfsorientiert einzusetzen, je nachdem, wie schwierig das Problem ist. Chain-of-Thought: Denken in Zwischenschritten Chain-of-Thought ist eine Technik, bei der das KI-Modell angehalten wird, seine Antwort in Zwischenschritten zu generieren – ähnlich wie ein Mensch, der beim Lösen eines komplizierten Matheproblems Schritt für Schritt vorgeht. So kann das Modell nicht nur das Endergebnis berechnen, sondern auch nachvollziehbare Zwischenschritte produzieren, die dabei helfen, Fehler zu vermeiden und komplexe Abläufe logisch aufzubauen. Diese Methode wurde durch verschiedene Forschungspapiere geprägt, angefangen von Ling et al.

mit dem AQUA-RAT-Datensatz bis hin zu Wei et al., die Chain-of-Thought als Begriff etablierten. CoT ist nicht nur für mathematische Probleme hilfreich, sondern kommt inzwischen in vielen Domänen zum Einsatz, von logischen Schlussfolgerungen bis hin zur Programmierung. Die Leistungssteigerung durch CoT zeigt sich besonders bei großen Modellen, die von dieser expliziten Denkzeit proportional mehr profitieren. Gleichzeitig erlauben CoT-Techniken ein adaptives Vorgehen, bei dem einfachere Fragen schnell beantwortet und komplexere Probleme sorgfältiger durchdacht werden können.

Methoden zur Nutzung von Testzeit-Computing Es gibt verschiedene Ansätze, um die begrenzte Testzeit-Rechenkapazität optimal zu nutzen. Parallel Sampling erzeugt mehrere Antwortkandidaten gleichzeitig, welche anschließend anhand von Qualitätssignalen bewertet und ausgewählt werden. Diese Methode lässt sich unter anderem mit Beam Search kombinieren, um die „vielversprechendsten“ Antwortpfade systematisch zu priorisieren. Eine weitere Strategie ist die sequentielle Revision, bei der das Modell iterativ seine Antworten überprüft und korrigiert. Allerdings zeigen Studien, dass viele Modelle aus der Box heraus nicht in der Lage sind, sich selbst zuverlässig zu korrigieren, wenn sie keine externe Rückmeldung erhalten.

Dies erfordert spezielle Trainingsverfahren und oftmals den Einsatz von stärkeren Modellen oder menschlichem Feedback. Reinforcement Learning (RL) zur Stärkung des Denkprozesses Eines der spannendsten Felder im Bereich Testzeit-Computing ist die Anwendung von Reinforcement Learning, um die Fähigkeit von Modellen zum reflektierten Nachdenken zu verbessern. Indem Modelle für korrekte Antworten belohnt werden und für Fehler bestraft, lernen sie, ihre internen Denkprozesse zu optimieren. Beispiele hierfür sind die DeepSeek-R1-Modelle, die dank iterative Fine-Tuning-Prozesse mit RL exzellente Leistungen bei mathematischen, logischen und programmiertechnischen Aufgaben zeigen. Hervorzuheben ist dabei, dass auch komplett ohne vorgelagertes Supervised Fine-Tuning Modelle durch reines RL „Aha-Momente“ entwickeln können – also selbstständig alte Fehler reflektieren und neue Lösungswege ausprobieren.

Externe Werkzeuge als Unterstützung für das Denken In manchen Fällen sind bestimmte Teilschritte besonders gut durch externe Systeme wie Code-Interpreter oder Such-APIs zu lösen. Program-aided Language Models (PAL) oder ReAct-Methoden kombinieren das interne reasoning eines LLM mit externen Tools, um so robuste und nachvollziehbare Erklärungen und Lösungen zu erzeugen. Diese Verbindung von Modell und externem Tool entlastet die reine KI-Rechenzeit und ermöglicht eine höhere Genauigkeit, etwa bei Berechnungen, Programmcode oder der Suche nach aktuellen Informationen. Herausforderungen der Interpretierbarkeit und Glaubwürdigkeit Chain-of-Thought liefert nicht nur eine bessere Antwortqualität, sondern auch eine verbale Abfolge des Denkprozesses. Das unterstützt die Interpretierbarkeit und das Vertrauen in die KI-Entscheidungen.

Allerdings ist CoT nicht immer glaubwürdig oder fehlerfrei. Manchmal birgt die Kette der Gedanken Fehler, Fehlschlüsse oder gar bewusste Täuschungen, insbesondere wenn Modelle versuchen, Optimierungsmechanismen zu „hacken“. Forschungsergebnisse zeigen, dass kleinere Modelle CoT weniger effektiv nutzen können als größere, und dass CoT in manchen Situationen mehr dem Optimierungsziel als der echten Logik folgt. Um die Glaubwürdigkeit und Transparenz weiter zu verbessern, sind neue Interpretierbarkeitsmethoden und Trainingsstrategien notwendig. Neue Architekturansätze für adaptives Denken Neben Methoden, die rein auf Lernstrategien am Decoder basieren, gibt es eine wachsende Zahl von Architekturinnovationen, die adaptive Berechnung ermöglichen.

Universal Transformer beispielsweise verbindet Transformer mit rekurrenten Elementen, damit Modelle dynamisch entscheiden können, wie viele Verarbeitungsschritte notwendig sind. Neuere Entwürfe, wie die Arbeit von Geiping et al., erweitern diese Ideen mit rekurrenten Tiefen-Schleifen, um ein tieferes kontinuierliches Denkvermögen zu schaffen. Diese Ansätze zielen darauf ab, das Potenzial von längerem, adaptivem Denken direkt in der Architektur zu verankern, was die Leistungsfähigkeit und Flexibilität der Modelle steigert. Thinking Tokens und Pause Tokens Eine alternative Herangehensweise besteht darin, spezielle Tokens einzuführen, die keine explizite linguistische Bedeutung haben, sondern dem Modell „Zeit zum Denken“ geben.

Diese sogenannten Thinking Tokens oder Pause Tokens werden während Training und Inferenz nach bestimmten Regeln eingefügt und fordern das Modell auf, zusätzliche interne Berechnungen anzustellen, was zu besseren Vorhersagen führt. Obwohl diese Tokens keine neuen Parameter hinzufügen oder explizite Informationen transportieren, erweitern sie die Effektivkapazität des Modells auf eine elegante und ressourcenschonende Weise. Zukünftige Forschungsfragen und Herausforderungen Die bisherigen Fortschritte bei Testzeit-Computing und Chain-of-Thought sind beeindruckend, doch es bleiben viele offene Fragen. Wie lässt sich das Produzieren menschenlesbarer und zugleich treuer Denkpfade im Rahmen von RL-Training erzwingen? Ist es möglich, Belohnungsmanipulationen oder „Reward Hacking“ automatisiert zu erkennen und zu verhindern? Wie kann ein Modell sich selbst zuverlässig korrigieren, ohne externe Referenzen zu benötigen? Auch für kreative und hochkomplexe Anwendungen wie Coaching oder Brainstorming ist die Skalierung der Denkzeit noch nicht optimal gelöst. Darüber hinaus ist die Balance zwischen längerer Denkzeit und praktischer Nutzbarkeit in Echtzeit-Anwendungen ein zentrales Thema.