In der Welt der Künstlichen Intelligenz erleben wir kontinuierlich innovative Fortschritte, die nicht nur die Art und Weise, wie Maschinen lernen, verändern, sondern auch Möglichkeiten eröffnen, sie in praktischen, realen Szenarien einzusetzen. Ein besonders faszinierender Bereich ist die Nutzung kleiner, leistungsfähiger AI-Modelle auf Edge-Geräten, also direkt am Ort der Datenentstehung wie IoT-Geräten, mobilen Endgeräten oder industriellen Anlagen. Hier erfüllt Phi-4-mini-reasoning, ein kompaktes Modell der Phi-4-Familie, eine Schlüsselrolle bei der Erweiterung von KI-Fähigkeiten dank seiner Kombination aus effizienter Architektur und gezielter Feinabstimmung für branchenspezifische Herausforderungen. Das Phi-4-mini-reasoning-Modell zeichnet sich durch eine überschaubare Größe von 3,8 Milliarden Parametern aus, die es ermöglicht, anspruchsvolle logische und mathematische Aufgaben auch auf Geräten mit begrenzter Rechenleistung durchzuführen. Dies macht es zu einer idealen Lösung für Anwendungen, die schnelle, zuverlässige Entscheidungen erfordern, ohne auf die Rechenpower großer Rechenzentren angewiesen zu sein.

Insbesondere in Industrieumfeldern, in denen Reaktionszeiten entscheidend sind und Netzwerkanbindung nicht immer gewährleistet ist, schlägt Phi-4-mini-reasoning eine Brücke zwischen Leistung und Effizienz. Die wachsende Bedeutung von Edge-Computing ergibt sich aus mehreren Faktoren. Erstens steigt die Menge der anfallenden Daten exponentiell an, sodass die Übertragung großer Datenmengen an zentrale Server ineffizient und oft nicht praktikabel ist. Zweitens erfordern viele industrielle Anwendungen, etwa in der Fertigung, Medizin oder Logistik, Echtzeitreaktionen, um Ausfälle zu vermeiden oder präzise Diagnosen zu ermöglichen. Drittens spielen Datenschutz und Sicherheit eine immer größere Rolle; das Verarbeiten sensibler Daten direkt vor Ort auf dem Edge-Gerät verringert Risiken und complies besser mit regulatorischen Anforderungen.

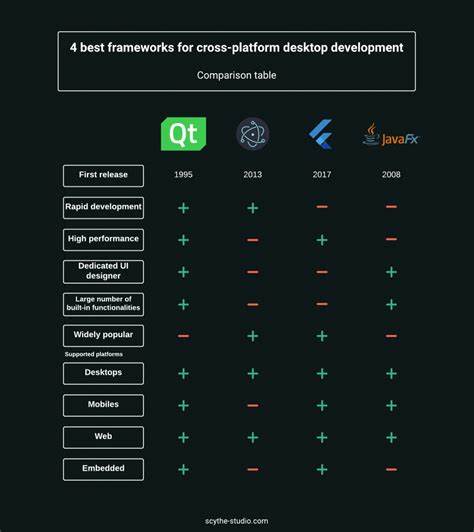

Um das volle Potenzial von Phi-4-mini-reasoning auf Edge-Geräten auszuschöpfen, ist es jedoch notwendig, das Modell entsprechend zu optimieren. Hier kommt die Quantisierung ins Spiel, ein Verfahren, das die Komplexität von neuronalen Netzwerken reduziert, indem es die genaue Repräsentation der Modellparameter mit geringerer Bitbreite kodiert. Microsoft Olive und Apple MLX Framework sind wegweisende Tools, die diese Quantisierung intelligent durchführen, um die Balance zwischen Rechenleistung und Genauigkeit zu maximieren. Durch diese Optimierung wird es möglich, selbst Modelle mit Milliarden von Parametern effizient auf IoT-Geräten, Smartphones oder kleinen Industriecomputern einzusetzen. Einzigartig an Phi-4-mini-reasoning ist die Möglichkeit, das Modell mit sogenannten Chain-of-Thought-Datensätzen (CoT) für spezifische Industrien weiterzuentwickeln.

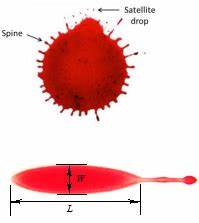

Chain-of-Thought-Finettuning verbessert das logische Denkvermögen einer KI, indem es ihr ermöglicht, komplexe Schlussfolgerungen Schritt für Schritt zu bilden – vergleichbar mit einem menschlichen Denkprozess. Dies ist insbesondere in Branchen wichtig, in denen Zusammenhänge zwischen medizinischen Symptomen, technischen Parametern oder betrieblichen Abläufen rausgearbeitet werden müssen. Das Beispiel aus dem medizinischen Bereich illustriert diese Erweiterung eindrucksvoll. Mit Hilfe von öffentlich verfügbaren medizinischen CoT-Datensätzen kann Phi-4-mini-reasoning darauf trainiert werden, komplexe Diagnosen oder Behandlungsvorschläge zu generieren, die auf einer fundierten mehrstufigen Argumentation basieren. So lassen sich beispielsweise Symptome und bildgebende Befunde analysieren, um die wahrscheinlichste Erkrankung zu identifizieren und Hinweise für die bestmögliche Therapie zu liefern.

Dabei bleibt das Modell so leichtgewichtig, dass es ohne Verzögerung auf einem mobilen Gerät eingesetzt werden kann – ein großer Vorteil in Notfallsituationen oder abgelegenen Regionen. Die Implementierung von Phi-4-mini-reasoning auf Edge-Geräten erreicht durch Werkzeuge wie Microsoft Olive oder Apple MLX nicht nur eine technisch überzeugende Effizienz, sondern auch eine beeindruckende Kompatibilität mit verschiedensten Hardwareplattformen. Dies erleichtert die Integration in bestehende industrielle Systeme maßgeblich. So können Anlagenbetreiber oder Entwickler in der Fertigung Echtzeit-Analysen und intelligente Steuerungen vor Ort ausführen, ohne ihre bestehende Infrastruktur grundlegend verändern zu müssen. Für Entwickler bietet Microsoft Olive darüber hinaus eine umfassende AI-Modelloptimierungsplattform, die nicht nur Quantisierung ermöglicht, sondern auch Fine-Tuning, ONNX-Konvertierung und die Erstellung von adaptiven Modellen unterstützt.

ONNX (Open Neural Network Exchange) sorgt für plattformübergreifende Kommunikation zwischen unterschiedlichen KI-Tools und Frameworks, was wiederum die Anpassung und den Einsatz von Phi-4-mini-reasoning in verschiedensten Szenarien erleichtert. In Kombination mit der Azure-Cloud-Plattform entsteht so eine skalierbare und flexible Umgebung, um KI-Modelle kontinuierlich anzupassen und zu verbessern. Die neue Fähigkeit, Phi-4-mini-reasoning speziell für branchenspezifische Anwendungsfälle anzupassen, eröffnet Unternehmen enormes Potenzial. Firmenspezifische Daten können gezielt genutzt werden, um das Modell noch präziser auf die jeweiligen Anforderungen abzustimmen. Ob es darum geht, in der Logistik Lieferketten schneller und stabiler zu machen, in der Produktion Fehler in Echtzeit zu erkennen oder im Gesundheitswesen patientenindividuelle Empfehlungen zu geben – die Möglichkeiten sind vielfältig und bislang kaum ausgeschöpft.

Für Nutzer der Apple-Gerätewelt stellt das Apple MLX Framework eine besonders attraktive Option dar, da es auf die Hardware- und Software-Optimierungen der Apple-Silicon-Chips abgestimmt ist. Hier ermöglicht das Framework lokale Modellanpassungen auch auf MacBooks oder iPads, die mit relativ geringer Rechenleistung dennoch komplexe Aufgaben effizient bewältigen können. Damit erweitert sich das Einsatzspektrum von Phi-4-mini-reasoning auch auf kreative und mobile Berufe, die bislang wenig von AI-Unterstützung profitierten. Die Kombination aus Feinabstimmung, Quantisierung und Edge-Deployment ermöglicht zudem neue Wege für die datenschutzkonforme KI-Nutzung. Viele Branchen stehen vor Herausforderungen, bei denen sensible Informationen etwa aus Krankenakten, Kundendaten oder Produktionsprozessen verarbeitet werden müssen.

Phi-4-mini-reasoning auf lokalen Geräten bietet hier den Vorteil, dass keine Daten außerhalb der Unternehmensumgebung versendet werden müssen – ein essentieller Schritt in Zeiten immer strengerer Datenschutzbestimmungen. Während die Leistungsfähigkeit des Phi-4-mini-reasoning-Modells auch nach der Quantisierung bemerkenswert bleibt, ist es wichtig, den durch die Optimierung verursachten Präzisionsverlust stets im Auge zu behalten. Hier sind Anpassungen und Tests entscheidend, um ein optimales Verhältnis zwischen Effizienz und Ergebnisqualität sicherzustellen. Die offenen Tools Microsoft Olive und Apple MLX bieten Entwicklern die nötigen Ressourcen, um diese Balance gezielt zu steuern. Die Zukunft der KI auf Edge-Geräten sieht durch Entwicklungen wie Phi-4-mini-reasoning äußerst vielversprechend aus.

Immer mehr Industriezweige erkennen das Potenzial, intelligente Prozesse direkt vor Ort in Maschinen, Geräten und mobilen Applikationen zu verankern. Das reduziert nicht nur Latenzzeiten, sondern macht Systeme auch robuster gegenüber Ausfällen der Netzverbindung. Insbesondere in Zeiten steigender Automatisierung und der Verlagerung von Datenverarbeitung weg zentraler Cloud-Systeme hin zu verteilten und dezentralen Strukturen wird die Bedeutung von leistungsfähiger Edge-KI weiter zunehmen. Phi-4-mini-reasoning ist dabei ein Vorreiter, da es die Vorteile flexibler Deployments auf einer breiten Gerätepalette kombiniert mit der Möglichkeit intensiver Anpassung an branchenspezifische Bedürfnisse. Egal ob in smarten Fabriken, Gesundheitszentren, im Transportwesen oder in der landwirtschaftlichen Produktion – die direkte, kontextbezogene Verarbeitung von Informationen mittels Phi-4-mini-reasoning eröffnet neue Dimensionen des vernetzten und intelligenten Arbeitens.

Die durchdachte Integration auf Edge-Endgeräten macht solche Anwendungen praktisch realisierbar und bietet einen nachhaltigen Wettbewerbsvorteil. Darüber hinaus werden durch Open-Source-Initiativen und Bereitstellung von Modellkatalogen wie beim Azure AI Foundry die Einstiegshürden für Entwickler immer niedriger. Unternehmen aller Größen können von der fortschrittlichen Technologie profitieren und eigene Anwendungsfälle schnell und kosteneffizient umsetzen. Letztlich führt der Fortschritt hin zu stärker spezialisierten KI-Modellen statt rein generischer Systeme dazu, dass diese Instrumente wirklich in ihren Kernbereichen glänzen können. Phi-4-mini-reasoning verkörpert diesen Weg: eine Kombination aus geringem Ressourcenbedarf, ausgefeilter Logik und gezielter Branchenanpassung.

Dies macht es zu einem zentralen Baustein zukünftiger KI-Lösungen im Edge-Computing. Mit der Unterstützung durch etablierte Optimierungsframeworks, vielseitige Plattformoptionen und umfangreiche Trainingsdatensätze können Entwickler heute ihre KI-Anwendungen so gestalten, dass sie robust, schnell und präzise auf Edge-Geräten agieren. Dies ist ein entscheidender Schritt, um das volle Potenzial von künstlicher Intelligenz auch in anspruchsvollen, datenintensiven Industrieumgebungen nutzbar zu machen und somit einen nachhaltigen Mehrwert in verschiedensten Bereichen zu schaffen. Phi-4-mini-reasoning ebnet dabei den Weg für eine neue Ära der intelligenten maschinellen Entscheidungsfindung direkt vor Ort.