Die Entwicklung von Retrieval-Augmented Generation (RAG) Anwendungen hat in den letzten Jahren stark an Bedeutung gewonnen, insbesondere im Umgang mit großen Sprachmodellen und der Verarbeitung umfangreicher Datenmengen. Viele Entwickler, die ihre ersten RAG-Prototypen gebaut haben, stellen schnell fest, dass die anfänglichen Ergebnisse oft noch nicht den Erwartungen entsprechen. Die Qualität der Antworten sowie die Systemlatenz sind häufig verbesserungswürdige Faktoren. Doch es gibt Hoffnung: Mit einer klar definierten Strategie kann jeder RAG-Prototyp systematisch verbessert und für den produktiven Einsatz optimiert werden. RAG-Anwendungen basieren auf mehreren Phasen, die ineinandergreifen und das Gesamtergebnis maßgeblich bestimmen.

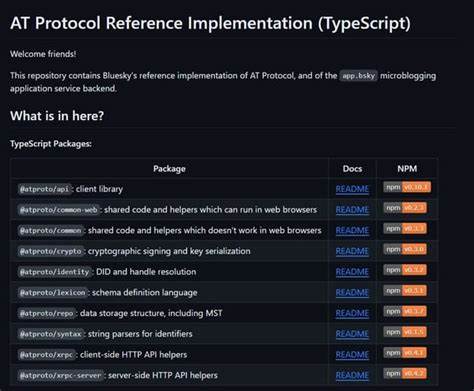

Die Pipeline beginnt meist mit dem sogenannten Chunking, gefolgt von der Einbettung (Embedding), der Speicherung der Daten, der Retrieval-Komponente und schließlich der Augmentierung der Antwort oder der Rückgabe an den Nutzer. Jede dieser Komponenten spielt eine essenzielle Rolle und erfordert individuelle Aufmerksamkeit, wenn man die Performance eines RAG-Systems nachhaltig steigern möchte. Ein zentrales Element in der Performance-Optimierung ist das Chunking. Dabei handelt es sich um die Aufteilung der Datenquellen in kleinere, verdauliche Einheiten. Große Sprachmodelle reagieren empfindlich auf die Qualität der Eingaben.

Wenn die Eingabe zu viel irrelevanten Text enthält, leidet die Antwortqualität erheblich. Daher ist es wichtig, eine Chunking-Strategie zu entwickeln, welche die relevanten Informationen präzise isoliert und gleichzeitig den Kontext wahrt. Ein guter Chunking-Algorithmus reduziert das Rauschen und ermöglicht es dem Modell, effizienter zu arbeiten. Im Anschluss an das Chunking folgt die Einbettung. Hierbei werden die Textdaten in vektorielle Repräsentationen umgewandelt, die eine semantische Suche ermöglichen.

Die Wahl der richtigen Embedding-Technologie ist entscheidend, da unterschiedliche Modelle variierende Genauigkeiten und Geschwindigkeiten bieten. Moderne Ansätze verwenden oftmals neuronale Netzwerke, die speziell auf die jeweiligen Anwendungsbereiche trainiert sind. Eine präzise Einbettung sorgt dafür, dass später bei der Suche die relevantesten Dokumente anhand ihrer semantischen Nähe identifiziert werden können. Die Speicherung der Embeddings und der ursprünglichen Text-Chunks erfolgt typischerweise in spezialisierten Datenbanken oder Vektorspeichern. Effiziente Speicherlösungen sind nicht nur in der Lage, große Datenmengen mit minimaler Latenz zu durchsuchen, sondern skalieren auch mit dem Wachstum des Datenbestands.

Technologien wie FAISS oder Pinecone sind in der Branche weit verbreitet und unterstützen Entwickler dabei, schnelle Abrufzeiten zu gewährleisten. Der Retrieval-Prozess, also die Suche nach den passenden Textchunks, gestaltet sich als einer der kritischsten Schritte in einem RAG-System. Eine schlechte Retrieval-Strategie kann selbst bei exzellentem Chunking und Einbettung zu unbrauchbaren Ergebnissen führen. Es gilt, Algorithmen zu implementieren, die nicht nur nahegelegene Vektoren erkennen, sondern auch Kontextfaktoren und Benutzerabsichten berücksichtigen. Adaptive Retrieval-Methoden, die durch Feedback lernen und sich verbessern, werden immer beliebter.

Nach dem erfolgreichen Retrieval wird die Antwort generiert. Hierbei kann eine Augmentierung eingebaut werden, durch die das System nicht nur die gefundenen Informationen präsentiert, sondern sie auch intelligent verarbeitet, zusammenfasst oder anreichert. Dabei spielen die Feinabstimmung der Sprachmodelle sowie die Erstellung qualitativ hochwertiger Prompts eine große Rolle. Ein gut gestaltetes Augmentierungskonzept erhöht die Relevanz und Verständlichkeit der Antworten signifikant. Die Reduzierung von Latenzzeiten und die Sicherstellung der Skalierbarkeit sind weitere wichtige Aspekte bei der Vorbereitung einer RAG-Anwendung für den produktiven Einsatz.

Dies erfordert eine umfassende Optimierung aller Komponenten und deren Zusammenspiel. Caching-Mechanismen, parallele Verarbeitungsprozesse und optimierte API-Architekturen helfen dabei, schnelle Reaktionszeiten auch unter hoher Last zu garantieren. Die kontinuierliche Verbesserung eines RAG-Systems sollte zudem auf Metriken basieren, die sowohl objektive Qualitätsmaße als auch Nutzerfeedback integrieren. Fehleranalysen und A/B-Tests ermöglichen es, Schwachstellen zu identifizieren und gezielt entgegenzuwirken. So können Schwachstellen im Promptdesign, in der Chunkqualität oder in der Retrieval-Genauigkeit präzise adressiert werden.