Die rasante Entwicklung großer Sprachmodelle (Large Language Models, kurz LLMs) hat nicht nur deren Fähigkeiten im Bereich der natürlichen Sprachverarbeitung enorm vorangetrieben, sondern auch den Bedarf an effizienten Speicher- und Rechenlösungen drastisch erhöht. Mit der Veröffentlichung von Unsloth Dynamic v2.0 GGUFs wurde ein bedeutender Fortschritt auf dem Gebiet der Quantisierung vorgestellt, der genau diese Herausforderungen adressiert und neue Maßstäbe hinsichtlich Genauigkeit und Performanz setzt. Die neue Quantisierungsmethode von Unsloth setzt dabei nicht nur auf eine verbesserte Kompression von Modellen, sondern auch auf eine intelligente und dynamische Anpassung der Quantisierungsschritte für jede einzelne Schicht eines Modells. Damit gelingt es, die Balance zwischen Ressourceneffizienz und Modellgenauigkeit auf ein neues Level zu heben und gleichzeitig die breitgefächerte Kompatibilität mit verschiedenen Inferenzsystemen sicherzustellen.

Die Unsloth Dynamic v2.0 Quantisierung ist ein Meilenstein, der den Einsatz von LLMs auch auf weniger leistungsfähiger Hardware praktikabel macht – ohne die Leistung spürbar einzuschränken. Dieses Potenzial eröffnet neue Möglichkeiten der KI-Anwendung in Forschung und Industrie. Die Technologie hinter Unsloth Dynamic v2.0 beruht auf einer umfassenden Überarbeitung des quantisierungstechnischen Vorgehens.

Im Gegensatz zu früheren Ansätzen, die oft nur bestimmte Layer selektiv quantisierten, werden nun alle möglichen Schichten eines Modells einzeln und sehr genau untersucht. Je nach Schichttyp und Modellarchitektur erfolgt eine individuelle Auswahl der Quantisierungsmethode. Dieses dynamische Verfahren ist modell- und schicht-spezifisch und ermöglicht eine optimale Kompression mit minimalem Verlust bei der Modellperformance. Dadurch werden nicht nur MoE-Modelle (Mixture of Experts) unterstützt, wie es schon bei der ersten Version von Unsloth Dynamic der Fall war, sondern auch eine Vielzahl anderer moderner Architekturen. Ein weiterer zentraler Vorteil von Dynamic v2.

0 ist die Nutzung eines eigens entwickelten und handkuratieren Kalibrierungsdatensatzes. Dieser Datensatz mit einer Größe von 300.000 bis zu 1,5 Millionen Tokens – je nach Modellvariante – trägt entscheidend zur Verbesserung der Gesprächsqualität und der allgemeinen Genauigkeit bei. Anders als herkömmliche Mengen, die häufig auf Wikipedia-Daten basieren und zu Überanpassungen führen können, fokussiert die Unsloth-Kalibrierung auf vielfältigere, saubere und kontextuell relevante Inhalte. Die praktische Umsetzung und Verfügbarkeit der Dynamic v2.

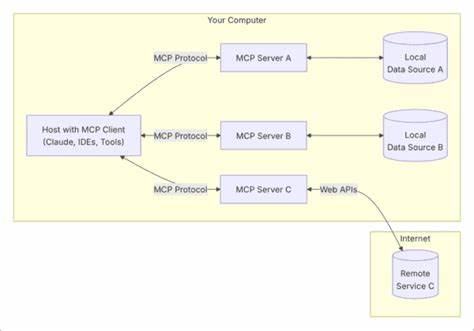

0 GGUF-Modelle ist ein weiterer Pluspunkt. Die Modelle sind kompatibel mit zahlreichen bekannten Inferenz-Engines wie llama.cpp, Ollama oder Open WebUI und können somit nahtlos in bestehende Workflows integriert werden. Das bietet Anwendern maximale Flexibilität, gleichzeitig profitieren sie von höheren Genauigkeiten und geringeren Speicheranforderungen. Das durch Unsloth entwickelte interne Evaluierungsframework erlaubt zuverlässige und reproduzierbare Benchmarking-Ergebnisse.

Insbesondere das 5-shot MMLU-Verfahren (Massive Multitask Language Understanding) wurde zur genaueren Bewertung herangezogen. Dieses Verfahren misst die Fähigkeit eines Modells, bessere Antworten mit geringem Kontext zu geben, und ist aussagekräftiger als klassische Metriken wie Perplexity oder KL-Divergenz. Mit diesem Setup gelang es Unsloth, die Dynamik von quantisierten Modellen exakt zu erfassen und glaubwürdige Vergleiche zum vollen Präzisionsmodell und alternativen Quantisierungsmethoden durchzuführen. Im Rahmen von Benchmarks zeigten sich erhebliche Vorteile von Dynamic v2.0 ggü.

älteren Quantisierungsansätzen. Die neue Methode konnte nicht nur höhere Genauigkeit bei der MMLU-Bewertung erzielen, sondern auch die Konsistenz der Ergebnisse über verschiedene Modelle wie Gemma 3 und Llama 4 verbessern. Besonders auffällig war das bessere Abschneiden bei Modellen mit mehreren Milliarden Parametern, bei denen die Komprimierung traditionell schwierig ist, ohne die Qualität zu beeinträchtigen. Neben der reinen akademischen Leistung bietet die Unsloth Dynamic 2.0 Quantisierung auch praktische Vorteile hinsichtlich der Effizienz.

Eine eigens entwickelte Effizienzmetrik berücksichtigt sowohl die Modellgröße als auch die erzielte MMLU-Genauigkeit. So wird eine effektive Vergleichsbasis geschaffen, die den Nutzen eines Modells bei geringerem Speicherverbrauch klar widerspiegelt. Dabei zeigte sich, dass Dynamic v2.0 mit deutlich geringeren Speicheranforderungen Modelle mit voller Präzision in puncto Leistung mindestens ebenbürtig ist oder diese sogar übertrifft. Für Anwender bedeutet dies eine erhebliche Erleichterung beim Betrieb ressourcenintensiver LLMs, gerade auf Geräten mit begrenztem Speicher oder bei Anwendungen mit restriktiven Hardwarebedingungen.

Ein weiterer kritischer Punkt bei der Quantisierung ist die Vermeidung von Überanpassung an Kalibrierungsdatensätze, die sonst zu unzuverlässigen Ergebnissen bei der Bewertung führen können. Hierfür nutzt Unsloth eine Kombination aus verschiedenen Datensätzen inklusive spezialisierter Wikipedia-Segmente, die eine realistischere Testumgebung schaffen. Dies verbessert die Aussagekraft von Benchmark-Ergebnissen bezüglich der Generalisierbarkeit der Modelle auf unterschiedliche Aufgaben und Kontexte. Interessanterweise hat Unsloth bei der Nachbildung und Validierung der 5-shot MMLU-Ergebnisse eine sorgfältige Analyse technischer Details durchgeführt. So zeigte sich beispielsweise, dass Tokenisierungsunterschiede, wie die Behandlung von Leerzeichen vor Token, merklichen Einfluss auf die Messwerte haben können.

Solche Feinheiten sind bei der Entwicklung und dem Vergleich von Quantisierungsmethoden oft entscheidend und unterstreichen den hohen Anspruch von Unsloth an korrekte und transparente Evaluationen. Auch auf Modellebene gab es Verbesserungen durch die Entwickler von Unsloth, insbesondere bei Llama 4. Bugs bei wichtigen Konfigurationen, wie der RoPE-Skalierung und der QK-Normalisierung, konnten durch Zusammenarbeit mit der llama.cpp-Community beseitigt werden. Das führte zu deutlich erhöhten Genauigkeiten, etwa einer Steigerung der MMLU-Pro-Score von 68,58 auf 71,53 Prozent, was die Effektivität solcher Detailoptimierungen unterstreicht.

Bei der Betrachtung der gemessenen Werte fällt auf, dass die Fortschritte bei der quantitativen Genauigkeit im Vergleich zu herkömmlichen QAT-Methoden (Quantization Aware Training) von großer Bedeutung sind. Die Gemma 3 QAT-Version erreichte in der 12 Milliarden Parameterklasse einen MMLU-Wert von über 67 Prozent, nahezu gleichauf mit der vollen bfloat16-Version. Dieses Ergebnis spricht für die hohe Qualität der Dynamic v2.0 Quantisierung und bestätigt deren Praxisrelevanz. Zusammenfassend leistet Unsloth mit der Dynamic 2.

0 GGUF Quantisierung einen entscheidenden Beitrag zur Weiterentwicklung großer Sprachmodelle. Die Mischung aus fein abgestimmter, schichtenspezifischer Quantisierung, einem hochwertigen Kalibrierungsdatensatz, realistischen Benchmarking-Frameworks und der praxisorientierten Kompatibilität zu verschiedenen Inferenzsystemen macht die Technologie zu einem wichtigen Werkzeug für Entwickler und Forscher. Die Möglichkeit, große und komplexe Modelle mit deutlich geringerem Speicherbedarf und hoher Güte auszuführen, kann Innovationen in zahlreichen Bereichen beschleunigen und damit den Zugang zu leistungsstarken KI-Systemen demokratisieren. Unsloth bleibt außerdem mit fortlaufender Weiterentwicklung und aktiver Community-Betreuung eine wichtige Anlaufstelle für Technikinteressierte. Das Engagement in Foren wie Reddit, Discord und der Austausch auf Social-Media-Kanälen garantiert, dass Anwender und Entwickler nicht nur von der neuesten Technik profitieren, sondern auch aktiv an zukünftigen Verbesserungen mitwirken können.

Die Veröffentlichung der Dynamic v2.0 GGUF-Modelle auf Plattformen wie Hugging Face sorgt zudem für eine breite Verfügbarkeit und einfache Integration in bestehende Infrastrukturen. Für alle, die im Bereich der KI-Forschung oder praktischen Anwendung mit großen Sprachmodellen arbeiten, stellen die Innovationen von Unsloth derzeit eine der fortschrittlichsten und zukunftsweisenden Lösungen dar. Wer die Leistung großer Modelle gerne bei reduziertem Ressourcenverbrauch einsetzen möchte, findet mit den Unsloth Dynamic v2.0 GGUFs eine überzeugende Option, die nicht nur technisch hervorragend funktioniert, sondern auch auf einem soliden wissenschaftlichen Fundament steht.

Angesichts der steigenden Anforderungen an KI-Systeme und der zunehmenden Verbreitung von LLMs in der realen Welt wird es spannend sein, wie sich die Quantisierungstechnologie weiterentwickelt. Unsloth setzt dabei einen starken Akzent auf Qualität, Transparenz und praktische Relevanz – ein Ansatz, der zweifelsohne die Zukunft der KI-Inferenz mitgestalten wird.