PostgreSQL zählt zu den beliebtesten relationalen Datenbanksystemen weltweit und wird in zahlreichen Anwendungen eingesetzt, die hohe Anforderungen an Datenkonsistenz und Performanz stellen. Besonders bei massiven Einfügeoperationen spielt die Geschwindigkeit eine entscheidende Rolle, um Engpässe zu vermeiden und die Skalierbarkeit sicherzustellen. Obwohl PostgreSQL standardmäßig bereits sehr leistungsfähig ist, lassen sich durch gezielte Optimierungen bei der Einfügegeschwindigkeit enorme Steigerungen erzielen. Wer seine Anwendungen auf maximale Performance trimmen möchte, muss dabei verschiedene Faktoren berücksichtigen, von der Netzwerkumgebung über die Anzahl der parallelen Verbindungen bis hin zu den Methoden der Datenübertragung an die Datenbank. Eine der grundlegenden Erkenntnisse im Umgang mit PostgreSQL ist, dass einfache Einfügeoperationen wie Einzelinserts für große Mengen an Daten nicht effizient sind.

Mehrere tausend bis zehntausend Einfügungen hintereinander durchzuführen kann zu massiven Verzögerungen führen. Die Gründe sind vielfältig: neben dem Overhead jeder einzelnen Abfrage fallen Lock-Contention, CPU-Auslastung und die Verwaltung von Transaktionen ins Gewicht. In der Praxis zeigen sich bei Einzelinserts etwa 2.000 Zeilen pro Sekunde mit einer einzigen Verbindung, was für viele moderne Anwendungen nicht ausreichend ist. Ein zentraler Hebel zur Verbesserung der Einfügegeschwindigkeit ist das Reduzieren von Netzwerklatenzen.

Gerade wenn die Datenbank und die Anwendung nicht in der gleichen Cloud-Region oder Umgebung laufen, erhöht sich die Kommunikationszeit erheblich und reduziert den Datendurchsatz. Um dem entgegenzuwirken, empfiehlt es sich, mögliche Netzwerkengpässe durch gezielte Infrastrukturentscheidungen zu minimieren. Ein weiterer entscheidender Faktor ist die Verwendung eines Verbindungspools. Das bedeutet, dass nicht für jede einzelne Abfrage eine neue Verbindung aufgebaut wird, sondern eine begrenzte Anzahl von Verbindungen wiederverwendet wird, um parallel mehrere Operationen abzuwickeln. So konnte bei Tests eine Steigerung der Inserts von 2.

000 Zeilen pro Sekunde auf über 11.000 Zeilen pro Sekunde bei zehn parallelen Verbindungen erzielt werden. Allerdings sollte man mit der Anzahl der Verbindungen vorsichtig umgehen: Erhöht man die Anzahl zu stark, etwa auf 40 parallele Verbindungen, steigt zwar die Gesamtanzahl der möglichen Einfügungen nicht proportional an, sondern reduziert sich sogar teilweise wieder aufgrund von erhöhtem Lock-Contention und CPU-Saturierung. Daraus folgt, dass die optimale Verbindungsanzahl situationsabhängig ist und meist bei etwa 20 Verbindungen liegt. Neben der Anzahl der Verbindungen spielt vor allem die Art und Weise, wie Daten in die Datenbank übertragen werden, eine entscheidende Rolle.

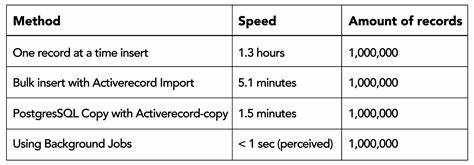

Hier bieten sich Batch-Inserts an, bei denen mehrere Datensätze in einer einzigen Abfrage zusammengefasst werden. Dies reduziert den Overhead für jede einzelne Abfrage und den damit verbundenen Auf- und Abbau von Verbindungen sowie Lock-Operationen im Datenbanksystem. Experimente mit einem Batch von 100.000 Zeilen konnten eine Steigerung der Durchsatzleistung auf über 37.000 Zeilen pro Sekunde erreichen, also ein nahezu zehnfacher Gewinn gegenüber Einfügeoperationen einzeln.

Einen noch größeren Leistungssprung ermöglicht die COPY FROM-Anweisung von PostgreSQL. Diese Methode erlaubt den direkten Import von großen Datenmengen, indem der Datenstrom wie ein Datei-Upload behandelt wird und zahlreiche interne Optimierungen, etwa im Bereich der Lock-Verwaltung und den Shared-Buffern, genutzt werden. So steigt die Schreibleistung bei Copy-Operationen auf 60.000 bis 90.000 Zeilen pro Sekunde an, was im Vergleich zu Einzel- und Batch-Inserts eine enorme Optimierung darstellt.

Allerdings bergen größere Batches auch eine Schattenseite: die Latenz zur Fertigstellung einzelner Einfügungen steigt. Werden einzelne Zeilen direkt nach der Einfügung verarbeitet, kann eine große Batch-Größe zu Verzögerungen führen, da der Abschluss der gesamten Gruppe von Zeilen abgewartet werden muss. Daher müssen Entwickler eine Balance finden zwischen Durchsatz und Latenz, abhängig davon, wie zeitkritisch ihre Anwendung reagiert. Ein Mittelweg liegt oft bei relativ kleinen bis mittelgroßen Batches, welche die Schreibleistung optimieren, ohne die Latenz unnötig in die Höhe zu treiben. Optimale Batch-Größen liegen in der Praxis häufig bei etwa 25 bis 100 Zeilen, abhängig von Hardware, IO-Leistung und Netzwerkbedingungen.

Weitere wichtige Faktoren für den erfolgreichen Betrieb eines PostgreSQL-Systems mit hohem Schreibdurchsatz sind die Konfiguration der Datenbank selbst. So müssen z.B. ausreichende Ressourcen für die Verwaltung von Locks, Multixacts und Shared Buffers vorhanden sein, um Spitzenbelastungen abzufangen und Fehler wie das Überschreiten von Multixact-Limits zu vermeiden. Gleichzeitig empfiehlt es sich, unnötige Fremdschlüsselbeziehungen oder Trigger zur Laufzeit zu minimieren, da diese Operationen zusätzliche Synchronisation erfordern und so den Schreibdurchsatz verringern können.

Für Entwickler von Anwendungen, die PostgreSQL als Backend nutzen, ist es entscheidend, diese Faktoren im Blick zu behalten und entsprechende Architekturmuster umzusetzen. Ein effizientes Task-Queue-System oder Event-Sourcing-Modell profitiert immens von schnellen, asynchronen Schreiboperationen. Moderne Programmierbibliotheken und Schnittstellen, wie pgx für Go oder entsprechende ORM- und Framework-Erweiterungen, bieten Möglichkeiten zur einfachen Implementierung von Verbindungspools und Batch-Inserts. Um das Zusammenspiel von Anwendung und Datenbank weiter zu optimieren, empfehlen sich zudem performante Benchmarking-Methoden, welche das System unter realistischen Lasten testen und Engpässe sichtbar machen. So gewinnen Entwickler konkrete Einblicke, welche kniffligen Punkte ihre Einfügeperformance bremsen und wie sich durch gezielte Optimierungen Millionen von Einfügungen pro Minute erreichen lassen.

Neben den bereits genannten Aspekten wird es im Bereich der PostgreSQL-Einfügeoperationen auch immer wieder spannende Innovationen geben. So kann der Einsatz von UNNEST, unlogged Tables oder Upserts mit Konfliktauflösung je nach Szenario weitere Optimierungen bringen. Speziell Multi-Tenant-Datenbanken oder Systeme mit stark referenzierten Tabellen profitieren von strategischer Gestaltung der Datenmodellierung und den eingesetzten Transaktionsgrenzen. Insgesamt zeigt sich, dass PostgreSQL trotz zahlreicher spezialisierter Datenbanken und Event-Streaming-Plattformen wie Kafka oder Clickhouse immer noch eine enorm leistungsfähige Basis darstellt – vorausgesetzt, man nutzt sie mit passenden Methoden und versteht die zugrundeliegenden Limitierungen. Mit den beschriebenen Optimierungen lassen sich sehr hohe Datendurchsätze erzielen, ohne auf komplexe Zusatztechnologien zurückgreifen zu müssen.

Wer also das volle Potenzial seiner PostgreSQL-Datenbank ausschöpfen möchte, sollte seine Einfügeoperationen mit Netzwerkoptimierung, Verbindungspooling, Batch-Verarbeitung und COPY-Anweisungen sorgfältig anpassen und regelmäßig anhand von Messungen nachjustieren. Nur so können moderne Anwendungen mit hohen Anforderungen an Geschwindigkeit und Zuverlässigkeit wirklich skalieren und auch bei Millionen von Transaktionen im Monat performant bleiben.

![Lecture Notes on Linear Programming by Hal Gabow [pdf]](/images/38812CFA-3F99-483D-A0AF-280F0247A82F)