JSON, das JavaScript Object Notation, gilt als der Standard zum Austausch von Daten im Web und darüber hinaus. Es ist schlicht, leichtgewichtig und strukturiert zugleich. Doch gerade durch seine scheinbare Einfachheit können komplexe Herausforderungen bei der Interpretation von JSON-Dokumenten entstehen, die Entwickler oft überraschen. Ein besonders interessantes und oft missverstandenes Problem sind sogenannte ungültige Zeichenketten in eigentlich gültigem JSON. Diese treten auf, wenn String-Inhalte zwar formal den JSON-Spezifikationen entsprechen, aber bei der Dekodierung in Programmierumgebungen zu Fehlern führen.

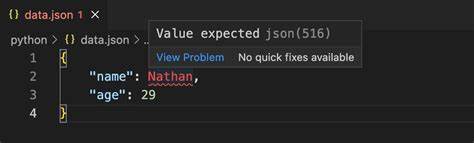

Dies wirft Fragen auf, wie valid JSON trotzdem fehlerhafte oder problematische Strings enthalten kann und was die Hintergründe hierfür sind. Ein prägnantes Beispiel stammt aus der Praxis des Enterprise-Webhooks-Anbieters Svix. Dort fiel auf, dass eine JSON-Zeichenkette einen Fehler verursachte, obwohl das JSON an sich gültig war. Die Fehlermeldung „unexpected end of hex escape“ deutete darauf hin, dass im String eine unvollständige Unicode-Escape-Sequenz vorhanden war. Solche Escape-Sequenzen im JSON haben das Format \uXXXX, wobei XXXX eine hexadezimale Zahl ist, die einen UTF-16 Codepunkt beschreibt.

Dieses Format ermöglicht es, Unicode-Zeichen darzustellen, die in der JSON-Datei nicht direkt eingetragen werden können, beispielsweise aufgrund von Steuerzeichen oder solchen außerhalb des ASCII-Bereichs. Das eigentliche Problem entsteht, wenn eine UTF-16 Escape-Sequenz einen sogenannten Hoch- oder Niedrig-Surrogat-Codepunkt adressiert, der für sich allein genommen keine gültige Unicode-Darstellung ist. Nach der Unicode-Norm werden Zeichen, die außerhalb der Basic Multilingual Plane (d.h. über U+FFFF hinaus) liegen, in UTF-16 mittels sogenannter Surrogatpaare codiert.

Ein Hoch-Surrogat (zwischen D800 und DBFF) muss durch ein Niedrig-Surrogat (zwischen DC00 und DFFF) gefolgt werden. Fehlt der zweite Teil, ist die Sequenz unvollständig und verursacht beim Umwandeln Probleme. Obwohl die JSON-Grammatik selbst keine solche Kombination verbietet oder diese fehlerhaft macht, führt die Interpretation und Decodierung dieser Zeichenketten oft zu Fehlern in der Praxis. Die Tragweite dieses Problems zeigt sich besonders in komplexen Softwareprojekten, etwa wenn Webhook-Payloads weiterverarbeitet, konvertiert oder zwischen verschiedenen „JSON Value“-Repräsentationen übertragen werden. Der fragliche Fehler „unexpected end of hex escape“ führte bei Svix dazu, dass ein Prozess versagte, weil unerwartet eine unvollständige Unicode-Escape-Sequenz auftrat.

Dies offenbart ein Spannungsfeld: JSON-Daten sind formal gültig, aber beim Interpretieren bestimmter Zeichenketten wird die Implementierung plafoniert. Die Ursache ist, dass viele JSON-Bibliotheken die Sequenzen zwar grammatisch validieren, jedoch die semantische Korrektheit der UTF-16 Surrogatpaare nicht strikt erzwingen. Dieser Umstand hat praktische Bedeutung für Entwickler und Teams, die mit Webhooks, APIs oder anderen JSON-basierten Schnittstellen arbeiten. Es verdeutlicht, dass die Validität von JSON nach Grammatikregeln nicht automatisch bedeutet, dass alle Strings darin ohne Weiteres verarbeitet werden können. Insbesondere, wenn JSON-Daten Strings mit Escapes enthalten, die UTF-16 Surrogatpaare repräsentieren sollten, aber inkorrekt oder unvollständig sind, kann es zu unerwarteten Fehlern kommen.

Was bedeutet das also für professionelle Softwareentwicklung? Zunächst einmal erfordert es ein Bewusstsein für die besonderen Eigenheiten von Unicode in JSON und wie verschiedene JSON-Bibliotheken diese behandeln. Die meisten modernen JSON-Parser prüfen zwar die Syntax und erlauben Escape-Sequenzen im Format \uXXXX, doch die tiefergehende Validierung der zulässigen Surrogatpaarfolgen ist nicht immer garantiert. Deshalb ist ein defensiver Umgang mit derartigen Eingaben empfehlenswert. Ein vernünftiger Ansatz besteht darin, die Eingabedaten nicht nur auf syntaktische Korrektheit zu validieren, sondern auch eventuelle Unicode-Escape-Sequenzen auf korrekte Surrogatpaare zu prüfen. Falls fehlerhafte Paare entdeckt werden, kann man diese entweder entschärfen, etwa durch Ersetzen der problematischen Escape-Sequenz durch ein Ersatzzeichen, oder entsprechende Fehlerbehandlungsstrategien implementieren.

Der Fall bei Svix konnte dank der Offenheit und der Community-Supports rund um die verwendete JSON-Bibliothek schnell adressiert werden. Nach identifizieren und verstehen des Problems wurde der Code so angepasst, dass er fehlerhafte Surrogatpaare erkennt, korrekt behandelt und die Applikation stabil bleibt, selbst wenn solche ungültigen Strings bei der Payloadverarbeitung auftauchen. Die Fehlerbehebung führte dazu, dass Webhooks innerhalb weniger Stunden retried und korrekt zugestellt wurden. Dies unterstreicht, wie wichtig sorgfältige Fehlerbehandlung beim Umgang mit JSON-Daten ist. Darüber hinaus wirft diese Problematik auch Fragen zur Kompatibilität und Zuverlässigkeit verschiedener Programmiersprachenbibliotheken auf.

Während einige JSON-Parsing-Lösungen streng nach den Unicode- und JSON-Spezifikationen arbeiten, ignorieren andere bei bestimmten Schritt der Dekodierung mögliche Fehlerquellen. Für Entwickler heißt das, dass sie sich gut informieren sollten, wie ihre Werkzeuge mit Unicode Escape-Sequenzen umgehen, besonders wenn die Applikation mit extern gelieferten JSON-Daten arbeitet und die Stabilität bei Fehlern oberste Priorität hat. Ein weiterer interessanter Aspekt ist, dass die Repräsentation und Dekodierung von Unicode in JSON auf UTF-16 basiert, was viele Programmierer gar nicht bewusst ist. JSON verwendet UTF-8 als Standard-Encoding der Datei, doch Unicode-Escape-Sequenzen beziehen sich auf UTF-16-Codepunkte. Deshalb entstehen hier bei der Interpretation komplexerer Unicode-Zeichen technische Herausforderungen.

Gerade bei Emoji oder seltenen Schriftzeichen sind korrekte Surrogatpaare entscheidend, um Zeichen nicht zu korrupt erscheinen zu lassen oder überhaupt korrekt zu verarbeiten. Praktische Ressourcen und Beispiele, etwa für die Programmiersprache Rust, illustrieren diese Problematik und erleichtern das Verständnis für Entwickler. Einige Playgrounds und Gist-Repositories zeigen, wie mit gültigen, aber problematischen JSON-Strings umgegangen wird. Technologien, die stabile und sichere Verarbeitung von JSON gewährleisten, sollten diese Fälle berücksichtigen, um unerwartete Ausfälle zu vermeiden. Im Endeffekt fordert uns die Thematik der „ungültigen Strings“ in gültigem JSON dazu auf, über die klassische Definition von Validität hinauszuschauen.

Software, die auf JSON-Daten basiert, sollte robuste Mechanismen im Einsatz haben, um nicht nur syntaktisch, sondern auch semantisch korrekte Daten sicher zu verarbeiten. Das gilt besonders im Bereich integrierter Systeme wie Webhooks, APIs und Echtzeitanwendungen, in denen Daten zwischen vielen heterogenen Systemen fließen. Zusammenfassend lässt sich also sagen, dass das Problem mit ungültigen Zeichenketten trotz gültigem JSON die scheinbar einfache Datenstruktur in ein komplexes Feld verwandelt. Die Kombination von JSON-Spezifikation, Unicode-Normen und Implementierungsdetails in Bibliotheken macht es erforderlich, dass Entwickler genau verstehen, wie Surrogatpaare und Escape-Sequenzen funktionieren. Mit bewusster Prüfung, gewissenhafter Fehlerbehandlung und dem Einsatz moderner Bibliotheken kann man die Zuverlässigkeit von Systemen wesentlich erhöhen und Fehlschläge bei der Datenverarbeitung wirkungsvoll vermeiden.

In der modernen Softwareentwicklung ist dies ein weiterer Beleg dafür, dass naheliegende und allgemeingültige Standards wie JSON stets im Detail hinterfragt und geprüft werden müssen, damit der Datenaustausch weltweit reibungslos funktioniert. Wer diese Fallstricke meistert, sichert die Stabilität seiner Systeme und verbessert die Nutzererfahrung nachhaltig.