Die Entwicklung großer Sprachmodelle (Large Language Models, LLMs) markiert einen der bedeutendsten Fortschritte in der Geschichte der künstlichen Intelligenz und des Natural Language Processing (NLP). Auch wenn heutzutage Namen wie GPT-3, BERT oder Transformer in aller Munde sind, liegt der Ursprung dieser beeindruckenden Technologie oft in frühen wissenschaftlichen Arbeiten, die den Weg für spätere Innovationen ebneten. Insbesondere eine wegweisende Studie aus dem Jahr 2003 in Montreal gilt als maßgeblicher Startpunkt für die moderne Entwicklung von LLMs und hat die Forschungslandschaft nachhaltig geprägt. Die Forschungsarbeit aus Montreal entstand in einem Umfeld, das von führenden Institutionen wie der Universität Montreal geprägt war – einem Zentrum für KI-Forschung und maschinelles Lernen. In den frühen 2000er-Jahren befand sich das Feld des NLP noch in den Kinderschuhen, insbesondere was das Verstehen und Reproduzieren menschlicher Sprache angeht.

Die Arbeit von 2003 brachte frischen Wind und Wege auf, wie Maschinen Sprache nicht nur analysieren, sondern auch auf eine Weise generieren können, die menschlicher Kommunikation näherkommt. Das Fundament legte eine Kombination aus innovativen Algorithmen und neuen Architekturen für neuronale Netze. Die Studie zeigte erstmals eindrucksvoll, wie Modelle, die auf statistischen Methoden und neuronalen Netzwerken basieren, Sprache mit höherer Genauigkeit verarbeiten können. Insbesondere die Integration tiefer Lernmechanismen – damals ein relativ neues Konzept – verbesserte die Fähigkeit der Maschinen, komplexe Sprachstrukturen zu verstehen und angemessen zu interpretieren. Ein Schlüsselaspekt der Montrealer Forschung war der Ansatz, sprachliche Muster aus großen Textkorpora zu extrahieren und diese Muster zu nutzen, um syntaktische und semantische Beziehungen abzubilden.

Diese Arbeit setzte neue Standards für das Training von Modellen, die später als Grundlage für heutige LLMs wie BERT und GPT dienten. Die Vorstellung, dass ein Modell aus einer riesigen Datenmenge lernen kann, ohne für jede einzelne Spracheigenschaft explizit programmiert werden zu müssen, war revolutionär und ebnete den Weg für eine datengetriebene KI. Diese Studienleistung trug maßgeblich dazu bei, dass Forscher begannen, sich stärker auf das Konzept des „Transfer Learning“ zu konzentrieren, bei dem vortrainierte Modelle auf spezifische Anwendungen angepasst werden können. Das ist heute ein Kernprinzip in der Entwicklung von Sprachmodellen und sorgt dafür, dass diese schnell an unterschiedliche Aufgaben und Sprachen angepasst werden können, ohne von Grund auf neu trainiert zu werden. Die Forschergemeinde in Montreal wurde zu einem bedeutenden Motor für viele der Innovationen, die später die NLP-Community weltweit beeinflussten.

Namen wie Yoshua Bengio, einer der Pioniere des Deep Learning, standen dabei im Fokus und prägten mit ihrer Arbeit das Verständnis von neuronalen Netzen für Sprachverarbeitung nachhaltig. Die 2003 veröffentlichte Arbeit ist eng mit diesen Wissenschaftlern verbunden und öffnete den Blick auf neue Möglichkeiten zur KI-Entwicklung. Die Herausforderung, natürliche Sprache zu verarbeiten, ist enorm komplex, da Sprache mehrdimensionale Informationen wie Syntax, Semantik, Pragmatik und Kontext miteinander vernetzt. Die Arbeit von 2003 erkannte früh, dass klassische regelbasierte Methoden, die auf vorprogrammierten Grammatikregeln basieren, den Anforderungen kaum gerecht werden können. Stattdessen verschob man den Fokus hin zu statistischen und lernbasierten Modellen, die aus Daten Patterns und Zusammenhänge selbständig extrahieren.

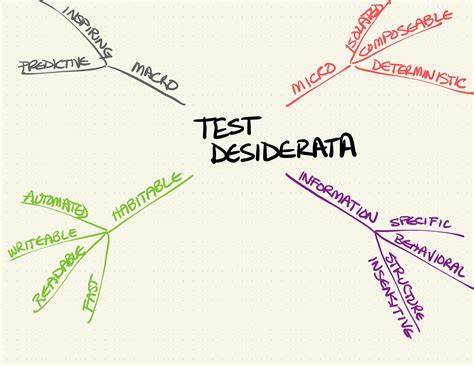

Mit der Zeit führte diese Forschung zu den sogenannten tiefen neuronalen Netzwerken, die mehrere Schichten besitzen und komplexe sprachliche Muster darstellen können. Das 2003 erarbeitete Konzept legte somit den Grundstein für spätere Durchbrüche wie Long Short-Term Memory (LSTM) Netzwerke und später das Transformer-Modell, die heute zentrale Bausteine leistungsstarker Sprachmodelle sind. Ein weiterer wichtiger Beitrag der Studie aus Montreal war die Betonung der Bedeutung von unsupervised Learning, also dem Lernen ohne explizite Annotationsdaten. Hierbei werden große Textmengen verwendet, um Sprachverständnis zu verbessern, ohne dass jedes Beispiel manuell kommentiert werden muss. Dieses Verfahren ist essentiell für die Skalierung von LLMs, da es erlaubt, unbegrenzt viel Wissen aus existierenden Daten zu extrahieren.

Auf der praktischen Seite ermöglichte der Fortschritt aus 2003 neue Anwendungen in der maschinellen Übersetzung, automatischer Texterstellung, Sprachassistenzsystemen und vielen weiteren Anwendungsfeldern. Die Forschung trug dazu bei, dass Computer heute menschliche Sprache besser verstehen, auf nahtlose Weise reagieren und sogar kreative Texte verfassen können, was früher undenkbar schien. Die Montrealer Studie von 2003 besitzt daher nicht nur historische Bedeutung, sondern wird oft als Ausgangspunkt betrachtet, um den rasanten Fortschritt in der KI-Sprachverarbeitung der letzten zwei Jahrzehnte nachzuvollziehen. Sie zeigt exemplarisch, wie Grundlagenforschung in innovativen wissenschaftlichen Umgebungen wegweisende Impulse setzen kann – Impulse, deren Auswirkungen heute in unzähligen Technologien und Produkten weltweit spürbar sind. Rückblickend eröffnet die Erkenntnis, dass aus einer einzelnen wissenschaftlichen Arbeit ein ganz neues Forschungsfeld entstehen kann, spannende Perspektiven für die Zukunft.

Sie bestärkt Forscherinnen und Forscher weltweit, weiterhin Neuland zu betreten und mit interdisziplinären Ansätzen das volle Potenzial der künstlichen Intelligenz auszuschöpfen. Insgesamt war die Studie aus Montreal 2003 ein Meilenstein, der den Grundstein für die Entwicklung großer Sprachmodelle legte, die heute in unserem Alltag und in der Wissenschaft allgegenwärtig sind. Ohne diesen wichtigen Beitrag wäre der Weg zu den heutigen, hochentwickelten KI-Sprachsystemen deutlich länger und komplizierter gewesen. Die Arbeit steht somit beispielhaft für die Kraft von Forschung, die über Jahrzehnte hinweg innovative Technologien hervorgebracht hat, die unser Leben und Arbeiten nachhaltig verändern.

![EUV Photoresists: The Next Generation? [video]](/images/D0FDEF52-730D-40BF-9889-56F02DF59FD8)