In der heutigen Zeit, in der künstliche Intelligenz und insbesondere große Sprachmodelle (Large Language Models, kurz LLMs) eine zentrale Rolle in vielen Anwendungen spielen, wächst auch der Bedarf an Werkzeugen, die die Interaktion mit diesen Modellen transparent und nachvollziehbar machen. LLM Debugger ist ein solches Tool, das speziell für die Visualisierung und das Debugging von OpenAI API Gesprächen entwickelt wurde. Es bietet Entwicklern eine intuitive Möglichkeit, API-Aufrufe zu protokollieren, zu analysieren und Unterschiede zwischen einzelnen Konversationsschritten sichtbar zu machen. Diese Funktionalität ist entscheidend, um Fehler schneller zu finden, Prompt-Strategien zu vergleichen und die Nutzererfahrung nachhaltig zu verbessern.Die Vorteile von LLM Debugger liegen vor allem in seiner einfachen Handhabung und den umfangreichen Features, die ohne großen Konfigurationsaufwand genutzt werden können.

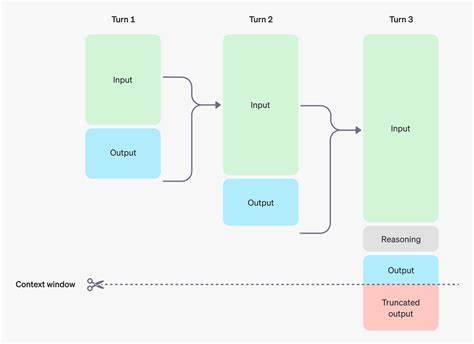

Mit nur einer Codezeile kann die bestehende OpenAI Client-Integration um Logging-Funktionalitäten ergänzt werden. Dies bedeutet, dass keine mühsame manuelle Sitzungsverwaltung oder zusätzliche Identifikationsmechanismen erforderlich sind. Die Software generiert automatisch sogenannte Session-IDs und erkennt, ob eine Unterhaltung fortgesetzt wird oder eine neue Sitzung startet. Dies geschieht per intelligenter Fingerprinting-Technologie, die Gespräche im Kern analysiert und mit einem Hashwert eindeutig identifiziert.Besonders wertvoll ist, dass LLM Debugger lokal auf dem Rechner läuft und die aufgezeichneten Daten ausschließlich auf dem eigenen System gespeichert werden.

Dies gewährleistet ein hohes Maß an Sicherheit und Privatsphäre, da keine Daten an externe Server gesendet oder über das Internet übertragen werden müssen. Gerade für Unternehmen und Entwickler aus regulierten Branchen ist dies eine nicht zu unterschätzende Eigenschaft. Die Protokolle werden strukturiert in JSON-Dateien abgelegt, die sich leicht weiterverarbeiten, durchsuchen oder archivieren lassen.Die Benutzeroberfläche der Anwendung ist bewusst einfach gestaltet und benötigt weder komplizierte Installationsprozesse noch das Einbinden von Node.js oder anderen Werkzeugen, die oft mit Frontend-Entwicklungen verbunden sind.

Die statischen Dateien sind vorkompiliert und direkt einsatzbereit, sodass auch Anwender ohne tiefgehende Programmierkenntnisse in kurzer Zeit einen Überblick über ihre LLM Gespräche erhalten. Die Oberfläche erlaubt das visuelle Vergleichen von verschiedenen Gesprächsverläufen, das Einsehen von Metadaten wie Latenzzeiten oder Modellversionen sowie die Hervorhebung von Tool- und System-Nachrichten – eine umfassende Analyse auf Knopfdruck.Darüber hinaus bietet LLM Debugger eine große Flexibilität in der Einbindung. Es kann als eigenständiger Service gestartet werden, der über einen lokalen Webserver erreichbar ist. Alternativ lässt sich das Tool auch in bestehende Webanwendungen integrieren, sodass die Log-Viewer Oberfläche unter einer beliebigen Route verfügbar gemacht werden kann.

Dies ist besonders für Entwickler relevant, die beispielsweise mit Frameworks wie FastAPI arbeiten und die Debugging-Funktion direkt in ihre Applikation einbinden möchten. Auch der Betrieb in Docker-Containern ist problemlos möglich, wodurch das Tool nahtlos in bestehende Entwicklungspipelines und Deployment-Prozesse integriert werden kann.Ein weiterer Pluspunkt ist die Framework-Agnostik von LLM Debugger. Es kann in jede Python-Anwendung eingebunden werden, unabhängig davon, ob es sich um eine einfache Skriptumgebung oder eine komplexe Agenten-Workflow-Lösung handelt. Das Tool lädt Entwickler ein, verschiedenste Einsatzszenarien abzudecken, in denen LLMs eingesetzt werden.

Egal, ob Chatbots, assistive Systeme, datengetriebene Plattformen oder automatisierte Empfehlungssysteme – die Transparenz beim API-Dialog kann signifikant erhöht werden.Technisch gesehen beruht die automatische Sitzungszuordnung auf einem ausgeklügelten Verfahren, das Konversationsinhalte normalisiert und daraus einen SHA-256-Hash erzeugt. So lassen sich Unterhaltungen eindeutig kennzeichnen und fortlaufende Dialoge über Sitzungsgrenzen hinweg erkennen. Diese persistente Zuordnung wird durch local gespeicherte JSON-Dateien gewährleistet, die beim Neustart der Anwendung geladen werden, um keine Kontexte zu verlieren. Die genaue Speicherung von Zeitstempeln, Modellinformationen und Anfragedetails ermöglicht darüber hinaus eine differenzierte Analyse von Leistungs- und Verhaltensparametern der KI.

In der Entwicklungsphase von KI-Anwendungen ist das Debugging der Schnittstelle zu OpenAI oft ein kritischer Faktor für den Erfolg. Fehlermeldungen oder unerwartete Modellantworten lassen sich mit LLM Debugger direkt im Kontext nachvollziehen und ihre Ursachen in den jeweiligen Prompts oder Konfigurationsparametern lokalisieren. Entwickler können so gezielt an Optimierungen arbeiten, unterschiedliche Prompt-Varianten miteinander vergleichen und zugleich nachvollziehen, wie sich Änderungen technisch auf die API-Replies auswirken. Diese Übersichtlichkeit spart viel Zeit und reduziert mehrfaches Testing mit Rate Limits und API-Kosten.Die Zukunft von LLM Debugger scheint vielversprechend, wobei bereits Funktionen für weitere Plattformen wie Anthropic Claude auf der Roadmap stehen.

Auch Features wie eine Wiederholfunktion für Gespräche, erweiterte Filtermöglichkeiten, Analysen auf UI-Ebene und die Möglichkeit, Berichte exportieren oder teilen zu können, sollen eingeführt werden. Die Open-Source-Lizenz unter MIT macht das Tool zudem attraktiv für Entwickler, die es an ihre individuellen Bedürfnisse anpassen und erweitern möchten.Zusammenfassend ist LLM Debugger ein essenzielles Werkzeug für jeden, der mit OpenAI Sprachmodellen arbeitet und mehr Transparenz, Kontrolle sowie Diagnosefähigkeit für seine Dialoganwendungen sucht. Die einfache Installation, der lokale Betrieb ohne Datenlecks und die umfangreichen Analysefunktionen machen es zu einem unverzichtbaren Helfer beim Entwurf, der Entwicklung und dem Betrieb moderner KI-basierter Lösungen. Wer Wert auf Qualität und schnelle Fehlersuche legt, profitiert enorm von einer visuellen und strukturierten Aufbereitung der oft komplexen Abfragen und Antworten.

Für Entwickler und Unternehmen, die ihre Projekte mit OpenAI oder vergleichbaren Modellen realisieren, eröffnet LLM Debugger neue Möglichkeiten, die Leistung ihrer Systeme messbar zu verbessern und die Nutzerzufriedenheit zu erhöhen. In einer Zeit, in der Vertrauen in künstliche Intelligenz und nachvollziehbare Ergebnisse immer wichtiger werden, liefert dieses Tool einen wertvollen Beitrag zum verantwortungsvollen Umgang mit automatisierten Sprachsystemen. Indem es auf Transparenz setzt und gleichzeitig den Datenschutz respektiert, wird LLM Debugger zum zuverlässigen Partner in der Arbeit mit Large Language Models und kann maßgeblich zum Erfolg von innovativen KI-Anwendungen beitragen.