In der modernen Softwareentwicklung spielt der effiziente Umgang mit Daten eine zentrale Rolle. Vor allem bei Anwendungen, die häufig Daten über Netzwerke übertragen oder persistieren müssen, ist die Art und Weise, wie Daten im Speicher repräsentiert und verarbeitet werden, entscheidend für die Performance und Skalierbarkeit. Klassischerweise kommt bei der Datenübertragung ein Serialisierungs- und Deserialisierungsprozess zum Einsatz, der allerdings zeitaufwändig ist und zu größeren Datenpaketen führt. Eine innovative Alternative bietet die sogenannte "Packed Data"-Technik, die nun auch in Haskell mit wachsenden Erfolg Einzug hält. Dieses Konzept ermöglicht es, Daten ohne Umwandlung direkt im kompakten Binärformat zu nutzen und somit Verarbeitungsschritte zu beschleunigen und effiziente Speicherzugriffe zu gewährleisten.

Haskell, bekannt für seine starke Typisierung und funktionale Programmierparadigmen, bietet mit dem Projekt "packed-data" eine Bibliothek, die genau diesen innovativen Ansatz verfolgt. Spannend an dieser Entwicklung ist, dass die Unterstützung für Packed Data in Haskell rein über die Typensicherheit und Metaprogrammierung realisiert wird, ohne Änderungen am Compiler vorzunehmen. Dadurch erhalten Entwickler leistungsfähige Werkzeuge, um komplexe Datenstrukturen wie Bäume direkt in einem gepackten Format abzubilden und zu verarbeiten, was besonders bei großen Datenmengen Vorteile bringt. Traditionell werden komplexe Datenstrukturen im Speicher über Zeiger realisiert, die auf unterschiedliche Speicherstellen zeigen. Dies macht zwar das Programmieren flexibel, ist aber für die Nutzung auf Netzwerkebene oder für die persistente Speicherung nicht optimal, da die Zeiger ihre Gültigkeit außerhalb des aktuellen Prozesses verlieren.

Deshalb erfolgt üblicherweise eine Serialisierung, bei der ein Objekt in ein transportfähiges Format wie JSON oder XML übertragen wird. Dieser Vorgang ist aufwendig, da sowohl Umwandlungszeit anfällt als auch das resultierende Datenformat oft deutlich umfangreicher ist. Die Folgen sind längere Übertragungszeiten und häufiger ein höherer Speicherverbrauch. Die Idee hinter Packed Data ist es, Daten so zu strukturieren, dass sie direkt als Binärdaten transportiert oder gespeichert werden können, ohne dass ein expliziter Serialisierungsprozess notwendig wird. Dabei werden alle Datenfelder „inline“ abgelegt, was bedeutet, dass keine Verweise oder Zeiger zwischen den Feldern existieren.

Dies führt zu einer kompakten, zusammenhängenden Speicherstruktur, die aufgrund ihrer Layout-Kohärenz die Effizienz moderner CPU-Caches, insbesondere des L1-Caches, optimal nutzt. Im praktischen Beispiel eines Baums wird dadurch erreicht, dass bei einem Traversieren keine Sprünge zu verschiedenen Speicherstellen nötig sind, sondern alle Elemente sequentiell abgearbeitet werden können – was die Laufzeit erheblich verbessern kann. Einer der bekannten Ansätze, der ähnliche Konzepte implementiert, ist Cap’n Proto, eine Bibliothek, die binäres Packing von Daten erlaubt und gleichzeitig schnellen Zugriff darauf bietet. Allerdings unterstützt kaum eine Programmiersprache nativ diese Form von Datenrepräsentation. Haskell hat mit Compact Normal Forms (CNF) zwar Ansätze für Kompaktheit, doch fehlt dort oftmals die Möglichkeit, auf die Werte direkt zuzugreifen.

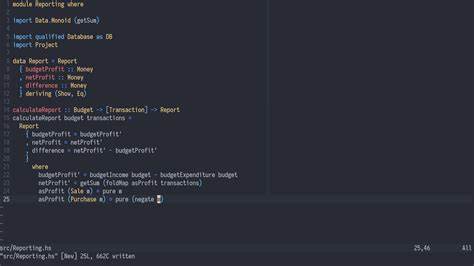

Die Forschung hat sich bereits mit Lösungen wie dem Gibbon Compiler beschäftigt, der funktionale Programme auf gepackte Datenstrukturen übersetzt. Doch bislang war der praktische Einsatz oft durch Komplexität oder fehlende Integration beschränkt. Die neue "packed-data" Haskell-Bibliothek schlägt genau hier eine Brücke: Sie nutzt die Metaprogrammierung mit Template Haskell, um automatisch für beliebige Datentypen Methoden zum Packen, Entpacken und Traversieren zu generieren, ohne dass der Entwickler dafür manuell komplexen Code schreiben muss. Die gesamte Operation bleibt dabei typsicher, was Fehlerquellen minimiert und die Integration nahtlos gestaltet. Im Zentrum der Implementation stehen abstrahierte Bausteine wie der "NeedsBuilder" und der "PackedReader".

Der NeedsBuilder übernimmt die Aufgabe, beim Packen einen Zwischenspeicher aufzubauen, der phasenweise Daten aufnimmt und am Ende ein gepacktes Binärpaket produziert. Dabei sorgen sogenannte Phantomtypen dafür, dass beispielsweise erst dann ein vollständiges Paket vorliegt, wenn alle erforderlichen Daten eingefügt sind, was den Buildprozess sicher und nachvollziehbar macht. Der PackedReader hingegen ist als indexed Monad implementiert und sorgt für das sichere und strukturierte Lesen von gepackten Datenblöcken. Durch die genaue Typisierung wird garantiert, dass nur passende Datentypen gelesen werden können, was Zugriffsfehler auf gepackte Speicherbereiche verhindert. Hinter dieser Monadenabstraktion steckt ein Cursor-Mechanismus, der bei jeder Lesebewegung den Lesepositionstyp aktualisiert und so den Fortschritt dokumentiert.

Eine zentrale Funktion, die automatisch für jeden gepackten Datentyp erzeugt wird, ist die sogenannte "case"-Funktion. Sie ermöglicht es, eine Datenstruktur anhand ihrer Konstruktoren zu analysieren und darauf basierende Logik anzuwenden – eine Struktur, die man aus normalen Algebraischen Datentypen kennt. Innerhalb der gepackten Datenwelt stellt dies sicher, dass selbst verschachtelte Typen effektiv durchlaufen und bearbeitet werden können, ohne vorher deserialisiert werden zu müssen. Eine weitere Herausforderung beim Umgang mit gepacktem Daten sind sogenannte Indirections, also Sprünge innerhalb der Daten, die notwendig sind, wenn Felder variabler Länge im Speicher liegen. Hier bietet die Bibliothek den Mechanismus von „FieldSize“, der es erlaubt, Längeninformationen zwischenzuspeichern, um gezielte Zugriffe ohne komplettes Traversieren zu ermöglichen.

Dies ist besonders bei rekursiven Strukturen wie Bäumen wichtig, um Performanceeinbußen zu vermeiden. Praktische Anwendungsbeispiele zeigen, wie man beispielsweise den rechtsmosten Wert eines gepackten Binärbaums lesen oder die Summe aller Blätter effizient berechnen kann. Dabei fasziniert, dass sich solche Operationen ähnlich elegant formulieren lassen wie im nativen Haskell, allerdings auf bereits kompakten Binärdaten und somit mit weniger Kosten für Speicherzugriffe. Leistungsbenchmarks zeigen jedoch ein gemischtes Bild. In manchen Szenarien, beispielsweise beim Auswerten von arithmetischen Ausdrücken innerhalb gepackter Daten, kann die Performance sogar die nativer Implementierungen in C oder Haskell übertreffen.

In anderen Fällen, etwa beim einfachen Auslesen von Baumwerten, sind aufgrund der notwendigen Monaden- und IO-Abstraktionen noch Leistungseinbußen zu verzeichnen. Dies weist auf einen interessanten Optimierungsspielraum hin, der zum Beispiel durch die Generierung dedizierten Maschinencodes mittels Template Haskell und Foreign Function Interface (FFI) adressiert werden könnte. Die wichtigsten Erkenntnisse aus der aktuellen Entwicklung sind, dass dank fortschrittlicher Typensysteme und Metaprogrammierung das Prinzip der Packed Data auch ohne Eingriffe in den Compiler realisierbar ist. Obwohl gewisse Overheads durch Abstraktionen bestehen, ist das Konzept vielversprechend und eröffnet neue Wege für effiziente und sichere Datenverarbeitung in Haskell. Auch die Übertragbarkeit des Ansatzes auf andere stark typisierte Sprachen wie Rust, Scala oder sogar TypeScript bietet spannende Perspektiven.

Nicht zuletzt ist der mögliche Nutzen für Netzwerkapplikationen hervorzuheben. Während heute fast immer JSON als Datenaustauschformat verwendet wird, wäre die Fähigkeit, diese Daten als stark typisierte gepackte Binärdaten direkt zu verwenden, ein großer Fortschritt. Dies könnte Latenzen reduzieren, Bandbreitenanforderungen minimieren und die Sicherheit erhöhen, indem Deserialisierungsfehler vermieden werden. Zusammenfassend stellt die Unterstützung für Packed Data in Haskell eine bedeutende Innovation dar, die theoretisch und praktisch neue Maßstäbe für die Datenverarbeitung setzen kann. Sie verbindet die Vorteile funktionaler Programmierung mit hochperformanter Speicher- und Netzwerktechnik.

Die Kombination aus Typensicherheit, Performance und Portabilität macht diesen Ansatz gerade für Anwendungen interessant, die große Datenmengen handhaben oder in verteilten Systemen agieren. Während die Forschung und Entwicklung weitergehen, bleibt die Nutzung von Packed Data ein spannender Trend, der nachhaltig die Art und Weise beeinflussen kann, wie Programme in der Zukunft gestaltet werden.