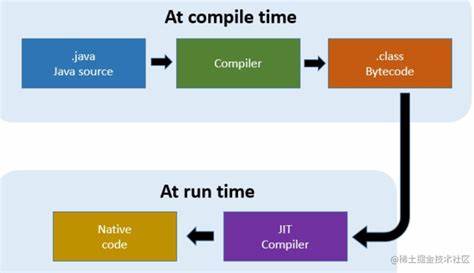

Die Entwicklung von maschinellen Lernbibliotheken im Browser hat in den letzten Jahren einen enormen Fortschritt erfahren. Besonders bemerkenswert ist das Projekt jax-js, das darauf abzielt, JAX, eine etablierte Python-Bibliothek für numerische Berechnungen und maschinelles Lernen, in reines JavaScript zu portieren. Im Zentrum dieses Fortschritts steht der jax.jit() Just-in-Time (JIT) Compiler, der komplexe mathematische Operationen optimiert und auf GPU-Architekturen ausführt, ohne die Nachteile herkömmlicher Ansätze mit den üblichen Verzögerungen und Overheads. Doch wie genau funktioniert dieser Compiler in jax-js und welche Probleme löst er? Der folgende Einblick beleuchtet die Grundlagen und technischen Details hinter jax.

jit() und zeigt, warum diese Entwicklung wegweisend für numerische Berechnungen im Browserumfeld ist. Zunächst einmal ist JAX eine leistungsstarke Bibliothek, die numerisches Rechnen auf Grundlage von NumPy-Funktionalitäten ermöglicht, ergänzt durch GPU-Beschleunigung und automatisches Differenzieren (Autograd). Ursprünglich für Python entwickelt, erlaubt JAX komplexe mathematische Operationen bequem und effizient. Die Herausforderung bei jax-js besteht darin, diese Funktionalitäten in eine browserfreundliche Umgebung zu bringen. Dabei stellt sich die Frage, wie man numerische Daten und Tensoroperationen nicht nur im CPU-Umfeld, sondern auch mit GPU-Unterstützung ausführen kann, ohne auf native CUDA-Programmiermodelle zurückgreifen zu müssen, die im Web schlichtweg nicht verfügbar sind.

Ein einfaches, aber ineffizientes Vorgehen wäre, alle Berechnungen unmittelbar CPU-seitig aufzuteilen und jede Operation als isolierten Aufruf an ein WebAssembly-Modul auszuführen. Solch eine naive Methode verursacht jedoch wiederholt Datentransfers zwischen CPU und GPU, was zu erheblichen Performanceeinbußen führt. Nehmen wir die Berechnung der Norm einer manipulierten Vektorreihe als Beispiel. Wenn die Berechnung in einzelne Schritte zerfällt – etwa Multiplikation, Addition, Quadratierung, Summierung und Wurzelziehen – so können diese nacheinander jeweils eigene Round-Trips zur GPU erzwingen. Diese Latenzen summieren sich und bremsen Rechenprozesse insbesondere bei größeren Datenmengen deutlich aus.

Genau hier setzt der jax.jit() JIT-Compiler an. Inspiriert vom XLA-Compiler von JAX, der Rechenoperationen als gerichtete azyklische Graphen repräsentiert, konstruiert jax-js ein Zwischenrepräsentationsmodell (Intermediate Representation, IR), das mathematische Operationen ausdrucksstark und effizient abstrahiert. Dieses IR, basierend auf dem kleinen Deep-Learning-Framework tinygrad, ermöglicht es, Operationen miteinander zu verschmelzen (Fusion), so dass weniger Round-Trips nötig sind und komplexe Ausdrücke als ein einziger kompakter GPU-Kernel ausgeführt werden können. Der Schwerpunkt liegt dabei auf einem schlanken Design, das trotz der reduzierten Codebasis deutliche Leistungsverbesserungen gegenüber reinen CPU- oder einer Kombination von Einzeloperationen bietet.

Die IR in jax-js basiert auf der sogenannten AluExp-Klasse, die mathematische Ausdrücke auf Skalarwerten beschreibt. Diese Ausdrücke können andersartig verschachtelt sein, jeweils mit deren Operationstyp, Datentyp und Quellen. Die Operationen selbst sind dabei stark vereinfacht und fokussieren auf grundlegende Rechenoperationen. Eine besondere Rolle spielt die Fähigkeit, sogenannte Views zu verfolgen, also unterschiedliche Betrachtungsweisen desselben Datensatzes, ohne dabei unnötige Kopien anzufertigen. Diese Sichtweise erlaubt es, Datenbewegungen effizient zu handhaben und somit den Speicher-Overhead zu minimieren.

Jeder optimierte Kernel in der jax-js-Architektur fasst mehrere dieser verschmolzenen Ausdrücke in einem Block zusammen, wobei jedoch immer nur eine Reduktionsoperation pro Kernel zulässig ist. Diese Regel vereinfacht die Analyse und Optimierung des graphbasierten Rechenplans, da Reduktionen – beispielsweise Summierungen – besondere Aufmerksamkeit für Performanceverbesserungen benötigen. Der modernere JIT-Ansatz nutzt das Konzept der dynamischen Graphen und der sogenannten Tracing-Funktion. Dabei wird eine computationale Funktion bei ihrem ersten Aufruf mit bestimmten Input-Dimensionen analysiert, um den vollständigen Berechnungsgraphen zu erfassen. Die Funktion wirkt also wie ein Detektiv, der jeden Rechenschritt aufzeichnet, um später die bestmögliche Ausführung zu gewährleisten.

Das Ergebnis der Analyse ist ein Jaxpr, ein DAG aus Operationen, der im kompakten IR-Format vorliegt und zur Kompilierung direkt an den Backend-Compiler übergeben wird. Dieser Prozess minimiert Laufzeit-Overhead bei Folgeausführungen mit ähnlichen Eingaben und fördert zudem die Kernel-Fusion. Ein hervorragendes Beispiel dieses Konzepts zeigt sich bei matrixmultiplikationen. Anstatt eine naive Rechenweise, die viele Zwischenoperationen und Speicherallokationen erzeugt, kann mithilfe von jax.jit() ein kompakter, optimierter Kernel erzeugt werden, der die notwendigen Reshaping- und Transpositionsschritte mit der elementweisen Multiplikation und anschließenden Summierung in einem Schritt ausführt.

Das führt zu einem beeindruckenden Geschwindigkeitszuwachs und effizienteren GPU-Auslastung. Dabei ist besonders fasziniertlich, dass jax-js durch diese Vorgehensweise viele der hochtechnischen Optimierungen von XLA zwar nicht vollständig reproduziert, aber dennoch eine optimale Nutzbarkeit im Browser ermöglicht. Das bedeutet, dass Nutzer von Anwendungen, die jax-js nutzen, von performanter numerischer Berechnung und maschinellem Lernen profitieren können, ohne sich um die komplexe Verwaltung von Hardware- und Softwareinfrastruktur kümmern zu müssen. Neben den Performanceaspekten adressiert jax-js auch die Herausforderungen des Speicher-Managements im JavaScript-Umfeld. Im Gegensatz zu Sprachen wie Python, die über destruktive Methoden wie __del__ verfügen, steht JavaScript nicht über vergleichbare Mechanismen zur Verfügung.

Dies erschwert die automatische Freigabe von nicht mehr benötigtem Speicher, was besonders bei großen Datenmengen und wiederholten Berechnungen hohe Anforderungen an das Garbage-Collection-System stellt. Entwicklungsansätze wie die Verwendung linearer Typen könnten hier zukünftig Abhilfe schaffen, um explizitere Kontrolle über Speicherlebenszeiten zu implementieren und Fragmentierung zu vermeiden. Auf der Backend-Seite bietet jax-js sowohl WebAssembly- als auch WebGPU-Unterstützung. WebGPU ist eine relativ neue, vielversprechende Schnittstelle, die direkten GPU-Zugriff im Browser ermöglicht und so sehr nahe an native Performance heranführt. Die Kombination aus hochoptimiertem IR, smarter Kernelfusion und moderner Hardwarebeschleunigung macht jax-js somit im Bereich Browser-basiertes maschinelles Lernen zu einem der besten verfügbaren Tools.

Erwähnenswert ist zudem, dass jax-js flexible APIs anbietet, die sich an NumPy und JAX orientieren, aber in gewohnter JavaScript-Umgebung nutzbar sind. Eine einfache Nutzung von Funktionen wie grad() zur Ableitungsberechnung oder komplexen numerischen Operationen ist somit gewährleistet. Entwickler können so in einem einzigen Ökosystem bleiben und müssen keine hybride Softwarelandschaft mit Python-Backend und JavaScript-Frontend pflegen. Der Einfluss dieses Projekts könnte branchenweit bedeutend sein. Durch jax-js wird es möglich, datenintensive, rechenaufwändige Algorithmen direkt auf dem Client durchzuführen, was die Netzwerklast reduziert und die Privatsphäre erhöht, weil Daten nicht zwangsläufig an entfernte Server geschickt werden müssen.

Gleichzeitig ermöglichen optimierte Kompilierungsstrategien wie jax.jit(), dass selbst komplexeste Modelle und Simulationen in Echtzeit laufen können – von Fluiddynamik über Audioverarbeitung bis hin zu neuronalen Netzwerken. Abschließend lässt sich festhalten, dass der jax.jit() JIT-Compiler den Kern des Fortschritts von jax-js bildet. Durch die Kombination von kompaktem IR, strategischer Kernelfusion, dynamischem Tracing und moderner Hardwarebeschleunigung stellt er eine innovative Lösung dar, um maschinelles Lernen und numerisches Rechnen effizient und benutzerfreundlich in Browserumgebungen umzusetzen.

Dieses Projekt verspricht, den Weg für neue Anwendungen zu ebnen, die bisher aufgrund technischer Limitierungen unmöglich schienen. Für Entwickler und Wissenschaftler im Bereich Data Science, maschinelles Lernen und Webtechnologien ist jax-js damit eine Bibliothek, die man im Auge behalten sollte.

![continuous wave : re-formation : 1.0.8 [video]](/images/049F1AF2-0A20-4D8A-8739-B3A85EA79A2F)