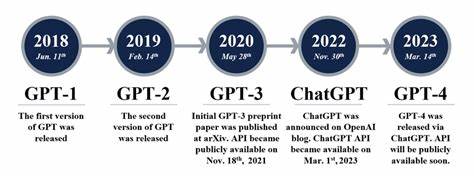

Die rasante Entwicklung im Bereich der Künstlichen Intelligenz, insbesondere bei großen Sprachmodellen (LLMs), hat die Technologie- und Entwicklergemeinschaft in den letzten Jahren nachhaltig verändert und inspiriert. Angefangen bei GPT-3, das anfangs als Maßstab galt, hat sich die Landschaft mit offenen Modellen, neuen Techniken und lokalen Laufzeitvarianten dramatisch weiterentwickelt. Dieses Wachstum spiegelt nicht nur technische Innovationen wider, sondern zeigt auch, wie eine engagierte Community den Zugang zu KI demokratisiert und neue Anwendungsmöglichkeiten geschaffen hat. Die Zeit von GPT-3 wurde von vielen als eine Art Initialzündung empfunden. OpenAI hatte mit GPT-3 ein Modell erschaffen, das mit 175 Milliarden Parametern eine völlig neue Dimension im Verständnis und Erzeugen von natürlicher Sprache eröffnete.

Viele Entwickler und Enthusiasten folgten gespannt den Fortschritten, doch das Modell war nur über OpenAI´s API zugänglich und Open Source war es nicht. Die Faszination für diese Technologien sorgte jedoch dafür, dass sich viele begannen Fragen zu stellen: Wie können wir ähnliche Fähigkeiten auf unseren eigenen Maschinen realisieren? Kann man solche riesigen Modelle überhaupt lokal ausführen? Parallel zu GPT-3 begann die Open-Source-Community erste Gegenbewegungen zu etablieren. Das 176 Milliarden Parameter starke Modell BLOOM war ein wichtiger Meilenstein. Zwar konnte es nicht ganz mit GPT-3 mithalten, bot jedoch die erste wirklich offene Alternative ohne Quantisierung. Die Bedeutung dieses Schritts lag nicht nur in der Modellgröße, sondern auch im Prinzip: Mehr Transparenz und Zugang für Entwickler, Forscher und experimentierfreudige Nutzer.

Diese Entwicklungen waren allerdings nur der Anfang. Die Enthusiasten-Szene um lokale AI-Modelle war zunächst eher klein, zumeist einige tausend Menschen, die sich für das Thema begeisterten. Sie beobachteten die Fortschritte bei OpenAI, träumten aber davon, solche hohen Rechenleistungen auch auf ihren eigenen Geräten lokal verwenden zu können – oft mit begrenzter Hardware und ohne Zugriff auf Cloud-Lösungen. Hier lag die Herausforderung und zugleich die Motivation: Wie kann man diese komplexen Modelle effizienter machen und auf Hardware aus der Consumer-Klasse laufen lassen? Die Leaks von Metas Llama-Modellen, vor allem Llama-1, hatten einen enormen Einfluss auf die Entwicklung. Zwar war Llama-1 nicht besser als GPT-3.

5, aber es leitete eine neue Ära ein. Entwickler begannen zu prüfen, wie man Modelle dieser Größenordnung auf CPUs ausführen kann. Llama.cpp war ein großer Durchbruch. Es zeigte, dass selbst ohne leistungsstarke GPUs das Verwenden von LLMs möglich ist.

Damit eröffnete sich die Möglichkeit für viele Nutzer, sich mit KI-Modellen zu befassen, die vorher für sie komplett außer Reichweite lagen. Ein weiterer entscheidender Fortschritt war die Einführung von Quantisierungstechniken, die es erlauben, Modelle stärker zu komprimieren und somit Ressourcen zu sparen. GGML-Quants (die später in GGUF umbenannt wurden) machten LLMs deutlich zugänglicher, wodurch der Einsatzumfang massiv erweitert wurde. Diese Entwicklungen beschleunigten den Trend, kleinere Modelle zu bauen und trotzdem eine hohe Leistungsfähigkeit zu gewährleisten. Unternehmen wie Mistral traten in den Vordergrund, um diese Innovationen mit eigenen Modellen und Techniken wie Mixture of Experts (MoE) voranzutreiben.

Besonders ihre mistral-7b und mixtral-Modelle beeindruckten durch eine Kombination aus Effizienz und Leistung. Diese Fortschritte wirkten als Katalysator für weitere Entwicklungen in der Open-Source-Szene und zeigten das enorme Potenzial kleinerer, maßgeschneiderter Modelle. Die Community war und ist eine treibende Kraft hinter der Produktion und Verbreitung von Model-Varianten und Finetunes. TheBloke, ein besonders engagierter Akteur, verschaffte der Szene Zugang zu unzähligen quantisierten Modellen. Seine Arbeit hat viele Nutzer inspiriert und den Zugang erleichtert, doch leider wurde es nach einer Zeit still um ihn, was viele bedauerten und auf sein Wohlergehen hoffen lässt.

Neben den technischen Errungenschaften zeigte sich bei den Projektnamen die beinah spielerisch kreative Seite der Community. Besonders „oobabooga“ wurde als Synonym für den „Text Generation Web UI“ berühmt – einer von vielen Webinterfaces, um LLMs einfach und lokal zu benutzen. Solche Projekte waren Ausdruck der Begeisterung für KI und des Willens, sie jedem Nutzer zugänglich zu machen. Als immer mehr Firmen das enorme Marktpotenzial von Sprachmodellen erkannten, setzte eine Kommerzialisierung ein. Dennoch blieb ein großer Teil der Community bestrebt, Modelle und Tools kostenlos und öffentlich zugänglich zu machen.

Dabei stellte sich oft die Frage nach Lizenzierung und Verantwortung, da manche Modelle zwar verfügbar waren, aber unter restriktiven Bedingungen standen, auf die manche Nutzer leichtsinnig verzichteten. Eine wahre Revolution auf dem Gebiet der Anpassbarkeit stellte die Einführung von LoRA (Low-Rank Adaptation) und später QLoRA dar. Diese Techniken ermöglichten es, Modelle mit geringem Rechenaufwand auf individuelle Anwendungsfälle zu verfeinern, ohne komplette Neukonfiguration. Die Vielfalt der Finetunes war enorm, von spezialisierten Chatbots über Rollenspiel-KI bis hin zu kreativen Anwendungen. Die Beliebtheit von Rollenspielelementen zeigte wie vielfältig die Einsatzbereiche von KI bereits waren.

Allerdings brachten diese neuen Möglichkeiten auch Herausforderungen mit sich: Sicherheit und Ethik wurden zunehmend diskutiert, insbesondere wie prompt injections und andere Methoden dazu benutzt werden konnten, bestehende Filter und Schutzmechanismen zu umgehen. Das Bewusstsein für diese Gefahren wuchs, ist aber bis heute eine der zentralen Aufgaben in der KI-Entwicklung. Heute, nur drei Jahre nach dem Start von GPT-3, gibt es eine Vielzahl von offenen Modellen mit frei verfügbaren Gewichten. Wirklich komplett Open-Source ist davon allerdings nur ein kleiner Teil. Vielmehr profitieren Nutzer von einer lebendigen Landschaft an Tools, Wrappern und ganzen Applikationen, die um diese Modelle herum entstanden sind.

Auch wenn viele Projekte mittlerweile nicht mehr aktiv gepflegt werden, zeigt dies das große Interesse und die experimentelle Phase, in der sich die KI-Community befindet. Mit dem Start von GPT-4 wurde das Tempo der Innovationen weiter angeheizt. Wissenschaftliche Veröffentlichungen und neue Modelle überschwemmten die Feeds von Forschern und Entwickler*innen. Die schiere Menge an Neuheiten ließ einige fast schon an das Gefühl der Singularität denken – auch wenn wir davon noch weit entfernt sind. Die Innovationsgeschwindigkeit und Notwendigkeit des ständigen Lernens sind jedoch beeindruckend.

Interessanterweise zeigte sich, dass die Befürchtungen, GPT-3 und vergleichbar leistungsfähige offene Modelle könnten gesellschaftlichen Schaden anrichten, sich bislang nicht bestätigt haben. Im Gegenteil: Die Verfügbarkeit und Vielfalt dieser Werkzeuge haben viele neue Geschäftsideen angestoßen und kreative Anwendungen ermöglicht. Auch die Hardware-Frage bleibt ein wichtiger Aspekt der Entwicklung. Nutzer fragen sich oft, ob ihre Gaming-GPUs wie eine RTX 3090 leistungsfähig genug sind, um selbst große Modelle lokal auszuführen. Gerade hier hofft die Community auf mehr Wettbewerb in der Grafikkartenindustrie, sodass AMD, Intel oder Apple für Entlastung vom Nvidia-Monopol sorgen können.

Günstigere und leistungsfähigere Hardware wäre ein großer Vorteil für eine breitere Verfügbarkeit von KI-Technologien. Die Reise vom rudimentären BLOOM-Modell über die Innovationsfreude der Community bis hin zur Kommerzialisierung und immer neuen technischen Durchbrüchen hat viele Menschen inspiriert und verändert. Für viele ist es nicht nur ein technisches Feld, sondern eine Gemeinschaft, in der man ständig lernt und sich gegenseitig unterstützt. Die Zukunft der Künstlichen Intelligenz bleibt spannend, geprägt von Offenheit, Innovation und dem Wunsch, Technologie für möglichst viele zugänglich zu machen.