Moderne Technologien wie Gesichtserkennungssysteme sollen Sicherheitslücken schließen und Diebstähle in Geschäften verhindern. Doch wie der Fall der Britin Danielle Horan zeigt, können technische Fehler schwerwiegende Auswirkungen auf das Leben unschuldiger Menschen haben. Danielle wurde fälschlicherweise beschuldigt, Kosmetik- und Hygieneartikel gestohlen zu haben – eine Erfahrung, die sie als zutiefst belastend und traumatisch empfand. Dieser Vorfall wirft Fragen zur Verlässlichkeit der Technik, zum Datenschutz sowie zu den ethischen und rechtlichen Implikationen der Nutzung solcher Systeme auf. Danielle Horan, eine Geschäftsfrau aus Greater Manchester, wurde im Frühjahr 2025 an zwei Standorten der Einzelhandelskette Home Bargains unerwartet gebeten, die Läden zu verlassen.

Die Gründe blieben zunächst unklar, was ihr nicht nur peinlich, sondern auch äußerst beunruhigend war. Nach intensiven Nachfragen und langem Kampf erhielt sie schließlich die Information, dass sie aufgrund eines angeblichen Diebstahls auf einer Überwachungsliste für Ladendiebe stand. Das Gesichtserkennungssystem einer Sicherheitsfirma namens Facewatch hatte sie fälschlicherweise identifiziert. Der vermeintliche Diebstahl bezog sich auf Toilettenpapier im Wert von etwa zehn Pfund, das sie jedoch ordnungsgemäß bezahlt hatte. Dieser Fall ist kein Einzelfall.

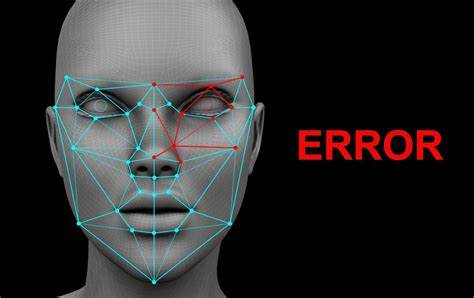

Immer mehr Menschen melden ähnliche Beschwerden bei Organisationen wie Big Brother Watch, die sich für Bürgerrechte und Datenschutz einsetzen. Hier wird deutlich, dass die zunehmende Automatisierung und Digitalisierung von Sicherheitsprozessen nicht nur Vorteile mit sich bringt, sondern auch neue Gefahren birgt. Insbesondere bei persönlichen biometrischen Daten muss Vorsicht geboten sein, da Fehler oder Missbrauch schwerwiegende, oft nicht sofort erkennbare Folgen haben. Gesichtserkennungstechnologie arbeitet mit Algorithmen, die visuelle Daten mit gespeicherten Profilen abgleichen. Ziel ist es, bekannte Täter frühzeitig zu erkennen und Sicherheitskräfte zu alarmieren.

Doch die Systeme sind nur so akkurat wie die zugrundeliegenden Daten und Algorithmen. Fehlalarme können beispielsweise durch unvollständige oder fehlerhafte Daten entstehen, oder wenn vermeintliche Übereinstimmungen falsch gewertet werden. Im schlimmsten Fall führt dies dazu, dass Unschuldige öffentlich beschuldigt, stigmatisiert und diskriminiert werden – ohne faire Anhörung oder einfache Möglichkeit der Korrektur. Danielle Horan schilderte, wie belastend die Situation für sie war. Wiederholte Demütigungen in den Geschäften, Angst vor weiterer öffentlicher Bloßstellung und Unsicherheit sorgten für erheblichen emotionalen Stress.

Psychische Folgen wie Angstzustände und starke Belastungen durch die Unsicherheit, unschuldig beschuldigt zu werden, wurden deutlich. Zudem erlebte sie zunächst große Schwierigkeiten, überhaupt eine Erklärung von Facewatch oder Home Bargains zu erhalten. Die mangelnde Transparenz und die fehlenden klaren Wege zur Anfechtung der Vorwürfe verstärken die Problematik. Die Betreiber solcher Systeme – wie die Sicherheitsfirma Facewatch – erkennen inzwischen die Notwendigkeit strengerer Kontrollen. Im Fall von Danielle führte dies sogar zur vorübergehenden Aussetzung der Nutzung der Technologie in den betroffenen Filialen.

Gleichzeitig fordern zivilgesellschaftliche Organisationen eine grundsätzliche Überprüfung und Restriktion des Einsatzes von Gesichtserkennung im Einzelhandel. Kritiker argumentieren, dass diese Technologie angesichts der aktuellen Fehleranfälligkeit und der oft massiven Eingriffe in die Privatsphäre nicht mit bestehenden Rechtsprinzipien kompatibel sei, insbesondere dem Grundsatz der Unschuldsvermutung. In Großbritannien ist der Einsatz kommerzieller Gesichtserkennung rechtlich erlaubt, allerdings nur unter strikter Einhaltung von Datenschutzgesetzen. Diese schreiben vor, dass biometrische Daten rechtmäßig, transparent und verhältnismäßig verarbeitet werden müssen. Im Verhältnis zu ihrer weitreichenden Wirkung stellen viele Experten und Datenschützer die Frage, ob Gesichtserkennungssysteme im Einzelhandel überhaupt noch mit diesen Regeln vereinbar sind.

Die Debatte geht einher mit ethischen Überlegungen zu Überwachung, individuellem Schutz und gesellschaftlicher Kontrolle. Die öffentliche Aufmerksamkeit, die der Fall Danielle Horan bekam, hat verdeutlicht, wie wichtig es ist, Verbraucherrechte zu stärken und die Mechanismen zur Fehlerbehebung bei Überwachungstechnologien zu verbessern. Dazu gehört auch, klare Ansprechpartner und unkomplizierte Prozesse für Betroffene zu schaffen, damit Fehlidentifikationen zügig korrigiert werden können. Nur so lassen sich Vertrauen in der Gesellschaft aufbauen und Fehlurteile verhindern. Darüber hinaus stellt sich die Frage nach der Rolle der Einzelhändler.

Sie tragen große Verantwortung bei der Auswahl und Anwendung von Überwachungstechnologien und bei der Schulung ihrer Mitarbeiter. Oft sind es einfache Angestellte, die vor Ort mit den Folgen konfrontiert werden und unzureichend vorbereitet sind, um mit komplexen technischen Fehlfunktionen umzugehen. In Daniele Horan's Fall wurde von Seiten des Retailers keine unmittelbare Erklärung angeboten, was die Situation noch verschärfte. Auf politischer Ebene fordert der Vorfall eine sorgfältige Abwägung zwischen Sicherheitsinteressen und dem Schutz der Bürgerrechte. Die Forderung nach einem vollständigen Verbot von Gesichtserkennungssystemen im Einzelhandel wird dabei von mehreren Seiten laut.

Gleichzeitig sollte man jedoch nicht die Chancen außer Acht lassen, die solche Technologien bieten können, wenn sie verantwortungsvoll und präzise eingesetzt werden – zum Beispiel im Kampf gegen organisierte Kriminalität. Entscheidend ist, dass die gesetzlichen Rahmenbedingungen angepasst und die technischen Systeme weiterentwickelt werden, um Fehlerquoten zu minimieren. Der Fall Danielle Horan mahnt eindringlich, die Risiken der Gesichtserkennung und damit verbundener Überwachungssysteme nicht zu unterschätzen. Technologische Innovationen dürfen nicht zulasten der Grundrechte und der Unschuldsvermutung gehen. Es braucht transparente Verfahren, klare Rechtsmittel und eine kritische öffentliche Debatte, um die Balance zwischen Technologieeinsatz und Datenschutz zu wahren.