Der Commodore 64 gehört zu den bekanntesten Heimcomputern der 1980er Jahre und prägt noch heute die Welt der Retro-Computerfreaks und Technikenthusiasten. Trotz der begrenzten Rechenleistung und des limitierten Arbeitsspeichers ist es einem engagierten Entwicklerteam gelungen, Llama2.c, ein modernes KI-Sprachmodell, auf den Commodore 64 zu portieren. Dieses Projekt, bekannt als Llama2.c64, verbindet die Nostalgie der klassischen 8-Bit-Hardware mit den Möglichkeiten moderner künstlicher Intelligenz und eröffnet neue Perspektiven, wie altbewährte Technologie neu genutzt werden kann.

Im Folgenden wird das Projekt detailliert vorgestellt, seine technischen Herausforderungen beleuchtet, die praktische Nutzung erklärt und Potenziale für die Zukunft aufgezeigt. Die Grundlage von Llama2.c64 bildet das ursprüngliche Llama2.c, ein auf C basierendes KI-Modell, das Sprachverarbeitung ermöglicht. Bei der Portierung auf den Commodore 64 war es essenziell, die besonderen Hardware-Beschränkungen zu berücksichtigen.

Der C64 verfügt standardmäßig nur über 64KB RAM, was für moderne KI-Anforderungen winzig ist. Mit der Verwendung einer RAM-Erweiterung (REU) von mindestens 2 MB – ein Zusatzspeicher auf einem inzwischen kaum mehr gebräuchlichen Erweiterungsgerät – konnte das Modell so angepasst werden, dass es seine Leistungen auf dem System entfalten kann. Die REU mit 2 MB Speicher ist also unverzichtbar, um das Gewicht der Modellparameter und Tokenizer-Daten unterzubringen. Llama2.c64 verwendet ein spezielles Modell namens tinystories, trainiert auf dem TinyStories Datensatz.

Diese Sammlung kurzer, kindgerechter Geschichten stammt ursprünglich aus der TinyLlamas-Initiative und ist perfekt dafür geeignet, ein einfach verständliches Sprachmodell zu generieren, das wie ein kleines Kind einfache Erzählungen fortsetzen kann. Dabei handelt es sich nicht um ein Chatmodell im klassischen Sinne, sondern um eine geschickte Weiterführung von Eingabe-Texten. Dies bringt den Charme und die Limitierungen eines 3- bis 4-jährigen Kindes in digitale Form und macht das Projekt besonders einzigartig. Die technische Ausstattung für den Betrieb von Llama2.c64 umfasst neben dem klassischen C64 mit REU-Minimalgröße von 2 MB zusätzliche Dateien, welche die Modelleigenschaften und Gewichtungen in für den C64 verständlichen Formaten enthalten.

Das sind unter anderem tokenizer.bin, config.bin und weights.reu. Die Gewichte sind unverändert im Float-32-Format hinterlegt und in der RAM-Erweiterung abgelegt, während der Tokenizer und andere wichtige Datenstrukturen im normalen RAM verbleiben.

Um diese komplexen Modelle in die Ressourcengrenzen des Commodore 64 zu bringen, mussten effiziente Encodierungen und Sparmaßnahmen angewandt werden. Beispielsweise werden Vokabulare mit Null-terminierten Strings gespeichert und bestimmte Rechenoperationen wurden eigens angepasst oder leicht optimiert, wie die Funktionen für Sinus, Kosinus und Exponential in math.c, die originale Algorithmen aus dem BASIC ROM des C64 abbilden. Die Anwendung ist kompatibel mit populären Emulatoren wie VICE, dessen Konfiguration durch das Aktivieren des REU und Auswahl des REU-Images weights.reu ermöglicht wird.

Alternativ funktioniert die Software auch mit der Hardware-Erweiterung Ultimate II+, die die REU-Funktionalität direkt in der Cartridge emuliert. Für Entwickler oder Retro-Enthusiasten birgt das Projekt auch eine Makefile-basierte Build-Umgebung, die nicht nur das Kompilieren vereinfacht, sondern auch die automatische Generierung der notwendigen Modelldateien ermöglicht. Darüber hinaus kann das Programm durch Verwendung des Exomizer komprimiert werden, was die Handhabung auf realer Hardware speziell vereinfacht. Die Performance von Llama2.c64 ist naturgemäß durch die Hardware begrenzt.

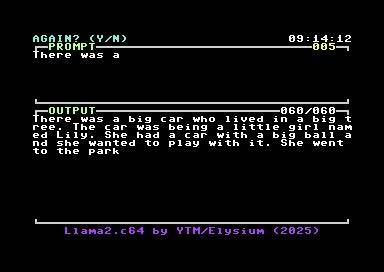

Die Erzeugung eines einzelnen Tokens dauert im Durchschnitt etwa acht Minuten, was bei größeren Texten zu einer Wartezeit von mehreren Stunden führen kann. Dieses langsame Tempo wird durch den begrenzten Arbeitsspeicher und die benötigten Rechenzyklen für die Matrixmultiplikationen bedingt, die den Großteil der Verarbeitungszeit in Anspruch nehmen. Trotz der eher gemächlichen Geschwindigkeit beeindruckt die Tatsache, dass eine so alte Plattform in der Lage ist, komplexe Modellberechnungen mit identischem Ergebnis zu einem zeitgenössischen Llama2.c-Programm durchzuführen. Dabei wird auch die deterministische Modus-Funktion unterstützt, die reproduzierbare Textausgaben ermöglicht und die Testergebnisse verlässlich und nachvollziehbar macht.

Die Limitierung auf relativ kleine Modelle, derzeit bei etwa 8 MB Modellgröße, hängt mit den Grenzen der REU-Speicherkapazität zusammen, die maximal 16 MB betragen kann. Die Notwendigkeit des REU-Moduls ist daher auch eine Voraussetzung für die richtige Nutzung des Modells auf dem C64. Dennoch zeigt das Projekt eindrucksvoll, dass auf Retro-Hardware anspruchsvolle Arbeiten wie KI-basiertes Textgenerieren möglich sind, soweit Ressourcen und Kompromisse pragmatisch behandelt werden. Neben den technischen Details bietet Llama2.c64 auch eine spannende Perspektive für Sicherheit und Datenschutz.

Da das Modell vollständig lokal auf dem C64 läuft, bleiben alle Daten unter Kontrolle des Nutzers. Es besteht keine Sorge hinsichtlich Cloud-Diensten oder externen Servern, die Daten auswerten oder verwenden könnten. Die Unabhängigkeit von teuren Grafikkarten, Netzwerkverbindungen oder leistungsfähiger Serverinfrastruktur macht das Projekt auch im Sinne von Nachhaltigkeit und Energieeffizienz interessant. Es zeigt, dass künstliche Intelligenz nicht zwingend an moderne Hochleistungsrechner gebunden sein muss, sondern mit geeigneten Anpassungen auch auf minimaler Hardware sinnvoll eingesetzt werden kann. Der Entwickler Maciej ‚YTM/Elysium‘ Witkowiak hat Llama2.

c64 mit großer Liebe zum Detail und tiefem Verständnis sowohl der KI-Modelle als auch der 8-Bit-Architektur umgesetzt. Sein umfangreiches Know-how steckt in zahlreichen Quellcodedateien, die etwa den Tokenizer, Netzwerkschichten des Transformers, Mathematikfunktionen und die Benutzeroberfläche realisieren. Auch Debugging- und Performance-Branches sind sichtbar und bieten Ansatzpunkte für Entwickler, die das Projekt weiter verbessern oder auf quantisierte Modellversionen erweitern möchten – was derzeit noch nicht umgesetzt ist. Für Nutzer, die zum Beispiel im Emulator oder auf echter Hardware die Möglichkeiten dieses Projekts erleben wollen, ist das Nachvollziehen der einfachen Schritte zur Installation und Konfiguration entscheidend. Die REU-Erweiterung muss aktiviert werden, das Modellgewicht als REU-Image geladen und schließlich die ausführbare Datei gestartet werden.

Bereits im laufenden Betrieb können Parameter wie die Temperatur und das Top-p Sampling beeinflusst werden, um die Zufälligkeit oder Konsistenz der Ausgaben anzupassen. Die Ausgabe erfolgt nicht messeverfahren mit klassischen Chatbots, sondern als Fortsetzung eines anfänglich übergebenen Textblocks, was die Verwendung als Experimentierplattform oder als experimenteller Geschichtenerzähler interessant macht. Llama2.c64 unterstreicht die Brücke zwischen klassischer Computertechnik und moderner künstlicher Intelligenz, die viele fasziniert. Es demonstriert, dass sich mit viel Kreativität und technischem Wissen auch auf vermeintlich eingeschränkter Technologie zukunftsweisende Anwendungen realisieren lassen.

Gerade in Zeiten, in denen KI oftmals mit Gigabyte großer Modelle und massivem Rechenaufwand assoziiert wird, zeigt dieses Projekt die konträre Möglichkeit auf: eine KI, die auf einer Hardware läuft, die ursprünglich für einfache Spiele und Textverarbeitung konzipiert war. Abschließend betrachtet eröffnet Llama2.c64 auch eine spannende Community-Dynamik. Entwickler sind eingeladen, das Projekt weiterzuentwickeln, beispielsweise durch Pull-Requests für quantisierte Modelle, Optimierungen der Rechenwege oder neue Anwendungsbereiche. Phantasievoll können Retro-Enthusiasten und Programmierer außerhalb der Mainstream-Plattformen die kreative Motivation spüren, gemeinsam Grenzen zu verschieben und zu zeigen, dass selbst eine 40 Jahre alte Maschine noch für innovative Technologie taugt.