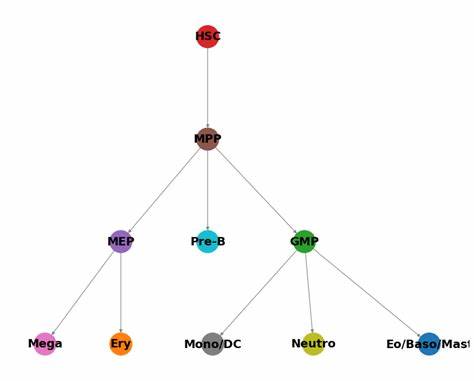

Im Bereich der Künstlichen Intelligenz und insbesondere der Verarbeitung natürlicher Sprache gewinnen Sprachmodelle immer mehr an Bedeutung. Mit der steigenden Komplexität dieser Modelle wächst auch der Bedarf an Werkzeugen, die deren inneren Arbeitsabläufe transparent und nachvollziehbar machen. Logitloom tritt genau hier als eine innovative Lösung in den Vordergrund. Dieses Tool ermöglicht es, sogenannte Token-Trajektorienbäume zu erforschen und gewährt damit einen unvergleichlichen Einblick in die Entscheidungsprozesse von instruct- und Basismodellen. Token-Trajektorienbäume sind im Grunde Visualisierungen der möglichen zukünftigen Entwicklungen bei der Textgenerierung eines Modells.

Sie zeigen auf, welche Token als nächstes mit welcher Wahrscheinlichkeit generiert werden können, und wie sich diese Wahrscheinlichkeiten über mehrere Tokenpositionen verzweigen. Logitloom erlaubt es Nutzern, diese Verzweigungen interaktiv zu erkunden und die verschiedenen Pfade, die ein Modell bei der Spracherzeugung einschlagen kann, nachzuvollziehen. Das Besondere an Logitloom ist seine Unterstützung für instruct-Modelle, die auf kinderfreundliche oder spezifische Anweisungen hin trainiert wurden, sowie für Basismodelle, die rohe Textvorhersagen ohne spezielle Instruktionen liefern. Durch diese Vielseitigkeit lädt das Tool dazu ein, Unterschiede in der Arbeitsweise verschiedener Modelltypen herauszuarbeiten. Anstatt nur das Endergebnis eines generierten Textes zu betrachten, kann der Nutzer nachvollziehen, wie ein Modell zu seiner Entscheidung gekommen ist.

Die Nutzung von Logitloom erfolgt über eine intuitive Benutzeroberfläche, die auf https://vgel.me/logitloom bereitgestellt wird. Nutzer haben die Möglichkeit, ein Prompt einzugeben und je nach Modelltyp unterschiedliche Parameter anzupassen, etwa die Tiefe des Baums oder die maximale Anzahl an Kindknoten für jedes Token. Dadurch wird die Analyse individuell steuerbar und kann sowohl für schnelle Einsichten als auch detaillierte Untersuchungen eingesetzt werden. In Bezug auf die technische Voraussetzung empfiehlt sich für instruct-Modelle die Verwendung einer Chat-API, die Assistant-Prefill und Logprob-Daten unterstützt.

Ein Beispiel hierfür ist das deepseek-chat Modell, das über die Deepseek-Plattform zugänglich ist. Für Basismodelle wird die Nutzung von Hyperbolics 405-base Modell empfohlen, welches stabile Ergebnisse liefert und ebenfalls Logprobs bereitstellt. Beide Anbieter stellen API-Schlüssel zur Verfügung, die lokal im Browser gespeichert werden, sodass keine Daten auf fremden Servern verbleiben. Funktional bietet Logitloom neben der Baumvisualisierung die Möglichkeit, einzelne Token und Pfade als Prefill zu markieren. Dies bedeutet, dass man einen bestimmten Generierungspfad als Ausgangspunkt festlegen und bei erneuter Ausführung sofort von dort aus weiter explorieren kann.

Diese Funktion ist einzigartig, da sie eine flexible und iterative Analyse gestattet, ohne die gesamte Textgenerierung von Grund auf wiederholen zu müssen. Die grafische Darstellung der Token-Trajektorienbäume bei Logitloom ist so gestaltet, dass auch komplexe Mehrwegverzweigungen übersichtlich bleiben. Token werden mit ihren jeweiligen Wahrscheinlichkeiten und Log-Wahrscheinlichkeiten angezeigt, was es erlaubt, automatisiert oder manuell weniger wahrscheinliche Pfade zu prüfen. Die Integration einer Top-P-Einschränkung erlaubt die Filterung von Pfaden nach Wahrscheinlichkeitsschwellen, wodurch die Analyse nicht von irrelevanten Optionen überflutet wird. Ein großes technisches Problem, dem sich Logitloom dennoch stellt, ist die Handhabung von UTF-8-Kodierungen bei der Tokenisierung.

Gerade bei mehrbyteigen Zeichen können durch die Zwischenschritte eigenartige Escape-Sequenzen entstehen, die manchmal merkwürdig im Ergebnis erscheinen. Das Entwicklerteam arbeitet aktiv an Lösungen, um die Darstellung von Unicode-Zeichen innerhalb der Baumstrukturen zu optimieren und eine natürliche Textwiedergabe zu gewährleisten. Für Entwickler und Forschungseinrichtungen, die ihr eigenes Projekt mit Logitloom ergänzen möchten, bietet die Open-Source-Verfügbarkeit auf GitHub umfassenden Zugang zum Quellcode. Die Verwendung moderner Technologien wie Bun für das Bundling und die Web-Entwicklung stellt eine performante Basis sicher. Ebenso wurde eine Vendor-Lösung für die OpenAI-Bibliothek implementiert, um Kompatibilitätsproblemen bei der Browser-basierten Nutzung entgegenzuwirken.

Das Potential von Logitloom geht weit über die reine Visualisierung hinaus. Indem es Einblicke bietet in die Entscheidungsheuristiken von modernen Sprachmodellen, schafft das Tool die Grundlage für Qualitätskontrollen, Debugging und auch für didaktische Zwecke bei der Ausbildung im Bereich Künstliche Intelligenz. Wer beispielsweise verstehen möchte, warum ein Modell sich in einer bestimmten Situation für ein bestimmtes Wort entscheidet, findet hier ein mächtiges Diagnosetool. Auch im kommerziellen Umfeld kann Logitloom wertvolle Dienste leisten. Unternehmen, die Sprachmodelle für spezifische Anwendungen anpassen und einsetzen, können mit dem Tool die Konsistenz und Verlässlichkeit der Modelle prüfen.

Insbesondere in sensiblen Bereichen wie Recht, Medizin oder Kundenkommunikation ist die Nachverfolgung von Modellentscheidungen essenziell, um Vertrauen bei Anwendern und Regulierern aufzubauen. Durch das Zusammenspiel von instruct- und Basismodellen innerhalb eines einzigen Explorationswerkzeugs wird zudem ein Vergleichsrahmen geschaffen, der die Modellwahl erleichtert. Anwender können analysieren, welche Modelle strategisch passendere Antworten liefern und wie deren Token-Auswahlpfade sich unterscheiden. Das unterstützt die Weiterentwicklung von Modellen hin zu mehr Robustheit und Natürlichkeit in der Sprache. Abschließend lässt sich festhalten, dass Logitloom ein innovatives und hochgradig nützliches Werkzeug ist, das eine bislang wenig zugängliche Dimension der Sprachmodell-Interaktion offenlegt.

Durch die Kombination von Benutzerfreundlichkeit, detaillierter Einsicht und technischer Flexibilität trägt Logitloom dazu bei, Sprachmodelle transparenter, effizienter und verständlicher zu machen. Für Forscher, Entwickler und Anwender im KI-Bereich eröffnet sich damit eine neue Welt der Explorations- und Optimierungsmöglichkeiten.