Die Softwareentwicklung befindet sich kontinuierlich im Wandel. Mit der zunehmenden Komplexität von Anwendungen wachsen auch die Anforderungen an die Sprache, mit der Entwickler ihre Ideen umsetzen. Ein besonders wichtiger Bereich, der in der jüngeren Vergangenheit immer stärkere Bedeutung erlangt hat, ist der Umgang mit Kompilierzeit-Berechnungen und deren Integration in die Typensysteme moderner Programmiersprachen. Dabei geht es im Kern darum, wie Programme zur Kompilierzeit durchdenken und optimieren können, ohne dabei an Lesbarkeit, Wartbarkeit oder Performance zu verlieren. Typensysteme sind zentrale Werkzeuge, um Programme verständlich und sicher zu gestalten.

Sie ermöglichen es, Fehler frühzeitig zu erkennen und Programme besser zu strukturieren. Klassischerweise funktioniert der Typen-Check stark losgelöst von der Programmlogik und den Variablen, mit denen Entwickler tatsächlich arbeiten. Das bedeutet, dass die Typen eher abstrakte Kategorien sind, die sicherstellen, dass Werte innerhalb von definierten Grenzen liegen. Diese Trennung hat den großen Vorteil, dass die Typen gut zu verstehen und zu analysieren sind. Es gibt jedoch auch experimentelle Ansätze, bei denen Typen als Werte behandelt werden können.

Ein prominentes Beispiel hierfür ist die Programmiersprache Zig, die Typen als reguläre Werte behandelt und erlaubt, zur Kompilierzeit über sie zu operieren. Damit können Typen dynamisch generiert und transformiert werden, was eine enorme Flexibilität bietet. So könnte etwa ein Datentyp namens ListIfOddLength erzeugt werden, der abhängig von einer Eigenschaft des Typs selbst einen Listen- oder den ursprünglichen Typ zurückgibt. Ein solcher Ansatz erlaubt sehr ausgeklügelte Typenoperationen, die aber auch den Nachteil mit sich bringen, dass die Klarheit leidet. Wenn Typen mit beliebiger Logik versehen werden dürfen, verliert der Entwickler häufig den Überblick, was an welchem Punkt wirklich passiert.

Der Typ eines Ausdrucks wird zu komplex, um ihn intuitiv zu verstehen, was den eigentlichen Zweck von Typensystemen – Vereinfachung und Fehlervermeidung – untergräbt. Große, bewährte Typensysteme wie das Hindley-Milner-System verfolgen einen strengeren Ansatz. Sie betrachten Typen als abstrakte Konzepte, die ausschließlich aus grundlegenden Bausteinen wie generischen Strukturen oder Aufzählungen bestehen. Dadurch entsteht eine Mensch-freundliche, gut erfassbare Struktur, die starke Typinferenz und einfache Lesbarkeit ermöglicht. Während kommerzielle Sprachen wie Rust, Haskell oder OCaml diese Philosophie verfolgen, bieten sie ebenfalls Wege, um Kompilierzeit-Logik durch Makros oder ähnliche Konstrukte einzubinden – allerdings meist auf Kosten einer zusätzlichen Komplexität durch eine zweite, eigene Syntax und dadurch entstehende Verwirrung bei Entwicklern.

Die Herausforderung besteht somit darin, die Vorteile von rechenstarken Kompilierzeit-Funktionalitäten mit der Lesbarkeit und Einfachheit eines traditionellen Typsystems zu verbinden. Ein möglicher Weg besteht darin, Kompilierzeit-Berechnungen als getrennte Ebene zu behandeln. Das bedeutet, dass gewisse Werte und Funktionen explizit als „zur Kompilierzeit bekannt“ markiert werden, während die Typstruktur selbst unverändert und übersichtlich bleibt. So könnte man beispielsweise absolute Zahlenwerte oder Konstanten als direkt zur Kompilierzeit verfügbar markieren, wohingegen Funktionen nicht automatisch ausgeführt werden, sondern explizit durch ein spezielles Symbol erzwungen werden müssen. Dies erhält die Vorteilhaftigkeit des Typsystems und sorgt gleichzeitig für Flexibilität bei der Metaprogrammierung.

Ein wichtiger Aspekt in solchen Systemen ist auch die Möglichkeit, Funktionen zu deklarieren, die ausschließlich zur Kompilierzeit aufgerufen werden dürfen. Das schafft klare Grenzen und vermeidet Missverständnisse, wenn ein Entwickler versehentlich Logik zur Laufzeit ausführen will, die eigentlich nur während der Kompilierung Sinn ergibt. Die Signaturen solcher Funktionen können formal identisch zu Laufzeitfunktionen sein, doch die Sprache sorgt hinter den Kulissen für differenzierte Behandlung und schützt vor falscher Verwendung. Beispiele aus der Praxis verdeutlichen die Leistungsfähigkeit solcher Konzepte. Komplexe Validierungen, etwa von regulären Ausdrücken, lassen sich so bereits während der Kompilierung durchführen.

Ein fehlerhafter Regex würde die Erstellung des Programms verhindern, bevor es je zur Laufzeit kommt und dort möglicherweise abstürzen würde. Ebenso können Datumsformatierer oder andere Konfigurationen validiert und kompiliert werden, was die Zuverlässigkeit des Endprodukts deutlich erhöht. Was aber sind Typen eigentlich, wenn man sie genau betrachtet? Abgesehen von der Struktur stellen Typen in nominalen Typensystemen auch eine eindeutige Identität dar. Ein Typ „Person“ mit gewissen Eigenschaften ist etwas anderes als ein „Dog“, selbst wenn sie dieselben Felder besitzen. Diese Unterscheidung ist essenziell, um Verständnis und Sicherheit im Programm zu gewährleisten.

Zugleich sind Typen aber keine Werte, mit denen man wie mit normalen Variablen rechnen oder experimentelle Logik durchführen sollte. Sie sind vielmehr statische Konzepte, deren Struktur beschrieben, aber die selbst nicht beliebig verändert werden dürfen. Um Fortschritte im Bereich der Typmetaprogrammierung zu erreichen, kann man daher den Ansatz verfolgen, Typen vom Konzept her in zwei Schichten zu teilen: die reine Struktur einerseits und die Identität andererseits. Struktur kann als Wert angesehen werden, die Identität jedoch nicht. So entstehen abstrakte Werte, welche die Struktur von Datentypen, Aufzählungen oder Traits repräsentieren, ohne ihre Identität aufzugeben.

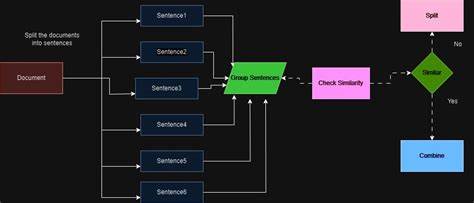

Das erlaubt es zum Beispiel, generische Hilfsmittel wie ein Partial-Konstrukt zu definieren, das ein bestehendes Datentyp-Objekt nimmt und daraus eine Variante erzeugt, bei der alle Felder optional sind. Der Programmierer muss dabei nicht bei Null anfangen, sondern kann auf bestehende Typ-Informationen zurückgreifen und neue Typen mit spezieller Logik zusammensetzen. Genauso wichtig sind Code-Objekte, die es erlauben, Quellcode als Daten zur Kompilierzeit zu behandeln und zu parsen. Damit gewinnt man eine mächtige Möglichkeit, Programme zur Kompilierzeit zu manipulieren und neue Konstrukte zu erzeugen, die man sonst nur mit schwergewichtigen Makros oder externen Tools erreichen könnte. Ein solcher Mechanismus sollte darauf achten, dass der neue Code überall in einem Programm konsistent einsetzbar ist und seine Gültigkeit vor der Ausführung geprüft wird.

Das fördert Wiederverwendbarkeit und Fehlerprävention. Auch Traits, ähnlich den Interfaces in anderen Sprachen, lassen sich in einem solchen System elegant abbilden und mit Standardimplementierungen versehen. Beispielsweise könnte ein Trait namens Stringable definiert werden, das für alle Strukturen eine standardisierte Methode to_string zur Verfügung stellt. Diese Methode generiert automatisch eine lesbare, stringbasierte Repräsentation sämtliche Felder einer Struktur. Entwickler können dabei einfache Strukturen mit minimalem Aufwand für die Erzeugung von String-Darstellungen ausstatten, ohne redundanten Boilerplate-Code schreiben zu müssen.

All diese innovativen Ansätze führen zu einem Konzept, das die Flexibilität von Zig's Kompilierzeit-Fähigkeiten und die typbezogene Sicherheit klassischer Hindley-Milner-Systeme miteinander vereint. Die Vorteile sind vielfältig: Klarere Programme, weniger fehleranfälliger Code, stärkere Typinferenz und noch nie da gewesene Möglichkeiten der Metaprogrammierung. Die Programmiersprachen der Zukunft stehen damit vor einem spannenden Wandel. Die Idee, dass Typen „lediglich Werte“ sind, stößt dabei an ihre Grenzen, und mehrschichtige Ansätze, die Typen, Typinfos, Abstract-Werte und Kompilierzeit-Codeobjekte sauber trennen, öffnen neue Türen. Entwickler bekommen mächtige Werkzeuge an die Hand, mit denen sie nicht nur programmieren, sondern Programme selbst erschaffen können – zur Kompilierzeit und ohne die Nachteile komplexer Makros oder schwer nachvollziehbarer Typenlogik.

Letztendlich vereinen diese Technologien das Beste aus beiden Welten: die Sicherheit und Eleganz erfahrener Typensysteme und die Flexibilität dynamischer Kompilierzeit-Berechnung. Das Ergebnis sind stabilere, wartbarere und bessere Programme, die auch in immer komplexeren Szenarien bestehen. So wird das Ziel erreicht, seine „Kompilierzeit-Torte zu haben und sie gleichzeitig zu genießen“ – ein Paradigma, das Entwickler von heute in den kommenden Jahren prägen wird.