Die Entscheidung für eine Datenbanktechnologie ist eine der wichtigsten technischen Weichenstellungen in jedem wachstumsorientierten Unternehmen. Insbesondere wenn Skalierung, Performance und Betriebskosten in den Fokus rücken, müssen oft komplexe Entscheidungen getroffen werden. Ein Beispiel für einen solchen Richtungswechsel ist der Wechsel von CockroachDB zu PostgreSQL, der für viele Unternehmen eine erlebbare Verbesserung der Systemstabilität, Performance und Wirtschaftlichkeit bedeutet. Dabei zeigt die Praxis, dass die Migration von einer verteilten, stark skalierbaren Lösung auf eine traditionelle, aber äußerst leistungsfähige relationale Datenbank durchaus mit Herausforderungen verbunden ist, jedoch viele Vorteile bietet. CockroachDB gilt vor allem durch seine mühelose horizontale Skalierung und hohe Verfügbarkeit als attraktives Datenbanksystem für verteilte, globale Applikationen.

Das SQL-kompatible Interface und die Fähigkeit, Multi-Region-Setups umzusetzen, machen das System insbesondere für Teams interessant, deren Anwendung global ausgelegt und regulatorischen Anforderungen wie der DSGVO verpflichtet ist. Doch genau dieser Leistungsumfang bringt auch erhebliche Kosten mit sich, die bei wachsendem Datenvolumen und steigenden Nutzerzahlen schnell ansteigen können. Viele Unternehmen, die mit Single-Region-Szenarien und vergleichsweise einfachen, transaktionalen Abfragen arbeiten, bemerken mit zunehmendem Wachstum eine Kostenexplosion bei CockroachDB. Die Betriebsausgaben für die verteilte Datenbank können sich auf mittlere sechsstellige Summen jährlich belaufen. Die Frage nach dem gerechtfertigten Mehrwert gegenüber traditionellen, aber erprobten Systemen wie PostgreSQL wird dann zunehmend relevant.

Ein wesentlicher Faktor bei der Entscheidung für eine Migration ist die Stabilität der eingesetzten Werkzeuge. Philosophie und Architektur von CockroachDB führten bei wachsendem Datenvolumen oft zu Zeitüberschreitungen bei Datenbankmigrationen. Praktisch bedeutete das, dass Tools wie Prisma bei der Anwendung von Schemaänderungen wiederholt ins Stocken gerieten oder komplett ausfielen. Solche Zeitüberschreitungen zwangen Entwicklerteams dazu, manuelle Interventionen durchzuführen und Migrationen blockierten häufig den Deployment-Prozess über Stunden hinweg. Dies führte zu einer latenten Angst vor Datenbanksperren, die in der Folge dazu führte, dass wichtige Änderungen oftmals umgangen oder außerhalb der Datenbank implementiert wurden – was aber auf lange Sicht den technischen Schuldenberg vergrößerte.

Neben den Migrationen betrafen die Timeouts zunehmend auch die für viele moderne Architekturen unverzichtbaren ETL-Prozesse. Viele etablierte ETL-Tools bieten rudimentäre oder keine Unterstützung für CockroachDB, was den Datenabfluss und die Integration erschwerte. Im Fall von Tools wie Airbyte traten sogar kritische Fehler wie Speicherlecks auf, die die Zuverlässigkeit beeinträchtigten und weitere Ausfälle und Verzögerungen verursachten. Dies verstärkte den Bedarf nach einer stabileren und besser unterstützten Plattform. Auf der Ebene der Abfragegeschwindigkeiten zeigte sich ein differenziertes Bild.

In manchen Fällen konnte CockroachDB mit einem intelligenten Query-Optimizer punkten, der komplexe Aggregationen effizienter ausführte als PostgreSQL. Dennoch handelte es sich hierbei um Ausnahmen. Die Mehrheit der realen Weltabfragen litt unter der komplexen und schwer zu optimierenden von Prisma generierten SQL-Statements, bei denen CockroachDB häufig ineffiziente Volltabellenscans durchführte. PostgreSQL erwies sich in diesen Szenarien durch optimierte Indizes und ausgefeilte Ausführungspläne als deutlich schneller. Auch Abbruchmechanismen für laufende, teure SQL-Abfragen sind ein praxisrelevantes Thema.

Während in PostgreSQL das Abbrechen einer Query unkompliziert über SQL-Clients wie TablePlus erfolgen kann, gestaltet sich dies in verteilten Cockroach-Clustern umständlich und fehleranfällig. Entwickler mussten sich in das Cockroach-Admin-Interface einloggen und hoffen, dass alle Cluster-Knoten die Abbruchanfrage korrekt verarbeiteten. Aus Supportperspektive waren Unternehmen bei CockroachDB ebenfalls mit Hindernissen konfrontiert. Getrennte Portale ohne Single-Sign-On sowie lange Reaktionszeiten stellten in kritischen Momenten eine weitere Belastung dar. Solche Hürden bei der Fehlerbehebung bedeuten, dass selbst kleinere Probleme größere Auswirkungen entfalten, insbesondere wenn dringender Handlungsbedarf besteht.

Technische Probleme mit der Netzwerkverbindung traten bei CockroachDB zudem immer wieder auf. Unerklärliche Verbindungsabbrüche zu internen Adressen führten zu Ausfällen in verschiedenen Umgebungen, von lokalen Entwicklungen bis hin zu Produktivsystemen und CI-Pipelines. Diese instabile Netzwerkinfrastruktur konnte trotz intensivem Troubleshooting nicht nachhaltig gelöst werden. Mit PostgreSQL traten derartige Probleme in bislang genutzten Setups nicht auf. Die eigentliche Migration stellte aufgrund des großen Datenvolumens von etwa 100 Millionen Zeilen in den größten Tabellen eine logistische Herausforderung dar.

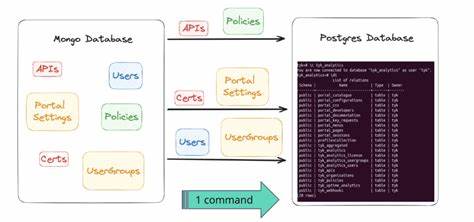

Großangelegte Werkzeuge zum Datenimport existierten im Cockroach-Ökosystem nur eingeschränkt und waren in frühen Entwicklungsstadien. Um den Wechsel dennoch zu ermöglichen, wurde eine maßgeschneiderte ETL-Lösung entwickelt, die unter Verwendung moderner Technologien wie Bun mehrere Prozesse parallelisierte und Daten mittels CSV-Streaming von Cockroach auf PostgreSQL übertrug. Eine praktische Hürde bestand in der unterschiedlichen Byte-Codierung von JSON- und Array-Datentypen zwischen beiden Systemen. Eine sorgfältige Anpassung der Datenformate war notwendig, um die Datenkonsistenz unter PostgreSQL sicherzustellen und die Nutzersicht unverändert zu lassen. Diese Art von Detailarbeit erfordert tiefgehendes Verständnis beider Systeme und die Bereitschaft zu iterativer Entwicklung.

Der eigentliche Migrationslauf in der Produktionsumgebung wurde mit umfangreichen Ressourcen unterstützt, um die Ausfallzeit so gering wie möglich zu halten. Unter Nutzung eines großen Virtual Machines mit 128 CPU-Kernen und während einer geplanten Wartungsphase wurde die Datenübertragung innerhalb von etwa 15 Minuten abgeschlossen. Ein später grundlegendes Monitoring bestätigte den fehlerfreien Betrieb ohne Datenverlust. Die danach unmittelbar sichtbaren Verbesserungen umfassten messbar niedrigere Antwortzeiten bei Anfragen, reduziertem Ressourcenverbrauch und eine erhebliche Kostenersparnis im Jahresvergleich von über 100.000 US-Dollar.

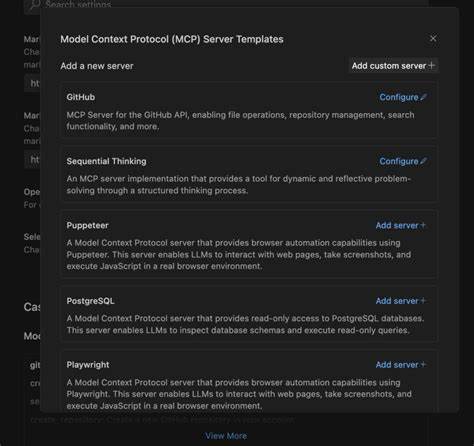

Die neue Umgebung ermöglichte zudem eine schnellere Identifikation und Optimierung mehrerer abfrageintensiver Stellen, was die Performance weiter erhöhte und die Entwicklerzufriedenheit steigerte. Der Wechsel von CockroachDB zu PostgreSQL verdeutlicht exemplarisch, dass der Einsatz bewährter relationaler Datenbanktechnologien auch in Zeiten von Cloud-nativen Anwendungen und global skalierbaren Architekturen seine Daseinsberechtigung hat. Solange die Anforderungen keine echte globale Verteilung mit strikten Compliance-Regeln erfordern, rentiert sich der Wechsel durch deutlich geringere Betriebskosten, attraktivere Tool-Ökosysteme und höhere Entwicklungsproduktivität. Darüber hinaus macht der Fall deutlich, wie wichtig es ist, Migrationen nicht als reinen Datenumzug zu betrachten, sondern sie als Chance zur Systemweiterentwicklung und Prozessoptimierung zu nutzen. Die Kombination technischer Kompetenz, kreativen Problemlösens und pragmatischer Herangehensweise ist der Schlüssel zu einem erfolgreichen Umstieg, der mehr als eine bloße Systemänderung darstellt – nämlich einen echten evolutionären Sprung.