In der heutigen digitalen Welt sind wir mit einer Flut an Nachrichtenquellen konfrontiert, die es schwer machen, den Überblick zu behalten. Mit der zunehmenden Menge an Informationen wächst auch das Bedürfnis nach effektiven Lösungen, um Nachrichten gezielt zu filtern, zu verarbeiten und kompakt zusammenzufassen. Agentische Workflows bieten hierbei eine innovative Möglichkeit, komplexe Aufgaben durch die Zusammenarbeit mehrerer spezialisierter Software-Agenten automatisiert abzuwickeln. Ein solches System lässt sich mit modernen Technologien wie MCPs (Multi-Contextual Programs), dem Amazon Q CLI und dem Terminal-Multiplexer tmux realisieren. In diesem Kontext eröffnet sich ein neues Feld der Automatisierung und Effizienz, das sich ideal für täglich aktualisierte Nachrichtenübersichten nutzen lässt.

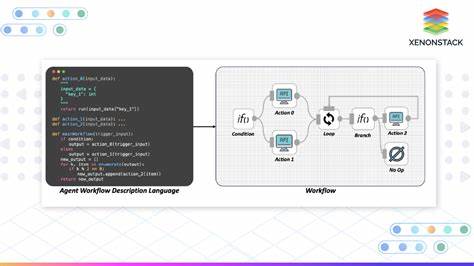

Im Folgenden werden die Komponenten, der Aufbau sowie die Funktionsweise einer solchen automatisierten Nachrichtenagentenlösung detailliert erläutert und mit Praxisbeispielen illustriert. Die Vorstellung einer agentischen Architektur bietet dabei wertvolle Einblicke für IT-Entwickler, Datenenthusiasten und alle, die sich für Automatisierung und maschinelles Lernen interessieren. Zentrales Element des vorgeschlagenen Workflows ist die Kombination von MCPs und Q, um einen mehrstufigen Prozess zu organisieren, der von der Nachrichtenbeschaffung über Parsing bis hin zur Erstellung der finalen Zusammenfassung reicht. MCPs sind hierbei Werkzeuge, die auf programmatischen Agenten basieren, welche unabhängig bestimmte Teilaufgaben abarbeiten. Q von Amazon stellt dabei ein Framework bereit, das es erlaubt, solche Multi-Agenten-Systeme nicht nur auszuführen, sondern auch zu koordinieren.

Ergänzend bringt tmux als Terminal-Multiplexer die Möglichkeit ein, alle laufenden Prozesse in separaten Fenstern sichtbar zu machen und parallel zu managen, was vor allem bei der Entwicklung und Kontrolle der Agenten von großem Nutzen ist. Der Prozess startet mit dem Einlesen der definierten Nachrichtenquellen aus einer Textdatei namens feeds.txt. Diese Datei enthält Links zu diversen RSS-Feeds, die als Eingabedaten für den Workflow dienen. Typische Quellen umfassen bekannte Angebote wie Hacker News, The Wall Street Journal, TechCrunch oder Wired.

Die Aggregation aus unterschiedlichen Quellen sorgt für ein breit gefächertes und thematisch diverses Nachrichtenbild. Um die Verarbeitung effizient zu gestalten, werden diese Nachrichtenquellen in drei Gruppen aufgeteilt – ein Schritt, der durch den Hauptagenten durchgeführt wird. Dadurch wird ermöglicht, dass mehrere Sub-Agenten parallel arbeiten können und jeweils eine definierte Anzahl von Feeds verantwortlich verarbeiten. Jeder Sub-Agent übernimmt eigenständig das Abrufen, Verarbeiten und Zusammenfassen seiner ihm zugewiesenen Nachrichtenfeeds. Das Feeds Abrufen erfolgt asynchron unter Einsatz von Python-basierten Funktionen, die den HTTP-Request effizient abwickeln und Fehlerbehandlung einbauen, um Ausfallzeiten oder Verbindungsprobleme robust zu handhaben.

Die Inhalte der RSS-Feeds werden anschließend geparst, um relevante Details wie Schlagzeilen, Veröffentlichungstermine, Kurzbeschreibungen und Links zu extrahieren. Die Parselogik ist speziell je nach Feedquelle anpassbar, um den unterschiedlichen XML-Strukturen gerecht zu werden. Ein LLM (Large Language Model) kann dabei zukünftig als Ergänzung eingesetzt werden, um auch komplexe oder heterogene Inhalte zuverlässiger zu verarbeiten und zu strukturieren. Im Anschluss an das Parsing werden die Artikel automatisch kategorisiert. Die Kategorisierung erfolgt anhand von Themen wie Künstliche Intelligenz, Technologie, Wirtschaft, Politik oder Cybersicherheit, was eine thematische Einordnung des Informationsflusses erlaubt.

Diese Kategorisierung ist von hoher Bedeutung, da sie strukturierte Übersichten ermöglicht und Trends über die verschiedenen Quellen hinweg sichtbar macht. Die Sub-Agenten generieren für jeden Feed eine eigenständige Zusammenfassung, die in vorbereitete Verzeichnisstrukturen abgelegt wird. So bleibt die Organisation der Daten übersichtlich und flexibel. Der Hauptagent beaufsichtigt währenddessen den Gesamtprozess, koordiniert die Sub-Agenten, verfolgt deren Fortschritt und sammelt abschließend alle Teilsummaries ein. Nach Abschluss aller Aufgaben erfolgt die Zusammenführung der einzelnen Berichte zu einem kohärenten, finalen Dokument.

Dieses Hauptsummary hebt zentrale Kennzahlen hervor, etwa die Gesamtzahl der verarbeiteten Nachrichten, die Themenverteilung, sowie die Quellenvielfalt. Zudem werden übergreifende Trends und besonders herausstechende Themen dargestellt. Sowohl die quantitativen Statistiken als auch qualitative Highlights geben dem Nutzer einen schnellen und fundierten Überblick über das aktuelle weltweite Nachrichten-Geschehen. Eine besonders elegante Komponente dieses Systems ist die Visualisierung und parallele Ausführung mithilfe von tmux. Über mehrere virtuelle Terminalfenster können sämtliche Sub-Agenten und der Hauptagent gleichzeitig und transparent überwacht werden.

Dies erleichtert Debugging, Fehlererkennung und Performance-Überwachung, was für eine robuste und planbare Systemarchitektur unerlässlich ist. Die Trennung in einzelne tmux-Panes bringt dabei gleichzeitig Flexibilität und Skalierbarkeit, da weitere Sub-Agenten nach Bedarf hinzugefügt oder bestehende angepasst werden können. Die eingesetzten Werkzeuge und Technologien sind allesamt Open-Source oder frei zugänglich und erlauben Entwicklern einen einfachen Einstieg in die Realisierung komplexer Agentensysteme. Das Framework Amazon Q beispielsweise bietet eine benutzerfreundliche CLI, mit der Agenten gesteuert, neue Toolkits eingebunden und kontextspezifische Einstellungen vorgenommen werden können. Die Modularität der Python-Skripte für den Feed-Abruf und das Parsing sorgt zudem für eine unkomplizierte Erweiterbarkeit um neue Quellen oder spezielle Analysemechanismen.

Eine spannende Perspektive für solche agentischen Workflows liegt in der Adaptierbarkeit auf andere Anwendungsgebiete. So könnten vergleichbare Multi-Agenten-Architekturen in der Verarbeitung von Design-Dokumenten, komplexen Berichten oder Software-Projektdokumentationen eingesetzt werden. Ebenso denkbar ist die Kombination mit weiteren KI-gestützten Werkzeugen, um Schreib- und Entwicklungsprozesse zu automatisieren oder kollaborative Multi-Agenten-Arbeitsflächen zu realisieren. Die bestehende Infrastruktur aus MCPs, Q und tmux bildet dafür eine technische Grundlage, die problemlos an individuelle Anforderungen angepasst werden kann. Für Anwender, die die Lösung selbst ausprobieren möchten, steht der Quellcode als öffentliches Repository zur Verfügung, das sämtliche Module, Konfigurationsdateien und Dokumentationen enthält.

Der Einstieg erfolgt unkompliziert durch das Klonen des Repositories, die Installation der benötigten Abhängigkeiten wie httpx für asynchrone HTTP-Requests und mcp[cli] für die Steuerung der Agenten. Nach einfacher Konfiguration lassen sich die Agenten über die Q CLI starten, wobei sich der gesamte Prozess durch das Hinzufügen von Kontextinformationen und das Starten der Haupt- und Sub-Agenten nahtlos orchestrieren lässt. Die Idee, tägliche Nachrichtenflüsse automatisiert zusammenzufassen, beantwortet ein reales Bedürfnis nach strukturierter Informationsaufnahme in einer immer komplexer werdenden Welt. Durch die Kombination moderner Programmierparadigmen, KI-Integration und cleverer Prozessvisualisierung erzielt dieses System eine bemerkenswerte Balance zwischen Automatisierung, Flexibilität und Benutzerfreundlichkeit. Regelmäßige Updates und Erweiterungen versprechen, das Potenzial der Lösung weiter auszubauen und die Nutzerfreundlichkeit zu steigern.

Abschließend zeigt dieses Projekt eindrucksvoll, wie Agenten, orchestriert durch intelligente Frameworks, tägliche Routineaufgaben übernehmen können und so Freiraum für kreative sowie strategische Tätigkeiten schaffen. Für alle, die sich mit modernen Multitasking- und Automatisierungslösungen beschäftigen, bietet das beschrieben Vorgehen eine fundierte und praxisnahe Inspiration, wie sich Technologie gewinnbringend einsetzen lässt.