Die Extraktion strukturierter Informationen aus aufgezeichnetem Audio ist eine spannende Herausforderung, die gerade in Zeiten von Künstlicher Intelligenz und Deep Learning immer mehr an Relevanz gewinnt. Die Fähigkeit, aus auditiven Daten sinnvolle, klar definierte Datenstrukturen ableiten zu können, eröffnet zahlreiche Anwendungsmöglichkeiten – von der Automatisierung in Unternehmen bis hin zur Verbesserung persönlicher Assistenten. Doch wie gelingt es, aus einem Stück gesprochener Sprache präzise und verwertbare Daten herauszufiltern, insbesondere wenn das Equipment günstig und die Rechenpower begrenzt ist? Eine praxisorientierte Betrachtung unterscheidet mehrere wichtige Schritte und Techniken, die diesen Prozess vereinfachen und verbessern können. Zunächst ist es entscheidend, die reine Audioaufnahme durch ein zuverlässiges Spracherkennungssystem in Text umzuwandeln. In diesem Bereich erfreut sich OpenAI Whisper großer Beliebtheit, da es eine robuste Transkription gewährleistet und auch auf begrenzteren lokalen Geräten mit moderater GPU-Leistung gut funktioniert.

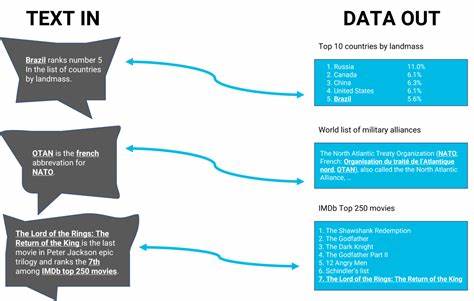

Whisper kann aufgrund seiner vielseitigen Trainingsbasis eine Vielzahl von Sprachmodellen erkennen und die gesprochene Sprache mit beeindruckender Präzision in schriftlichen Text übertragen. So wird die Grundlage geschaffen, von der aus der weitere Prozess der Strukturierung überhaupt erst möglich wird. Nach der Umwandlung in Text besteht die Herausforderung darin, diesen unstrukturierten linguistischen Rohstoff in geordnete Datenfelder zu transformieren. Das heißt, es wird analysiert, welches Anliegen oder welche Absicht hinter dem Text steht – genannt „Purpose“ – und welche notwendigen Informationen oder Werte extrahiert werden müssen, um eine handhabbare Datenstruktur zu bilden. Ein gutes Beispiel ist die Aufforderung "Bitte beantrage Urlaub vom 1.

November bis 8. November". Hierbei lässt sich als Zweck das "Urlaubsantrag stellen" identifizieren, während die wichtigen Daten das Start- und Enddatum sind, idealerweise in einem standardisierten Format wie "2025-11-01" bzw. "2025-11-08". Viele Entwickler wenden für die nachgelagerte Datenextraktion Ansätze aus der Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) an.

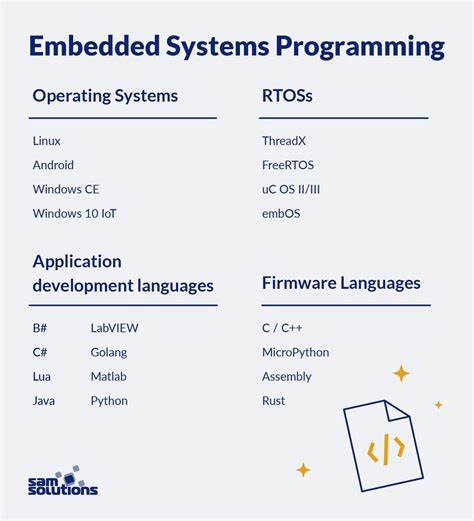

Python-Bibliotheken wie spaCy bieten dafür eine hervorragende Grundlage, insbesondere für die Tokenisierung und das Erkennen von relevanten Satzkomponenten. Mit Hilfe solcher Tools werden Texte segmentiert, wichtige Wörter und Phrasen identifiziert und in Kategorien eingeordnet. Es ist jedoch nicht immer trivial, ein System zu designen, das zuverlässig unterschiedliche Zwecke erkennen und deren zugehörige Daten korrekt zuordnen kann. Dabei hilft ein sogenannter "Best-Match"-Ansatz, bei dem der transkribierte Text anhand von Trainingsdaten oder vordefinierten Mustern mit den vorhandenen Zweckklassen verglichen wird. Die Ähnlichkeit zwischen Nutzeräußerung und Beispieltexten bestimmt dann die wahrscheinlichste Kategorie.

Einige Erfahrungsberichte aus Entwicklercommunitys empfehlen auch klassische Strategien wie die Verwendung von regulären Ausdrücken (Regular Expressions) und multi-pass Skripten, um wörtliche Muster im Text zu erkennen und die zugehörigen Werte herauszufiltern. Hierbei können linguistische Analysemethoden zur Wortartbestimmung (z.B. Subjekt, Verb, Objekt) genutzt werden, um Informationen zu selektieren und fehlerhafte Interpretationen zu minimieren. Die manuelle Kategorisierung und anschließende Überprüfung durch Menschen bleibt dabei häufig ein wertvoller Bestandteil, um unerwartete Ausreißer zu erkennen und die Zuverlässigkeit zu erhöhen.

Eine weitere interessante Herangehensweise ist der Einsatz kleiner, auf spezifische Aufgaben zugeschnittener Large Language Models (LLMs), um die Informationsstrukturierung durch semantisches Verständnis des Textes zu verbessern. Diese Modelle können im Gegensatz zu einfachen Regelwerken komplexere Zusammenhänge und Abhängigkeiten im gesprochenen Inhalt erkennen und so eine dynamischere sowie flexiblere Datenextraktion ermöglichen. Für Anwender mit begrenzten Ressourcen empfehlen sich Modelle, die lokal auf GPUs wie der alten NVidia 1660 Super mit 6 GB VRAM betreibbar sind, um Latenz und Datenschutzbedingungen besser zu kontrollieren. Neben der technischen Umsetzung spielt die Normalisierung der extrahierten Daten eine entscheidende Rolle. Zeitangaben, Zahlen oder Ortsnamen müssen in ein einheitliches Format gebracht werden, um bei späteren Verarbeitungsschritten problemlos genutzt werden zu können.

Beispielsweise wird ein frei formulierter Zeitraum „1. November“ in ein maschinenlesbares „2025-11-01“ überführt. Das erhöht nicht nur die Konsistenz, sondern stellt auch die verlässliche Weiterverarbeitung in Datenbanken oder automatisierten Workflows sicher. In der Praxis existieren diverse kombinierte Lösungen, die eine mehrstufige Pipeline umfassen: Von der Spracherkennung mit Whisper über die Textvorverarbeitung und Tokenisierung mit spaCy bis hin zum eigentlichen Mapping auf strukturierte Daten mithilfe regelbasierter Systeme, KI-Modellen oder einer intelligenten Mischform. Dies erlaubt eine flexible Handhabung, die auf verschiedenste Einsatzfelder anpassbar ist, vom Kundenservice über Terminvereinbarungen bis hin zu medizinischen Anamnesegesprächen.

![ASML's Breakthrough 3-Pulse EUV Light Source [video]](/images/CBD0D6DC-0F1C-4B1A-AF36-9BF6A553C049)